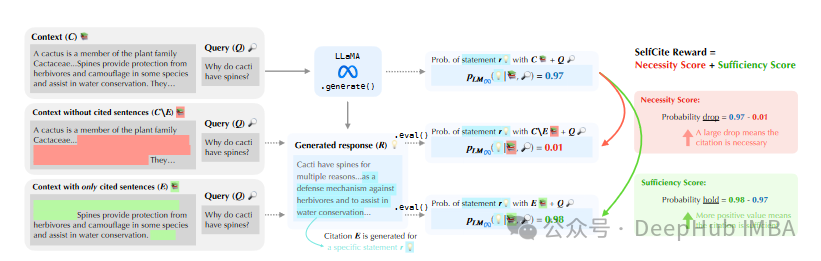

SelfCite: 通过自监督奖励提升LLM对上下文内容的引用质量

SelfCite 提出了一种新颖的自监督方法,通过上下文消融技术和自监督奖励机制,提升大型语言模型 (LLM) 对上下文内容的引用质量,生成更准确、更可靠的句子级别引用,从而提高基于上下文的生成任务的整体性能。

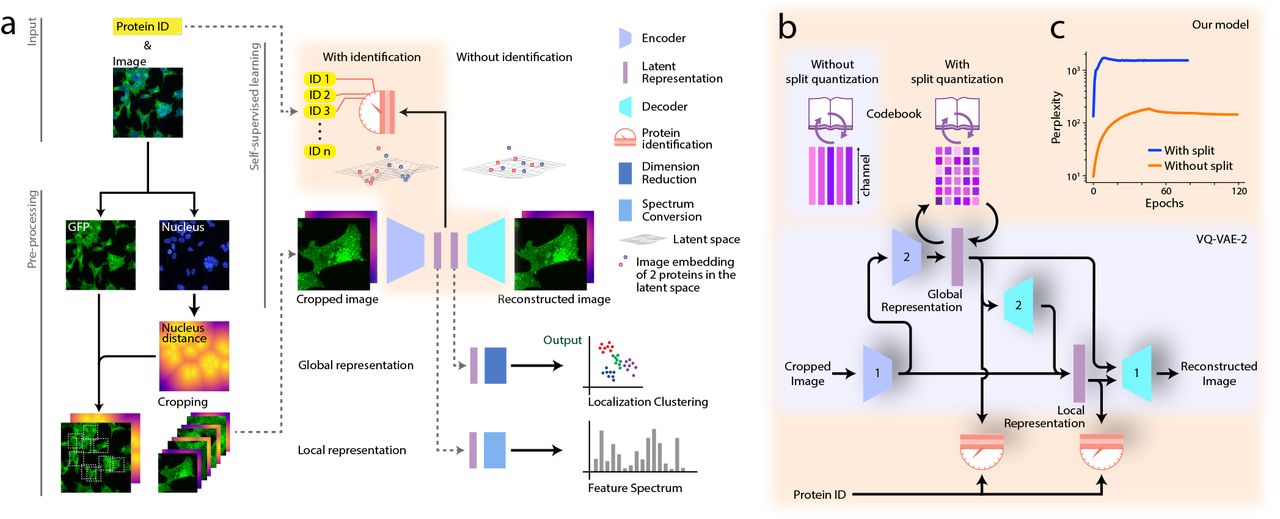

视觉大模型DINOv2:自我监督学习的新领域

本文将介绍DINOv2是如何改进的,以及这些进步可能对整个领域有什么影响。

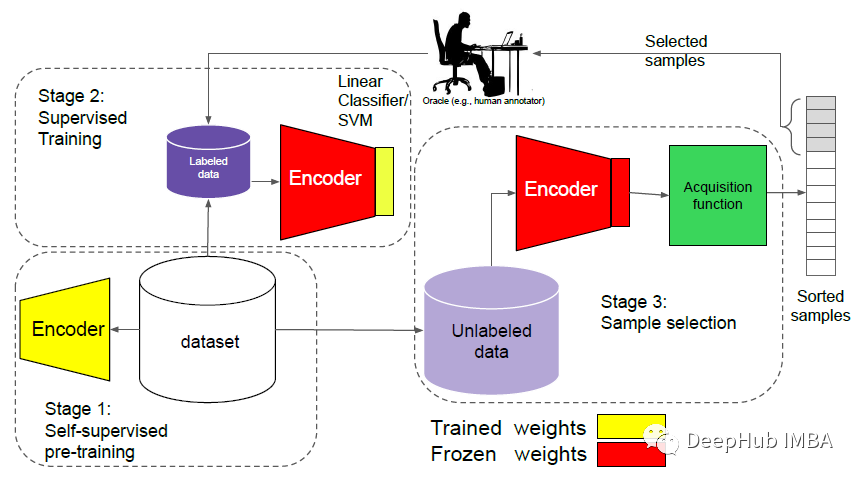

论文推荐:当自监督遇到主动学习

Reducing Label Effort: Self-Supervised meets Active Learning这篇论文将主动学习和自监督训练结合,减少了标签的依赖并取得了很好的效果。

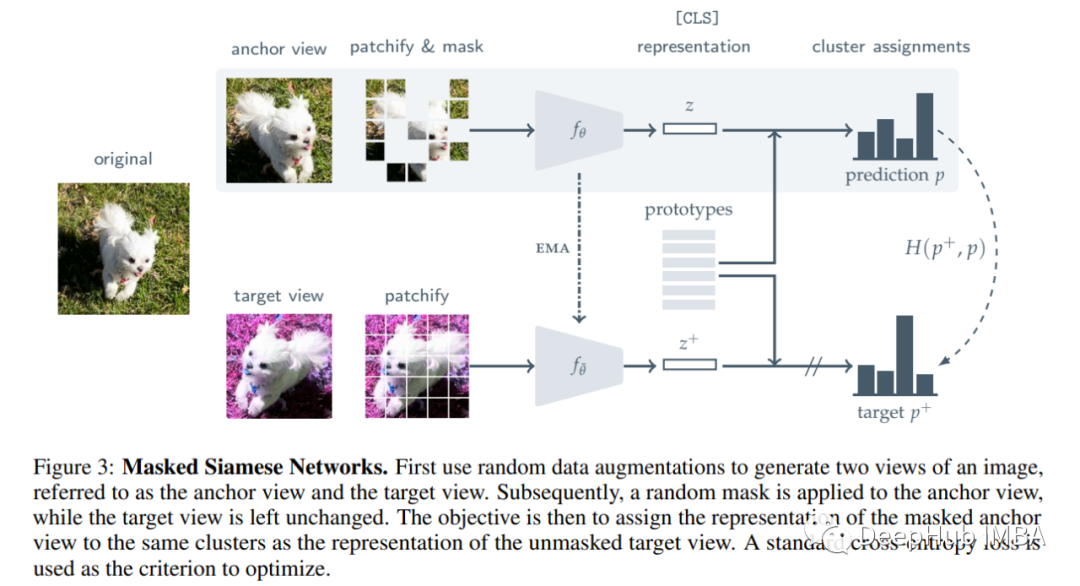

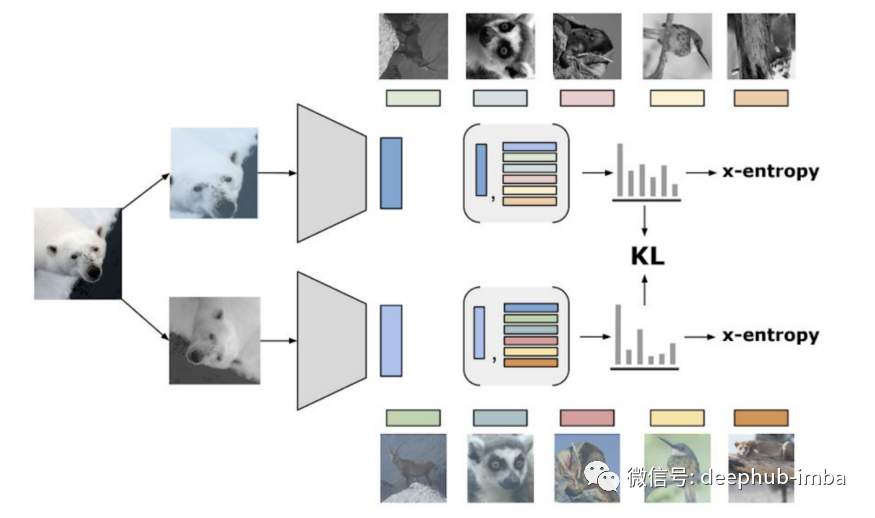

论文推荐:使用带掩码的孪生网络进行自监督学习

本篇文章将介绍Masked Siamese Networks (MSN),这是另一种用于学习图像表示的自监督学习框架。MSN 在 ImageNet-1K 上的线性评估方面优于 MAE 和其他模型

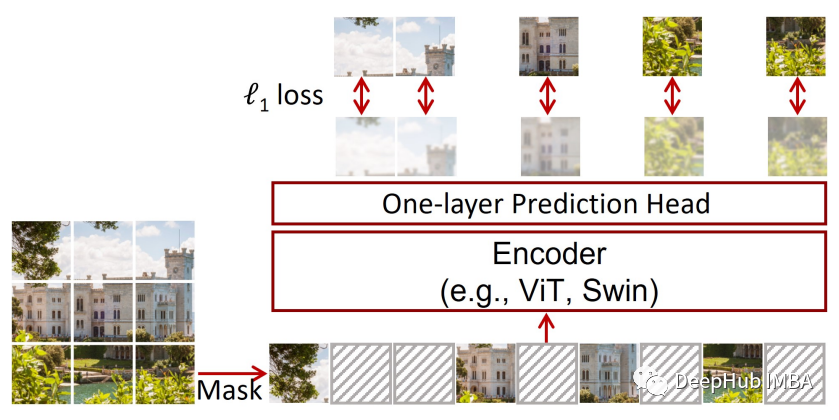

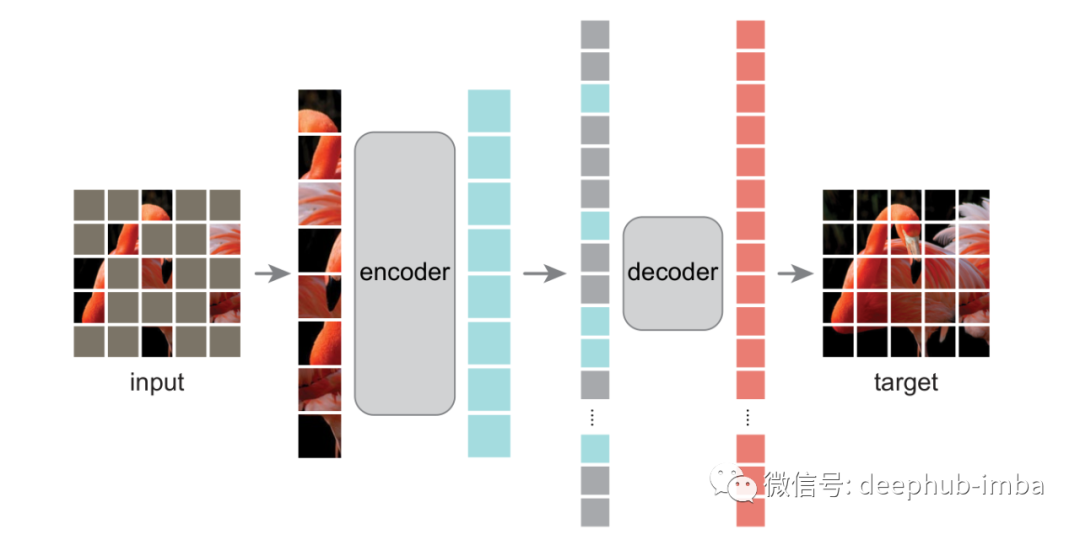

更简单的掩码图像建模框架SimMIM介绍和PyTorch代码实现

在本文中我们将探索一篇和MAE同期的工作:SimMIM,任何VIT都可以在大量未注释的数据上进行训练,并且可以很好地学习下游任务。

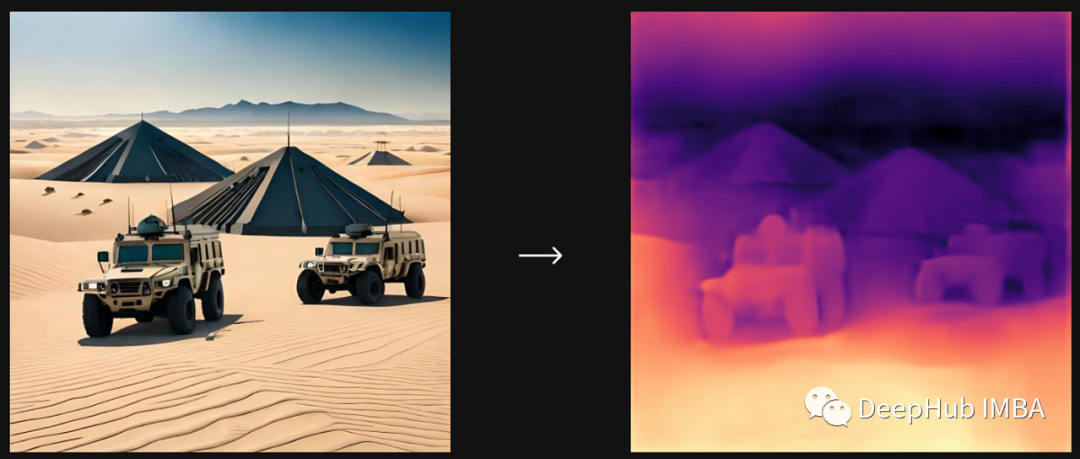

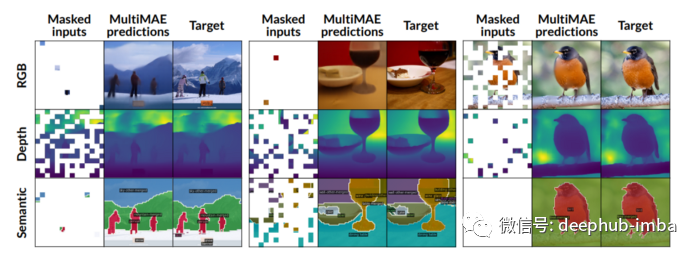

MultiMAE:一种简单、灵活且有效的 ViT 预训练策略

Multi-modal Multi-task Masked Autoencoders (MultiMAE),也是一种预训练策略,可以对掩码进行自动编码处理并执行多模态和多任务的训练。

自监督学习的知识点总结

本篇文章将对自监督学习的要点进行总结

论文推荐:ReLICv2 ,新的自监督学习能否在ResNet 上超越监督学习?

自监督 ResNets 能否在 ImageNet 上没有标签的情况下超越监督学习?

带掩码的自编码器MAE详解和Pytorch代码实现

前几天已经被kaiming大神的MAE刷屏了,今天我们来看看论文具体的代码实现。