一文彻底搞懂大模型参数高效微调(PEFT)

最近这一两周看到不少互联网公司都已经开始秋招提前批了。不同以往的是,当前职场环境已不再是那个双向奔赴时代了。求职者在变多,HC 在变少,岗位要求还更高了。最近,我们又陆续整理了很多大厂的面试题,帮助一些球友解惑答疑,分享技术面试中的那些弯弯绕绕。。更多实战和面试交流,加入我们。

使用 Python TorchRL 进行多代理强化学习

本文将深入探讨如何使用 TorchRL 解决 MARL 问题,重点关注多代理环境中的近端策略优化(PPO)。

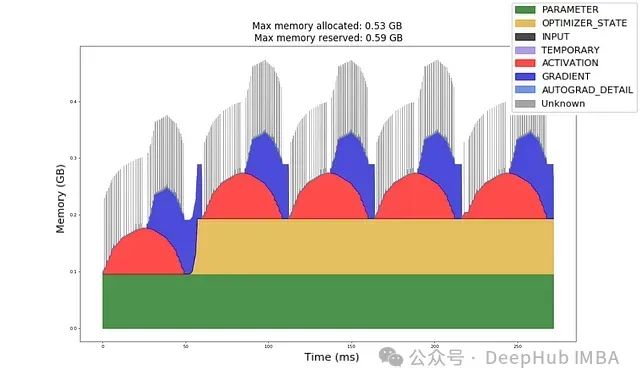

深入理解GPU内存分配:机器学习工程师的实用指南与实验

给定一个模型架构、数据类型、输入形状和优化器,你能否计算出前向传播和反向传播所需的GPU内存量?

在 Linux 上轻松部署 PyTorch 环境:一步步指南

在这篇文章中,我们将详细介绍如何在 Linux 系统上安装和配置 PyTorch 环境,帮助你顺利进行深度学习模型的开发和训练。通过上述步骤,你已经在 Linux 上成功安装和配置了 PyTorch 环境,并且可以开始进行深度学习的研究和开发。如果你有任何问题或遇到任何困难,PyTorch 的官方文

手把手教你快速安装gpu版本的pytorch

比如pytorch版本是1.10.1(需要对应),环境创建时python版本是3.8 (需要对应),cuda 12.3(比它小的都可以),那么下面几个可以下载,选一个下载,最好装到一个英文路径下。第五步:验证torch安装是否成功,import torch成功说明安装成功,如果torch.cuda.

小白学大模型:LLaMA-Factory 介绍与使用

最近这一两周看到不少互联网公司都已经开始秋招提前批了。不同以往的是,当前职场环境已不再是那个双向奔赴时代了。求职者在变多,HC 在变少,岗位要求还更高了。最近,我们又陆续整理了很多大厂的面试题,帮助一些球友解惑答疑,分享技术面试中的那些弯弯绕绕。Efficient fine-tuning对于将大型语

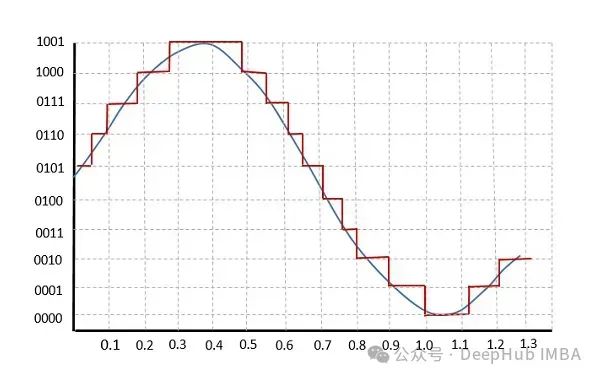

图解Pytorch学习率衰减策略(一)

在深度学习中,学习率是一个非常重要的超参数,它控制了模型在每次权重更新时的步长。学习率衰减策略是指在训练过程中逐步减少学习率,从而使得模型更稳定地收敛到最优解。本文将介绍:LinearLR、StepLR、MultiStepLR、ExponentialLR、CosineAnnealingLR、Redu

深度学习环境搭建详解(Anaconda、Pycharm、Cuda、Pytorch)

本文详细说明了深度学习中的相应环境配置,包括Anaconda、Pycharm、Cuda、cuDNN、Pytorch等,小白也能轻松上手哦!

VMamba 安装教程(无需更改base环境中的cuda版本)

下面分别是 CUDA 12.1 和 CUDA 11.8 两种环境的安装,由于此时 CUDA 的内核以及相关文件均安装在虚拟环境中,可以不考虑base环境里 CUDA 的版本。),但是有些问题无法解决,特此汇总。注意,即使base环境中安装的 CUDA 版本过低,也不影响 Mamba,Vim 以及 V

anaconda修改安装的默认环境

📚✨🎃。

pytorch里tensor用法总结

通过这篇总结,希望可以帮助pytorch学习者更好掌握Tensor的基本用法。

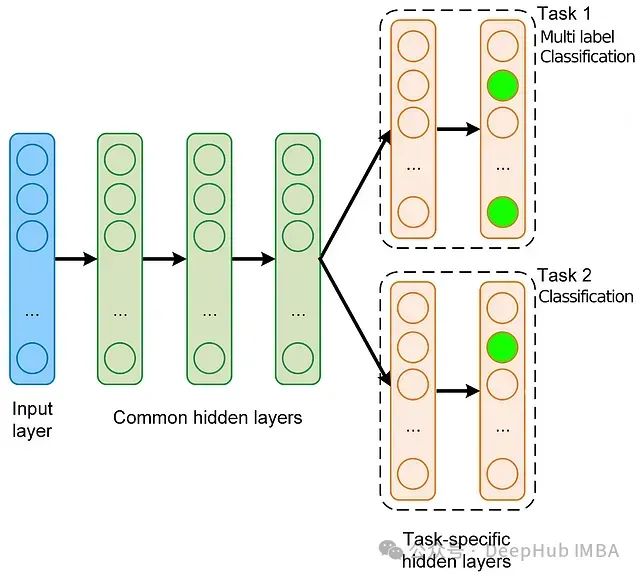

深度学习实战:手把手教你构建多任务、多标签模型

在本文中,我们将基于流行的 MovieLens 数据集,使用稀疏特征来创建一个多任务多标签模型,并逐步介绍整个过程。所以本文将涵盖数据准备、模型构建、训练循环、模型诊断,最后使用 Ray Serve 部署模型的全部流程。

Pytorch基础:Tensor的连续性

在Pytorch中,一个连续的张量指的是张量中各数据元素在底层的存储顺序与其在张量中的位置一致。这意味着每一个元素的地址可以通过下面的线性映射公式来确定:

Vision Mamba论文阅读(主干网络)

简单看看,文章介绍了Vim模型,这是一种新的通用视觉基础模型,它利用双向Mamba块(bidirectional Mamba blocks (Vim))和位置嵌入 (position embeddings)来处理图像序列,并在ImageNet分类、COCO对象检测和ADE20K语义分割任务上取得了比

掌握 PyTorch 张量乘法:八个关键函数与应用场景对比解析

PyTorch提供了几种张量乘法的方法,每种方法都是不同的,并且有不同的应用。我们来详细介绍每个方法,并且详细解释这些函数有什么区别:

VSCode部署Pytorch机器学习框架使用Anaconda(Window版)

在这种情况下,为了确保 PyTorch 可以在你的系统上正常使用 GPU 加速,你可以考虑安装可用的最高版本的 CUDA Toolkit,即 11.8,然后测试 PyTorch 是否可以正常访问 GPU。根据你的第二张截图,你的系统安装了 NVIDIA CUDA 12.2.138 驱动,但是在 Py

Linux下Vision Mamba环境配置+多CUDA版本切换

Linux 下 Vision Mamba的环境配置。笔者在linux下选用CUDA11.8版本,也比较推荐读者使用此版本,方便后续环境配置。

小白也能读懂的ConvLSTM!(开源pytorch代码)

别再用CNN-LSTM了!ConvLSTM(卷积长短期记忆网络)是一种结合了卷积神经网络(CNN)和长短期记忆网络(LSTM)优势的深度学习模型。它主要用于处理时空数据,特别适用于需要考虑空间特征和时间依赖关系的任务,如气象预测、视频分析、交通流量预测等。

Ultralytics YOLO - 最先进的视觉人工智能:yolov8 环境搭建

Ultralytics YOLOv8是一种尖端的,最先进的(SOTA)模型,建立在以前的YOLO版本的成功基础上,并引入了新的功能和改进,以进一步提高性能和灵活性。YOLOv8旨在快速,准确,易于使用,使其成为广泛的目标检测和跟踪,实例分割,图像分类和姿态估计任务的绝佳选择。

用PyTorch 从零开始构建 BitNet 1.58bit

我们手动实现BitNet的编写,并进行的一系列小实验证实,看看1.58bit 模型是否与全精度的大型语言模型相媲美!