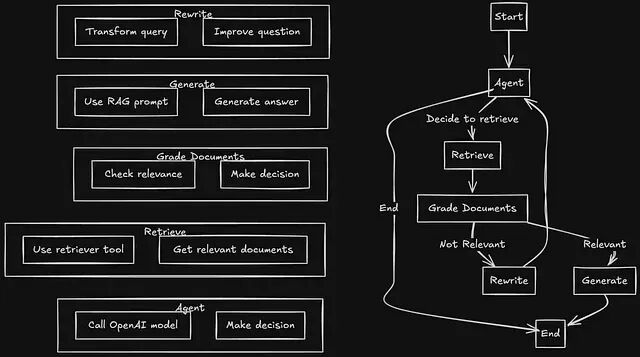

Agentic RAG:用LangGraph打造会自动修正检索错误的 RAG 系统

本文要做的就是用 LangGraph 做流程编排、Redis 做向量存储,搭一个生产可用的 Agentic RAG 系统。涉及整体架构设计、决策逻辑实现,以及状态机的具体接线方式。

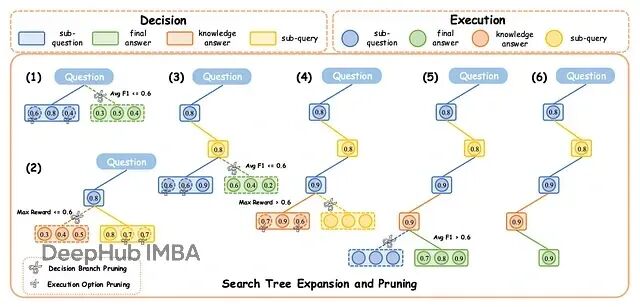

DecEx-RAG:过程监督+智能剪枝,让大模型检索推理快6倍

DecEx-RAG 把 RAG 建模成一个马尔可夫决策过程(MDP),分成决策和执行两个阶段。

JAX性能优化实战:7个变换让TPU/GPU吃满算力

我们今天就来总结7个能够提高运行速度的JAX变换组合

Google Code Wiki:GitHub代码库秒变可交互文档

Google发布的这个Code Wiki项目可以在代码仓库之上构建动态知识层的工具,或者说可以"自动生成文档"。

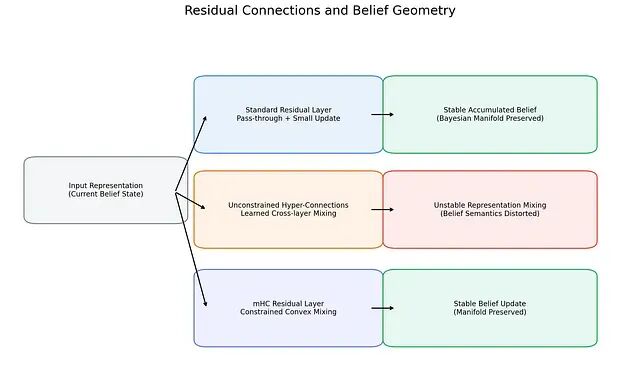

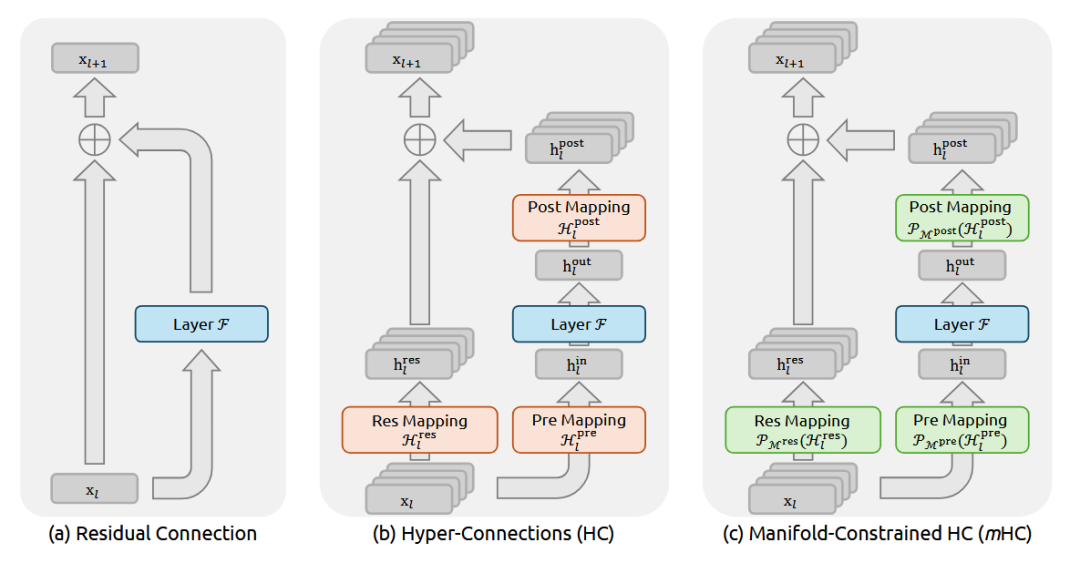

从贝叶斯视角解读Transformer的内部几何:mHC的流形约束与大模型训练稳定性

近期研究揭示了一个有趣的现象:Transformer内部确实在执行贝叶斯推理:只不过不是符号化的方式而是几何化的。

DeepSeek 开年王炸:mHC 架构用流形约束重构 ResNet 残差连接

这回DeepSeek又要对 残差连接(Residual Connection)出手了。

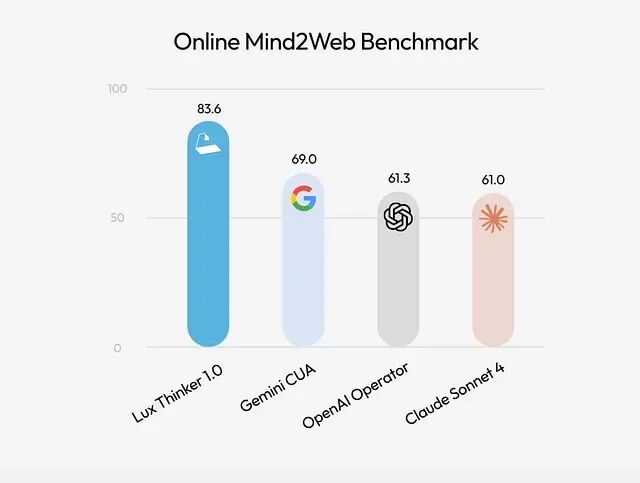

Lux 上手指南:让 AI 直接操作你的电脑

**Lux** 要是一个专门用于计算机操作的基础模型。

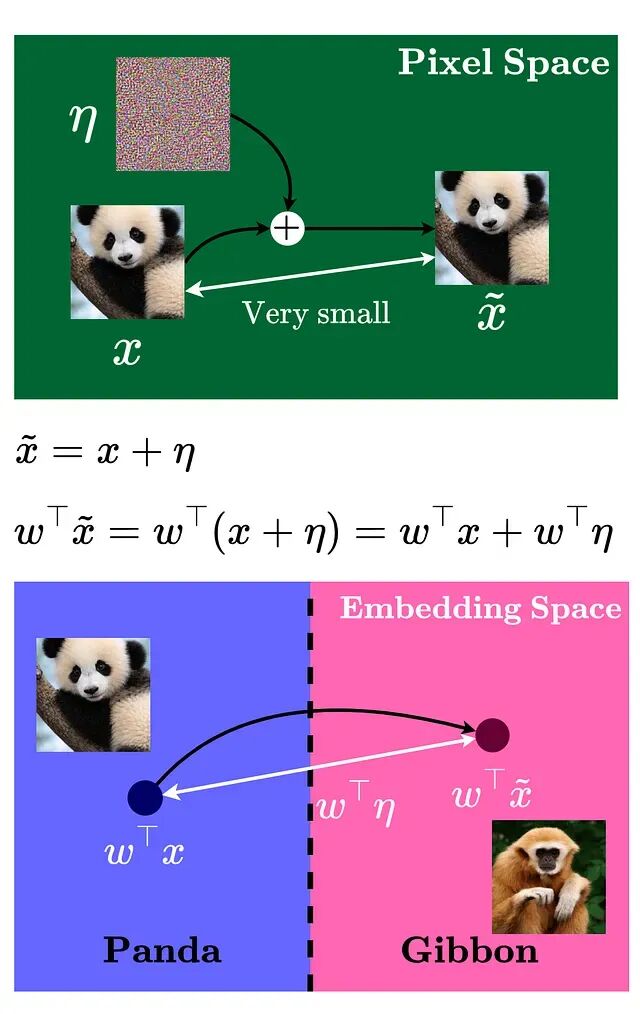

对抗样本攻击详解:如何让AI模型产生错误判断

精心构造的输入样本能让机器学习模型产生错误判断,这些样本与正常数据的差异微小到人眼无法察觉,却能让模型以极高置信度输出错误预测。

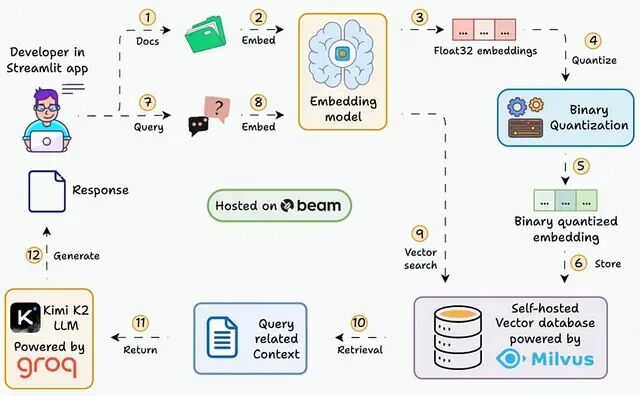

大规模向量检索优化:Binary Quantization 让 RAG 系统内存占用降低 32 倍

本文会逐步展示如何搭建一个能在 30ms 内查询 3600 万+向量的 RAG 系统,用的就是二值化 embedding。

向量搜索升级指南:FAISS 到 Qdrant 迁移方案与代码实现

FAISS 在实验阶段确实好用,速度快、上手容易,notebook 里跑起来很顺手。但把它搬到生产环境还是有很多问题

CALM自编码器:用连续向量替代离散token,生成效率提升4倍

近年来语言模型效率优化多聚焦参数规模与注意力机制,却忽视了自回归生成本身的高成本。CALM提出新思路:在token之上构建潜在空间,通过变分自编码器将多个token压缩为一个连续向量,实现“一次前向传播生成多个token”。

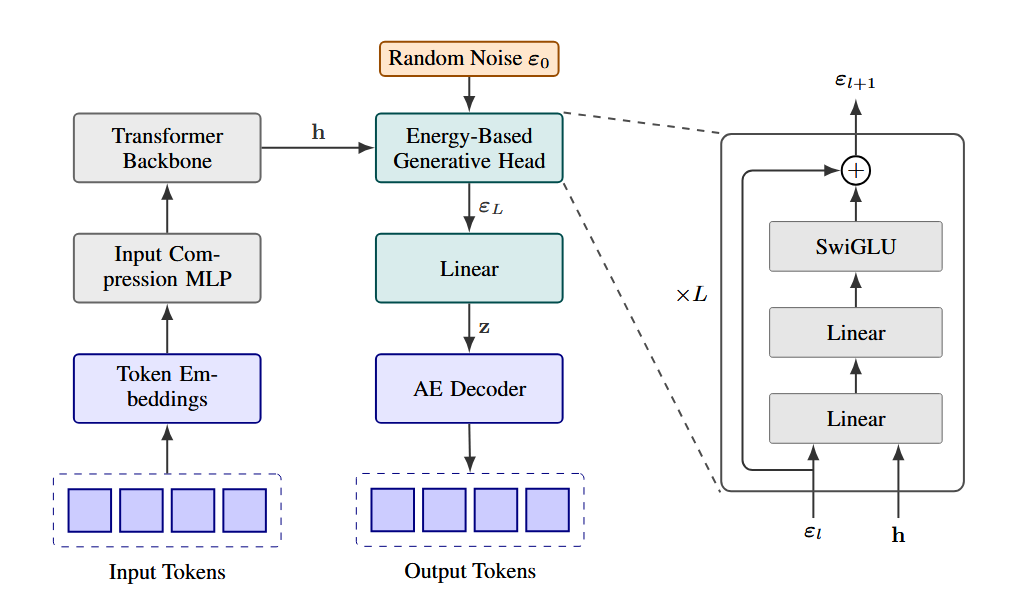

dLLM:复用自回归模型权重快速训练扩散语言模型

dLLM是一个开源的Python库,它把扩散语言模型的训练、微调、推理、评估这一整套流程都统一了起来,而且号称任何的自回归LLM都能通过dLLM转成扩散模型

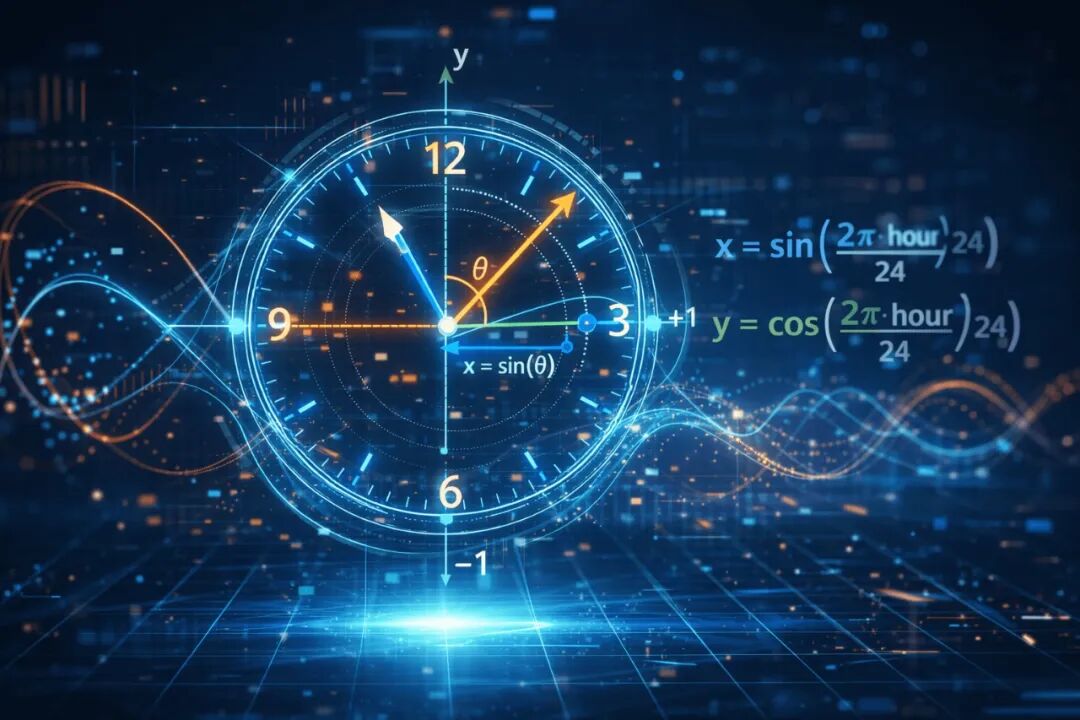

机器学习时间特征处理:循环编码(Cyclical Encoding)与其在预测模型中的应用

使用正弦和余弦进行循环编码,是一种优雅且低成本的修正手段。它保留了数据的邻近性,消除了人工伪影,能让模型学得更快、更准。

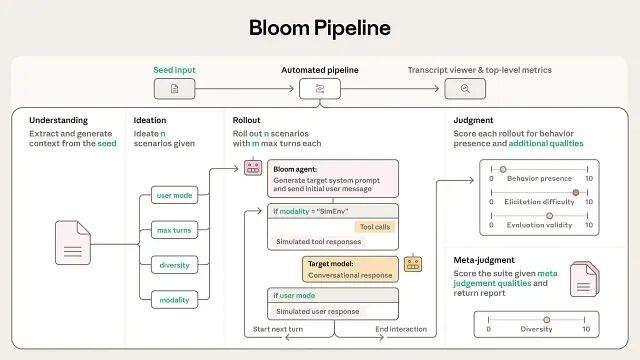

Anthropic 开源 Bloom:基于 LLM 的自动化行为评估框架

这套框架把行为评估自动化了,从定义行为到生成测试用例、执行评估、给出判断,全程不需要人工介入。

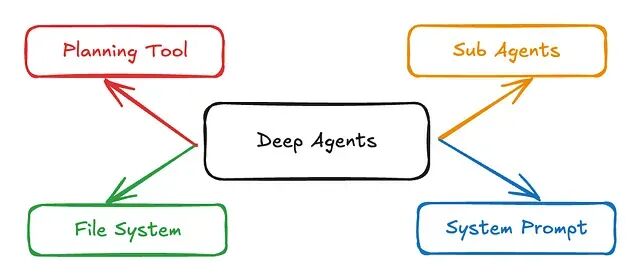

Pydantic-DeepAgents:基于 Pydantic-AI 的轻量级生产级 Agent 框架

有时候严格的类型安全加上一个干净的 Docker 容器,远比一张错综复杂的有向无环图(DAG)要好维护得多。

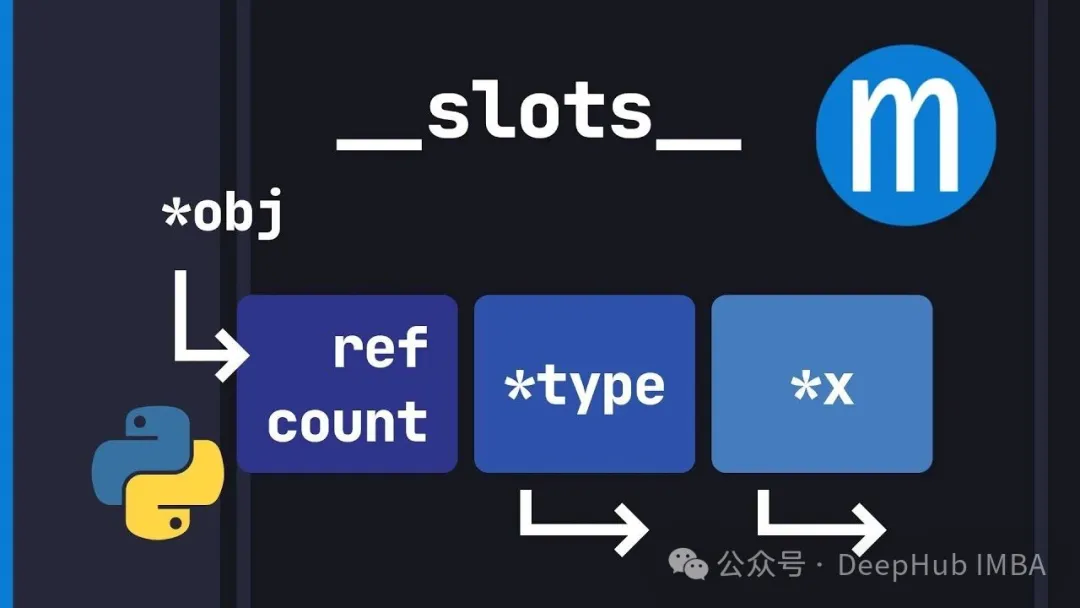

别再浪费内存了:Python __slots__ 机制深入解析

`__slots__` 就是让你用灵活性换内存效率和更快的属性访问。对于高性能场景来说这是个必须掌握的优化手段。

Scikit-image 实战指南:10 个让 CV 模型更稳健的预处理技巧

本文总结了基于 **scikit-image** 的十个工程化模式,旨在帮助开发者消除输入数据的不确定性将杂乱的原始图像转化为对模型真正友好的高质量张量。

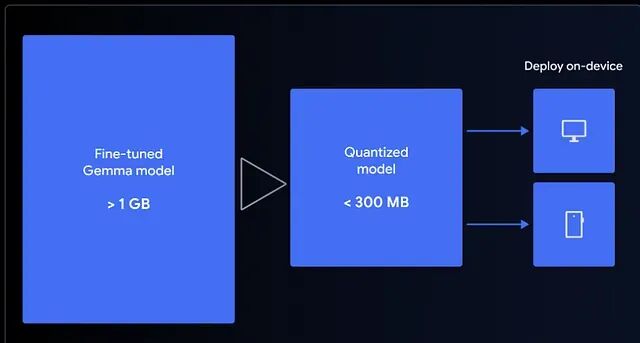

1小时微调 Gemma 3 270M 端侧模型与部署全流程

Gemma 3 270M是谷歌推出的轻量级开源模型,可快速微调并压缩至300MB内,实现在浏览器中本地运行。本文教你用QLoRA在Colab微调模型,构建emoji翻译器,并通过LiteRT量化至4-bit,结合MediaPipe在前端离线运行,实现零延迟、高隐私的AI体验。小模型也能有大作为。

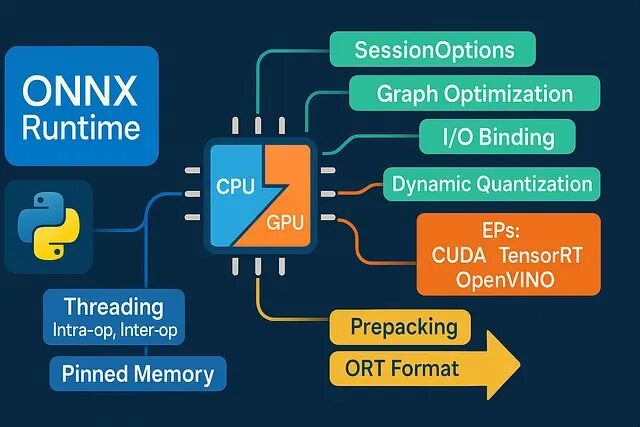

ONNX Runtime Python 推理性能优化:8 个低延迟工程实践

深度学习推理慢?未必是模型问题。本文揭示8大ONNX Runtime工程优化技巧:合理选择执行提供器、精准控制线程、规避内存拷贝、固定Shape分桶、启用图优化、CPU量化加速、预热与微批处理、向量化前后处理。不改模型也能显著提升性能,低延迟落地关键在于细节调优。

Scikit-Learn 1.8引入 Array API,支持 PyTorch 与 CuPy 张量的原生 GPU 加速

Scikit-Learn 1.8.0 更新引入了实验性的 Array API 支持。这意味着 CuPy 数组或 PyTorch 张量现在可以直接在 Scikit-Learn 的部分组件中直接使用了