人工智能与机器学习原理精解【27】

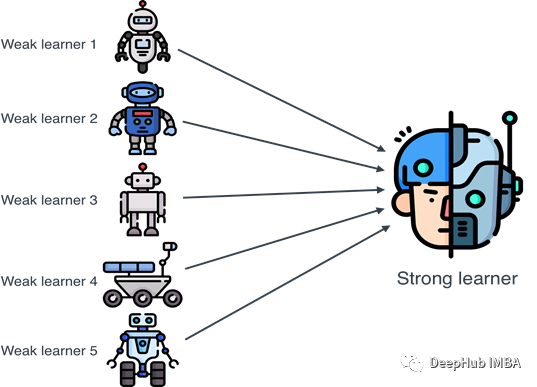

集成学习(Ensemble Learning)是一种机器学习范式,通过构建并结合多个学习器(也被称为基学习器或组件学习器)来完成学习任务。这些学习器可以是从同一种学习算法产生的同质学习器,也可以是从不同学习算法产生的异质学习器。集成学习的核心思想是“好而不同”,即基学习器应该具有好的性能,并且它们之

人工智能|集成学习——混合专家模型 (MoE)

与稠密模型相比,预训练速度更快与具有相同参数数量的模型相比,具有更快的推理速度需要大量显存,因为所有专家系统都需要加载到内存中在微调方面存在诸多挑战,但 近期的研究 表明,对混合专家模型进行指令调优具有很大的潜力。为了实现大模型的高效训练和推理,有的是从模型底层下手,比如直接改变底层模型架构,将原来

机器学习 第8章-集成学习

集成学习(ensemble learning)通过构建并结合多个学习器来完成学习任务,有时也被称为多分类器系统(multi-classifersystem)、基于委员会的学习(committee-based learning)等。图8.1显示出集成学习的一般结构:先产生一组“个体学习器”(indiv

第八章:集成学习

在RF中,对基决策树的每个结点,先从该结点的属性集合中随机选择一个包含k个属性的子集,然后再从这个子集中选择一个最优属性用于划分.这里的参数k控制了随机性的引入程度:若令k= d,则基决策树的构建与传统决策树相同;采用“重采样法”,可获得“重启动”机会以避免训练过程过早停止,即在抛弃不满足条件的当前

AI - 集成学习

并且可以使用交叉验证等技术来选择最优的模型,根据性能评估的结果,可以调整集成学习器的参数,如基学习器的数量、投票策略等,以优化其性能。💎集成学习是机器学习中的一种思想,它通过多个模型的组合形成一个精度更高的模型,参与组合的模型成为弱学习器(基学习器)。基学习器是可使用不同的学习模型,比如:支持向量

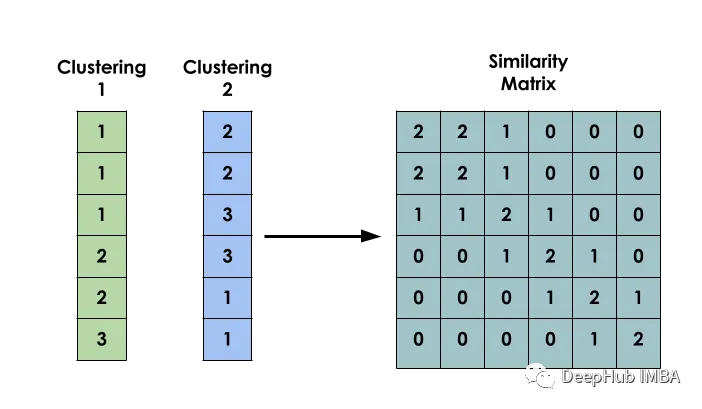

无监督学习的集成方法:相似性矩阵的聚类

在机器学习中,术语Ensemble指的是并行组合多个模型,这个想法是利用群体的智慧,在给出的最终答案上形成更好的共识。

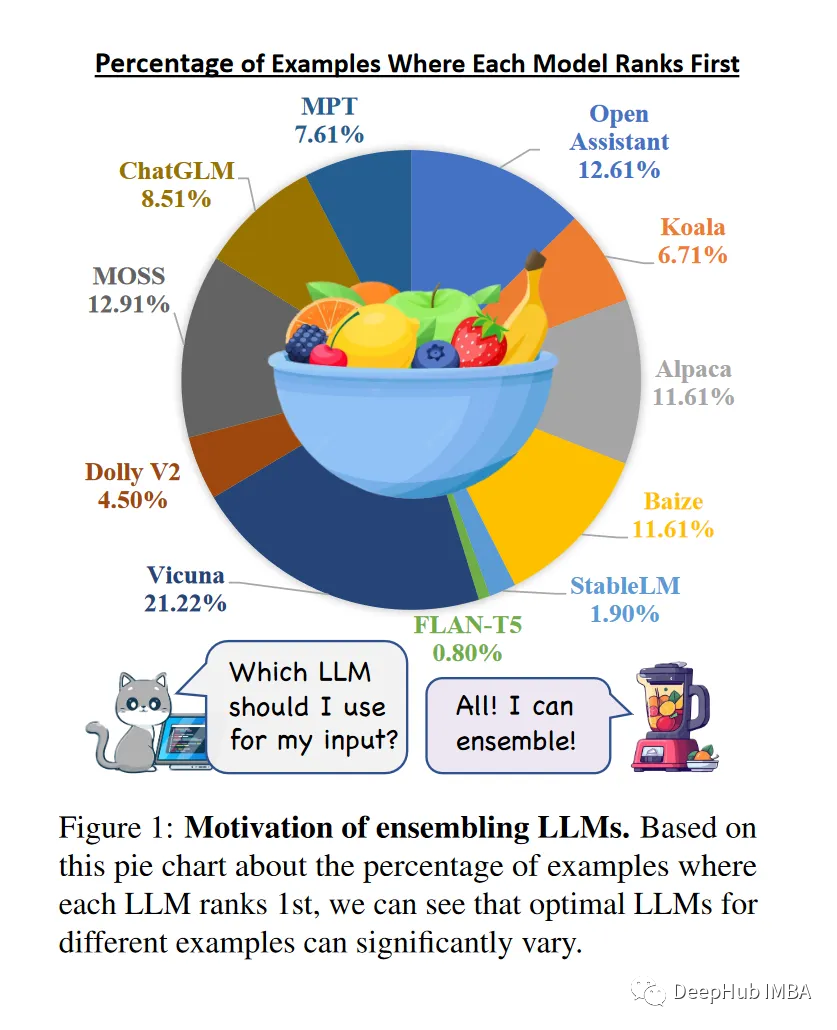

LLM-Blender:大语言模型也可以进行集成学习

LLM-Blender是一个集成框架,可以通过利用多个开源大型语言模型(llm)的不同优势来获得始终如一的卓越性能。

机器学习强基计划10-1:为什么需要集成学习?核心原理是什么?

集成学习是一种通过结合多个学习器来获得比单一学习器显著优越泛化性能的算法框架,本文梳理和推导集成学习的基本概念

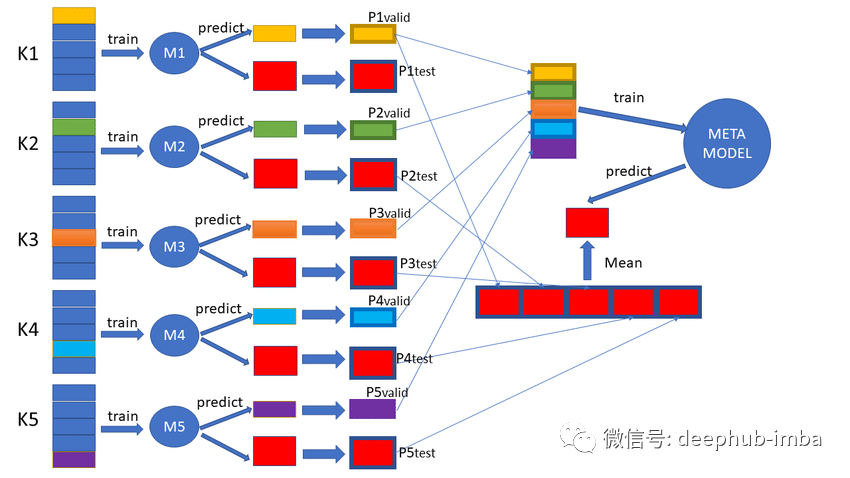

集成学习之Stacking(堆栈)方法

集成学习是监督式学习的一种。主流的方法有Bagging、Boosting和Stacking。本文主要对Stacking进行讲解分析。Bagging是采取投票或平均的方式来处理N个基模型的输出,而Stacking方法是训练一个模型用于组合之前的基模型。具体过程是将之前训练基模型的输出构造为一个训练集,

【机器学习之模型融合】Voting投票法基础理论

认识模型融合和投票法Voting

AI遮天传 ML-集成学习

“Two heads are better than one.”“三个臭皮匠,顶一个诸葛亮”把多个人的智慧集合到一起,可能会比一个人好,放在机器学习上,我们借鉴这一经验,把融合多个学习方法的结果来提升效果的方法,我们叫做:Ensemble learning 集成学习......

机器学习模型的集成方法总结:Bagging, Boosting, Stacking, Voting, Blending

集成学习是一种元方法,通过组合多个机器学习模型来产生一个优化的模型,从而提高模型的性能。集成学习可以很容易地减少过拟合,避免模型在训练时表现更好,而在测试时不能产生良好的结果。

【软考】系统集成项目管理工程师 (一)信息化知识

软考中级——系统集成项目管理工程师备考干货第一章:信息化知识。

使用折外预测(oof)评估模型的泛化性能和构建集成模型

折外预测在机器学习中发挥着重要作用,可以提高模型的泛化性能。

集成学习中的软投票和硬投票机制详解和代码实现

集成方法是将两个或多个单独的机器学习算法的结果结合在一起,并试图产生比任何单个算法都准确的结果