冲激阶跃与卷积

时移性质:若ƒ1(t)*ƒ2(t)=ƒ(t),则有ƒ1(t-t1)*ƒ2(t-t2)=ƒ(t-t1-t2)。分配律:ƒ1(t)*[ƒ2(t)+ƒ3(t)]=ƒ1(t)*ƒ2(t)+ƒ1(t)*ƒ3(t);f(t)与冲激偶函数的卷积:ƒ(t)*δ’(t)=f’(t)*δ(t)=ƒ’(t);2)反转平移

AI 工具合辑盘点,总有一款适合你

等功能。其中,翻译支持。

空间变形网络——STN

CNN 的机理使得 CNN 在处理图像时可以做到 transition invariant,却没法做到 scaling invariant 和 rotation invariant。即使是现在火热的 transformer 搭建的图像模型 (swin transformer, vision tran

torch.cuda.OutOfMemoryError: CUDA out of memory.

发现gpu:0显存被PID:19409程序大量占用, 报错应该是默认在gpu:0训练导致显存不足, 接着查看gpu:0上程序所属用户(如果不是师兄的我就kill了)设置完成后查看显存占用情况可以看到, gpu:1显存占用马上上升了, 不影响其他gpu卡的显存。这样即可指定在gpu:1上训练, 实际上

yolov7改进系列

111

YOLOv5基础知识点——激活函数

激活函数

使用 T5 模型来做文本分类任务的一些总结

使用 T5 (Text-to-Text Transfer Transformer) 来做文本分类任务的一些总结

nn.Parameter()

可以方便地定义和管理模型的可训练参数,并且在模型训练过程中可以自动计算梯度并更新参数值,是构建神经网络模型时常用的工具。是 PyTorch 中的一个类,用于创建可训练的参数(权重和偏置),这些参数会在模型训练过程中自动更新。

基于MindSpore复现UNet—语义分割

U-Net: Convolutional Networks for Biomedical Image Segmentation

基于pytorch用yolov5算法实现目标检测与分割

适合新手入门玩一下目标的检测和分割,大概了解yolov5算法的一些基本操作。1.1 课题背景目标检测的目的是判断在单张图片或者连续图片(视频)中,感兴趣的单个或者 多个物体是否存在,如果存在,需要将感兴趣的单个或者多个物体的位置和大小确 定。通常情况下我们使用一个矩形框来表示一个物体的位置和大小,矩

win下YOLOv7训练自己的数据集(交通标志TT100K识别)

遗传算法是利用种群搜索技术将种群作为一组问题解,通过对当前种群施加类似生物遗传环境因素的选择、交叉、变异等一系列的遗传操作来产生新一代的种群,并逐步使种群优化到包含近似最优解的状态,遗传算法调优能够求出优化问题的全局最优解,优化结果与初始条件无关,算法独立于求解域,具有较强的鲁棒性,适合于求解复杂的

【2023 · CANN训练营第一季】昇腾AI入门课(Pytorch)---昇腾AI入门课(PyTorch)微认证考试

19、当迁移出现报错时,查看底层日志是一种常见的DEBUG手段,可以通过设置环境变量ASCEND_GLOBAL_LOG_LEVEL的方式收集不同等级的日志。20、昇腾软硬件基础平台中包括应用使能、AI框架、异构计算架构、Atlas系列硬件等,其中()对下适配不同的硬件形态,对上适配不同的AI框架,发

燕千云ChatGPT应用,用过的都说香

不断尝试和突破ChatGPT在细分领域的业务尝试,寻求更多的业务场景,来帮助企业降低运营成本,提升服务效率。

2023最新pytorch安装教程,简单易懂,面向初学者(Anaconda+GPU)

2023最新pytorch安装教程,简单易懂,面向初学者(Anaconda+GPU)

YOLOv5解析 | 参数与性能指标

:Confidence Threshold,置信度阈值。只显示预测概率超过conf_thres的预测结果。:Intersect over Union Threshold,交并比阈值。:以某种方式计算AP值来表达PR图的面积:每个类的AP值的平均数。用于表达多类标签预测的性能,如AP一样,mAP越高,

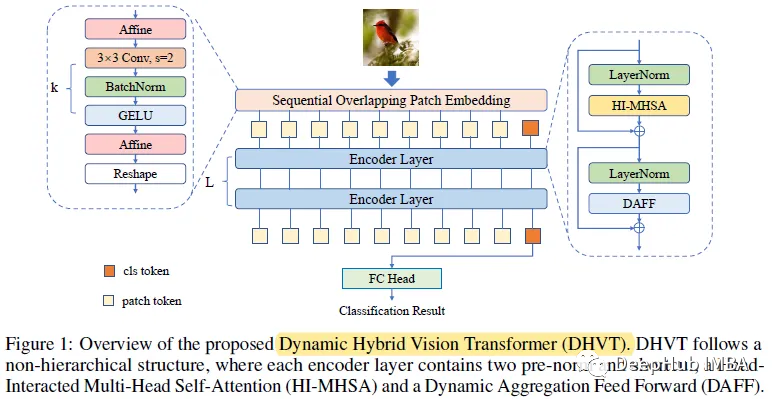

DHVT:在小数据集上降低VIT与卷积神经网络之间差距,解决从零开始训练的问题

VIT在归纳偏置方面存在空间相关性和信道表示的多样性两大缺陷。所以论文提出了动态混合视觉变压器(DHVT)来增强这两种感应偏差。

Yolov5 激活函数

activation.py文件

深入浅出PaddlePaddle函数——paddle.to_tensor

paddle.to_tensor

yolov5模型(.pt)在RK3588(S)上的部署(实时摄像头检测)

yolov5模型(.pt)在RK3588(S)上的部署(实时摄像头检测)

深度学习docker环境配置之nvidia-docker安装使用

docker容器技术–。:Anaconda用于隔离不同的python环境;docker可以理解成在你的机器里面安装了一个独立的系统,因此它可以隔离不同的CUDA环境,还有着独立的文件系统,防止别人删掉你的实验和环境等。