深度学习优化入门:Momentum、RMSProp 和 Adam

深度学习优化入门:Momentum、RMSProp 和 Adam

使用 Transformer 和 Amazon OpenSearch Service 构建基于列的语义搜索引擎

在数据湖中,对于数据清理和注释、架构匹配、数据发现和跨多个数据来源进行分析等许多操作,查找相似的列有着重要的应用。如果不能从多个不同的来源准确查找和分析数据,就会严重拉低效率,不论是数据科学家、医学研究人员、学者,还是金融和政府分析师,所有人都会深受其害。传统解决方案涉及到使用词汇关键字搜索或正则表

10. 网络模型使用及修改

【代码】10. 网络模型使用及修改。

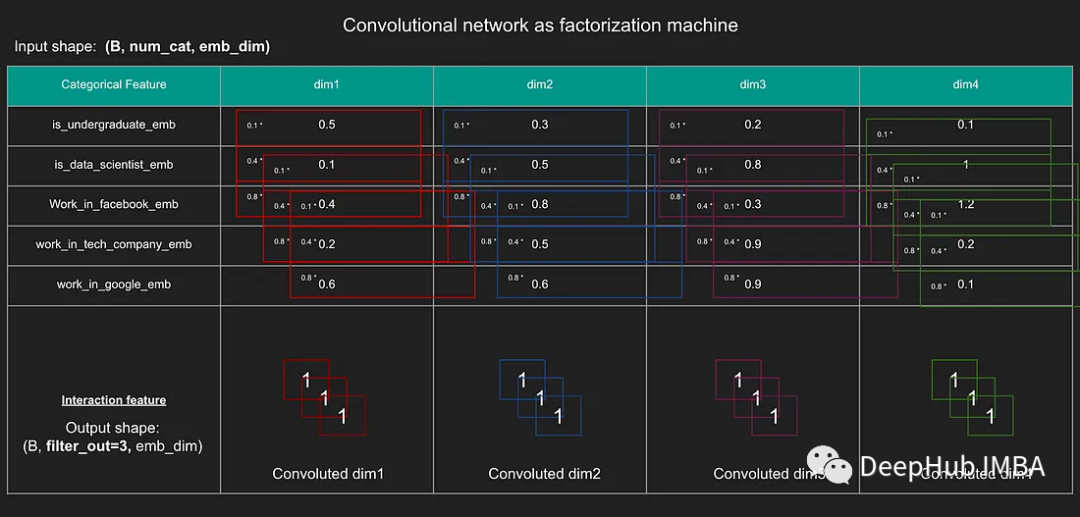

使用卷积操作实现因子分解机

本文将介绍如何使用卷积操作实现因子分解机器。

交叉熵简介

交叉熵(Cross Entropy)是用来衡量两个概率分布之间的差异性的一种方法。在机器学习和深度学习中,交叉熵常常被用作损失函数,用来衡量模型预测的结果与真实结果之间的差距。Hpq−i1∑npilogqi其中,pi表示真实分布中第i个事件发生的概率,qi表示模型预测分布中第i个事件发生的

BIT 变化检测模型复现 深度学习学习笔记 基于transformer结构的图像处理模型

transformer结构在遥感图像处理和计算机视觉当中展现出优势,BIT网络利用了transformer结构,这里是变化检测模型BIT复现过程,手把手教GitHub源码复现。包括数据结构解析、修改及环境配置,训练、预测过程报错及debug修改。利用pycharm进行代码debug。

AI时代,程序员需要焦虑吗?

ChatGPT 横空出世后,“AI 即将取代程序员” 的观点一度引发热议,至今尚未完全冷却。ChatGPT 是一种基于人工智能技术的对话生成系统,其受欢迎的程度在一定程度上说明了人们对于人工智能技术的兴趣和追求。但是,从目前的实际情况来看,人工智能技术还没有达到完全替代程序员的程度。首先,AI 技术

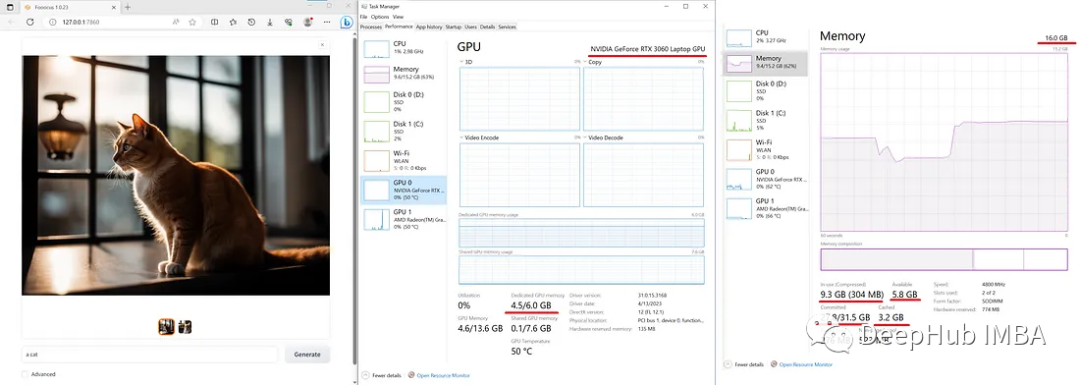

Fooocus:一个简单且功能强大的Stable Diffusion webUI

在这篇文章中,我们将介绍如何在本地和Colab上使用Fooocus

基于开源模型搭建实时人脸识别系统(四):人脸质量

这篇我们简要介绍了一下人脸质量评估,不过笔者在这方面涉猎也不深,只是做个简单的总结,需要深入做还是有不少工作。

医学图像分割综述:U-Net系列

论文地址代码地址医学图像自动分割是医学领域的一个重要课题,也是计算机辅助诊断范式的一个重要对应。U-Net是最广泛的图像分割架构,由于其灵活性,优化的模块化设计,并在所有医学图像模式的成功。多年来,U-Net模型得到了学术界和工业界研究人员的极大关注。该网络的几个扩展已经被提出,以解决医疗任务所产生

利用Google Colab免费使用GPU服务器详细攻略

前言Google Colab是一个基于云端的免费Jupyter笔记本环境,可供用户创建、分享、运行Python代码和机器学习模型。

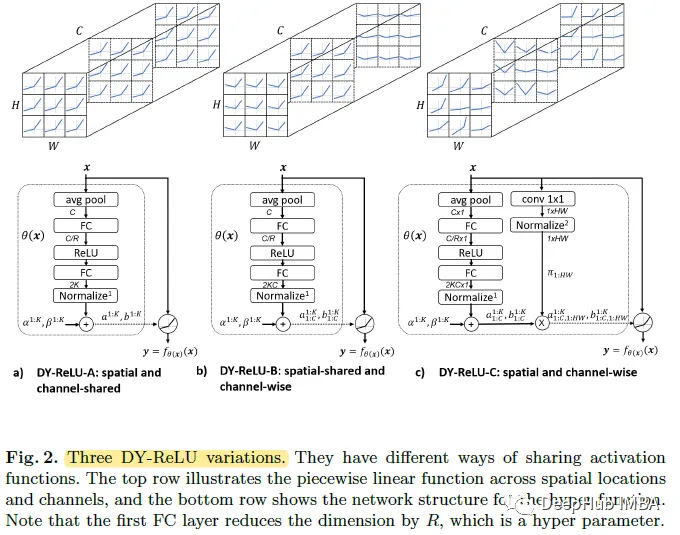

Dynamic ReLU:根据输入动态确定的ReLU

这是我最近才看到的一篇论文,它提出了动态ReLU (Dynamic ReLU, DY-ReLU),可以将全局上下文编码为超函数,并相应地调整分段线性激活函数

使用DiffusionDet训练自己的数据集(pascal-voc)

此贴建立在DiffusionDet和detectron2环境已经配置好(能跑通DiffusionDet的demo.py就行),之后再出这个手顺我没有跟着官方手顺建立软链接什么的,比较麻烦,我直接按照自己的习惯建的目录。

2023年的深度学习入门指南(6) - 在你的电脑上运行大模型

上一篇我们介绍了大模型的基础,自注意力机制以及其实现Transformer模块。因为Transformer被PyTorch和TensorFlow等框架所支持,所以我们只要能够配置好框架的GPU或者其他加速硬件的支持,就可以运行起来了。而想运行大模型,恐怕就没有这么容易了,很有可能你需要一台Linux

Stable Diffusion web UI 部署详细教程

本文使用 AutoDL 平台进行 Stable Diffusion web UI 云端部署AutoDL算力云 | 弹性、好用、省钱。租GPU就上AutoDL。

模型量化(6):Yolov5 QAT量化训练

从模型量化(5): 敏感层分析可以看出来,对于yolov5-nano模型,对最后一层detect层进行敏感层分析的时候,发现对检测精度的影响比较大。所以在PTQ/QAT在进行量化时,会跳过这些敏感层。QAT微调的模型,就是PTQ在校准后的模型。从上一小节可以看出如果PTQ中模型训练和量化是分开的,而

windows cuda更新教程

windows cuda更新、安装教程

深度学习总结——用自己的数据集微调CLIP

在自己的数据集上微调CLIP模型

安装mmcv-full适配torch版本

比如我的cuda版本是10.1,torch版本是1.8.0,mmcv-full安装命令如下。

ByteTracker行人跟踪核心代码解读

byteTracker中因为目标检测和行人跟踪是解耦的,因此这里主要分析的是byteTracker中的代码。也即是分析当给定一帧图片frame_id,给定这帧中的box列表,行人跟踪类是怎么跟踪每条轨迹的。也就是https://github.com/ifzhang/ByteTrack中位于目录tut