六十七、Spark-两种运行方式(本地运行,提交集群运行)

本地运行:在IDEA中直接运行控制台输出结果即可集群运行:在本地将程序打包为 jar,提交至集群运行其程序(将结果上传至hdfs)

spark运行架构和基础

基本 概念RDD:(官方概念)弹性分布式数据集,就是一个个的在内存里的数据。就是数据的基本单位,所有spark都是来操作他的 DAG 是有向无环图,它的作用主要是反应rdd之间的关系。 Excutor 就是一个容器,就像Hadoop的node一样,用来运行的 应用 顾名思义来编写spark程序的 任

像写SQL一样去处理内存中的数据,SparkSQL入门教程

像写SQL一样去处理内存中的数据,SparkSQL入门教程

一天学完spark的Scala基础语法教程十三、文件IO操作(idea版本)

????前言????????博客主页:红目香薰_CSDN博客-大数据,计算机理论,MySQL领域博主????✍本文由在下【红目香薰】原创,首发于CSDN✍????2022年最大愿望:【服务百万技术人次】????????初始环境地址:【spark环境搭建(idea版本)_红目香薰-CSDN博客】???

Spark追妻系列(TopN案例和动作算子)

Spark中的TopN案例

一天学完spark的Scala基础语法教程十二、异常处理(idea版本)

????前言????????博客主页:红目香薰_CSDN博客-大数据,计算机理论,MySQL领域博主????✍本文由在下【红目香薰】原创,首发于CSDN✍????2022年最大愿望:【服务百万技术人次】????????初始环境地址:【spark环境搭建(idea版本)_红目香薰-CSDN博客】???

一天学完spark的Scala基础语法教程十、类和对象(idea版本)

????前言????????博客主页:红目香薰_CSDN博客-大数据,计算机理论,MySQL领域博主????✍本文由在下【红目香薰】原创,首发于CSDN✍????2022年最大愿望:【服务百万技术人次】????????初始环境地址:【spark环境搭建(idea版本)_红目香薰-CSDN博客】???

Spark追妻系列(Spark初了解)

感觉每天又有了希望,又有动力,感觉学习尽头十足Spark是什么Spark是一个用来实现快速而通用的集群计算的平台。在之前,学习了MR,学习了hadoop,用mapreduce来对数据进行处理,但是hadoop是用批处理的,而且还有延迟,况且,出来了Hive,Hive将sql转化为mr算子。可以不用去

一天学完spark的Scala基础语法教程七、数组(idea版本)

????前言????????博客主页:红目香薰_CSDN博客-大数据,计算机理论,MySQL领域博主????✍本文由在下【红目香薰】原创,首发于CSDN✍????2022年最大愿望:【服务百万技术人次】????????初始环境地址:【spark环境搭建(idea版本)_红目香薰-CSDN博客】???

六十五、Spark-综合案例(搜狗搜索日志分析)

业务逻辑:针对SougoQ用户查询日志数据中不同字段,使用SparkContext读取日志数据,封装到RDD数据集中,调用Transformation函数和Action函数进行处理不同业务统计分析...

六十四、Spark-分别统计各个单词个数及特殊字符总个数

广播变量(Broadcast Variables):广播变量用来把变量在所有节点的内存之间进行共享,在每个机器上缓存一个只读的变量,而不是为机器上的每个任务都生成一个副本,简单理解:减少内存,减小计算压力;

数分-理论-大数据7-Spark

数分-理论-大数据7-Spark(大数据框架)(数据分析系列)文章目录数分-理论-大数据7-Spark(大数据框架)1知识点2具体内容2.1概述2.1.1起源2.1.2诞生2.1.3Spark与Hadoop、MapReduce、HDFS的关系2.1.4生态体系2.2编程模型-核心2.2.1RDD概述

六十三、Spark-读取数据并写入数据库

需求说明:使用Spark流式计算 将数据写入MySQL,并读取数据库信息进行打印

02环境搭建

02环境搭建

spark技术学习与思考(sparkcore&sparksql)

Spark 产生之前,已经有 MapReduce 这类非常成熟的并行计算框架存在了,并提供了高层次的API(map/reduce),它在集群上进行计算并提供容错能力,从而实现分布式计算。所以为什么 spark 会流行呢?

学会RDD就学会了Spark,Spark数据结构RDD快速入门

学会RDD就学会了Spark,Spark数据结构RDD快速入门

十亿条数据需要每天计算怎么办?Spark快速入门

spark快速入门,解决亿级数据计算问题

Spark进行独热编码

本文总计 500 字,预计阅读需要 2-3 分钟

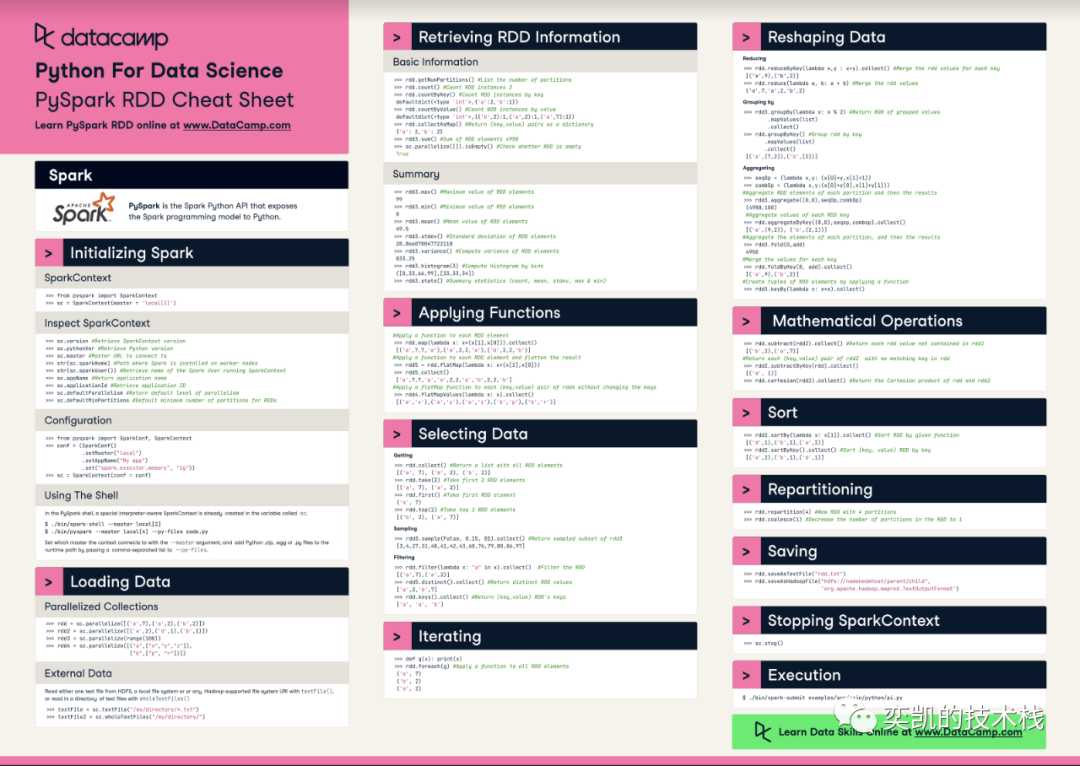

PySpark 速查表

在本文中,我将介绍datacamp的这份Pyspark的速查表

Spark统计一座城市的男女人数,以及男女消费额的最高与最低

Spark统计一座城市的总人数,男女人数,总消费额,人均消费额,以及男女消费额的最高与最低