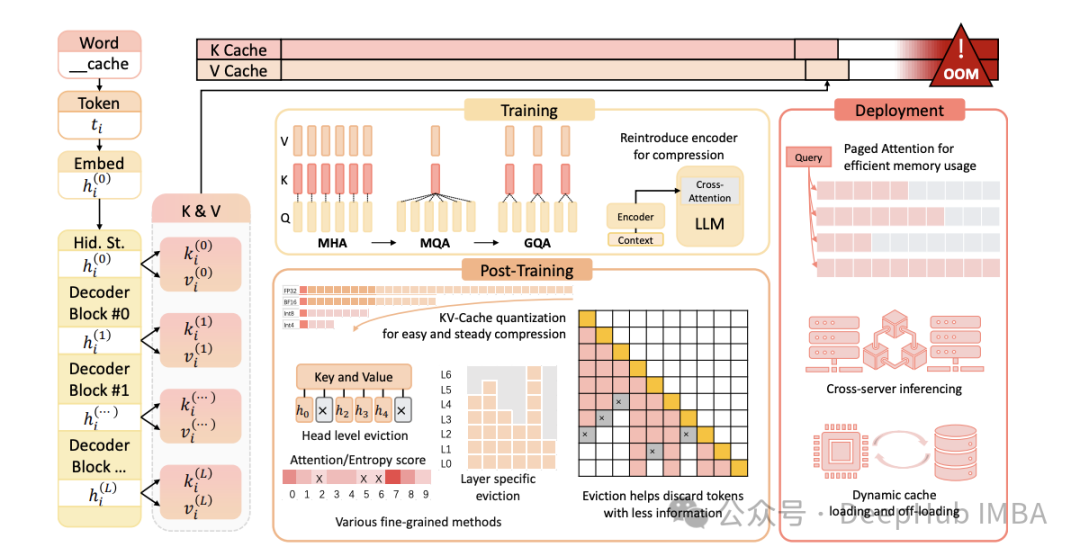

LLM高效推理:KV缓存与分页注意力机制深度解析

随着大型语言模型(LLM)规模和复杂性的持续增长,高效推理的重要性日益凸显。KV(键值)缓存与分页注意力是两种优化LLM推理的关键技术。本文将深入剖析这些概念,阐述其重要性,并探讨它们在仅解码器(decoder-only)模型中的工作原理。

AnythingLLM一个开源免费且容易搭建和使用的本地AI问答知识库助手的应用

您一直在寻找的全方位AI应用程序。与您的文档聊天,使用AI代理,高度可配置,多用户,无需繁琐的设置。👉 适用于桌面(Mac、Windows和Linux)的AnythingLLM!这是一个全栈应用程序,可以将任何文档、资源(如网址链接、音频、视频)或内容片段转换为上下文,以便任何大语言模型(LLM)

ORCA:基于持续批处理的LLM推理性能优化技术详解

ORCA系统创新性地提出了持续批处理概念,通过引入迭代级调度和选择性批处理机制,有效解决了大语言模型批处理中的关键技术挑战。

大语言模型(LLM)安全:十大风险、影响和防御措施

大语言模型(LLM)安全对于防止未经授权的访问和滥用敏感数据至关重要。由于这些模型处理大量信息,数据泄露可能会导致严重的隐私侵犯和知识产权盗窃。通过加密、访问控制和定期审计确保数据保护有助于降低这些风险,保护大语言模型(LLM)处理的信息的完整性和机密性。

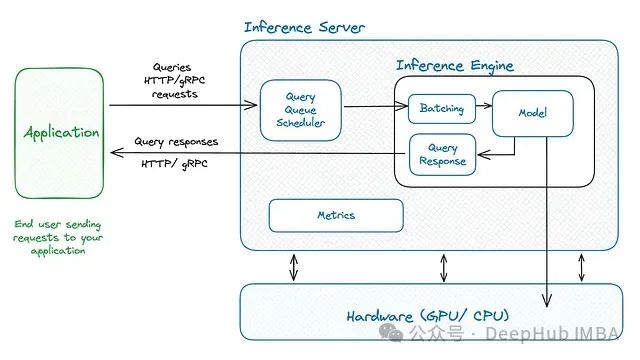

从本地部署到企业级服务:十种主流LLM推理框架的技术介绍与对比

本文将深入探讨十种主流LLM服务引擎和工具,系统分析它们在不同应用场景下的技术特点和优势。

OpenWebUI系列之 如何通过docker自动将其更新到OpenWebUI最新版本

Open WebUI 是一个可扩展、功能丰富且用户友好的自托管 WebUI,旨在完全离线运行。它支持各种 LLM 运行器,包括 Ollama 和 OpenAI 兼容 API。如何通过docker自动将其更新到OpenWebUI最新版本?

AI大模型开发架构设计(13)——LLM大模型的向量数据库应用实战

大模型的局限性向量数据库使用场景以及改建大模型向量数据库应用技术架构剖析利用向量检索构建知识库案例

AI多模态大模型+机械臂打造具身实验平台

这样做的好处是,如果你的指令涉及到一些列的复杂动作(好几个机械臂基本动作函数,需要用多模态信息数据),这样更能确保函数参数提取的正确率,还有如果某一个机械臂基本动作单元函数是要处理多次类似的动作,即你的参数可能是一个数组之类的,比如你让机器人进行搬运任务,就需要给它很多个目标点参数,这是因为可以明确

为什么说AI颠覆了用户场景?

AIGC时代,所有软件都有机会重塑一遍

ollama安装(ubuntu20.04)

本文指导Ollama的安装过程。

深度认知大模型文件格式GGUF

Hugging Face Hub 支持所有文件格式,但内置了GGUF 格式的功能,这是一种二进制格式,针对快速加载和保存模型进行了优化,使其在推理方面非常高效。GGUF 旨在与 GGML 和其他执行器一起使用。GGUF 由@ggerganov开发,他也是流行的 C/C++ LLM 推理框架llama

docker 本地部署大模型(ollama)

此处由于挂载目录使用了相对路径,所以本地文件夹位于 /var/lib/docker/volumes/ollama而非运行命令的相对路径测试 api。

倚天屠龙:Github Copilot vs Cursor

不管人工智能是否能取代开发人员,都建议你现在开始接触AI辅助编程工具。我推荐你从尝试GitHub Copilot和Cursor开始。

智谱AI——智能体开发探索

使用智谱AI探索大语言模型智能体开发。

Qwen大模型简介

Qwen系列大模型的参数规模为18亿(1.8B)、70亿(7B)、140亿(14B)和720亿(72B),包括基础模型Qwen,即Qwen-1.8B、Qwen-7B、Qwen-14B、Qwen-72B,以及对话模型Qwen-Chat,即Qwen-1.8B-Chat、Qwen-7B-Chat、Qwen

240810-Gradio自定义Button按钮+事件函数+按钮图标样式设定

margin: 0;/* 可调整最大宽度 */"""# 自定义的 JavaScript,用于捕捉按钮点击并触发 Gradio 按钮的 click 事件"""# Gradio 应用# 输入文本# 输出文本# 默认带icon的按钮# 隐藏真实按钮# 自定义 HTML 按钮"""# 显示自定义按钮# 绑定

【AI落地应用实战】Amazon SageMaker JumpStart 体验零一万物的 Yi 1.5 模型

Amazon SageMaker JumpStart 是 Amazon SageMaker 平台的一部分,旨在帮助用户更快、更轻松地启动和开发机器学习项目。这是亚马逊云科技提供的一个非常实用的工具,特别适合那些希望迅速启动和开发机器学习项目的用户。SageMaker JumpStart 可以视为 S

最新大模型架构TTT模型代码解析(一)

这项来自斯坦福大学、加州大学伯克利分校、加州大学圣迭戈分校和 Meta 的研究提出了一个新颖的序列建模方法,称为测试时训练(Test-Time Training, TTT)层。TTT 层通过用机器学习模型取代 RNN 的隐藏状态,并使用输入 token 的实际梯度下降来压缩上下文。研究表明,这种方法

LLM端侧部署系列 | 手机上运行47B大模型?上交推理框架PowerInfer-2助力AI手机端侧部署

近日,上海交大为大模型能够在智能手机上部署提出PowerInfer-2,该框架是专为智能手机设计且高度优化的推理框架。目前PowerInfer-2支持的最大模型是Mixtral 47B MoE模型,在inference的时候每秒可生成11.68个token,这比其他最先进的框架快22倍。即使是使用7

理性看待、正确理解 AI 中的 Scaling “laws”

在这种模式中,物种的形态在长时间的稳定期(equilibrium)之后,会经历短暂的、快速的形态变化(punctuation),这些变化可能伴随着物种的灭绝和新物种的产生。))进行改进的使用场景。但考虑到其中大部分视频并没有实用的音频内容(可能是音乐、静态图片或游戏视频等),实际可用的数据量可能远低