下载学习,轻松部署,在 AI PC 上体验基于英特尔® 酷睿™ Ultra 优化的大语言模型!

下载 PDF 文档

动手实验

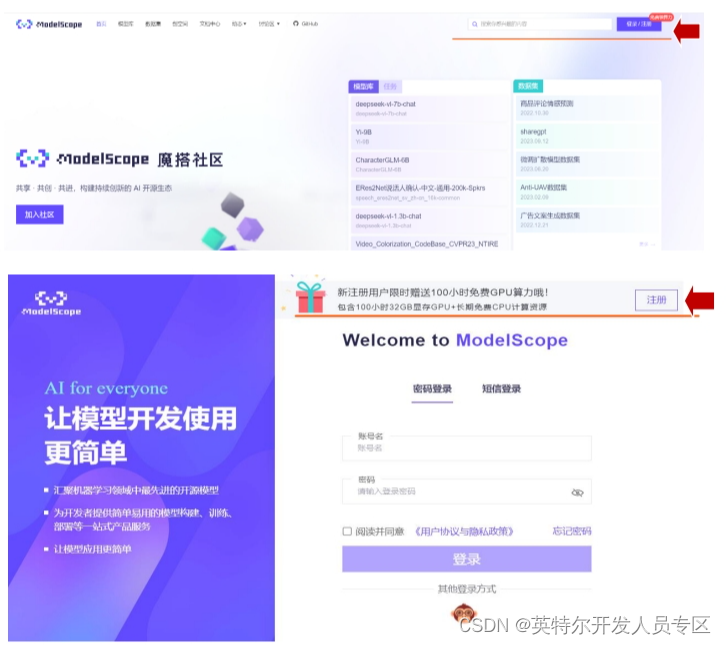

一、 注册&登录 ModelScope

- 进入 ModelScope(https://www.modelscope.cn/home),右上角点击 完成新用户的注册;

- 注册完成后,登录 ModelScope,进入首页,请确定已经绑定阿里云账 号,并已获得免费的配套云计算资源。启动 CPU 服务器:

- 启动成功后,点击“查看”

二、环境配置

- 点击 Terminal 图标,打开终端命令行环境。

- 环境搭建:

在终端命令行环境中输入下列命令用于在环境目录/opt/conda/envs 下新 建文件夹 itrex:

cd /opt/conda/envs

mkdir itrex

使用 wget 命令复制运行环境镜像文件并在云主机的 itrex 目录进行运行环 境的恢复。(任选一个下载即可)

下载源 1:

wget https://idz-ai.oss-cn-hangzhou.aliyuncs.com/LLM/itrex.tar.gz

下载源 2:

wget https://filerepo.idzcn.com/LLM/itrex.tar.gz

解压文件:

tar -zxvf itrex.tar.gz -C itrex/

激活环境:

conda activate itrex

安装对应的 kernel:

python -m ipykernel install --name itrex

三、LLM 下载

切换至工作目录:

cd /mnt/workspace

根据实验需要,下载相对应的中文大模型至本地:

git clone https://www.modelscope.cn/ZhipuAI/chatglm3-6b.git git clone https://www.modelscope.cn/qwen/Qwen-7B-Chat.git

四、chatbot 的构建和使用

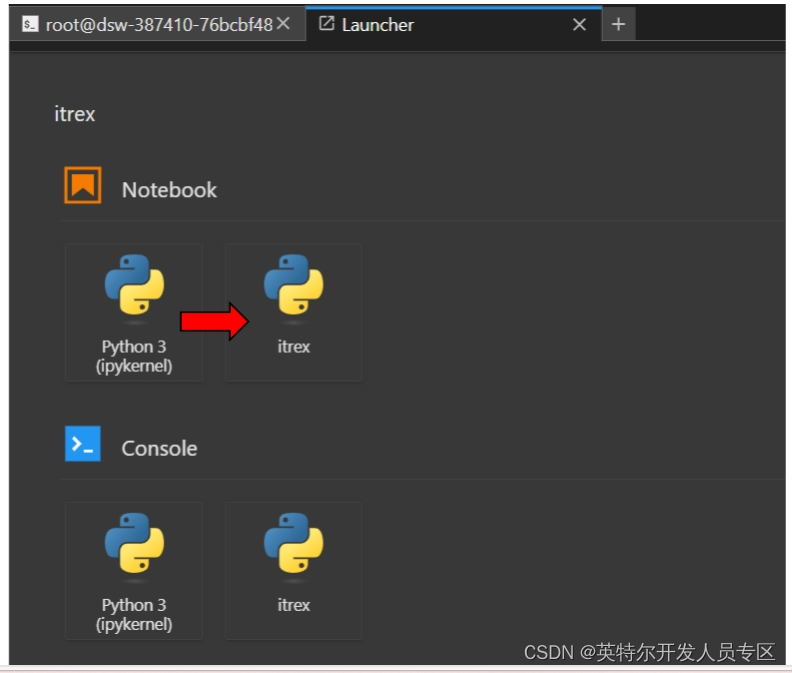

在 Notebook 的 Launcher 中选择基于 itrex 的环境,新建一个.ipynb 文件

量化并构建 chatbot:在 Notebook 单元格 cell 中输入如下代码:

# Build chatbot with INT4 weight-only quantization, computations in

AMX INT8

from intel_extension_for_transformers.neural_chat import

build_chatbot, PipelineConfig

from intel_extension_for_transformers.transformers import RtnConfig

config = PipelineConfig(model_name_or_path="./chatglm3-6b",

6

optimization_config=RtnConfig(bits=4, compute_dtype="int8",

weight_dtype="int4_fullrange"))

chatbot = build_chatbot(config)

点击左侧按钮运行;

使用 chatbot 得到回答:新建一个 notebook 的单元格 cell,输入如下代 码:

# Perform inference/generate a response

response = chatbot.predict(query="上海有哪些景点")

print(response)

五、其他大语言模型部署实验

在完成上述实验后,可以进一步尝试下载及加载其他大语言模型进行 部署实验的体验。推荐体验的开源模型列表:

通义千问 Qwen-7B-Chat

智谱 ChatGLM3-6B

百川 2-7B-对话模型

Intel 发布的开源模型如 Neural Chat 等(待更新

版权归原作者 英特尔开发人员专区 所有, 如有侵权,请联系我们删除。