【OpenCV学习】(十二)图像分割与修复

背景

图像分割本质就是将前景目标从背景中分离出来。在当前的实际项目中,应用传统分割的并不多,大多是采用深度学习的方法以达到更好的效果;当然,了解传统的方法对于分割的整体认知具有很大帮助,本篇将介绍些传统分割的一些算法;

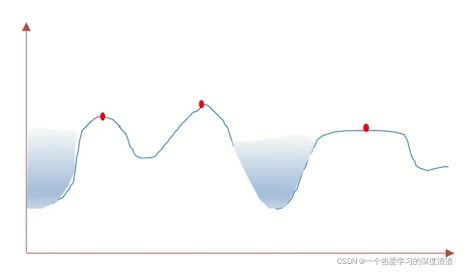

一、分水岭法

原理图如下:

利用二值图像的梯度关系,设置一定边界,给定不同颜色实现分割;

实现步骤:

标记背景 —— 标记前景 —— 标记未知区域(背景减前景) —— 进行分割

函数原型:

watershed(img,masker):分水岭算法,其中masker表示背景、前景和未知区域;

distanceTransform(img,distanceType,maskSize):矩离变化,求非零值到最近的零值的距离;

connectedComponents(img,connectivity,…):求连通域;

代码实现:

img = cv2.imread('water_coins.jpeg')

gray = cv2.cvtColor(img, cv2.COLOR_BGR2GRAY)# 加入cv2.THRESH_OTSU表示自适应阈值(实现更好的效果)

ret, thresh = cv2.threshold(gray,100,255, cv2.THRESH_BINARY_INV + cv2.THRESH_OTSU)# 开运算(去噪点)

kernel = np.ones((3,3), np.int8)

open1 = cv2.morphologyEx(thresh, cv2.MORPH_OPEN, kernel, iterations =2)#膨胀

beijing = cv2.dilate(open1, kernel, iterations =1)# 获取前景

tmp = cv2.distanceTransform(open1, cv2.DIST_L2,5)

ret, qianjing = cv2.threshold(tmp,0.7*tmp.max(),255, cv2.THRESH_BINARY)# 获取未知区域

beijingj = np.uint8(beijing)

qianjing = np.uint8(qianjing)

unknow = cv2.subtract(beijing, qianjing)# 创建连通域

ret, masker = cv2.connectedComponents(qianjing)

masker = masker +1

masker[unknow==255]=0# 进行图像分割

result = cv2.watershed(img, masker)

img[result ==-1]=[0,0,255]

cv2.imshow('result', img)

cv2.waitKey(0)

二、GrabCut法

原理:通过交互的方式获得前景物体;

1、用户指定前景的大体区域,剩下的为背景区域;

2、用户可以明确指定某些地方为前景或背景;

3、采用分段迭代的方法分析前景物体形成模型树;

4、根据权重决定某个像素是前景还是背景;

函数原型:

grabCut(img,mask,rect,bgdModel,fbgModel,5,mode)

- mask:表示生成的掩码,函数输出的值,其中0表示背景、1表示前景、2表示可能背景、3表示可能前景;

代码如下:

classApp:

flag_rect =False

rect=(0,0,0,0)

startX =0

startY =0defonmouse(self, event, x, y, flags, param):if event == cv2.EVENT_LBUTTONDOWN:

self.flag_rect =True

self.startX = x

self.startY = y

print("LBUTTIONDOWN")elif event == cv2.EVENT_LBUTTONUP:

self.flag_rect =False

cv2.rectangle(self.img,(self.startX, self.startY),(x, y),(0,0,255),3)

self.rect =(min(self.startX, x),min(self.startY, y),abs(self.startX - x),abs(self.startY -y))print("LBUTTIONUP")elif event == cv2.EVENT_MOUSEMOVE:if self.flag_rect ==True:

self.img = self.img2.copy()

cv2.rectangle(self.img,(self.startX, self.startY),(x, y),(255,0,0),3)print("MOUSEMOVE")print("onmouse")defrun(self):print("run...")

cv2.namedWindow('input')

cv2.setMouseCallback('input', self.onmouse)

self.img = cv2.imread('./lena.png')

self.img2 = self.img.copy()

self.mask = np.zeros(self.img.shape[:2], dtype=np.uint8)

self.output = np.zeros(self.img.shape, np.uint8)while(1):

cv2.imshow('input', self.img)

cv2.imshow('output', self.output)

k = cv2.waitKey(100)if k ==27:breakif k ==ord('g'):

bgdmodel = np.zeros((1,65), np.float64)

fgdmodel = np.zeros((1,65), np.float64)

cv2.grabCut(self.img2, self.mask, self.rect,

bgdmodel, fgdmodel,1,

cv2.GC_INIT_WITH_RECT)# 注意np.where的用法可以用来筛选前景

mask2 = np.where((self.mask==1)|(self.mask==3),255,0).astype('uint8')

self.output = cv2.bitwise_and(self.img2, self.img2, mask=mask2)

由于效果并不是特别明显,并且运行时耗时会比较长,在这里就不展示了;

注意:np.where的用法需要掌握,可以将一个矩阵中选定的值与未选定的值做二值化的处理;

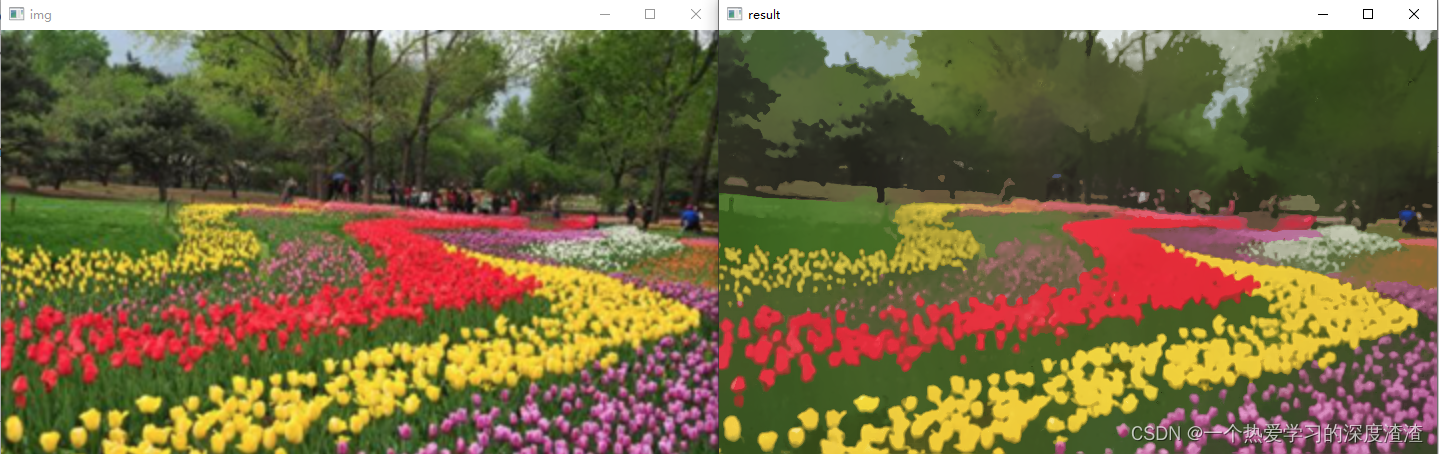

三、MeanShift法

实现原理:

- 并不是用来进行图像分割的,而是在色彩层面的平滑滤波;

- 中和色彩分布相近的颜色,平滑色彩细节,腐蚀掉面积较小的颜色区域;

- 以图像上任意点P为圆心,半径为sp,色彩幅值为sr进行不断的迭代;

函数原型:

pyrMeanShiftFiltering(img,sp,sr,…)

代码实现:

img = cv2.imread('flower.png')

result = cv2.pyrMeanShiftFiltering(img,20,30)

cv2.imshow('img', img)

cv2.imshow('result', result)

cv2.waitKey(0)

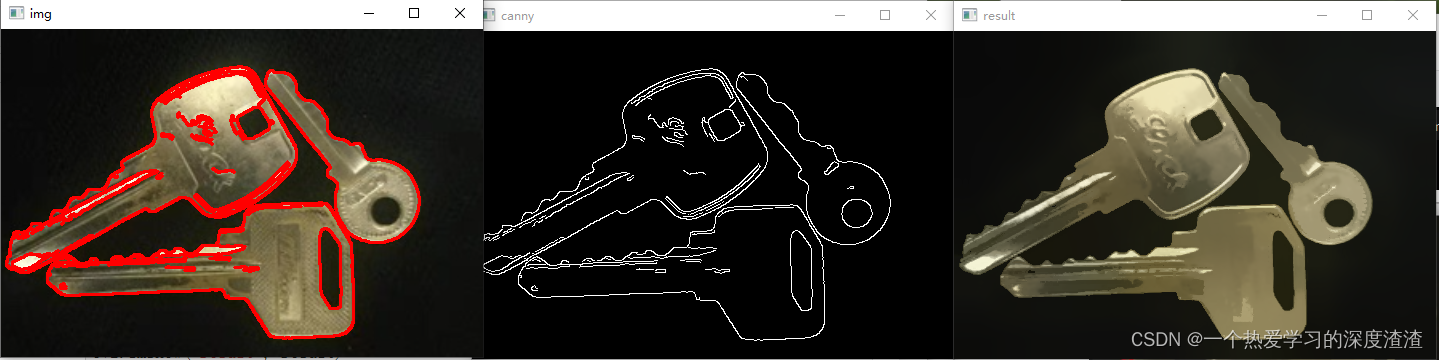

通过该函数可以实现色彩的平滑处理,做特效也是不错的(有种卡通化的效果),虽然该函数并不能直接做图像分割,但处理后的图像可以通过canny算法进行边缘检测;

Canny代码:

img = cv2.imread('key.png')

result = cv2.pyrMeanShiftFiltering(img,20,30)

img_canny = cv2.Canny(result,150,300)

contours, _ = cv2.findContours(img_canny, cv2.RETR_EXTERNAL, cv2.CHAIN_APPROX_SIMPLE)

cv2.drawContours(img, contours,-1,(0,0,255),2)

cv2.imshow('img', img)

cv2.imshow('result', result)

cv2.imshow('canny', img_canny)

cv2.waitKey(0)

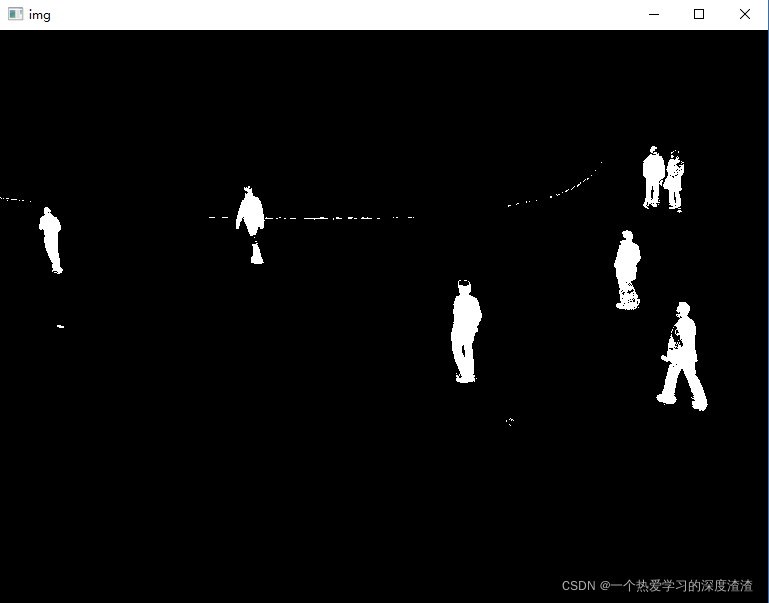

四、MOG前景背景分离法

首先需要了解视频的一些原理:

- 视频是一组连续帧组成的(一帧也可以看作一副图像)

- 帧与帧之间关系密切(又称为GOP)

- 在GOP中,背景几乎是不变的

主要有以下几种方法:

1、MOG去背景

原理:混合高斯模型为基础的前景、背景分割法;

函数原型:

createBackgroundSubtractorMOG(其中的默认值就不做讲解了)

代码实战:

cap = cv2.VideoCapture('./vtest.avi')

mog = cv2.bgsegm.createBackgroundSubtractorMOG()while(True):

ret, frame = cap.read()

mask = mog.apply(frame)

cv2.imshow('img', mask)

k = cv2.waitKey(10)if k ==27:break

cap.release()

cv2.destroyAllWindows()

五、拓展方法

1、MOG2

说明:与MOG算法类似,但对于亮度产生的阴影有更好的识别效果,噪点更多;

函数原型:createBackgroundSubtractorMOG2(默认参数不作介绍)

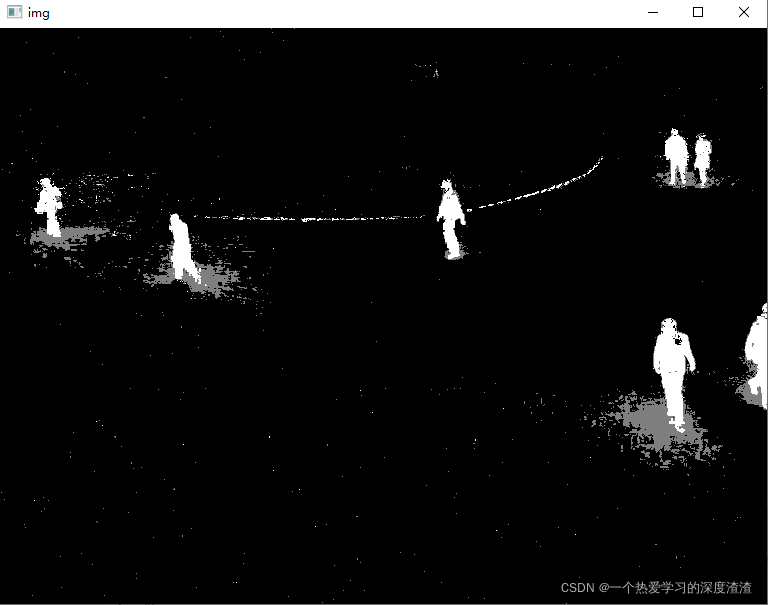

效果展示:

2、GMG

说明:静态背景图像估计和每个像素的贝叶斯分割抗噪性更强;

函数原型:createBackgroundSubtractorGMG()

效果展示:

总结:GMG开始会不显示一段时间,这是由于初始参考帧的数量和过大;对比业界的效果来看,这些传统方法的效果并不好,特别是对比深度学习的算法;但很多原理值得我们取思考借鉴,模型只是给出我们问题的优解,如果能将传统算法结合深度学习算法,那是否能在提速的同时,也达到一个可观的效果,这是我思考的一个点,欢迎大家发表自己的意见;

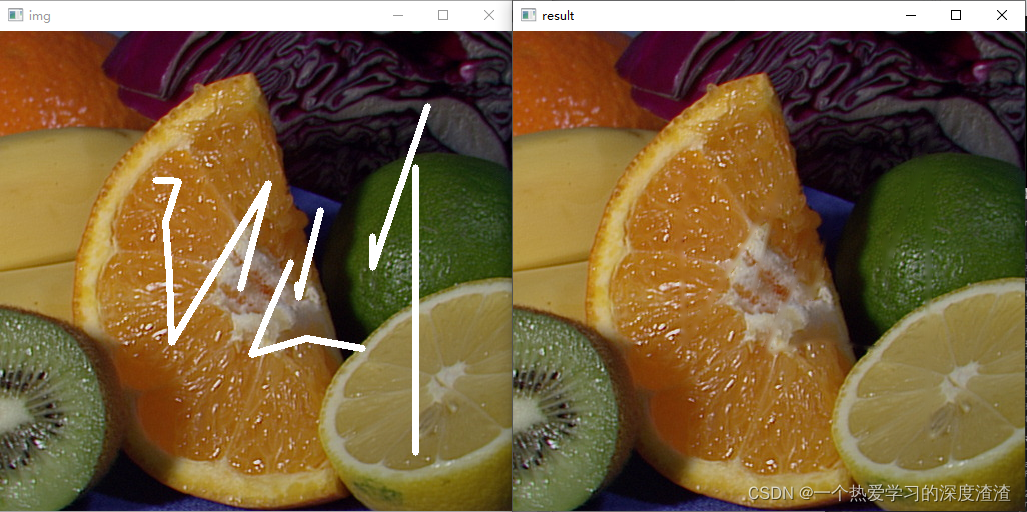

六、图像修复

说明:我们的图像往往会有一些马赛克的存在,特别是一些老照片会有不必要的图案,图像修复就是用于解决这类问题,并不等同于超清化;

函数原型:

inpaint(img,mask,inpaintRadius,两种方式:INPAINT_NS、INPAINT_TELEA)

代码案例:

img = cv2.imread('inpaint.png')

mask = cv2.imread('inpaint_mask.png',0)

result = cv2.inpaint(img, mask,5, cv2.INPAINT_TELEA)

cv2.imshow('img', img)

cv2.imshow('result', result)

cv2.waitKey()

总结:从结果来看,效果相当不错,但前提我们需要知道需要修复的部分,所以应用的场景也会比较局限;

总结

简单介绍了一些传统的一些图像分割算法,并没有涉及原理,感兴趣的可以自行了解;当然,现在业界的分割算法都采用深度学习的方式了,并且也有了很好的效果和落地应用,后续也会开对应的专栏,科普一下深度学习中分割算法的发展历史,其主要为模型的迭代了,感兴趣可以先了解下编解码这个结构;

版权归原作者 一个热爱学习的深度渣渣 所有, 如有侵权,请联系我们删除。