对用户来说,更多的选择没坏处;如果这个选择本身还很优质,那就更棒了。

对话

早上,我收到了 Mistral 发来的邮件,提示我拥有了访问 Le Chat 的权限。

我一时觉得很奇怪,什么是 Le Chat?

然后我才弄明白,原来是 Mistral 对标 ChatGPT ,推出了一个自己的对话机器人界面。虽然 Mistral 的创始人是 Deepmind 和 Meta 的前员工,但是这个公司毕竟是在法国,所以弄个法语特色的名称,也不意外。

于是,我赶紧点进去看看这个 Mistral 的新对话平台。目前来说,界面还是非常清爽的。

你可以打开右上方的这个下拉菜单,选择使用的模型。

这里有 3 种可选模型,分别是 Large, Next 和 Small 。

其中 Small 模型,我之前就测试过,属于轻量级模型。Next 我之前一直没有机会测试,据说在推理上是目前除 GPT-4 之外最强悍的。而 Large 模型则是这次的主角。几乎是和 Le Chat 一起推出的。

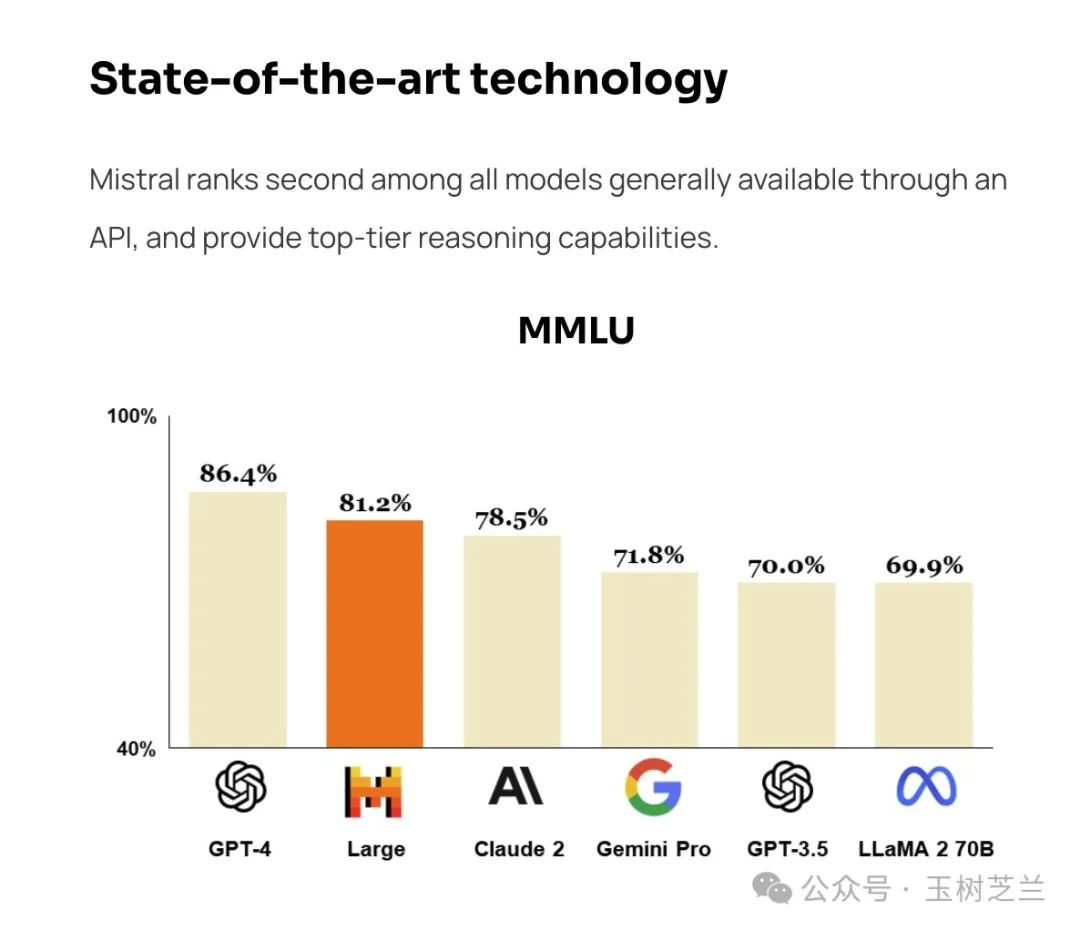

至于 Large 和 Next 究竟哪个更好用?我回头还得查查官方说明,以及用户的实际评测打分。不过 Mistral 发布的这个评测结果,显然让我对 Large 模型更加感兴趣。

可以看到,Mistral AI 宣称目前除了GPT-4,Mistral Large 已经超越了其他所有大模型。当然,我对这个宣称保持审慎和保留态度。原因是现在的模型测试标准简直是一言难尽。

不过,这里具体的数字如何,对普通用户其实没有什么太大用处。我更关心的,是模型用起来是不是符合咱们的需求。

那咱们今天,就先来看看这个最新的 Mistral Large 模型怎么样。

能力

我先进行了一下问答测试。选用的题目是:

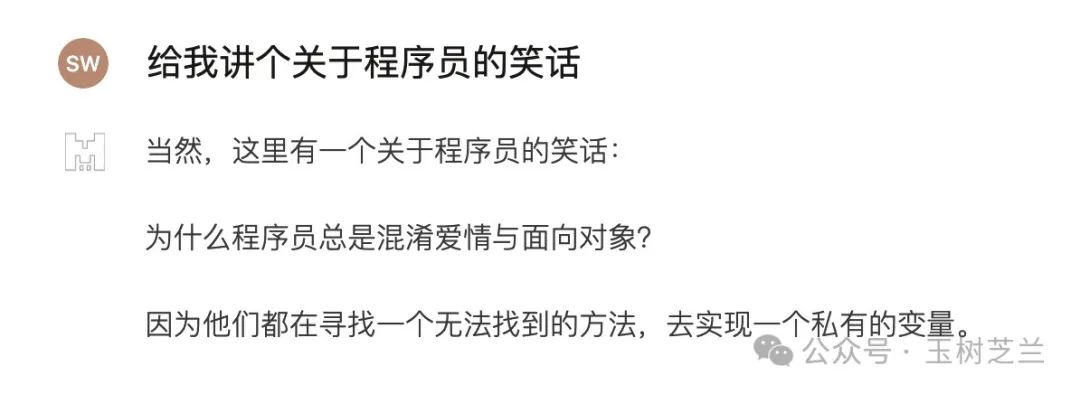

给我讲个关于程序员的笑话

之所以选择这个题目,是因为同样的问题,我 2 个多月以前就考过 Mistral Medium 模型。

不知道是天冷还是笑话冷,反正我冻得够呛。

而这是 Mistral Large 的答案:

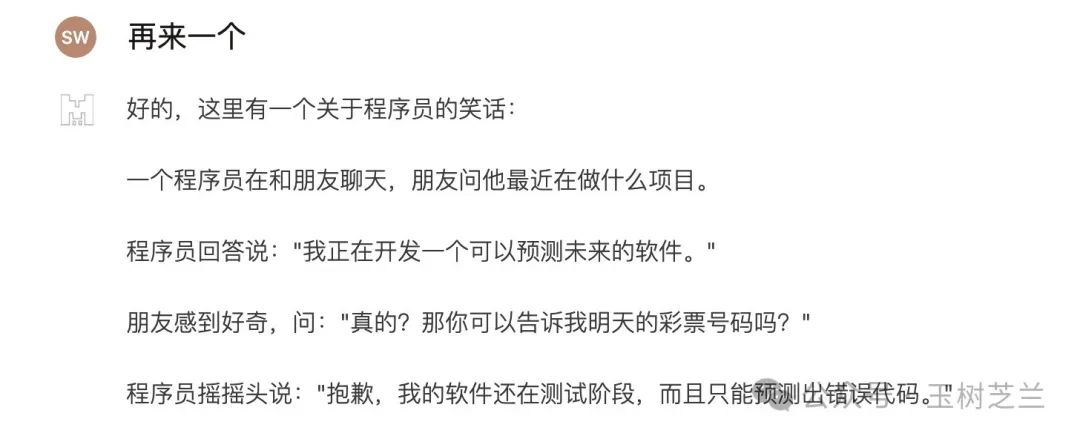

我觉得一般吧,再来一个:

这个我觉得还有点儿意思,哈哈。

Mistral 官方表示,目前这个 Mistral Large 模型能够熟悉以下语言:

但是根据我们实际测试的结果,它对中文理解和回答的能力也不差。

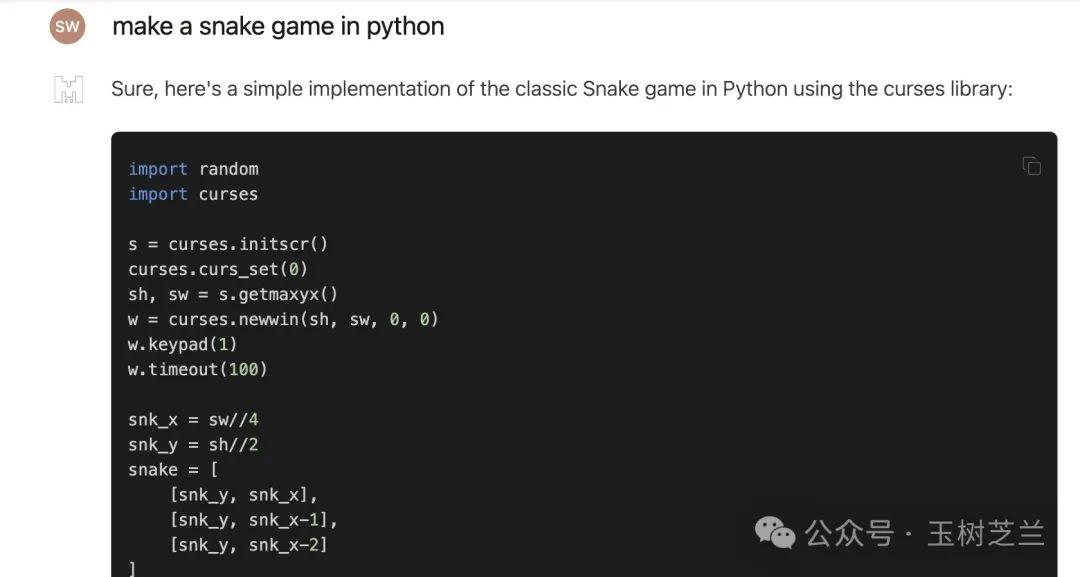

下面咱们试试它的编程(coding)能力好了。

编个啥呢?游戏吧。

我先考一个传统艺能,也是很多大语言模型测试代码编写能力的时候惯用设定目标 —— 贪吃蛇。

一看见 Mistral Large 使用的是 curses ,我就觉得十拿九稳了。果不其然,我尝试运行了这段程序,然后这是运行的结果:

没有任何报错,没有任何的迭代。就是这么顺畅。

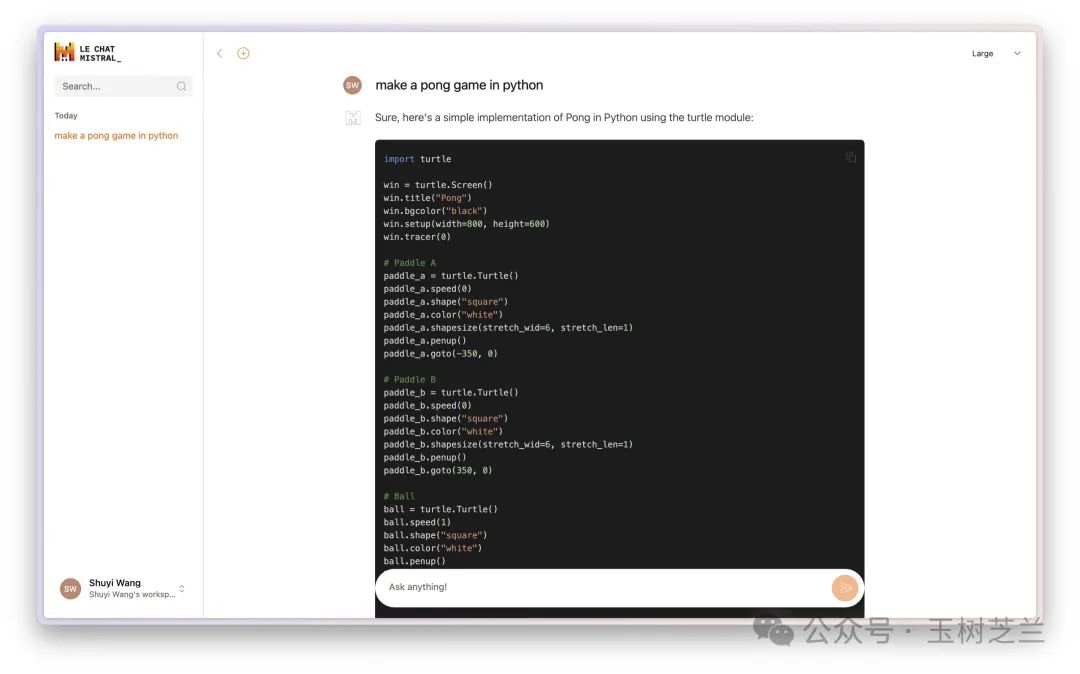

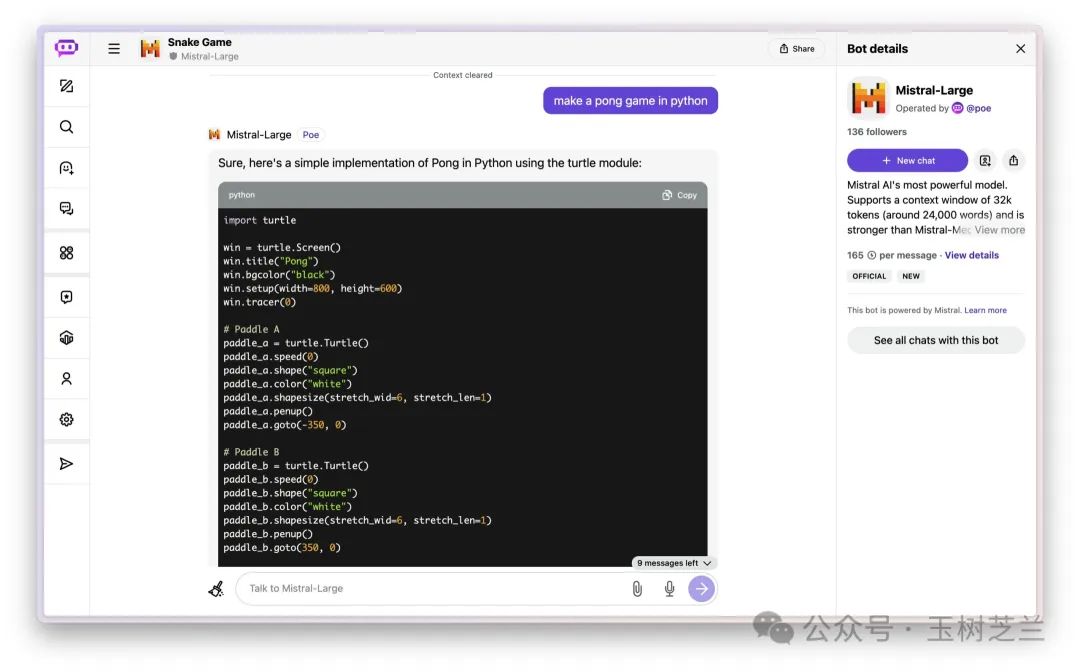

于是我又尝试了另外一个游戏,Pong。

同样的,没有报错,一次成功。这次我一个人操作两个挡板(分别是上下左右和 WASD),手忙脚乱玩儿了一会儿。

老实说,Mistral Large 的效果,只是让我对它的稳定性信心更加充足而已。毕竟,早在 2 个多月以前,我就依次测试过 Mistral 的 Medium 模型和 Mixtral 8x7B 混合模型,它们都能够顺利编写和运行贪吃蛇游戏,而且输出速度更快。

当然,我觉得目前 Mistral Large 输出速度相较而言有些慢,可能是因为同时免费测试的用户太多的缘故。看看过几天是否有改进吧。

Mixtral 8x7B 模型更为有趣,它是广泛为大众所知的大语言模型里面,第一个应用了 MoE (专家混合)机制的。而且效果非常好。Google 的 Gemini Pro 1.5 也使用了这种机制,所以才有令人印象深刻的效果。

可惜啊,Gemini Pro 1.5 我是第一时间申请试用,到现在也没用上。

不过刚才咱们谈的这些大模型,基本上都得去调用 API 才能使用,数据都需要与云端进行交换。如果你不喜欢或者因为条件限制,根本做不到数据传递,那么也可以自己在本机部署 Mistral 7B 这个小模型来用。它的特点是小巧而强悍。

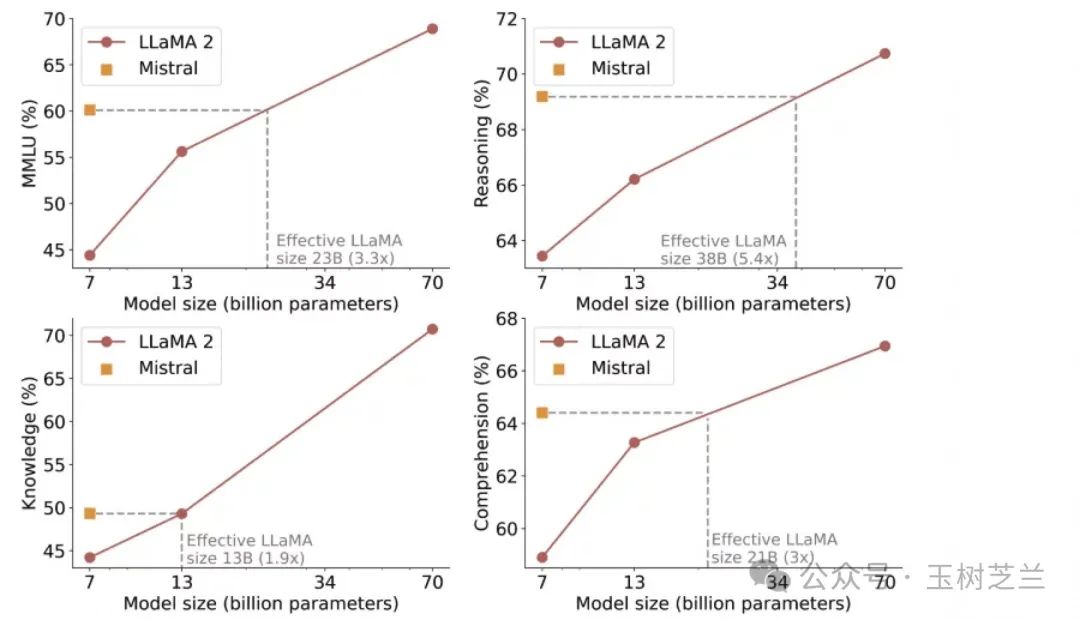

你看看 Mistral 推出 7B 模型时候选择的对比对象,根本就不是其他的 7B 模型,而是直接找出来 Llama 2 13B (比它几乎大了一倍)来比较,而且多项指标碾压对手。

部署

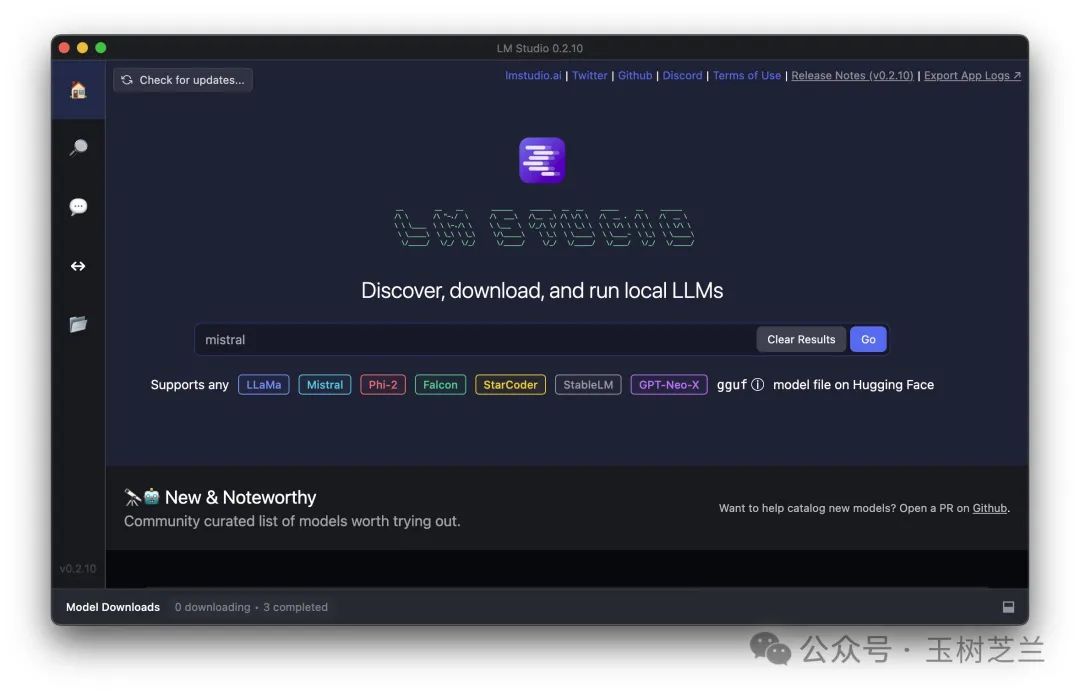

本地部署大语言模型的方式有好几种,例如 Ollama 之类。我比较喜欢 LM Studio,因为安装方便,界面用起来清爽。你可以 从这里下载。

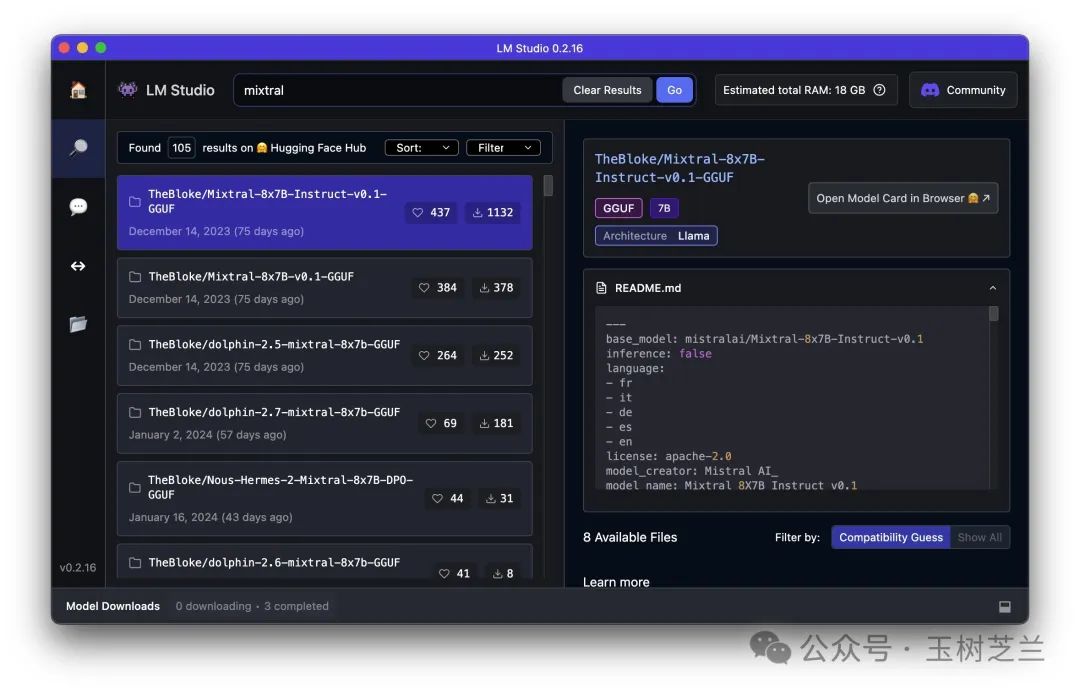

咱们在 LM Studio 主界面的搜索框搜索 Mistral 。

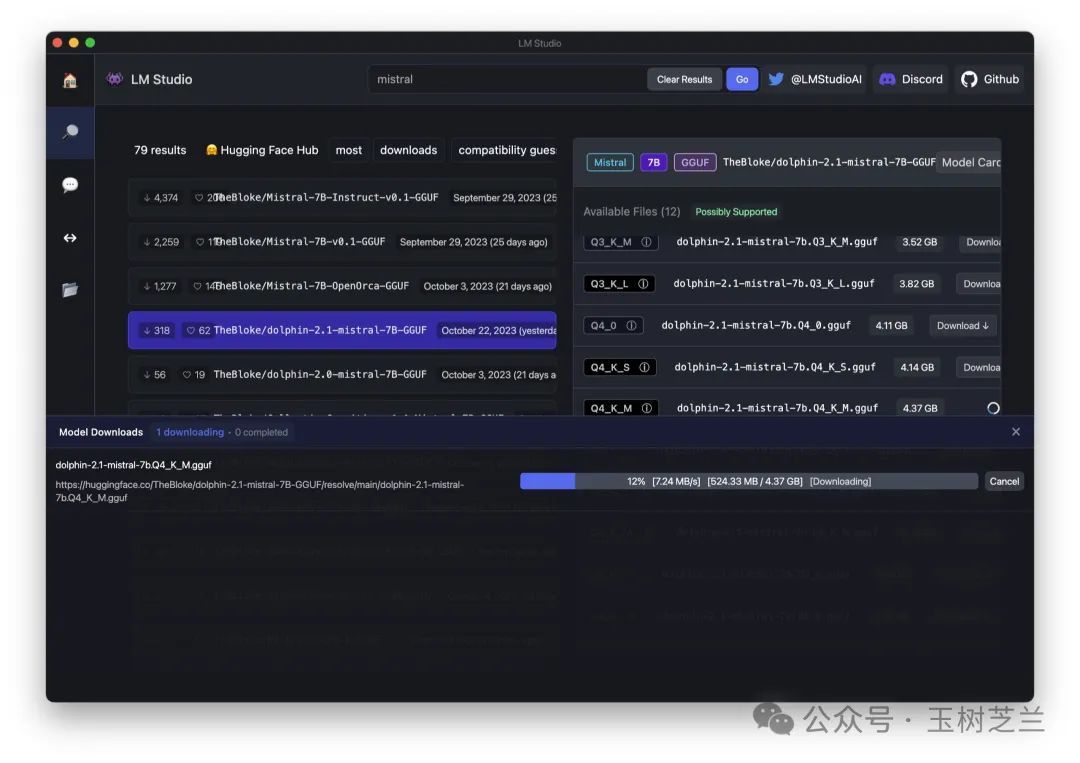

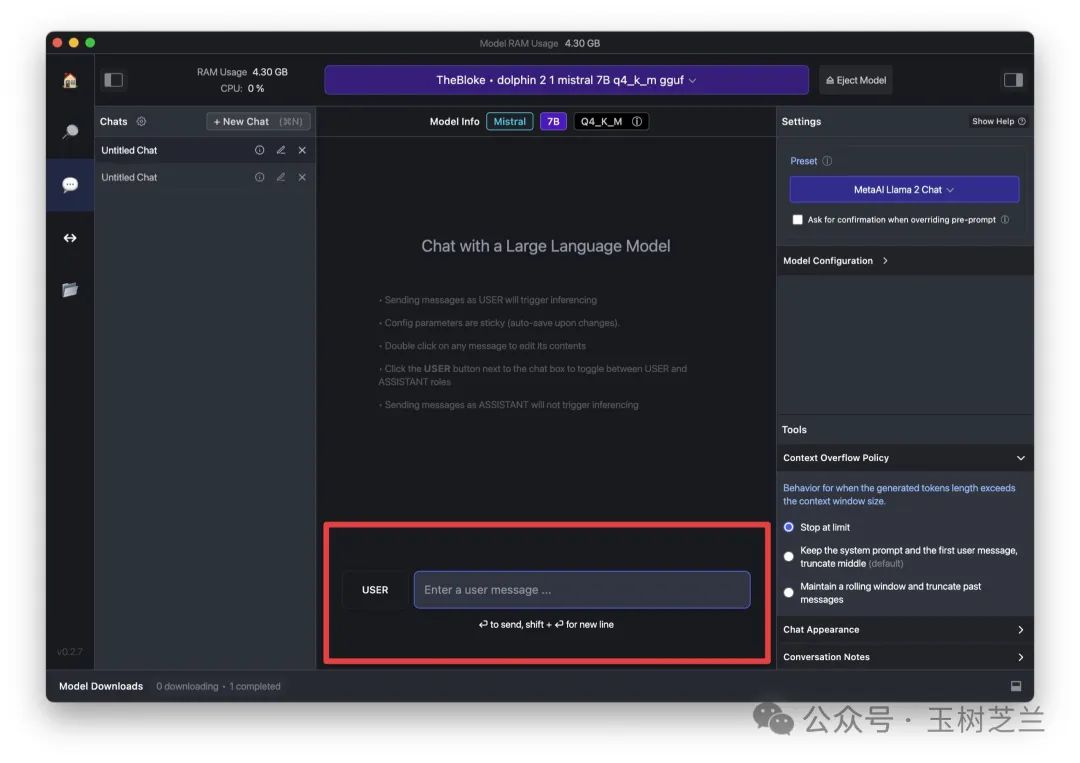

我这里比较之后,选择的是 Dolphin 2.1 Mistral 7B GGUF 版本。选择「下载」后,请耐心等待下载完成。时间视网速而定。

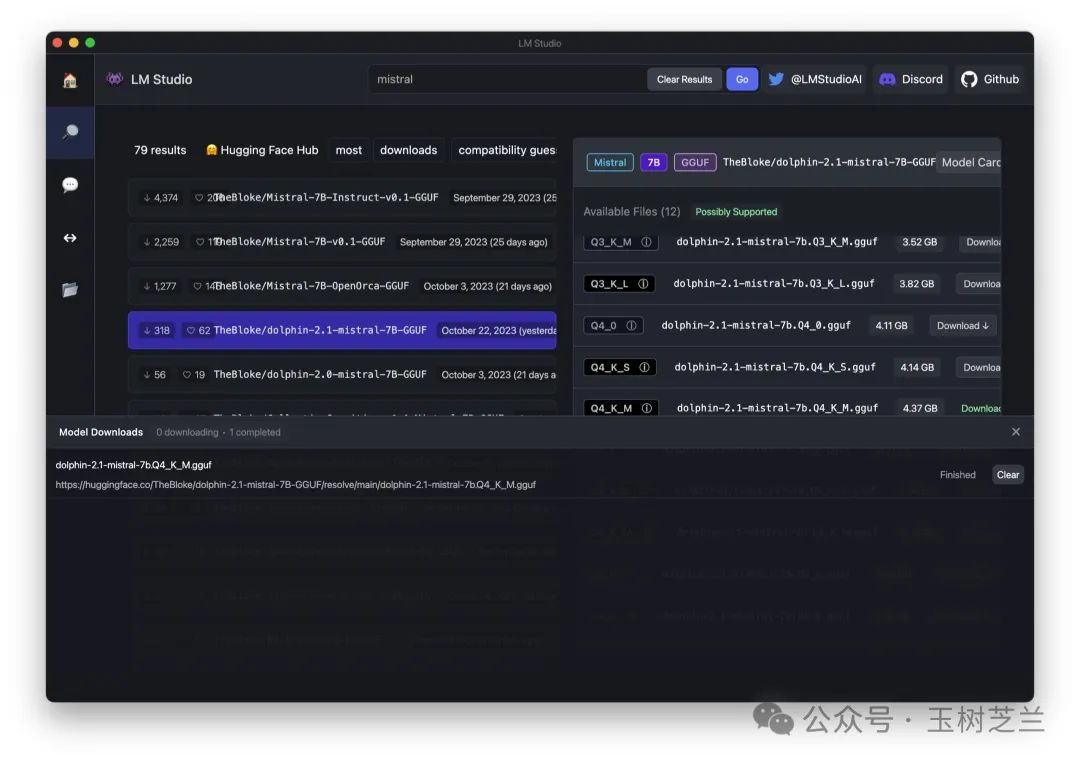

下载完成后,选择加载该模型。

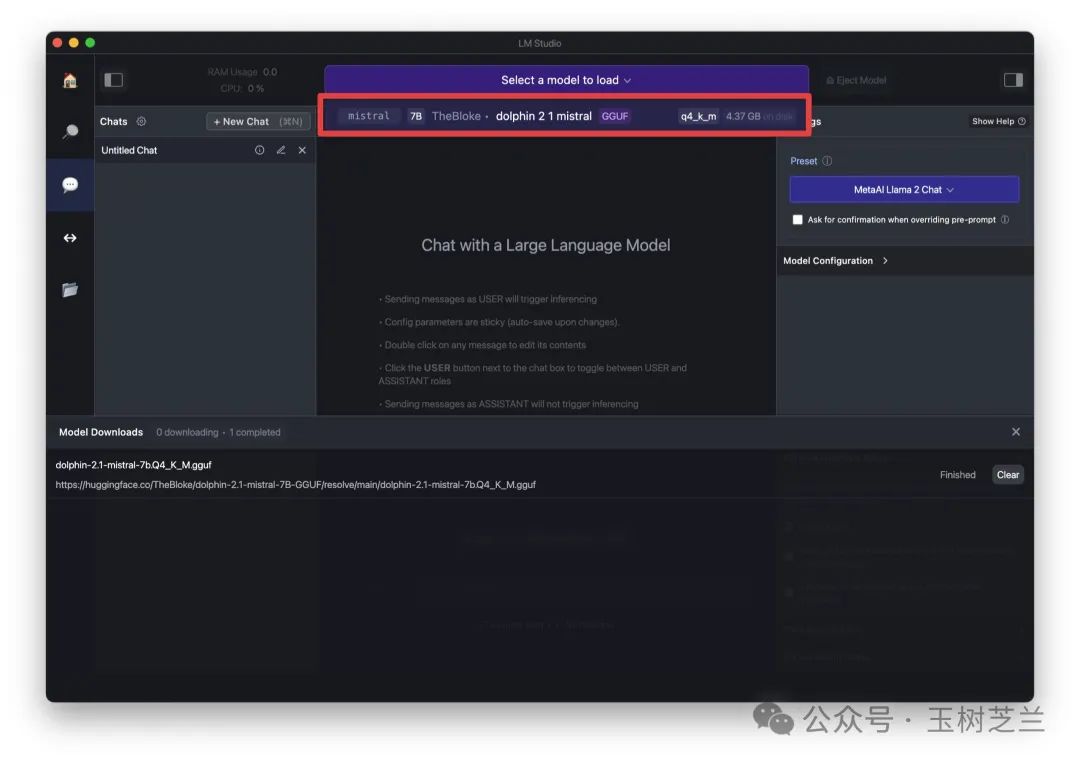

加载完毕之后,在这里输入你的问题即可。

我出的题目,是:

write python code to print 1 to 101

翻译过来,就是:

编写 Python 代码以打印 1 到 101。

然后,本地的 Mistral 7B 模型就开始思考和输出了。

可以看到,它不光是完成了程序编写,还对这样写代码的原因进行了讲解。作为一个 7B 「小」模型,我觉得很棒。

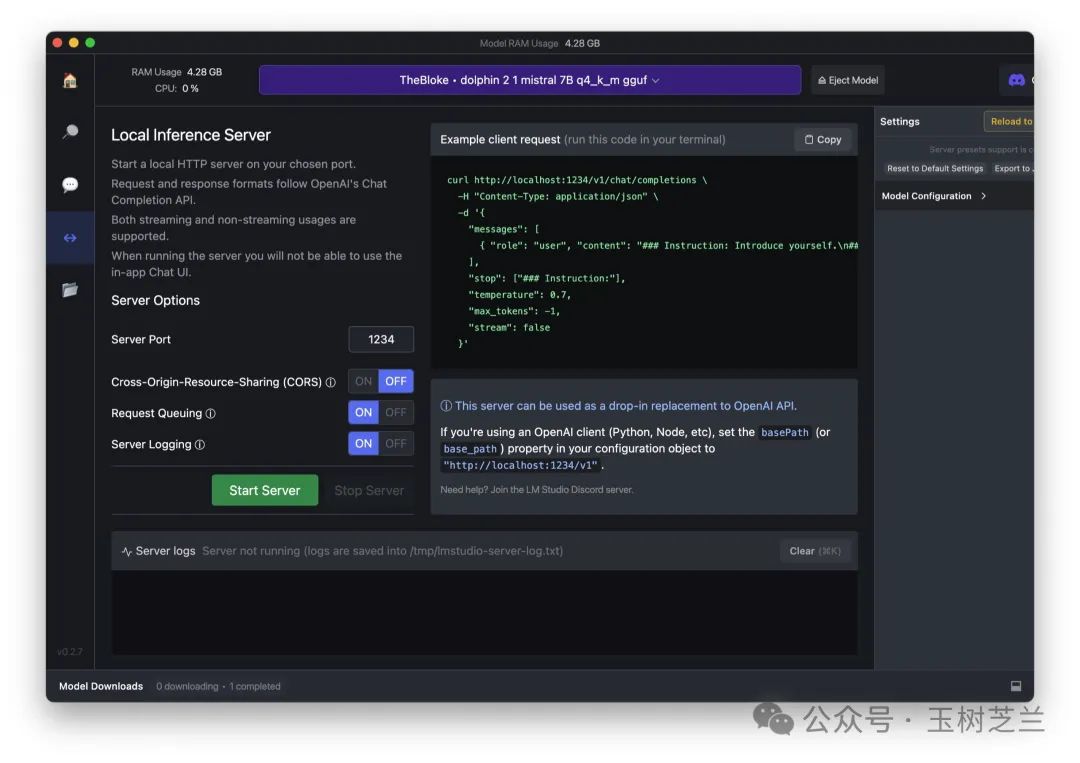

在本地部署模型的好处,是你可以用它来作为 server ,给各种应用提供服务。

上图说明了在其他程序中,如何调用目前这个 Mistral 7B 模型。点击 Start Server 按钮。

可以看到启动服务之后,在 1234 端口监听。因为咱们使用的是 GGUF 压缩模型,因此内存占用只有 4.29GB ,还是可以接受的。

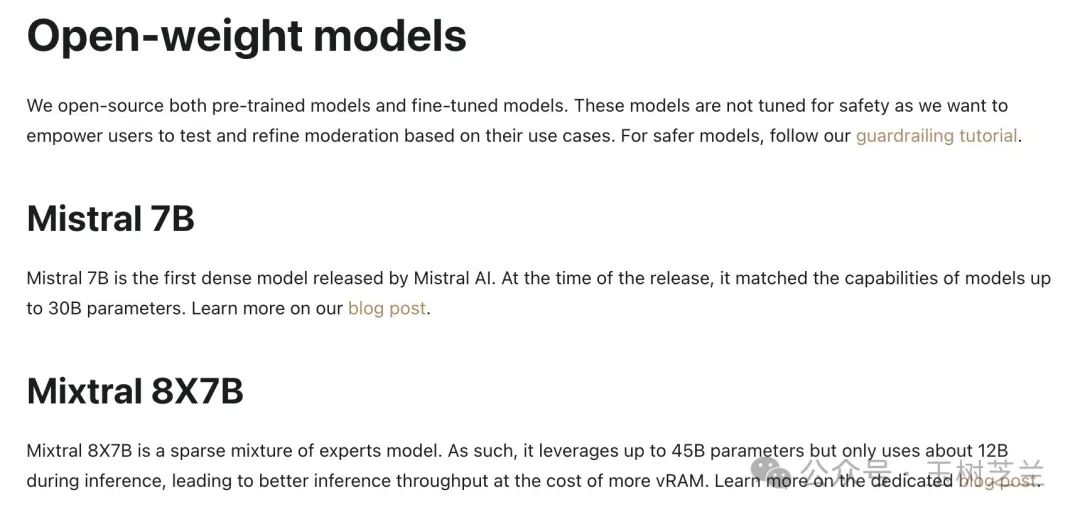

这里多说一句,其实 Mistral 官方把 Mistral 7B 和 Mixtral 8X7B 都称作「开放权重」模型。你都可以在本地进行部署。

只不过,后者的参数量高达 45B 。我担心电脑内存不够大,所以就没有进行测试。但 LM Studio 上面也有对应的模型可供下载。

如果你尝试过,欢迎把测试结果告诉我。

支持

这次 Mistral 的动作很大,包括接受微软的战略投资,充分利用 Azure 基础设施等。

但其实,它早就被各种第三方工具支持了,可谓「人缘极好」。

如果你打算尝试 Mistral 模型,目前有以下几个方法。

首先是 Poe ,这里你直接就可以调用 Mistral Large 模型。

注意,你不需要缴费成为 Poe 的付费订户,就能用 Mistral Large ,调用速度也非常快。当然这几天除外,因为大部分人还在新鲜期,玩儿命各种角度来测试。

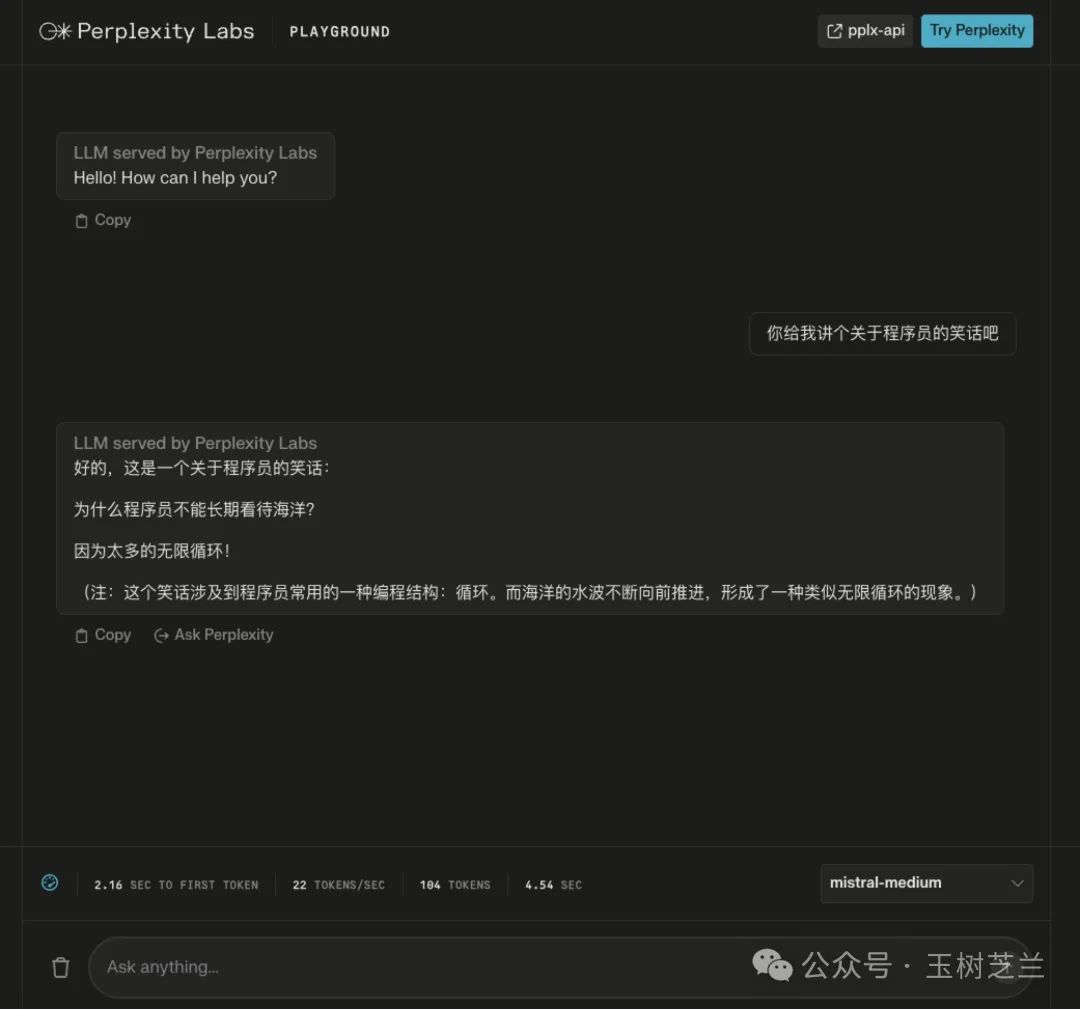

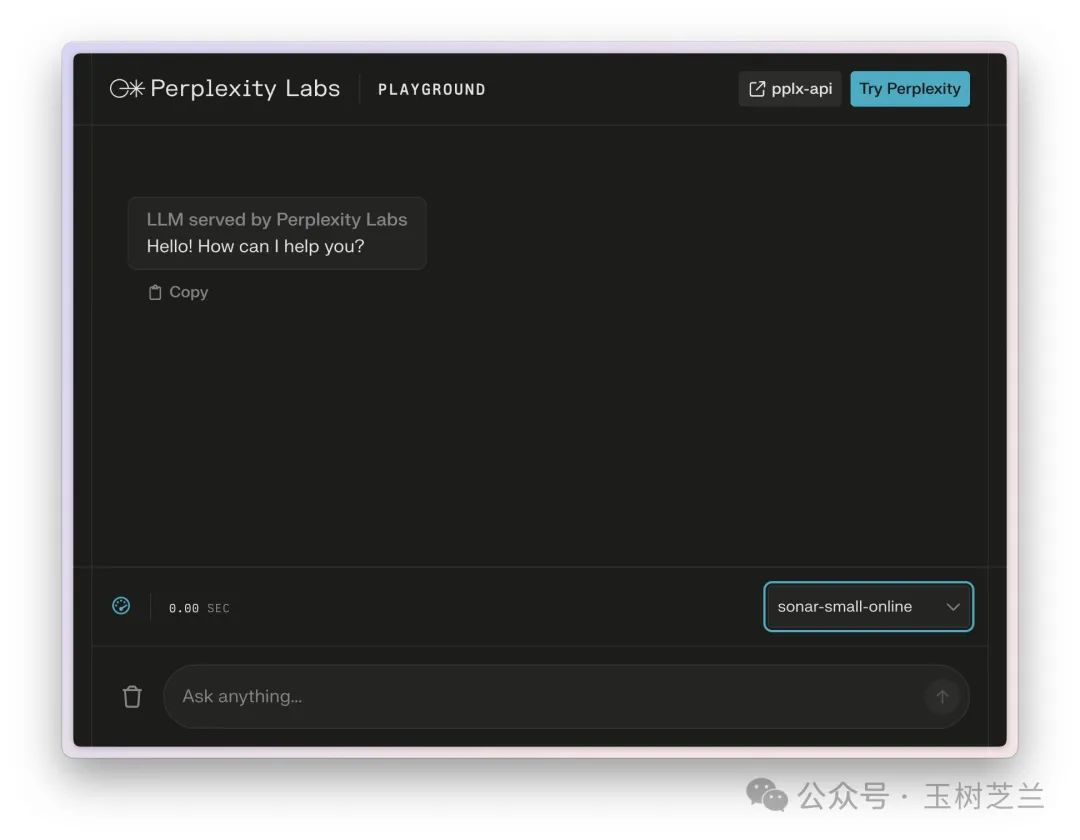

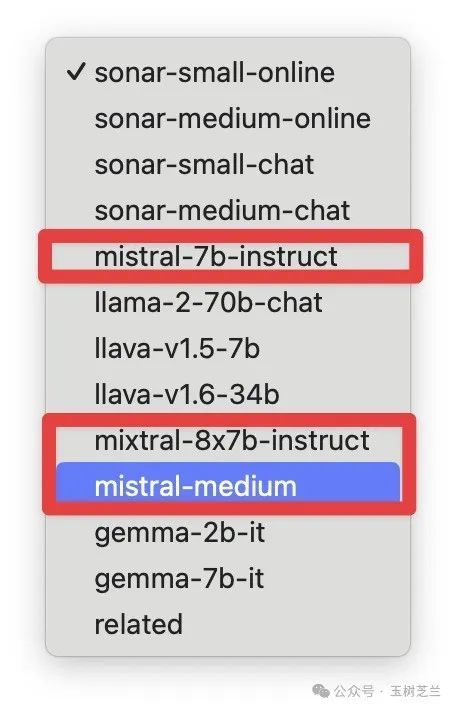

另外就是 我给你介绍过的 Perplexity,它 专门提供了一个 Labs 功能,也是一个对话界面。里面包括了多种模型。

有的是 Perplexity 自己的,有的来自第三方,其中就包括 Mistral Medium 等。

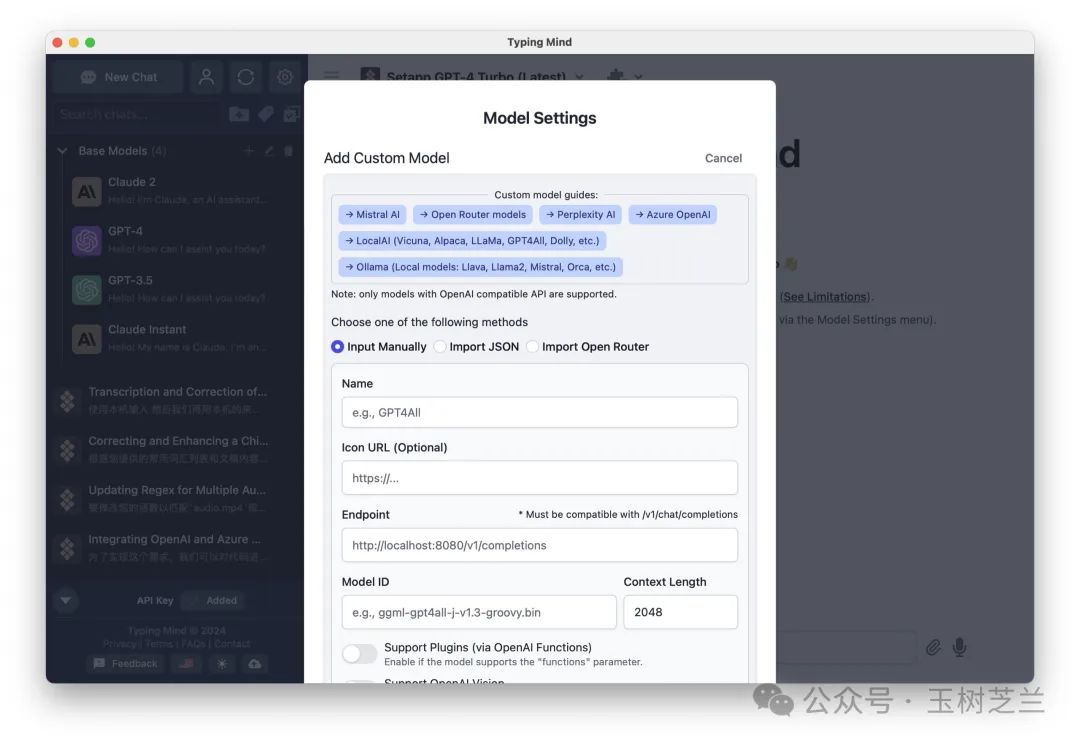

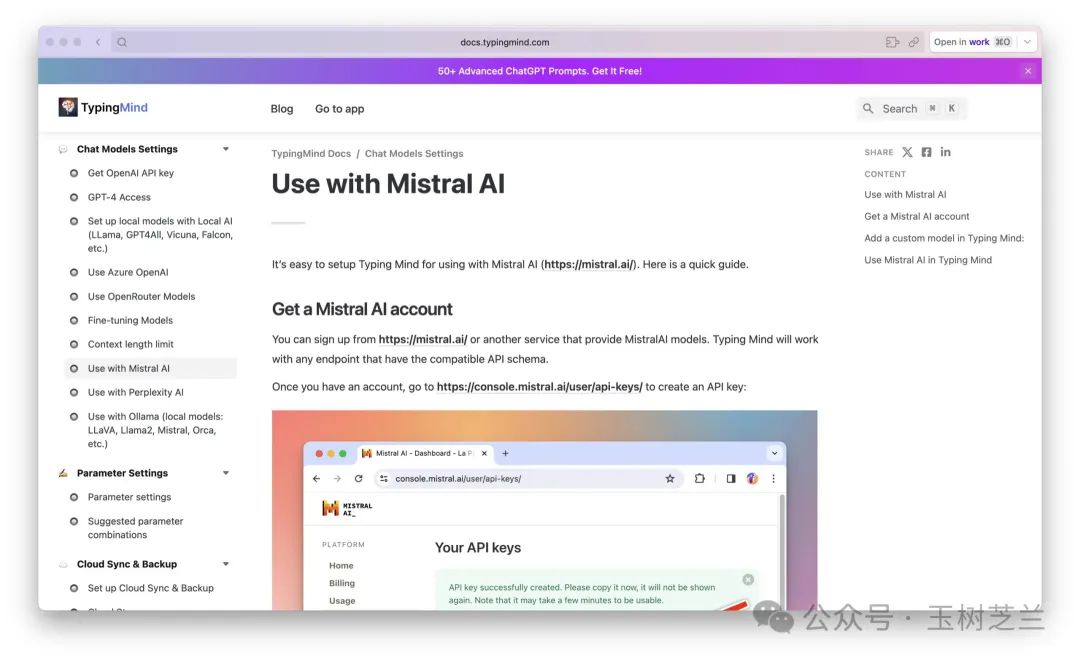

另外,我给你 介绍过的 Typingmind 里面,也有 Mistral 模型的支持。

这里还提供了详尽的文档,教你如何在 Typingmind 里面使用 Mistral AI。

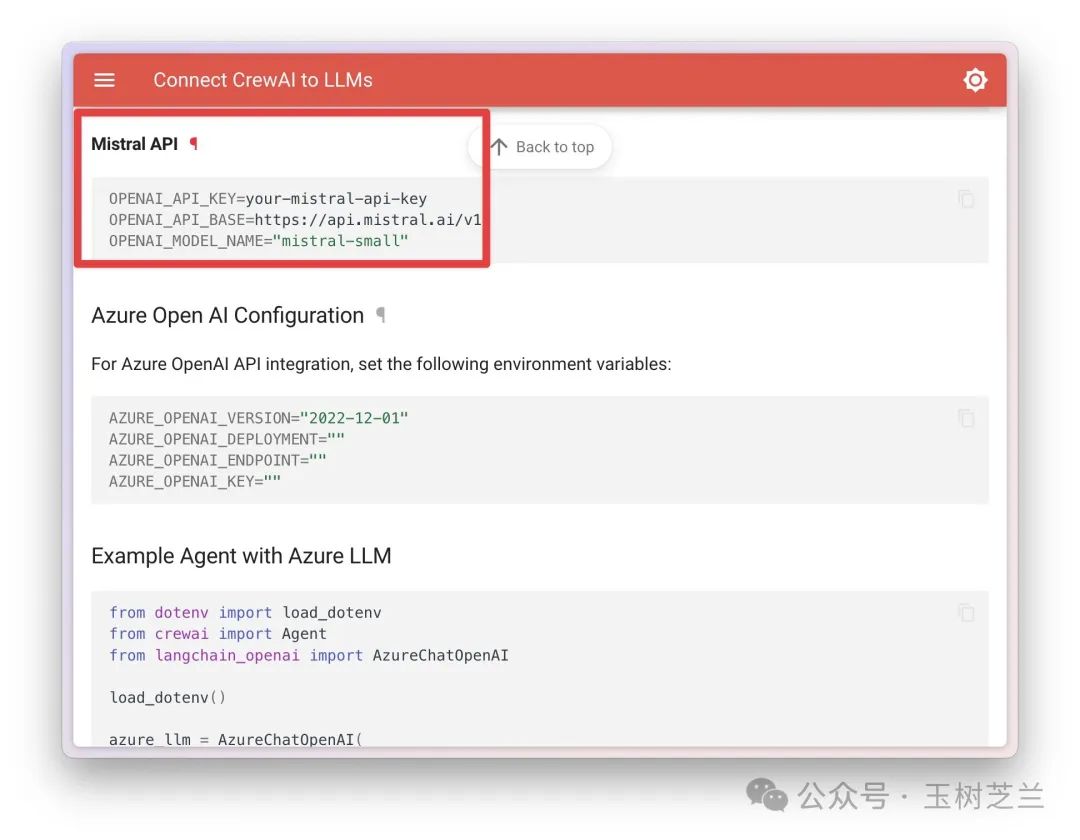

不仅如此,目前很火的多 AI Agent 框架,例如 Autogen Studio, CrewAI 等,都支持 Mistral 。

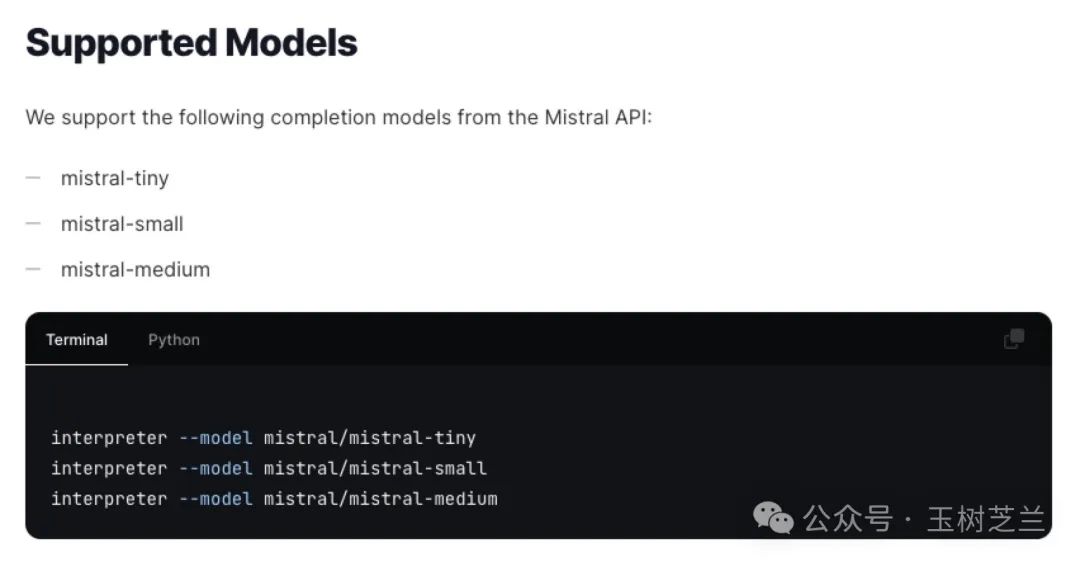

就连 之前给你介绍过的 Open Interpreter ,也在文档里专门写明如何支持 Mistral 模型。

编程

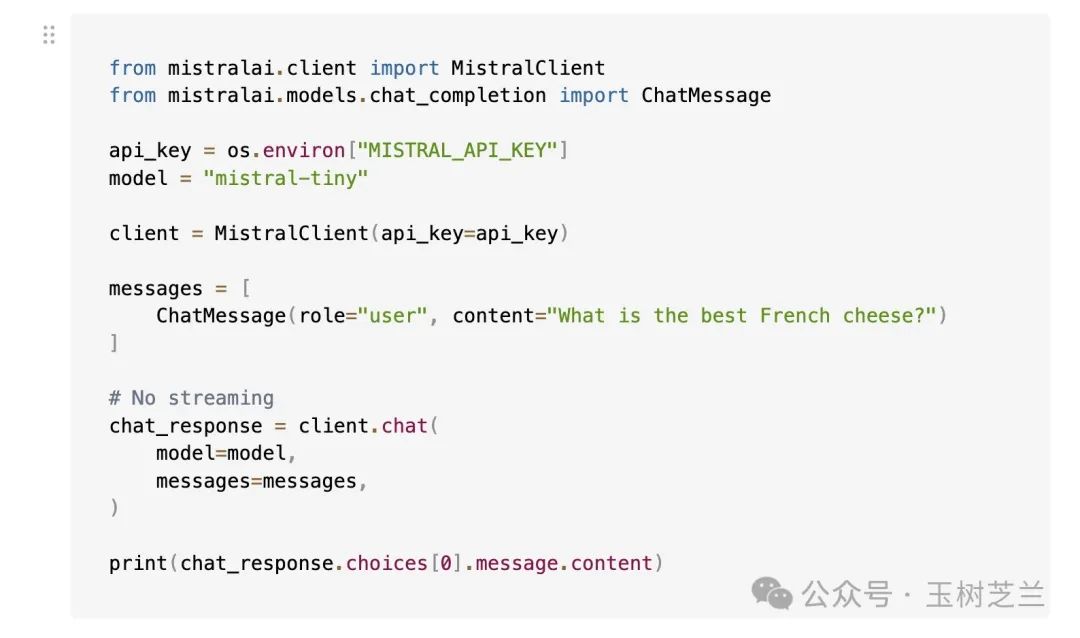

如果你会编程,也可以在自己的应用中集成 Mistral API 调用。它的文档非常清晰,调用也很简单。

我最近,就尝试用 Perplexity 和 Mistral Medium 的 API ,做了个自动化文本处理工作流,帮我润色语音转写的文稿,还是比一遍遍打开对话界面重复机械输入提示词,要方便多了。

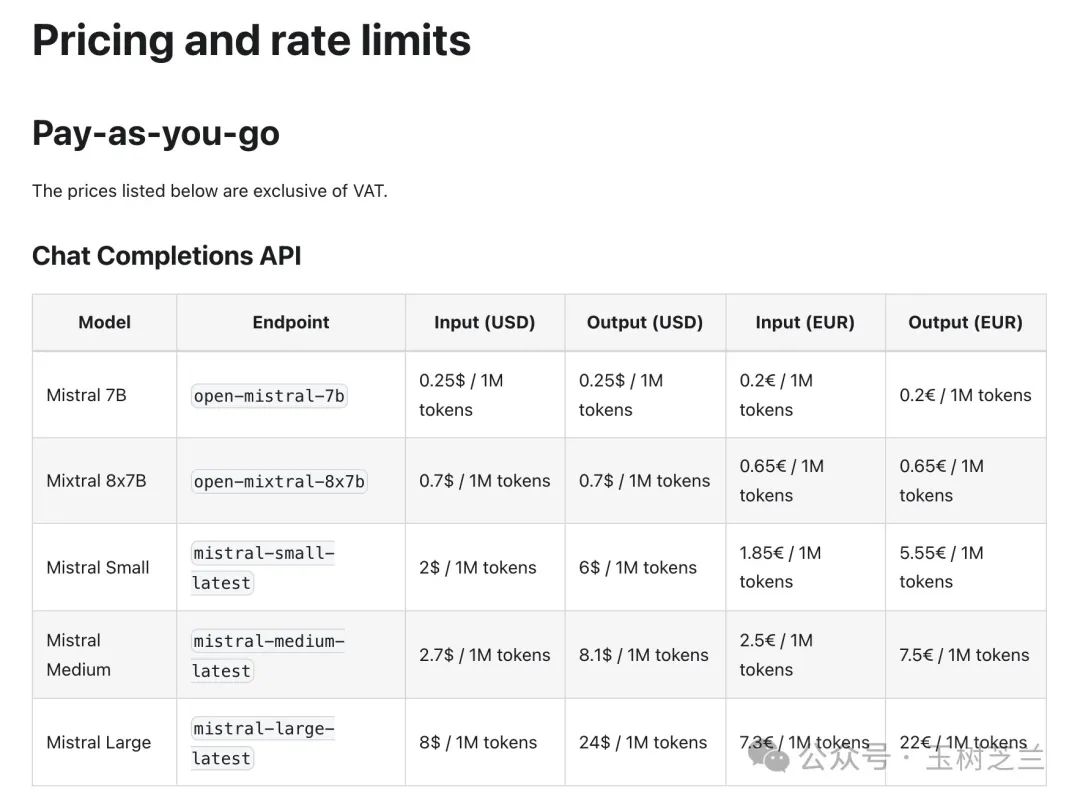

只不过,调用的时候,你不要忽略不同模型的价格差别。

对这个图,我不止一位朋友感叹 ——Mistral Large 的价格,直追 GPT-4 啊。

我算了算,也确实如此。所以如果我真的需要比较强的逻辑推理,可能目前还是更倾向于使用 GPT-4-Turbo-Preview 。毕竟价格相差不大,但是 GPT-4 能力公认更强一些。

小结

本文我为你介绍了 Mistral AI 的大语言模型。从可以本机部署的 7B ,一直到能力与 GPT-4 相媲美的 Mistral Large ,这个模型家族各具特色。关键是,目前我们可以在很多应用的支持下,免费来尝试使用。如果你有调用大语言模型的需求,不妨试一试。欢迎你把自己实际使用的结果反馈在留言区,咱们一起交流讨论。

祝 Mistral AI 使用愉快!

点赞 +「在看」,转发给你身边有需要的朋友。收不到推送?那是因为你只订阅,却没有加星标。

欢迎订阅我的小报童付费专栏,每季度更新不少于10篇文章。订阅一整年价格优惠。

如果有问题咨询,或者希望加入社群和热爱钻研的小伙伴们一起讨论,订阅知识星球吧。不仅包括小报童的推送内容,还可以自由发帖与提问。之前已经积累下的帖子和问答,就有数百篇。足够你好好翻一阵子。知识星球支持72小时内无条件退款,所以你可以放心尝试。

若文中部分链接可能无法正常显示与跳转,可能是因为微信公众平台的外链限制。如需访问,请点击文末「阅读原文」链接,查看链接齐备的版本。

延伸阅读

- 文献综述 AI 应用对比 — Elicit, GPTs 与 Perplexity

- AI 真要成精了?ChatGPT 上手体验

- 智谱 GLM-4 大语言模型好用吗?

- 未来的写作长啥样?LEX 用 GPT-3 AI 给你点儿颜色看看

- 如何用 Python 和机器学习训练中文文本情感分类模型?

版权归原作者 nkwshuyi 所有, 如有侵权,请联系我们删除。