本文介绍如何使用百度的大模型API接口实现一个AI对话项目

1 注册百度云

搜索百度云,打开官网注册,充值一点点大米(收费很低,大概生成几个句子花费一毛钱)

注册之后一定要完成个人认证,不然无法使用。

2 获取API接口

完成注册与认证之后,打开千帆大模型平台,点开引用接入,应用名称起个名字,描述随便打几个字就行。

获取API Key 和Secret Key(注意保密)

完成之后,大功告成。

3 配置环境

安装Anaconda和PyCharm

Anaconda官网:Download Anaconda Distribution | Anaconda

PyCharm官网:PyCharm:适用于数据科学和 Web 开发的 Python IDE (jetbrains.com)

PyCharm建议下载专业版的,上网找个激活码就ok。

安装过程很简单,网上教程一大堆,随便找个一步步来就可以。就不再赘述。

创建虚拟环境

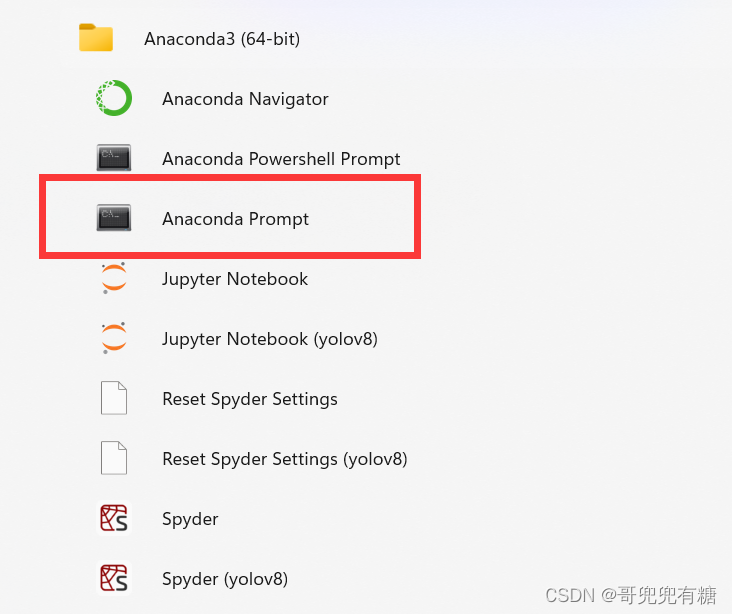

安装好Anaconda之后,在开始菜单栏会有文件夹,打开Anaconda Prompt(记住不能错,必须是Anaconda Prompt)

创建一个大模型的环境,然后下载库。依次运行以下代码。

conda create -n llm python=3.10

#创建llm

conda activate llm

#激活llm

pip install langchain

pip install qianfan

#下载

如果在后续的运行中出现缺失包的报错,那就缺的包pip install 下载一下就行啦。

4 代码编写与运行

打开pycharm,新建一个py文档,输入如下代码。

#1.导入包

import os

#QianfanLLMEndpoint:通常提供较为简单的文本补全接口,可能不包含复杂的对话管理和上下文理解能力。

from langchain_community.llms import QianfanLLMEndpoint

#2.设置千帆的API-KEY和SERECT-KEY

os.environ['QIANFAN_AK']='cfgxxxxxxxxxxx9nu7'

os.environ['QIANFAN_SK']='Txxxxxxxxxxxxxxxxxxxxxxxx'

#3.实例化模型

llm=QianfanLLMEndpoint(model='ChatGLM2-6B-32K')

#可以更换模型,在langchain官方文档里面

#4.输入问题,打印结果

res =llm('llm大模型是什么?')

print(res)

通过调用千帆(Qianfan)的API来实现文本补全功能。代码逐行解释:

- 导入Python的os模块,这个模块提供了许多与操作系统交互的功能,比如设置环境变量。

- 导入

langchain_community.llms模块中的QianfanLLMEndpoint类,这个类用于创建一个与千帆大模型交互的接口。 - 设置环境变量

QIANFAN_AK和QIANFAN_SK,这两个变量分别代表千帆API的Access Key和Secret Key。这些密钥是API调用的身份验证信息,需要从千帆平台获取。 - 实例化

QianfanLLMEndpoint类,创建一个名为llm的对象。这里指定了使用的模型为ChatGLM2-6B-32K,这个参数可以根据需要更换为其他模型。 - 使用

llm对象调用ChatGLM2-6B-32K模型,传入一个问题'llm大模型是什么?',然后打印出模型返回的结果。

如图所示:

运行代码,查看结果。

完美生成!

如果想要更换大模型,直接在参数里面指明大模型的名字即可。

llm=QianfanLLMEndpoint(model='ChatGLM2-6B-32K')

#可以更换模型,在langchain官方文档里面

官方文档地址:LLMs | 🦜️🔗 LangChain

5 chat models

如果想要完成对话任务,运行以下代码。

#1.导入包

import os

from langchain_community.chat_models import QianfanChatEndpoint

from langchain_core.language_models.chat_models import HumanMessage

#2.设置千帆的API-KEY和SERECT-KEY

os.environ['QIANFAN_AK']='cxxxxxxxxxxxxxxxxxxxxx'

os.environ['QIANFAN_SK']='TxxxxxxxxxxxxxxxxxxxxxxxxI'

#3.实例化模型

chat = QianfanChatEndpoint(streaming=True)

messages = [HumanMessage(content="给我写一首诗")]

res = chat(messages)

print(res)

版权归原作者 哥兜兜有糖 所有, 如有侵权,请联系我们删除。