关于这篇新文章的最酷的事情是,他们在Google colab上提供了一个演示,您可以在其中轻松地自己尝试一下,正如我将在本文中展示的那样!但首先,让我们看看他们是如何做到的。

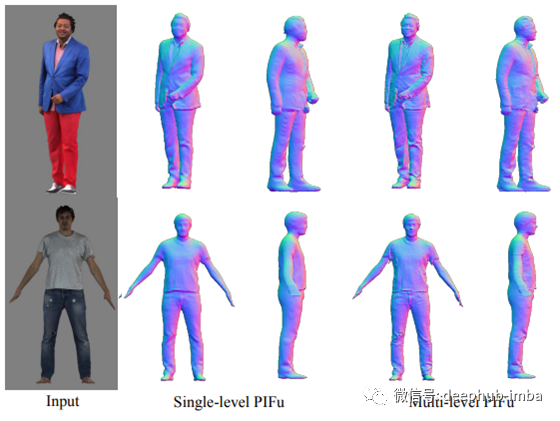

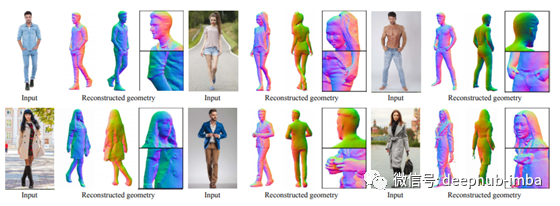

Facebook和南加州大学的研究人员最近推出了一篇名为“ PIFuHD: Multi-Level Pixel-Aligned Implicit Function for High-Resolution 3D Human Digitization”的新论文。简而言之,它使用某人的2D图像来重构该人的3D高分辨率版本。我们的主要目标是对穿着衣服的人进行高保真3d重建,并获得详细信息,例如手指,面部特征和衣服褶皱,正如我们在此图中看到的那样。因为的原因,目前的方法没有使用全高分辨率图像,所以它们降低了图像的尺寸,并丢失了在3D中创建高分辨率细节的重要信息,但是看起来还是不错的。

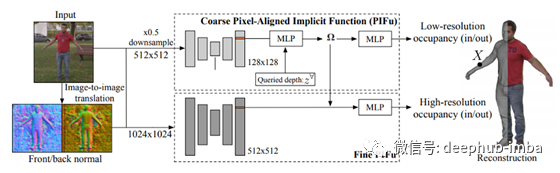

PiFuHD通过两步解决问题来实现这一目标。首先,以较低的分辨率(缩小比例)对模型进行训练,以专注于整体推理。这样,它可以覆盖图片的更大空间背景上下文。然后,使用这些上下文信息,模型通过观察图像和更高分辨率的第一个输出来估计人的详细几何形状。粗略层通过对图像进行下采样并将其输入到PIFu模型中来捕获全局3D结构,而高分辨率的详细信息是通过在相似的轻量级PIFu网络中使用这些第一个3D输出作为高分辨率输入来添加的。由于精细层级将第一层级的特征作为3d嵌入,因此不需要以更高的分辨率查看整个图像,从而可以在没有背景的情况下提供此人的高分辨率图像。具有较低分辨率的背景信息和较高分辨率的模型解决了先前方法遇到的计算时间问题。

正像图中展示的,需要多层PIFu才能获得高分辨率3D模型,但是使用单层PIFu可以更快地创建准确的模型。这种新方法是精确的,并且使用这种双向模型使它在现阶段的内存限制下可以成功运行。下面是使用这种技术取得的一些更令人印象深刻的结果……

他们做了一个公开演示,在那里你可以简单地上传你的图片并在谷歌colab上看到结果!只需要一分钟左右。这只是这篇新论文的一个简单概述。

下面是这个演示的链接。

论文地址: https://arxiv.org/pdf/2004.00452.pdf

colab演示: https://colab.research.google.com/drive/11z58bl3meSzo6kFqkahMa35G5jmh2Wgt

源代码: https://github.com/facebookresearch/pifuhd

作者:Louis Bouchard

deephub翻译组