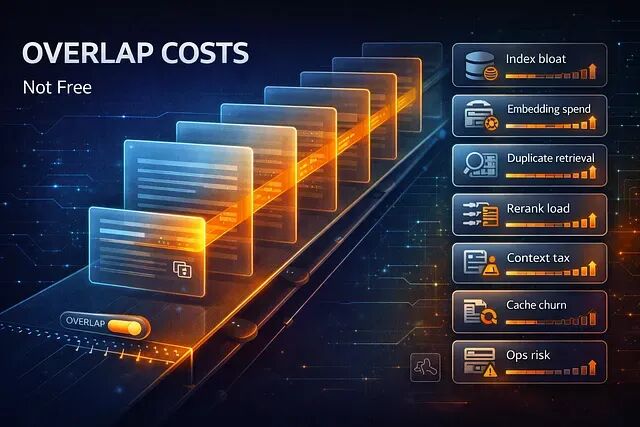

RAG 分块重叠提升了召回率但增加了隐藏成本,比如说索引膨胀、Embedding 开销、延迟、重排序负载和评估漂移。

本文将总结的八项 RAG 分块重叠隐藏的成本,以及如何判断什么时候重叠真正有用,什么时候只是花钱买心安。

快速回顾:重叠到底干了什么

分块重叠就是让相邻的分块共享一部分 Token:

Doc tokens: 1..................................................N

Chunk 1: [ 1..................512 ]

Chunk 2: [ 385.................896 ] (overlap 128)

Chunk 3: [ 769.............1280 ]

这样做的好处是边界附近的关键句子更有可能完整出现在至少一个分块里,对召回率和下游的生成都有帮助。

代价呢?文档的部分内容被重复嵌入、重复存储。

架构流程:重叠在哪里放大成本

Documents

|

v

Chunking (size S, overlap O) ---> [#chunks](#chunks) increases as O increases

|

v

Embedding (cost scales with total tokens embedded)

|

v

Vector Index (storage + build time)

|

v

Retrieval (more candidates, more near-duplicates)

|

v

Rerank / Fusion (extra compute)

|

v

LLM Context (more tokens + more redundancy)

重叠影响的是整条流水线——从数据摄入、索引构建、检索、重排序,一直到生成和评估,无一幸免。

1、索引膨胀:分块数比你以为的多得多

重叠增加分块数量,但很多人低估的是它在规模上膨胀的速度。

文档长度 L,分块大小 S,重叠 O,步长就是 S − O。步长越小,分块越多。

向量数暴涨,索引变大,构建和压缩耗时拉长,线上服务的内存压力陡增。

典型场景:一个"微调 overlap"的调整,把每夜索引重建从 45 分钟拖到了 2 小时,值班的人开始收到索引延迟告警。

预算的时候一定要盯住向量数量,别只看文档数。

2、Embedding 开销:重复 Token 照样收费

嵌入有重叠的分块就是在嵌入重复文本。按 Token 计费的模型不会因为你在分块 1 里已经嵌入过那句话就给你打折。

摄入成本随嵌入 Token 数线性增长。回填和重新嵌入的开销很快失控。

很多团队只按文档数估算成本,而不是按分块后的实际 Token 总量计算

每个语料库版本的总嵌入 Token 数,才是该盯的预算项。

3、检索质量可能反而变差:近似重复泛滥

重叠通常能提高召回率,但副作用是在向量空间中制造大量近似重复项。

检索 top-k 的时候,你可能拿到来自同一段落的 5 个只是位置略有偏移而不是来自不同章节或不同文档的多样化的块。信息多样性下降,上下文冗余增加,互补性事实更容易被挤出结果列表。

应对方法是加入多样性控制:MMR(最大边际相关性)、每文档在 top-k 中设上限(比如最多 2 个分块)、检索后按哈希或相似度阈值去重。

没有去重的重叠,就像请了八个人开会,到场一看其中五个是同一个人戴了不同的帽子。

4、重排序器负载:候选集被冗余撑大

用了重排序器(Cross-Encoder、LLM 重排序、混合打分),重叠就会往候选集里塞进大量冗余分块。

重排序的成本跟候选数量乘以分块长度成正比,负载高时延迟飙升,P95 变得很不稳定,而重排序本来就经常是整个链路中最慢的环节。

解决思路:先检索一个稍大的候选池,去重之后再送进重排序器;或者对每个文档只取一个代表性分块先做粗排,再精排。

每次查询走重排序器消耗的 Token 数和调用次数。

5、上下文窗口:占位不贡献信息的 Token

重叠对检索有帮助,但到了生成阶段它可能把重复文本塞进 LLM 上下文反而让最终 Prompt 变差。

LLM 输入 Token 数上升意味着成本上升。留给其他文档、对话历史、工具调用的空间被压缩。更麻烦的是"引用回声"模型反复引用同一段内容,因为你喂给它的就是这些。

场景还原:你让模型做个摘要,它给你返回同一段落的三个改写版本。

生成之前做一轮处理就能缓解:把检索到的分块按相似度聚类,每个聚类只留最佳代表,必要时用抽取式摘要或引用选择来压缩。

这里需要关注每次回答的平均上下文 Token 数。

6、缓存效率大打折扣

重叠一变,分块边界就变了。听起来是小事但它直接摧毁缓存键。

如果系统缓存了每个分块的 Embedding、检索结果、重排序器输出、分块到文档的映射——重叠参数一调,这些全部失效。

缓存占用变大(分块更多),命中率下降(唯一键更多),每次部署后都有更长的冷启动期。

建议:尽可能在文档段落或章节级别做缓存;分块 ID 基于文档偏移量和内容哈希来生成,保持稳定;不要频繁调 overlap,除非你对整条流水线做了版本管理。

调优之后,请重新评估缓存大小和命中率的变化。

7、评估漂移:基准悄悄变了

这个问题比较隐蔽。改了 overlap 之后,分块集合变了,检索结果变了,模型看到的上下文也变了。你的评估套件衡量的已经不是同一个系统。

你以为检索改善了,实际上只是证据分布变了。不同实验之间的对比变成了鸡同鸭讲。看起来的"胜出"可能只是冗余带来的假象,并非真正的检索改进。

正确做法是对所有环节做版本管理:语料库快照、分块参数(S,O)、Embedding 模型、索引构建配置、检索和重排序策略,一个都不能少。评估指标也要更新,加入多样性感知的度量(比如 top-k 中覆盖了多少个不同文档),以及答案忠实度和引用精确度而不是只看准确率。

8、运维复杂度上升:大索引威胁系统可靠性

更大的索引、更高的单次查询计算量,带来的不仅是费用,还有可靠性风险。

因为索引构建慢了所以部署和回滚窗口会拉长,内存尖峰也更频繁。多租户向量数据库中噪声邻居的干扰加剧。出了事故排查也更难:到底是检索的问题,重排序的问题,还是 LLM 的问题?

一个常见的翻车场景:系统在预发布环境表现完美,到了生产流量下直接崩溃,就因为 overlap 的调整把资源消耗推过了临界点。

对待 overlap 变更应该跟对待容量变更一样认真:上线前做负载测试,测量端到端的 p50/p95 延迟,持续监控索引的内存、磁盘和压缩指标。

重叠什么时候值得?

几种情况下重叠通常值得投入:文档中有跨越分块边界的关键事实(法律文本、技术规范、操作流程),分块尺寸比较小导致边界频繁切割,或者检索对丢失连接句子特别敏感。

如果分块已经足够大,文档本身高度重复,检索结果没有去重,或者已经在用重排序并且可以通过其他途径获得多样性那么重叠大概率是在浪费资源。

总结

分块重叠确实能拉高召回率。但它不是免费升级而是一笔到处冒头的经常性支出:Embedding 费用、索引体积、检索多样性、重排序算力、上下文 Token 消耗、缓存失效、评估可比性、运维稳定性,每一项都会被它影响。

如果你正在调优 RAG,建议做一个实验:在增大 overlap 的同时,强制启用去重和每文档上限。如果这套组合能以更少的冗余拿到大部分质量收益。

by Velorum