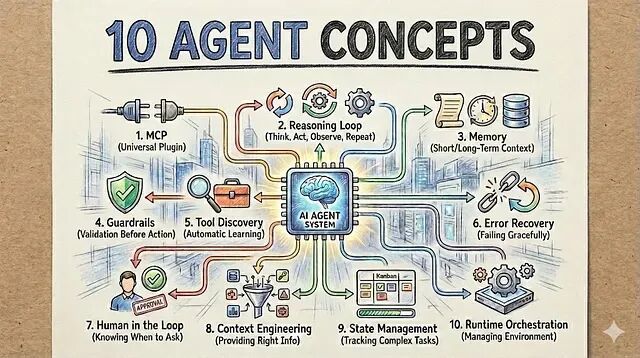

Agentic AI的核心不在LLM选型也不在提示词技巧。真正决定一个Agent能否在无人值守的情况下稳定工作的是它背后的系统设计。

本文就总结了构建AI系统时真正绕不开的10个基础概念

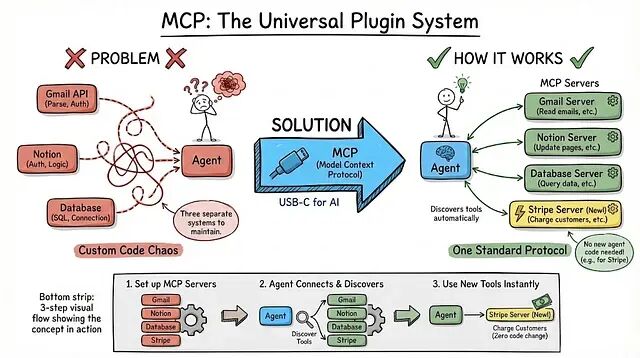

1、MCP:通用插件系统

假设你需要Agent读取Gmail、更新Notion、查询数据库。按传统做法,每个服务都要单独写集成代码,解析Gmail的API、搞定Notion的鉴权、再写一套SQL连接逻辑。三个系统,三套代码,三份维护成本。

MCP(Model Context Protocol)用一种统一协议解决了这个问题。可以把它理解成AI世界的USB-C:不管连什么设备,接口只有一个。

你部署若干MCP服务器,每个服务器对外暴露工具,并附带清晰的功能描述和输入参数说明。Agent连上服务器后自动发现可用工具。

举个例子:某个MCP服务器暴露了send_email函数,描述是"向指定地址发送带主题和正文的邮件"。Agent把它列入工具清单。用户说"把报告发给xxx",Agent就带着正确参数调用这个函数。第二天你加了个search_github服务器,Agent自动发现、自动使用。不需要改任何代码。

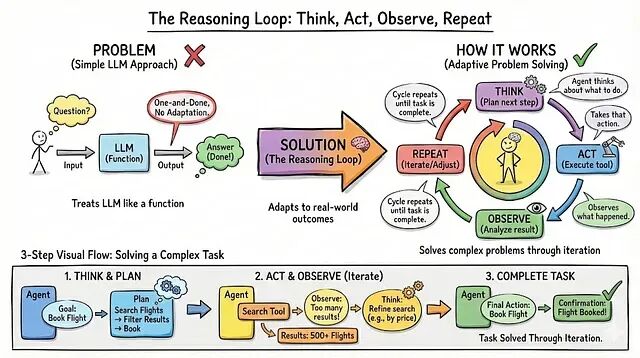

2、推理循环:思考、行动、观察、重复

多数开发者把LLM当函数用,输入问题输出答案然后就结束了。但现实中的任务不是一锤子买卖,需要根据中间结果不断调整策略。

推理循环才是Agent真正解题的方式。

Agent先想该做什么,然后执行,再观察结果,接着重新评估:刚才的做法管用吗?下一步试什么?如此往复,直到任务完成。

比如你让Agent查竞争对手的定价。它先想到去看对方官网,结果拿到一个404。它注意到页面不存在,于是换个思路,转去主页找入口。从主页定位到定价链接,点进去,提取数据。每一步都建立在上一步的反馈之上。第一条路走不通,Agent没有直接报错退出,而是自己绕了过去。

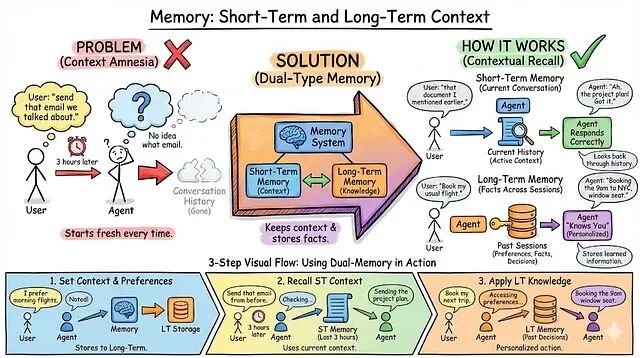

3、记忆:短期与长期上下文

短期记忆负责维持当前会话的上下文。用户提到"之前说的那个文档",Agent能回溯对话找到具体是哪份。长期记忆则跨越会话边界,持久化存储用户偏好、历史决策、习得的信息。有了长期记忆,Agent会让人觉得"它记得我",而不是每次都像跟陌生人打交道。

来看一个场景:用户说过"我习惯把会开在上午10点之前"。这条偏好被写入长期记忆,关联到用户ID。一周后用户说"帮我跟Sarah约个会",Agent检索记忆,发现早会偏好,直接推荐上午9点的空档,而不是随机塞一个下午的时间。没有记忆系统的话用户每次都得重复说明自己的习惯。烦。

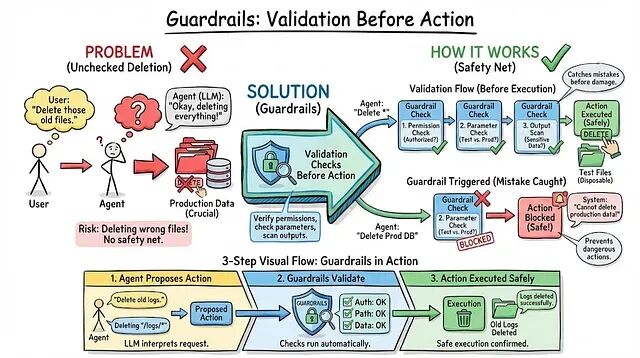

4、护栏:执行前的安全校验

Agent准备删文件,LLM非常确定这就是用户的意思。可万一判断错了呢?万一它删的是生产库而不是测试数据呢?

护栏就是在操作真正执行前跑的一道验证。检查权限、校验参数合理性、扫描输出里有没有敏感信息。本质上是一层安全网,在错误造成实际损害之前把它拦下来。

用户说"清理一下旧的测试数据"。Agent理解成删50,000条数据库记录。护栏介入:这个用户有删除权限吗?"旧测试数据"对应5万条记录,合理吗?系统把这标记为可疑操作,弹出确认。一问才知道,用户说的是50条,不是50,000条。一场事故就这么被挡住了。

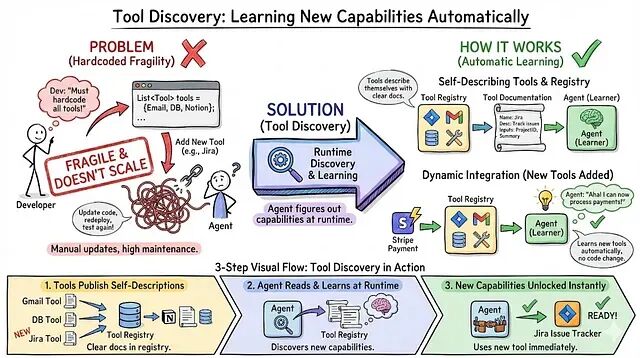

5、工具发现:运行时自动获取新能力

把工具列表硬编码进Agent,下个月加了Jira集成,就得改代码、重新部署、全量回归测试。脆弱并且不可扩展。

工具发现的思路完全不同:工具自带描述文档,Agent在运行时读取这些描述,自动学会怎么调用。

假设你在生产环境部署了一个新的日历MCP服务器,暴露了create_event和list_events两个函数,附带功能说明。下次有人说"帮我约个团队会议",Agent在可用工具列表里看到日历相关的接口,读一下描述就知道怎么用了。Agent代码完全没动。新能力是它自己"发现"的。

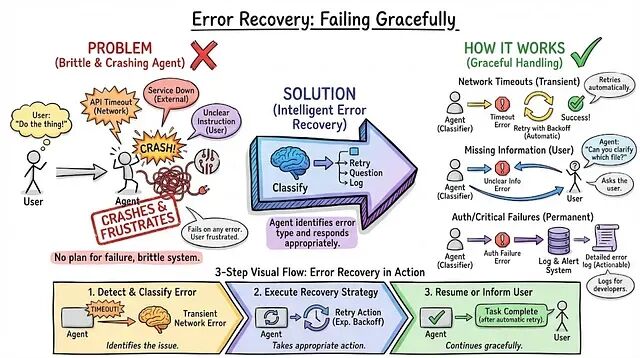

6、错误恢复:体面地失败

API会超时,服务会宕机,用户会给模棱两可的指令,Agent一定会撞上错误。关键在于它是直接挂掉,还是能聪明地处理。

错误恢复的核心是分类和应对。网络超时?重试。信息缺失?反问用户。鉴权失败?写日志,给出明确的错误说明。

Agent试着发一封邮件,SMTP服务器超时了。它没崩等2秒重试,还是不行,等4秒再试,第三次通了。用户全程毫无感知。换一种情况:超时一直没好。三次重试都失败后,Agent告诉用户——"邮件服务暂时挂了,草稿已保存,10分钟后自动重发。"出了什么问题、接下来怎么办,交代得清清楚楚。

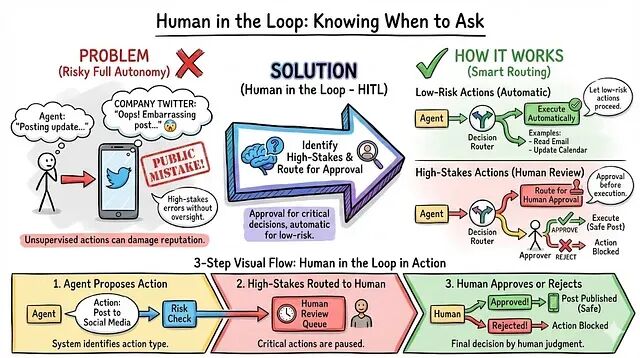

7、人共介入:知道什么时候该停下来问人

人工介入不等于事事都要审批。它的精髓在于区分风险等级:高风险操作走审批流程,低风险操作该自动就自动。

社交媒体Agent日常起草帖子、自动发布,处理常规内容没问题。但当它准备回复一条关于产品缺陷的客户投诉时,它停了下来,给你发通知:"这条回复我写好了,要发吗?"你看了看,改了一处措辞,点确认。Agent发出去。该自动的自动,该人审的人审,你不用盯着每一条操作,但关键节点上你还是拿着方向盘。

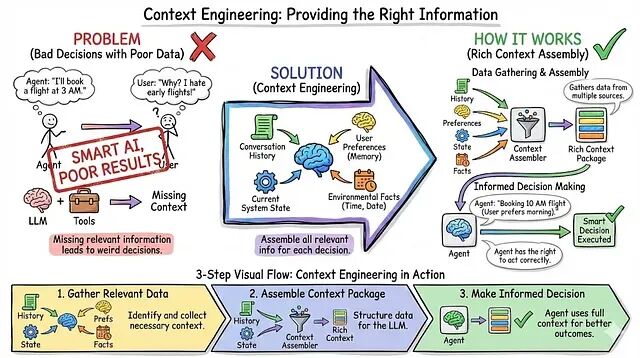

8、上下文工程:喂给Agent对的信息

LLM够聪明工具也到位了,但Agent的决策就是很离谱。为什么?信息没给对。

上下文工程解决的就是这个问题——在每次决策前,把相关信息组装好送进去。不只是对话历史,还包括记忆中的用户偏好、当前系统状态、时间日期之类的环境变量。

用户问:"明天的户外会议要不要改期?"如果上下文里只有这句话,Agent只能瞎猜。但如果上下文里还包括明天的天气预报(70%概率下雨)、日历上标注的户外团建活动、用户以前遇到下雨就改期的习惯、以及当前空闲的室内会议室,Agent就能给出一个靠谱的建议——挪到B会议室,理由充分。信息差决定了输出质量。

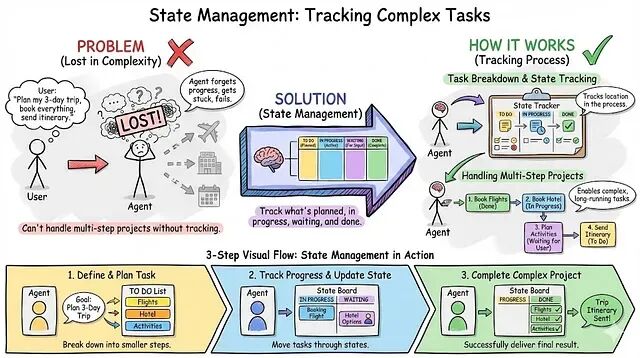

9、状态管理:跟踪多步任务的进度

用户不会只问一个简单问题就完事。他们会提出需要几小时甚至几天才能完成的多步骤项目。Agent必须知道自己做到哪了。

状态管理就是跟踪每个任务处于什么阶段——已规划、进行中、等待输入、已完成。没有这层机制,稍微复杂点的需求Agent就搞不定。

用户说"调研排名前5的竞品,做一张对比表格"。Agent拆成子任务:第一步,确定竞品名单(进行中);第二步,逐个调研(等第一步的结果);第三步,生成表格(等第二步的结果)。干到一半需要用户确认"你最关心哪些指标",Agent就把这个子任务标成等待状态,抛出问题,转去做别的事。用户回复后,它从中断的地方精确恢复。没有状态管理的话?Agent丢失上下文,只能从头来过。

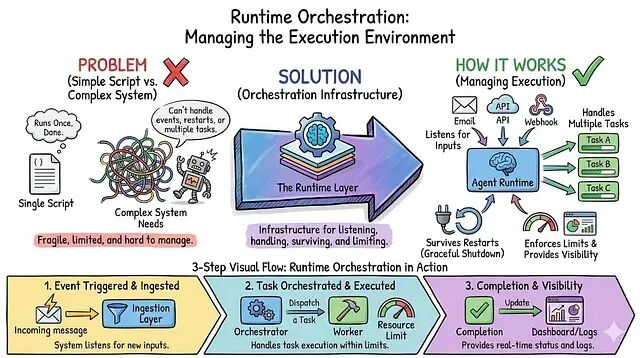

10、运行时编排:管理执行环境

Agent不是跑一次就结束的脚本。它是一个长期运行的系统,要响应事件、并行处理任务、扛住重启、还得在资源限制内运转。

运行时编排就是这套基础设施。Agent怎么监听多个输入源?怎么优雅关闭?怎么让外部看到它在干什么?怎么防止某个任务把资源全吃光?这些都是编排层要解决的问题。

一个典型场景:Agent同时监听Slack消息、定时任务和Webhook回调。事件队列把每条消息分发给对应的处理器——用户发的紧急Slack消息即时响应,定时报告在后台跑。部署新版本时,关闭处理器先把所有进行中的任务状态存盘。资源限制确保单个任务不会跑超过5分钟、发起超过50次API调用。出了问题,分布式追踪能精确复现整个执行链路。

何时使用每个概念

从零开始?先搞定MCP和工具发现。地基打好了后面加功能才不会出错。最怕一上来就硬编码集成,回头全是技术债。

测试过了但生产环境翻车?上护栏和错误恢复。执行前校验,瞬态故障自动重试。生产环境的边界情况永远比你想的多。

Agent记性差、表现蠢?加记忆。短期记忆给对话,长期记忆存事实。再配合上下文工程确保决策时信息是完整的。

任务卡住跑不动?看看推理循环和状态管理。复杂需求要拆成可追踪的子任务,计划走不通时Agent得有能力自己调整。

担心安全问题?护栏加人在回路中。起步阶段保守一些,随着对Agent能力边界摸清楚了,再逐步放权。

提示词写得不错但Agent还是做出错误决策?问题多半出在上下文工程。检查一下Agent在做决定时到底看到了哪些信息——用户偏好、系统状态、环境变量,是不是漏了什么。把注入的上下文记录下来方便排查。

部署和监控头疼?运行时编排该补上了。事件处理、优雅关闭、可观测性、资源限制。看不见的问题没法修。

需要快速接入大量外部服务?MCP服务器。一个协议打通所有工具,别再给每个新服务手写集成代码了。

API账单蹭蹭往上涨?加资源限制。每个任务的执行时间和API调用次数都该有上限。宁可快速失败,也别把预算悄悄烧光。

用户不信任Agent?高风险操作走人工审批,其他场景靠错误恢复兜底。透明度是信任的前提——告诉用户Agent在干什么、为什么这么干。

by Divy Yadav