前言

之前写了一篇文章: Mediapipe+OpenCV图像识别技术与Unity引擎的结合

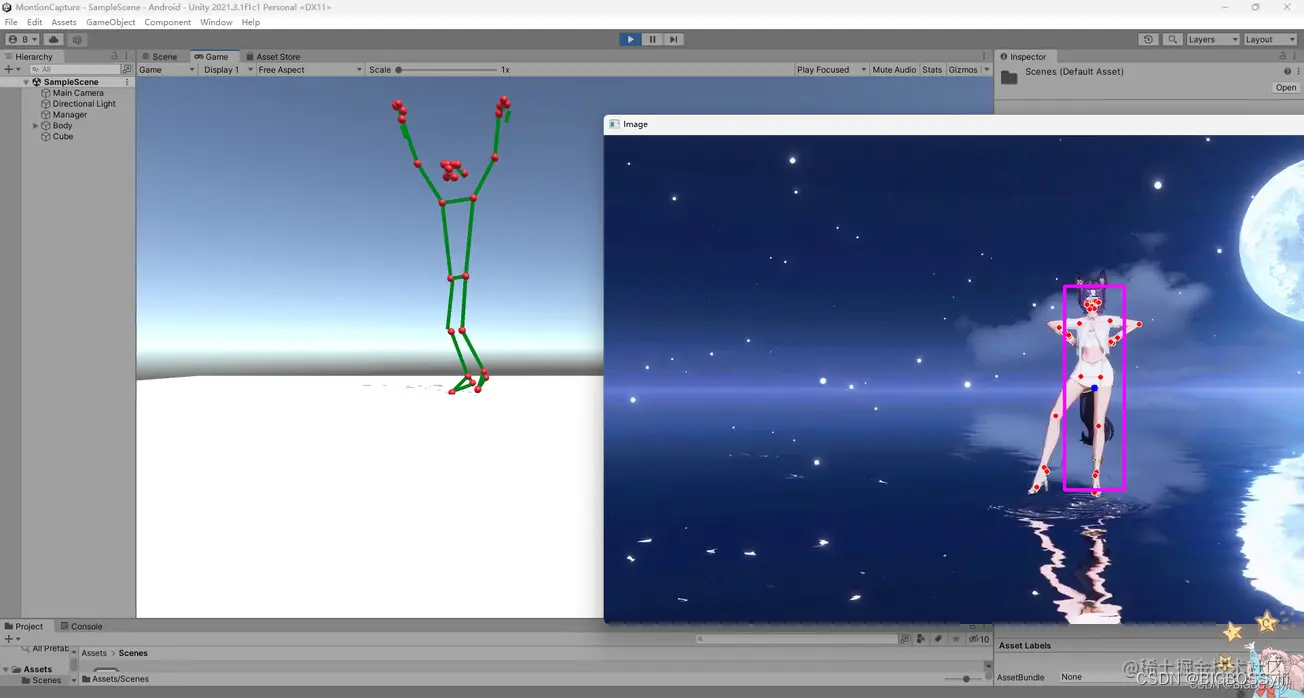

其中的技术是Python利用OpenCV图像捕捉,配合强大的Mediapipe库来实现人体动作检测与识别;将识别结果实时同步至Unity中,实现人物模型在Unity中运动身体结构识别

技术更新

因为之前的人物动作捕捉是先通过Python和Mediapipe先将人物动作进行捕捉,将捕捉到的数据format后写入到txt中,在Unity端对txt进行数据读取,进而实现Unity人物运动;其中的缺点是:没有时效性

而本次的改进:通过利用socket和UPD通信,在localhost中数据传输,让动捕数据实时传输,到达实时动捕的效果

Demo演示

之前的Demo展示:https://hackathon2022.juejin.cn/#/works/detail?unique=WJoYomLPg0JOYs8GazDVrw

更新后效果

可以和珈乐同步互动…

本篇文章所用的技术会整理后开源,后续可以持续关注:

项目地址:https://github.com/BIGBOSS-dedsec/OpenCV-Unity-To-Build-3DPerson

GitHub:https://github.com/BIGBOSS-dedsec

CSDN: https://blog.csdn.net/weixin_50679163?type=edu

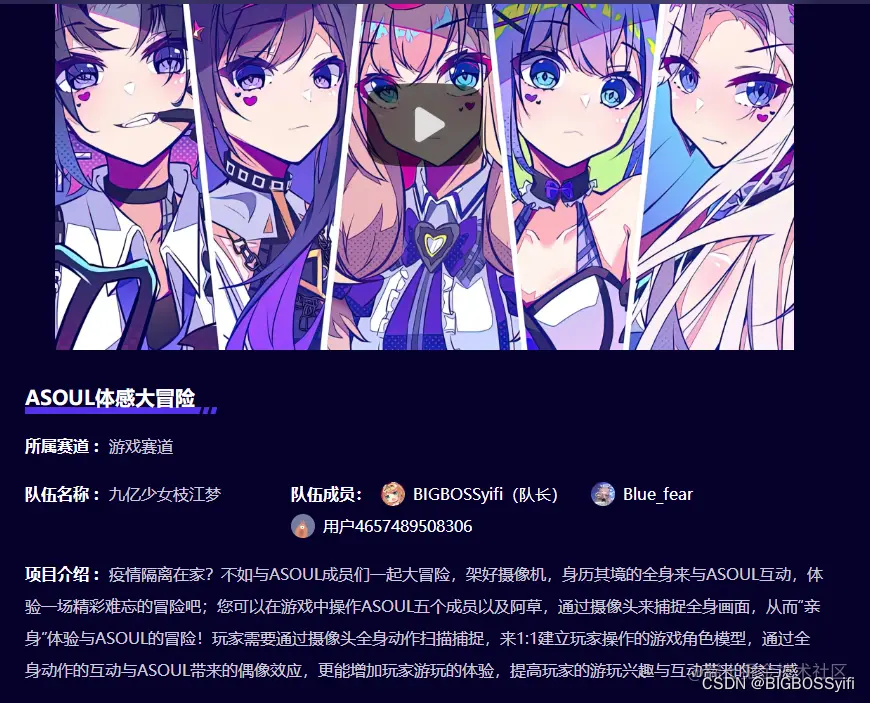

同时本篇文章实现的技术参加了稀土掘金2022编程挑战赛-游戏赛道-优秀奖

作品展示:https://hackathon2022.juejin.cn/#/works/detail?unique=WJoYomLPg0JOYs8GazDVrw

认识Mediapipe

项目的实现,核心是强大的Mediapipe ,它是google的一个开源项目:

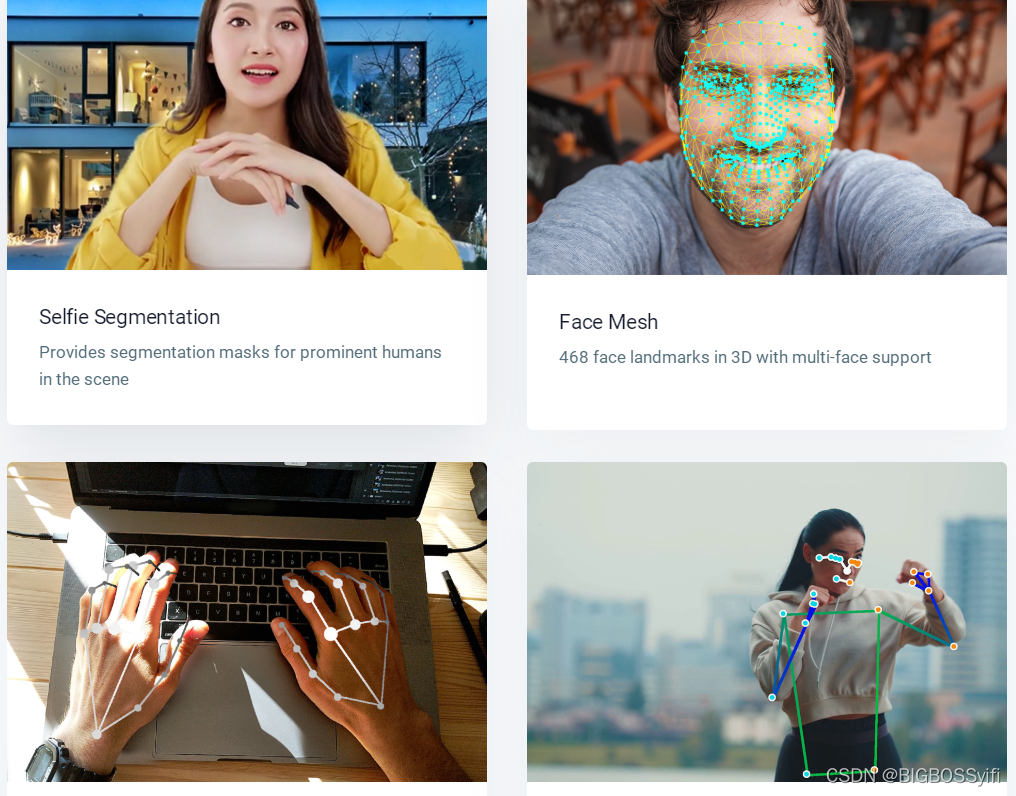

功能详细人脸检测 FaceMesh从图像/视频中重建出人脸的3D Mesh人像分离从图像/视频中把人分离出来手势跟踪21个关键点的3D坐标人体3D识别33个关键点的3D坐标物体颜色识别可以把头发检测出来,并图上颜色

Mediapipe Dev

以上是Mediapipe的几个常用功能 ,这几个功能我们会在后续一一讲解实现

Python安装Mediapipe

pip install mediapipe==0.8.9.1

也可以用 setup.py 安装

https://github.com/google/mediapipe

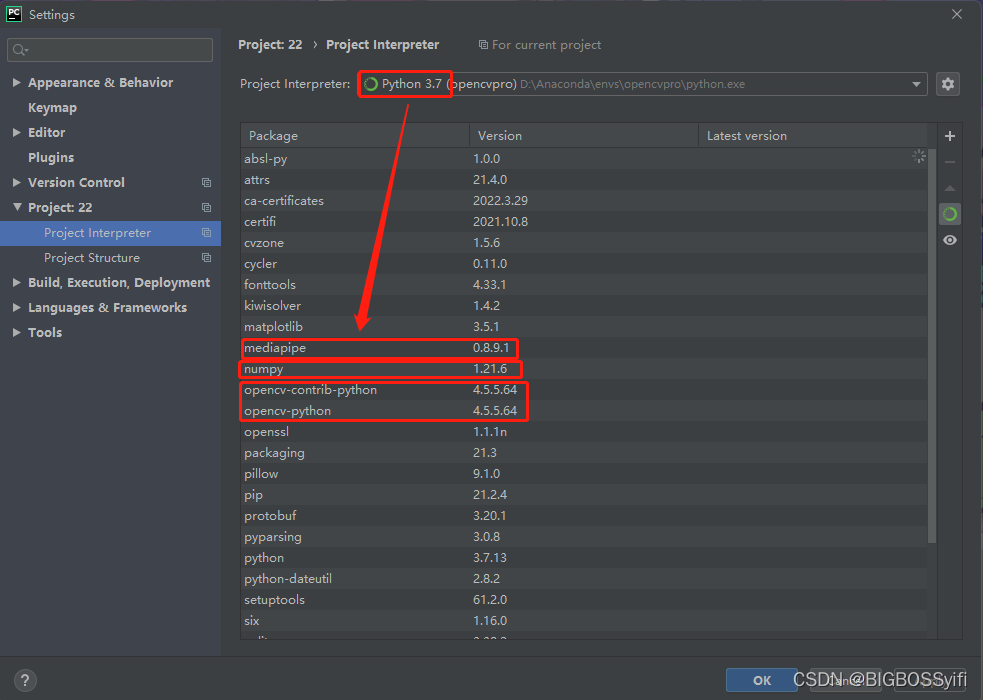

项目环境

Python 3.7

Mediapipe 0.8.9.1

Numpy 1.21.6

OpenCV-Python 4.5.5.64

OpenCV-contrib-Python 4.5.5.64

实测也支持Python3.8-3.9

身体动作捕捉部分

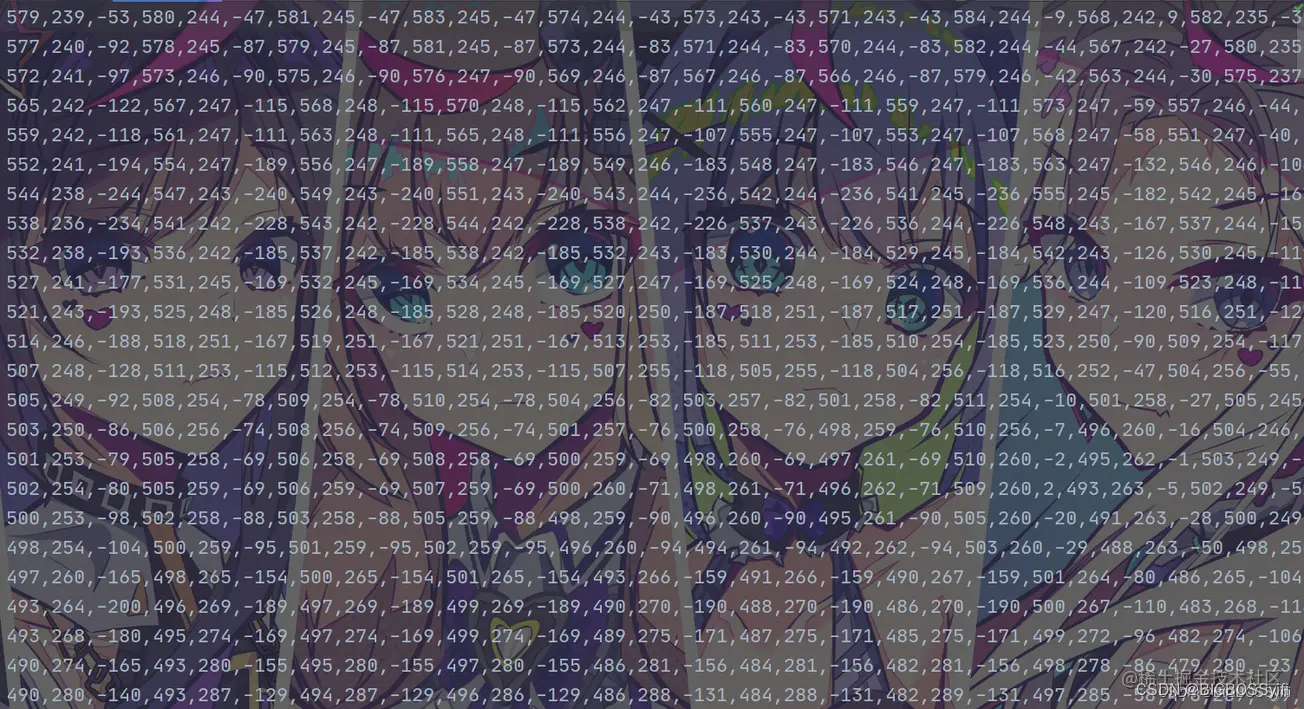

身体数据文件

这部分是我们通过读取视频中人物计算出每个特征点信息进行数据保存,这些信息很重要,后续在untiy中导入这些动作数据

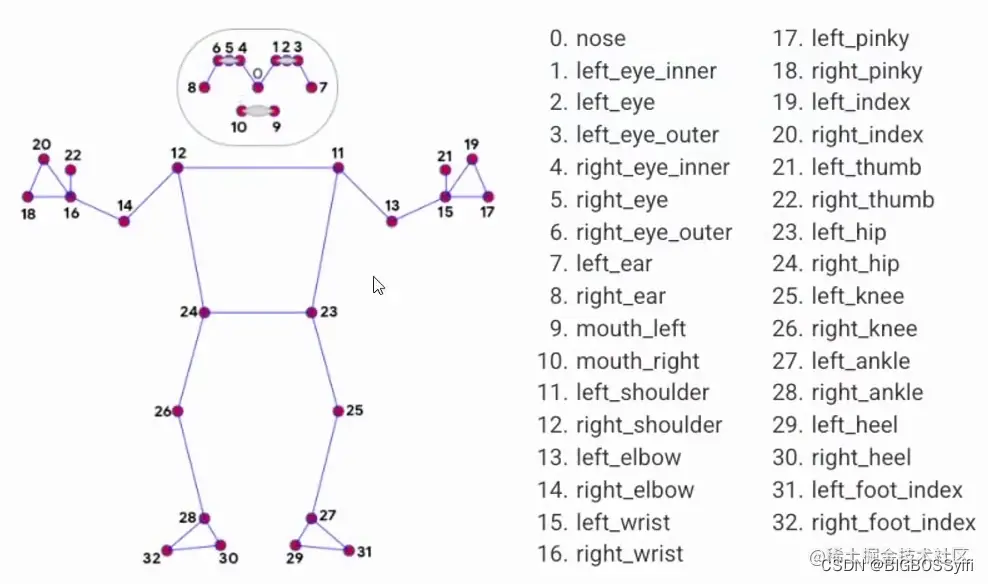

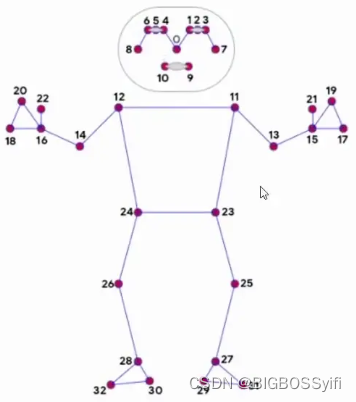

关于身体特征点

核心代码

摄像头捕捉部分:

import cv2

cap = cv2.VideoCapture(0)#OpenCV摄像头调用:0=内置摄像头(笔记本) 1=USB摄像头-1 2=USB摄像头-2whileTrue:

success, img = cap.read()

imgRGB = cv2.cvtColor(img, cv2.COLOR_BGR2RGB)#cv2图像初始化

cv2.imshow("HandsImage", img)#CV2窗体

cv2.waitKey(1)#关闭窗体

视频帧率计算

import time

#帧率时间计算

pTime =0

cTime =0whileTrue

cTime = time.time()

fps =1/(cTime - pTime)

pTime = cTime

cv2.putText(img,str(int(fps)),(10,70), cv2.FONT_HERSHEY_PLAIN,3,(255,0,255),3)#FPS的字号,颜色等设置

身体动作捕捉:

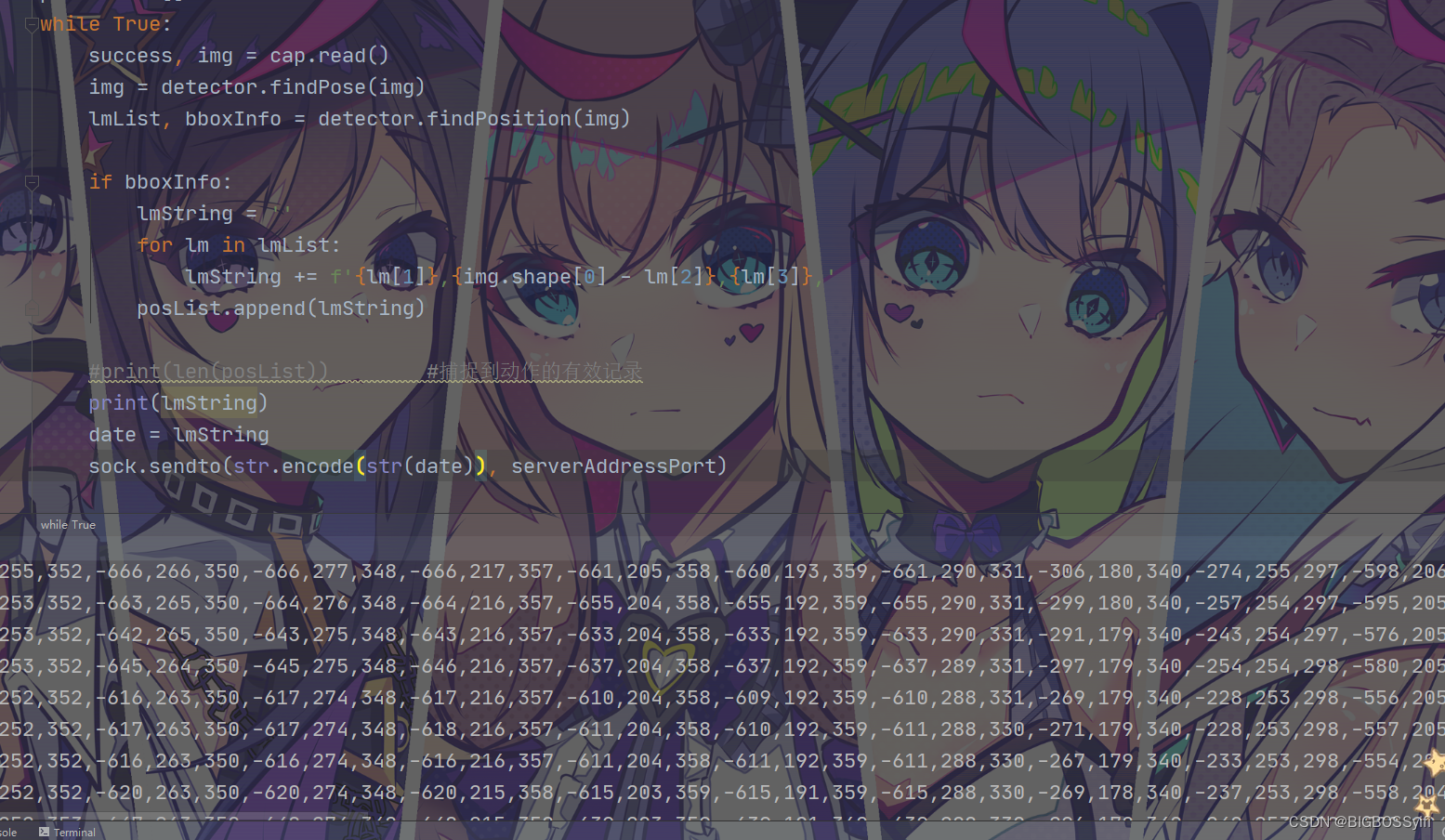

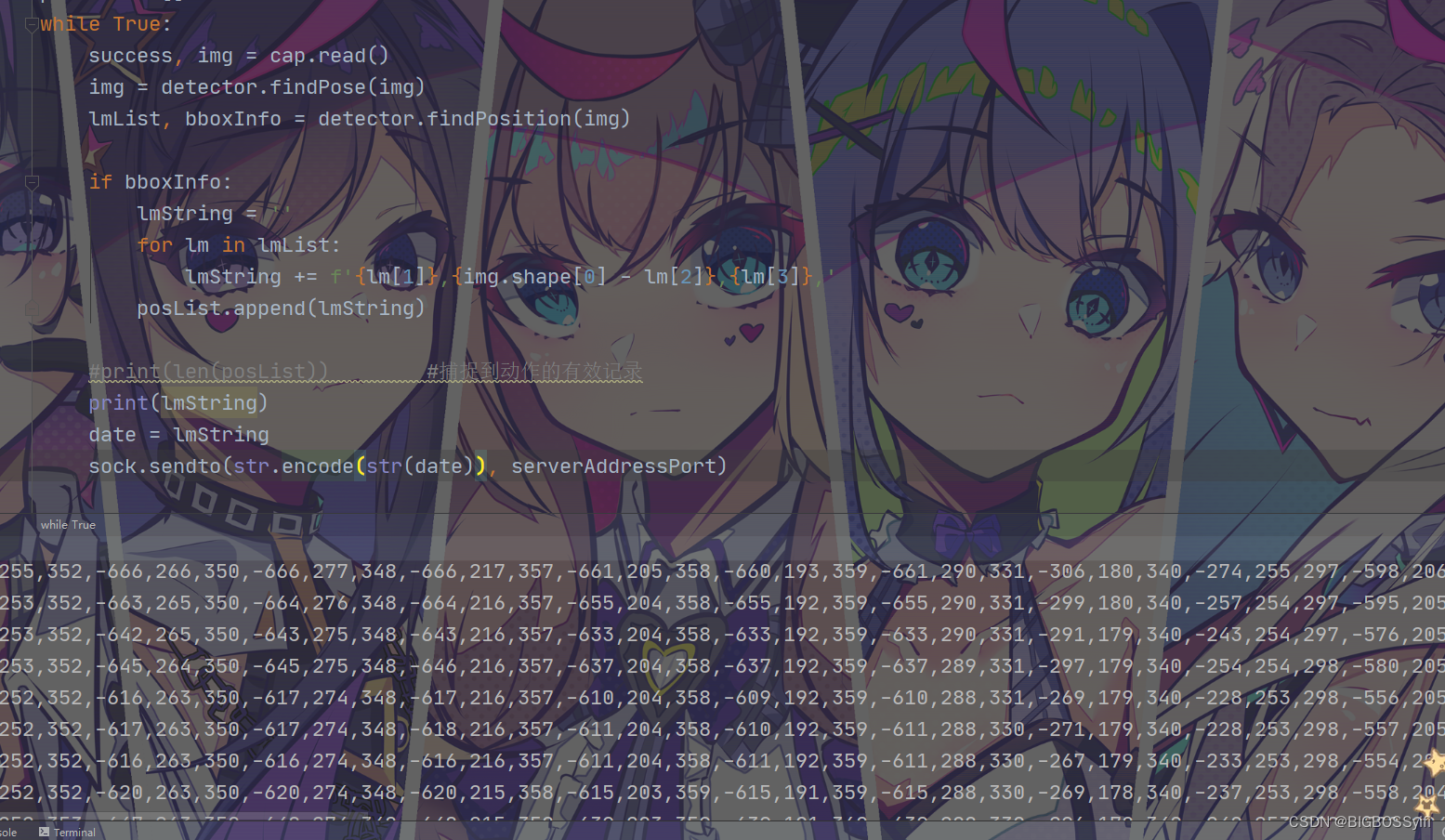

whileTrue:if bboxInfo:

lmString =''for lm in lmList:

lmString +=f'{lm[1]},{img.shape[0]- lm[2]},{lm[3]},'

posList.append(lmString)

数据传输:

# 定义localhost和端口

sock = socket.socket(socket.AF_INET, socket.SOCK_DGRAM)

serverAddressPort =("127.0.0.1",5054)# 数据发送

date = lmString

sock.sendto(str.encode(str(date)), serverAddressPort)

完整代码

MotionCapPRO.py

import cv2

from cvzone.PoseModule import PoseDetector

import socket

# cap = cv2.VideoCapture('1.mp4')

cap = cv2.VideoCapture(0)

sock = socket.socket(socket.AF_INET, socket.SOCK_DGRAM)

serverAddressPort =("127.0.0.1",5054)# 定义localhost与端口,当然可以定义其他的host

detector = PoseDetector()

posList =[]# 保存到txt在unity中读取需要数组列表whileTrue:

success, img = cap.read()

img = detector.findPose(img)

lmList, bboxInfo = detector.findPosition(img)if bboxInfo:

lmString =''for lm in lmList:

lmString +=f'{lm[1]},{img.shape[0]- lm[2]},{lm[3]},'

posList.append(lmString)# print(len(posList)) print(lmString)

date = lmString

sock.sendto(str.encode(str(date)), serverAddressPort)

cv2.imshow("Image", img)

key = cv2.waitKey(1)# 记录数据到本地# if key == ord('r'): withopen("MotionData.txt",'w')as f:

f.writelines(["%s\n"% item for item in posList])

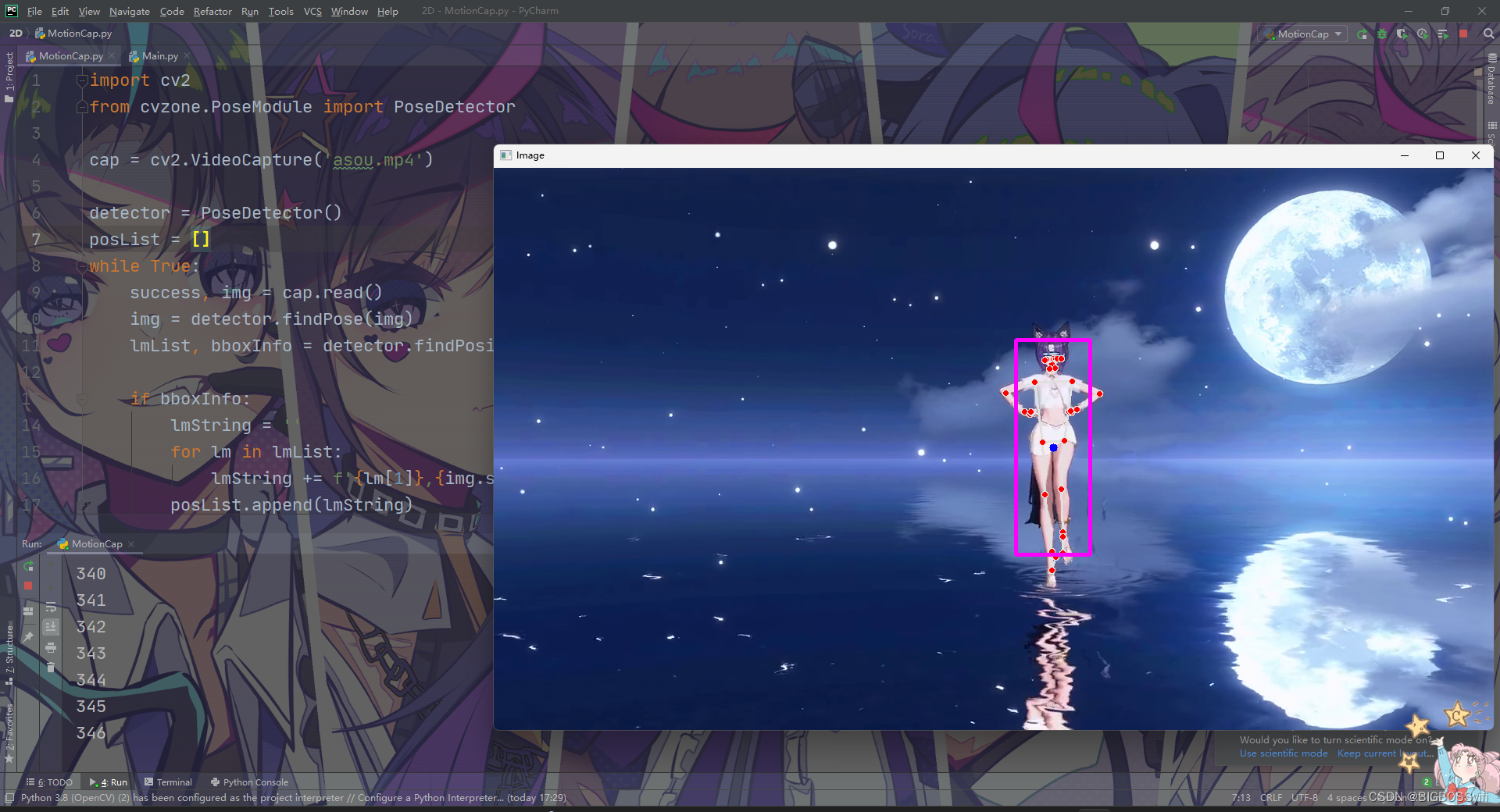

运行效果

Unity 部分

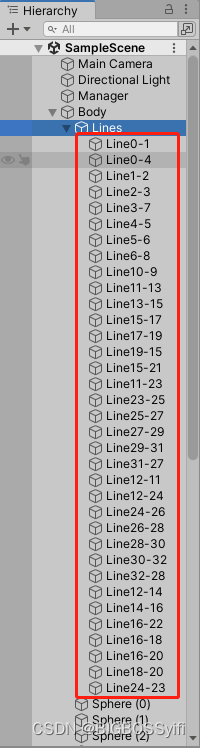

建模

在Unity中,我们需要搭建一个人物的模型,这里需要一个33个Sphere作为身体的特征点和33个Cube作为中间的支架

具体文件目录如下:

Line的编号对应人物模型特征点

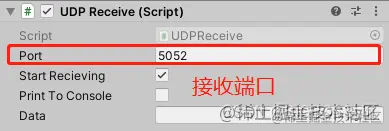

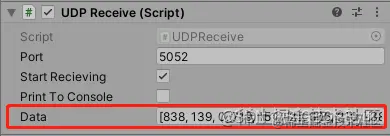

UPD.cs (用于接收端口数据)

usingUnityEngine;usingSystem;usingSystem.Text;usingSystem.Net;usingSystem.Net.Sockets;usingSystem.Threading;publicclassUDPReceive:MonoBehaviour{Thread receiveThread;UdpClient client;publicint port =5052;publicbool startRecieving =true;publicbool printToConsole =false;publicstring data;publicvoidStart(){

receiveThread =newThread(newThreadStart(ReceiveData));

receiveThread.IsBackground =true;

receiveThread.Start();}privatevoidReceiveData(){

client =newUdpClient(port);while(startRecieving){try{IPEndPoint anyIP =newIPEndPoint(IPAddress.Any,0);byte[] dataByte = client.Receive(ref anyIP);

data = Encoding.UTF8.GetString(dataByte);if(printToConsole){print(data);}}catch(Exception err){print(err.ToString());}}}}

(水印是我的,非盗用)

Line.cs

这里是每个Line对应cs文件,实现功能:使特征点和Line连接在一起

usingSystem.Collections;usingSystem.Collections.Generic;usingUnityEngine;publicclassLineCode:MonoBehaviour{LineRenderer lineRenderer;publicTransform origin;publicTransform destination;voidStart(){

lineRenderer =GetComponent<LineRenderer>();

lineRenderer.startWidth =0.1f;

lineRenderer.endWidth =0.1f;}// 连接两个点voidUpdate(){

lineRenderer.SetPosition(0, origin.position);

lineRenderer.SetPosition(1, destination.position);}}

Action.cs

这里是读取上文识别并保存的人物动作数据,并将每个子数据循环遍历到每个Sphere点,使特征点随着视频中人物动作运动

usingSystem.Collections;usingSystem.Collections.Generic;usingUnityEngine;publicclassbody:MonoBehaviour{// Start is called before the first frame updatepublicUDPReceive udpReceive;publicGameObject[] bodyPoints;voidStart(){}// Update is called once per framevoidUpdate(){string data = udpReceive.data;// data = data.Remove(0, 1);// data = data.Remove(data.Length - 1, 1);print(data);string[] points = data.Split(',');print(points[0]);//0 1*3 2*3//x1,y1,z1,x2,y2,z2,x3,y3,z3for(int i =0; i <32; i++){float x =float.Parse(points[0+(i *3)])/100;float y =float.Parse(points[1+(i *3)])/100;float z =float.Parse(points[2+(i *3)])/300;

bodyPoints[i].transform.localPosition =newVector3(x, y, z);}}}

最终实现效果

这里的视频与Unity运行有延时

后记

利用这一技术,后期可以开发出更多有意思的玩法,虽然比赛已经结束(也取得一个自己比较满意的成果),但是我的作品更新不会结束,我会一直完善下去,直到成为一款优秀的ASOUL游戏作品!坚持下去的所有动力都是对ASOUL的热爱,永远的五人团—“我们是AAAAAASOULLLLLLL!!!”

Good Luck,Have Fun and Happy Coding!!!

版权归原作者 BIGBOSSyifi 所有, 如有侵权,请联系我们删除。