探索文档图像大模型,提升智能文档处理性能

0. 前言

自

ChatGPT

于

2022

年

11

月发布以来,大模型的相关研究在全世界的学术界和工业界都引起了广泛的关注,大模型技术也为智能文档处理领域带来了新的机遇。通过在智能文档处理领域训练和应用大规模深度学习模型,能够提供更准确、全面的文档理解与分析,改善文档图像识别和分类的性能,并提供强大的文档生成和翻译能力。这将推动智能文档处理技术的发展,为各行各业的数字化转型和智能化升级提供重要支持。

在本节中,我们将回顾来自合合信息的丁凯博士在

第十九届中国图象图形学学会青年科学家会议 - 垂直领域大模型论坛

中关于文档图像大模型的思考与探索,并介绍在大模型时代下文档智能处理技术面临的挑战和研究进展。

1. 垂直领域大模型论坛

1.1 论坛介绍

2023

年

12

月

28

日至

31

日在广州成功举办“第十九届中国图像图形学学会青年科学家会议”,该会议由中国图像图形学学会青年工作委员会主办,合合信息联合承办。会议面向国际学术前沿与国家战略需求,聚焦最新前沿技术和热点领域 。

2023

年

12

月

29

日下午,垂直领域大模型论坛成功举办。“垂直领域大模型”致力于在重要的前沿科技领域开发特定行业或应用领域优化的大型人工智能模型,同时,也为行业特定解决方案、数据分析和智能决策提供了重要的技术支撑。此次论坛的重点是介绍垂直领域大模型的最新研究进展与前沿技术,旨在促进图像图形领域学术界与产业界之间的交流与合作,推动该领域的创新与发展。

1.2 走近合合信息

合合信息是行业领先的人工智能及大数据科技企业,深耕智能文字识别、图像处理、自然语言处理和大数据挖掘等领域,其研发的智能图像处理引擎提供多种图像智能处理黑科技,例如图像切边增强、PS 篡改检测以及图像矫正等,相关黑科技的体验可以登录合合信息官网。

合合信息发布的产品包括名片全能王、扫描全能王和 TextIn 智能文档处理云平台,为全球用户和企业提供卓越的服务。其研究团队合合

TextIn

在智能文档处理技术领域进行了广泛而深入的研究,包括文档图像分析与预处理、文档解析与识别、版面分析与还原、文档信息抽取与理解、AI安全以及存储检索和管理等多个关键技术,为智能文档处理领域的发展做出了巨大贡献。

2. 大模型时代下的文档图像智能处理

文档图像智能处理是一种将图像和文本结合起来的技术,可以将图像中的文字识别为计算机可读的文本,并将其用于数据分析、信息检索、自然语言处理以及其他信息处理任务中,因此文档图像智能分析与处理在现实场景具有重要意义,不仅能够进行自动化识别和提取文本信息,降低人力成本,提高生产效率,同时具有广泛的应用场景。

但目前,文档图像智能分析与处理过程中仍面临着诸多挑战,例如,文档类型的多样产生了繁杂的版式与结构,同时文档图像来源的多样导致了形式、格式、布局、字体、大小等方面具有的差异性,同时受拍摄器材、背景环境影响,文档图像可能存在噪声、失真、模糊等问题,这会影响到图像的质量和识别准确度。

因此文档图像智能处理是图像图形技术研究的重要方向,为了推动相关研发和实践工作,在垂直领域大模型论坛上,来自合合信息的丁凯博士主要介绍了大模型时代下文档图像智能处理面临的一些关键技术难题和挑战,以及合合信息在解决文档图像智能处理领域面临的各类问题时所做一些相关工作进展和研究成果。

2.1 大模型发展

随着

ChatGPT

等大模型在自然语言处理和其他领域的广泛应用,大模型这一概念开始受到越来越多的关注。一方面,大模型在很多领域都取得了显著的成果,为人工智能技术的发展提供了强大的支撑。例如,在自然语言处理领域,大模型可以实现更精确、更快速的文本生成、机器翻译等任务;在图像识别领域,大模型可以实现更高准确性的图像分类和目标检测等任务。另一方面,随着硬件技术的不断进步和计算资源的逐步普及,大模型的应用也逐渐向更多的领域扩展。越来越多的企业和研究机构开始关注大模型的应用与研究。

在文档图像智能处理领域,随着多模态大模型的深入研究和发展,使得处理具有多种类型和来源的数据变得更加容易和精确。例如,可以通过使用多模态信息(如文本、视觉和音频)来实现文档图像的内容理解和分类,并且可以使用大规模深度学习模型进行训练与推理,从而取得更好的效果和性能。

2.2 GPT-4V 在文档领域的表现

GPT-4V

是基于

SOTA

(

state of the art

) 大语言模型 (

Large Language Model

,

LMM

) 并使用大量多模态数据训练的最先进的具有视觉能力的大型多模态模型 (

Large Multimodal Model

,

LMM

)。

GPT-4V

不仅可以使用仅文本输入 (

text-only inputs

),也可以选择仅带有单个图像的单个图像-文本对 (

single image-text pair

),还可以选择带有多个图像输入 (

multiple image inputs

) 的交错图像-文本对 (

interleaved image-text pairs

)。

在场景文字识别,无论语言的种类和形态,

GPT-4V

都可以取得较好的结果,与此同时,在类似手写文字识别、几何图像与文字结合的教育场景中,

GPT-4V

也具有优秀的表现。而传统的技术想要实现在几何图像与文字结合的文档中做到正确识别,需要多个模型进行缝合,并针对特定场景进行定制,其泛化能力有限。

除了常规的证件识别外,

GPT-4V

也可以针对比较复杂版式,甚至对于多张不同的文档图像以及文档图像与自然场景结合的信息抽取和文档理解,

GPT-4V

同样表现优异,例如,提问图中商品价格,

GPT-4V

会首先分析自然场景中有多少此类商品,然后再账单图像中根据总价和商品数量计算出商品单价,最终得到自然场景中的商品总价,使用端到端的形式解决图像文档处理问题。

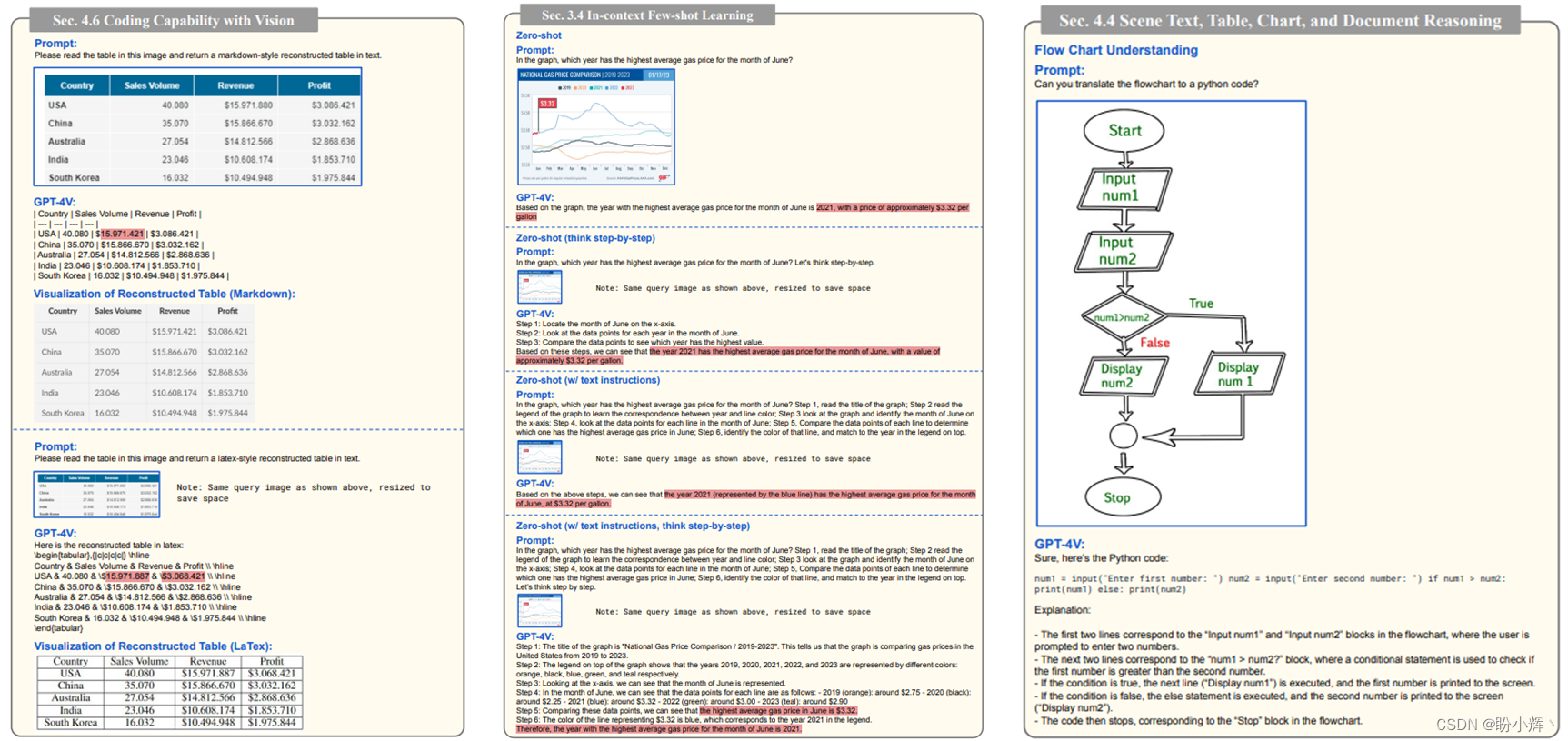

GPT-4V

除了在表格文档中表现优异外,还能够针对统计图,包括曲线图、柱状图等进行处理,能够清晰的描述图表中的内容,同时在根据图表内容进行编码和问答等方面表现出巨大的潜力,而传统方法对此领域的研究效果相对一般,且泛化能力与

GPT-4V

有相当大的差距。

在文档图像处理领域的某些问题上,

GPT-4V

超出了传统方法的研究水平,例如在专业学科问题上,针对建筑场景的设计图、生物、地理学科的图文结合理解,对于传统方法而言仍然是较大挑战。

看到

GPT-4V

在智能文档处理领域的优异表现后,接下来,我们需要回答以下问题:在

GPT-4V

模型提出后,传统的光学字符识别 (

Optical Character Recognition

,

OCR

) 是否面临淘汰的窘境?

2.3 GPT-4V 对智能文档处理的局限性

尽管以

GPT-4V

为代表的大模型在认知和理解等层面取得了非常惊艳的效果,但在文档处理领域中面临的问题,例如图像质量、文字识别和版面分析等仍然存在。

GPT-4V

仍然无法解决所有

OCR

问题,例如,在中文领域,无论是印刷还是手写字体,经常会出现幻觉现象(幻觉现象是指模型生成的内容与现实世界事实或用户输入不一致的现象,通俗理解就是,模型在“胡说八道”),经常会出现大段的不存在内容。在智能文档处理 (

Intelligent Document Processing

,

IDP

) 领域,幻觉现象的出现可能通常是由于模型在识别文档时就偏离了文档所内容造成。研究表明,在处理非拉丁语言和复杂任务(如手写数学表达式识别、表格结构识别以及从文档图像中进行端到端语义实体识别和对抽取)时仍存在困难。基于此,专门的

OCR

模型仍具有必要性和研究价值。

为了全面衡量

GPT-4V

在

IDP

领域的表现,研究人员对

GPT-4V

在一系列

OCR

任务中的表现进行了量化评估,包括场景文字识别、手写文字识别、手写数学表达式识别、表格结构识别以及从视觉丰富的文档中提取信息等。评估结果显示,除了在手写英文识别问题上,

GPT-4V

接近

SOTA

水平外,无论是场景文字识别、手写公式识别等

OCR

任务中,

GPT-4V

距离

SOTA

水平仍有较大差距,在手写公式识别任务中,

GPT-4V

甚至只有

10%

左右的准确率,完全无法进行正常应用,而

SOTA

仍然可以达到

60%-70%

的水平。

另一方面,虽然

GPT-4V

能做到

OCR

文档识别,但对于特别长的文档,例如包含

300

页左右的文档,会超出

GPT-4V

所能处理的范畴,其依赖于前置的文档识别系统的精度。并且文档不仅有文字,还包含结构与版式,无论是扫描文档或电子文档,对于

GPT-4V

都是未解决的问题,对于稍加复杂的文档,其解析效果就会较差,如果前置识别效果较差,那么文档理解效果将大打折扣。

并且在视觉丰富的密集文本中,多模态大模型仍无法取得理想结果,主要是因为它们更倾向于基于文本的语义分析,而在视觉数据解析方面能力相对不足。这就导致在处理细粒度文本(例如细小的签名、复杂的古文字)时,传统的语言模型无法有效应对。为了克服这些限制,就需要融合专门的

OCR

技术和算法来实现准确的文本识别和提取。

3. 大模型时代下的智能文档处理

尽管存在上述限制,

GPT-4V

和其他通用

LLM

仍然可以通过增强语义理解、微调下游任务以及促进自动/半自动数据构建等方式,显著推动

OCR

领域的发展。这些方法有助于提高

OCR

系统的准确性、效率和适应性,为实现更准确和高效的

OCR

提供了潜在的解决方案。

3.1 像素级 OCR 统一模型

在

IDP

领域,

GPT-4V

仍然无法处理像素级任务,而在文档解析与识别任务上,

GPT-4V

仍然距离传统技术存在差距,

GPT-4V

的强项在于文档信息抽取与理解等认知层面上。利用

GPT-4V

提供的大模型范式,在像素级

OCR

上做统一模型,能够提升领域性能上限,弥补

GPT-4V

的缺陷。

针对目前

OCR

的多数模型通常是针对特定任务设计的,采用不同的架构和训练策略,这极大地增加了研究和维护的复杂性,并阻碍了模型在应用中的快速部署。因此,合合信息-华南理工大学文档图像分析识别与理解联合实验室研究了

UPOCR

,用于统一的像素级

OCR

模型。具体而言,

UPOCR

将不同

OCR

任务的范例统一为图像到图像的转换,并使用基于视觉

Transformer

(

ViT

) 的编码器-解码器架构。

实验结果表明,

UPOCR

模型在三个像素级OCR任务上,包括文本去除、文本分割和篡改文本检测,均实现了

SOTA

性能,而仅使用一个统一的模型,为通用

OCR

模型的研究提供了有益参考。

3.2 OCR 大一统模型

令计算机理解文档图像是一项困难但至关重要的任务,它涉及到复杂的功能,例如文本识别和对文档的整体理解。目前的视觉文档理解 (

Visual Document Understanding

,

VDU

) 方法主要依赖传统的

OCR

引擎来处理文本识别,并且主要关注使用

OCR

输出进行理解。尽管这些基于

OCR

的方法表现出一定的准确性,但它们也存在以下问题:高昂的计算成本;对语言和文档类型的灵活性有限;

OCR

错误可能会影响后续处理过程。

为解决上述问题,

Donut

模型移除了

OCR

,使用

Transformer

架构,并使用交叉熵损失进行预训练。而

NOUGAT

模型通过

Swin Transformer

和

Transformer Decoder

实现文档图像到文档序列输出,主要解决了

PDF

格式会导致语义信息丢失的问题。

KOSMOS2.5

是用于阅读文本密集图像的多模态模型,基于

Pix2Seq

架构根据输入图像输出文本块识别结果,该模型可以通过微调轻松适应任何具有不同

prompt

的文本密集图像理解任务。

丁凯博士分享了

OCR

大一统模型相关的研究范式:

- 将文档图像识别分析的各种任务定义为序列预测的形式

- 通过不同的

prompt引导模型完成不同的OCR任务 - 支持篇章级的文档图像识别分析,输出

Markdown/HTML/Text等标准格式 - 将文档理解相关的工作交给

LLM去做

团队基于上述理念与其他

SOTA VDU

模型,提出了

OCR

大一统模型

SPTS v3

,将多种

OCR

任务定义为序列预测的形式,通过不同的prompt引导模型完成不同的

OCR

任务。

3.3 文档识别分析与 LLM 应用融合

在论坛分享的最后,丁凯博士展示了合合信息对于多模态大模型在文档领域应用的范式,该范式包含

文档和用户问题

(首先处理文档的图像形式,包括扫描的纸质文件、拍照的照片,或电子文档的页面图像)、

文档识别与版面分析

(识别文档中的文字、图片、表格等元素,并分析版面布局,包括标题、段落、页眉和页脚,用于理解文档的总体结构和内容组织)、

文档切分与召回

(将文档切分,将不同部分的内容分离出来,以便进行进一步处理和分析,此外,实施召回策略用于检索和提取文档中的特定元素,如标题、关键字和段落内容)和

LLM 问答

(大语言模型问答用于文档中信息提取的问答任务,通过训练模型理解文档内容,实现高度智能化的信息提取和交互,以便用户可以快速获取所需信息)等关键步骤。

最后,丁凯博士以相关产品对财报问答的实践为例,展示了合合信息在文档识别分析与

LLM

应用融合方面的研究进展。通常,诸如财报之类的文档内容长(有时多大数百页)、图表多,版式杂(混合使用多种图表)、专业性强(包含大量专业术语)以及数据多,相似概念多(多个概念是同一数据的不同表述),因此传统的处理方法存在处理效率低、语义解析能力不足等问题,而新的模型能够从复杂的文档中提取关键信息,并以人类可读的方式呈现给用户。例如,它可以识别重要的数据和图表,并解析其中的信息,并且还能够理解上下文和语义关系,帮助用户更好地理解和分析文档内容。项目体验地址:https://www.textin.com/market/detail/document。

4. 文档图像大模型发展展望

通过整合图像、文字和语音等多种模态数据,以

GPT-4V

为代表的多模态大模型技术极大的推动了文档识别与分析领域的进步,为传统的图像文档处理技术带来了重大挑战,但仍然存在许多亟待解决的问题,需要进一步的研究和探索,例如文档识别等感知层面的研究、以及如何更好地结合大模型的能力来优化图像文档处理。

随着技术的不断进步,感知与认知的结合将会为用户带来更加智能、高效、便捷的图像文档处理体验,实现更深入的语义理解和分析,从而提高文档的组织、分类和检索等方面的效率和精度。期待合合信息在模式识别、深度学习、图像处理和自然语言处理等领域继续深入探索和研究,以推动技术创新。

小结

尽管多模态大模型技术在智能文档处理领域有着重要的作用,但它并没有完全解决该领域面临的问题。本文通过回顾丁凯博士在第十九届中国图象图形学学会青年科学家会议 - 垂直领域大模型论坛上的报告,介绍了

GPT-4V

在

IDP

领域的优异性能及其面临的挑战,然后介绍了合合信息在文档感知方面的研究进展,并分析了如何将文档识别分析与大语言模型融合,以进一步提高图像文档处理的性能。

相关链接

多模态大模型时代下的文档图像智能分析与处理

参与问卷调查,赢取福利

合合信息为大家准备了一份福利!只需填写问卷,在

1

月

12

日开奖时,将有机会成为

10

名幸运儿之一,每位获奖者将获得

50

元京东卡,快来参与吧!

版权归原作者 盼小辉丶 所有, 如有侵权,请联系我们删除。