打开AI的黑盒子——机器学习可解释性!

随着机器学习模型在各行各业的广泛应用,特别是在医疗、金融、司法等高风险领域,模型的可解释性变得尤为重要。为什么得到这样的结果往往和结果本身一样重要。使用兼容性矩阵和权衡分数优化来确定满足所有要求和约束的最佳权衡分数,为模型开发中的数据效用、隐私和可解释性提供了一个系统和客观的调和手段。提出了一种新的

ICLR 2024 | Meta AI提出ViT寄存器结构,巧妙消除大型ViT中的伪影以提高性能

在这项工作中,作者对 DINOv2 模型特征图中的伪影进行了详尽的研究,并发现这种现象存在于多个现有的流行ViT模型中。作者提供了一种简单的检测伪影的方法,即通过测量token的特征范数来实现。通过研究这些token的局部位置和全局特征信息,作者发现,这些token对于模型性能损失存在一定的影响,并

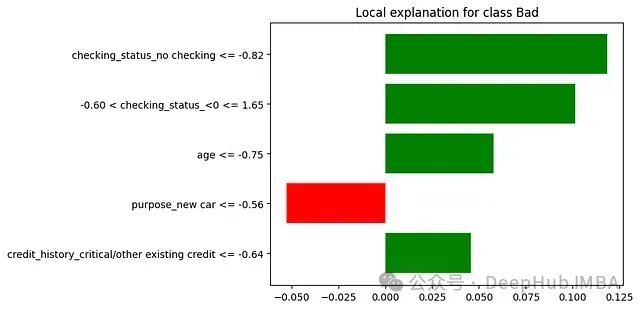

10个用于可解释AI的Python库

XAI的目标是为模型的行为和决定提供有意义的解释,本文整理了目前能够看到的10个用于可解释AI的Python库

可解释的AI:用LIME解释扑克游戏

可解释的AI(XAI)一直是人们研究的一个方向,在这篇文章中,我们将看到如何使用LIME来解释一个模型是如何学习扑克规则的。

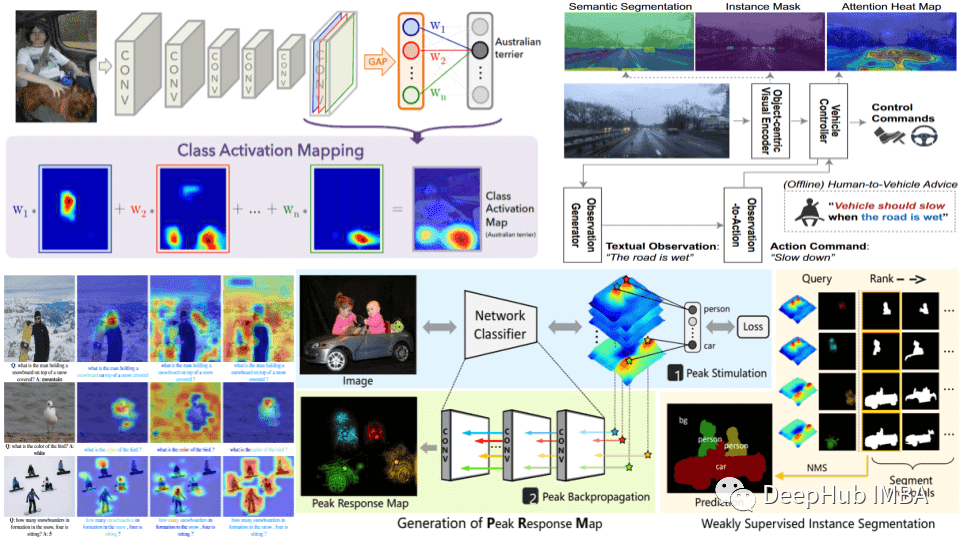

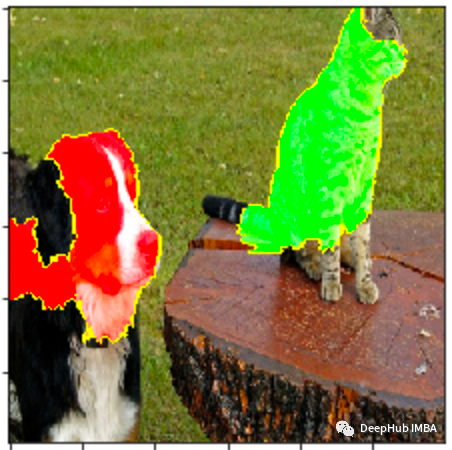

使用LIME解释CNN

图像与表格数据集有很大不同,我们用突出显示图像中模型预测的重要区域的方法观察可解释性

6个可解释AI (XAI)的Python框架推荐

随着人工智能的发展为了解决具有挑战性的问题,人们创造了更复杂、更不透明的模型。在本文中,我将介绍6个用于可解释性的Python框架。

基于速度、复杂性等因素比较KernelSHAP和TreeSHAP

KernelSHAP 和 TreeSHAP 都用于近似 Shapley 值。本文将比较这两种近似方法

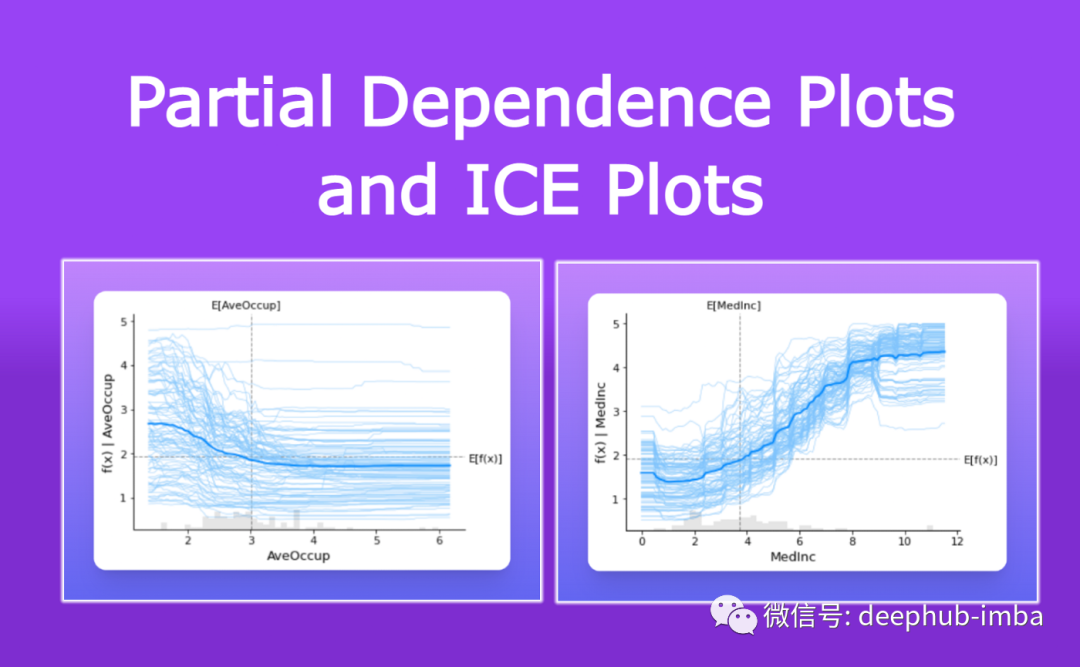

模型的可解释性:部分依赖图PDP和个体条件期望图ICE

部分依赖图 (PDP) 和个体条件期望 (ICE) 图可用于可视化和分析训练目标与一组输入特征之间的交互关系。