如果你的PyTorch优化器效果欠佳,试试这4种深度学习中的高级优化技术吧

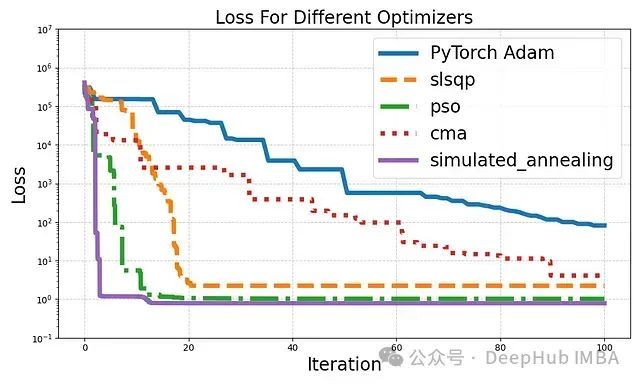

在深度学习领域,优化器的选择对模型性能至关重要。

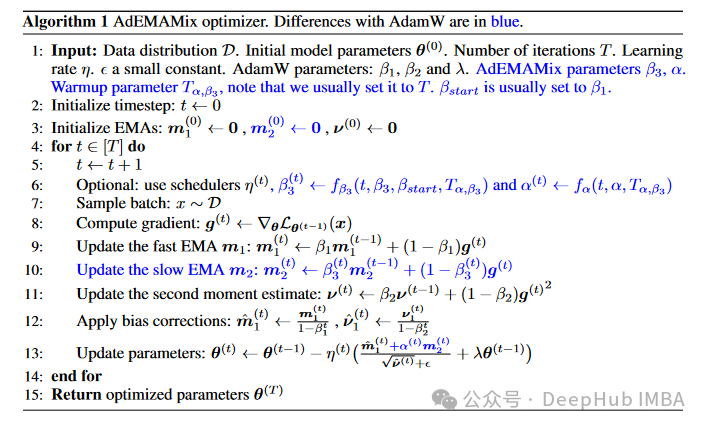

AdEMAMix: 一种创新的神经网络优化器

这种算法旨在解决当前广泛使用的Adam及其变体(如AdamW)在利用长期梯度信息方面的局限性。研究者们通过巧妙地结合两个不同衰减率的指数移动平均(EMA),设计出了这种新的优化器,以更有效地利用历史梯度信息。

Adam-mini:内存占用减半,性能更优的深度学习优化器

论文提出一种新的优化器Adam-mini,在不牺牲性能的情况下减少Adam优化器的内存占用。

【深度学习】优化器详解

深度学习中常见的优化器

深度学习中常见概念(收敛、优化器、学习率等)

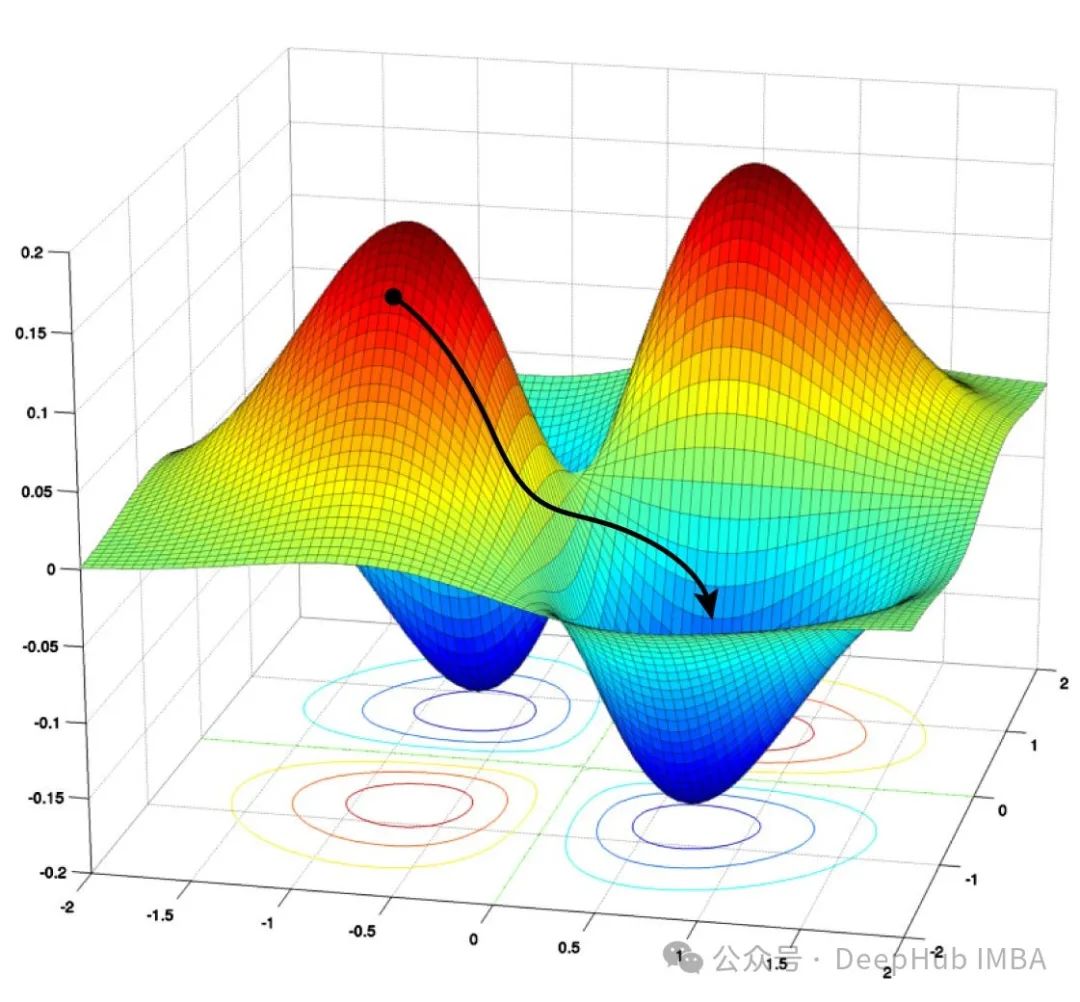

选择最优学习率是很重要的,因为它决定了神经网络是否可以收敛到全局最小值。选择较高的学习率,它可能在你的损失函数上带来不理想的后果,因此几乎从来不能到达全局最小值,因为你很可能跳过它。所以,你总是在全局最小值附近,但是从未收敛到全局最小值。选择较小的学习率有助于神经网络收敛到全局最小值,但是会花费很多