究极详细保姆教程:pycharm如何配置python路径

如何配置pycharm的python路径

Pycharm中Terminal用不了conda指令解决办法

解决了Windows系统上禁止运行脚本,以及环境变量的问题

Selenium自动化之弹窗处理

1.前言,我们在使用Selenium做Web自动化测试时,页面经常出现弹窗,如果不处理后续的测试脚本就无法正常运行,今天我们就带大家一起来学习如何处理Web页面上的弹窗。2.Web页面弹窗的分类,弹窗通常有3种:Alert类型弹框、Confirm类型弹框、Prompt类型弹框,这种我们无法通过定位元

Python爬虫入门 ~ selenium访问元素信息与交互基本使用

函数,可以获取到标签体中的文本内容,这里需要注意的是,一定得是标签体中有文字的才能正常获取到数据,想"百度一下"按钮是没有文本的,则无法获取到数据。常用的交互步骤都用上了,还是挺简单的,以后爬取别的数据也是针对性的调整一下元素的定位即可。函数,指定我们所需要的标签属性,即可得到对应的属性值。搜索完成

成功解决Selenium 中116版本的chromedriver找不到问题

Selenium 中的Google(谷歌浏览器)最新版本chromedriver解决方案。116版本。驱动打开网址发现最新的版本停止在了114版本的解决方法。

Flask 单元测试

单元测试是软件测试的一种类型。顾名思义,单元测试的对象是程序中的最小的单元,可以是一个函数,一个类,也可以是它们的组合。相对于模块测试、集成测试以及系统测试等高级别的测试,单元测试一般由软件开发者而不是独立的测试工程师完成,且具有自动化测试的特质,因此单元测试也属于自动化测试。在实际开发中,有一些测

安装Pycharm的13个步骤,还不会嘛?(超级详细教程)

Jetbrains家族和Pycharm版本划分:pycharm是Jetbrains家族中的一个明星产品,Jetbrains开发了许多好用的编辑器,包括Java编辑器(IntelliJ IDEA)、JavaScript编辑器(WebStorm)、PHP编辑器(PHPStorm)、Ruby编辑器(Rub

Python实现简单的爬虫功能

本文介绍了如何使用Python实现简单的爬虫功能,包括导入必要的库和模块、发送HTTP请求、解析HTML文件、存储数据等步骤。通过本文的学习,相信读者已经掌握了基本的爬虫技术和实现方法。需要注意的是,在实际应用中,需要遵守相关法规和道德准则,不得进行未经授权的信息获取和使用。

快速找到离群值的三种方法

本文将介绍3个在数据集中查找离群值的Python方法

【爬虫】5.6 Selenium等待HTML元素

任务目标创建Ajax网站创建服务器程序Selenium XX 等待1. Selenium强制等待2. Selenium隐性等待3. Selenium循环等待4.Selenium显示等待等待方法

Selenium 更新版本

Selenium 更新版本

自动化神器Playwright快速上手指南

(3) Selenium基于HTTP协议(单向通讯),Playwright基于Websocket(双向通讯)可自动获取浏览器实际情况。(1)安装Playwright依赖库(Playwright支持Async\Await语法,故需要Python3.7+)(2)安装Chromium、Firefox、We

python selenium如何带cookie访问网站

from selenium import webdriver # 使用Chrome浏览器 driver = webdriver . Chrome() # 或者使用Firefox浏览器 # driver = webdriver.Firefox()使用# 创建一个Cookie字典cookie = {'d

【深度相机D435i】Windows+Ubuntu下调用D435i利用Python读取、保存RGB、Depth图片

最近组里面的项目需要用到D435i深度相机采集深度图片,所以记录一下在Windows+Ubuntu的环境下使用D435i深度相机的流程,以及如何利用python读取、保存常见的RGB、Depth图片。提示:以下是本篇文章正文内容,下面案例可供参考D435i 在小巧外形中采用英特尔模块和视觉处理器,是

网络爬虫-----爬虫的分类及原理

比如用户在百度搜索引擎上检索对应关键词时,百度将对关键词进行分析处理,从收录的网页中找出相关的再根据一定的排名规则进行排序后展现给用户,那么就需要尽可能多的互联网的优质网页。增量式更新指的是再更新的时候只更新改变的地方,而为改变的地方则不更新,所以该爬虫。取出待抓取URL,解析DNS得到主机的IP,

【python】 安装浏览器驱动器

使用Selenium模块需要安装浏览器驱动程序,不同的浏览器的驱动程序不一样,以Chrome为例,Chrome的驱动程序为ChromeDriver。

selenium 自动化测试——环境搭建

然后找到对应的webdriver文件下载,完成后将该驱动放到 /usr/local/bin下即可。执行过程中,你会发现执行到第4行时会报错,那是因为没有下载对应的浏览器驱动,然后尝试第一次使用selenium 完成一个简单的测试自动化脚本。安装python,并且使用pip命令安装 selenium。

请求数据通过URL加入sign验证加密与解密

通过生成sign对网络请求进行加密的算法案例分析

网络爬虫相关概念

如果我们把互联网比作一张大的蜘蛛网,那一台计算机上的数据便是蜘蛛网上的一个猎物,而爬虫程序就是一只小蜘蛛,沿着蜘蛛网抓取自己想要的数据。解释1:通过一个程序,根据Url(http://www.taobao.com)进行爬取网页,获取有用信息。解释2:使用程序模拟浏览器,去向服务器发送请求,获取响应信

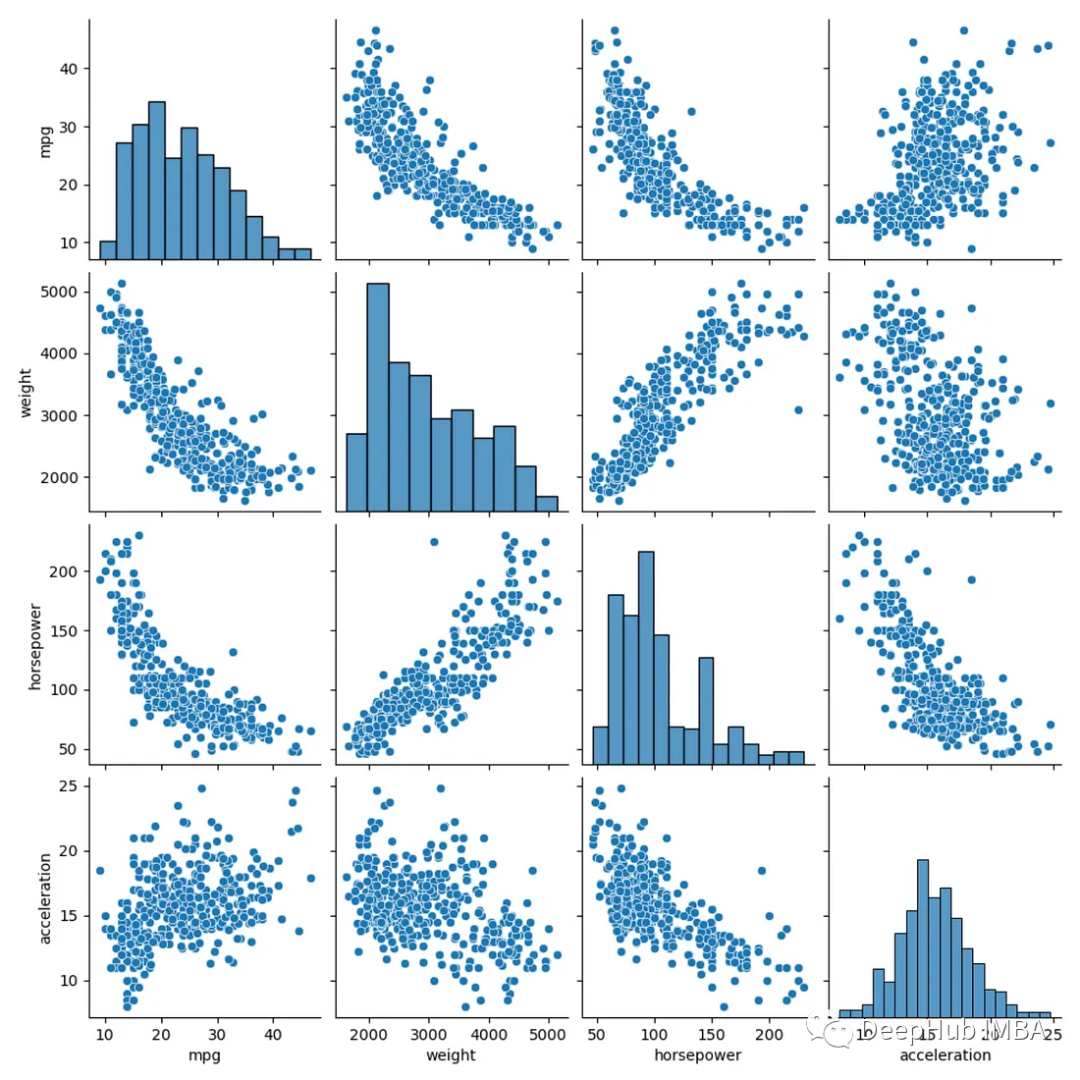

在Python中创建相关系数矩阵的6种方法

相关系数矩阵(Correlation matrix)是数据分析的基本工具。它们让我们了解不同的变量是如何相互关联的。在Python中,有很多个方法可以计算相关系数矩阵,今天我们来对这些方法进行一个总结