ChatGPT介绍,与BERT区别及在公司使用方向

ChatGPT介绍,与BERT区别及在公司使用方向

Bert 得到中文词向量

通过bert模型得到中文词向量

深度学习之文本分类总结

一、文本分类概况二、文本分类的发展三、文本分类常用的模型结构四、文本分类模型实际中遇到的问题(Q&A)

【关系抽取】基于Bert的信息抽取模型CasRel

文章目录 关系提取是一项自然语言处理 (NLP) 任务,旨在提取实体(例如,比尔盖茨和微软)之间的关系(例如,创始人)。例如,从句子 比尔盖茨创建了微软 中,我们可以提取关系三元组 (比尔盖茨, 创始人, 微软)。关系提取是自动知识图谱构建中的一项关键技术。通过关系抽取,我们可以累积抽取新的关系实体

如何将 Git 托管项目中的所有本地更改恢复到以前的状态?

我运行了 git status,它告诉我一切都是最新的,并且没有本地更改。然后我连续做了几次改变,意识到我想把所有的东西都扔掉,回到我原来的状态。这个命令会为我做吗?

如何计算Bert模型的参数量

如何计算Bert模型的参数量

猿创征文|信息抽取(2)——pytorch实现Bert-BiLSTM-CRF、Bert-CRF模型进行实体抽取

猿创征文|信息抽取(2)——pytorch实现Bert-BiLSTM-CRF、Bert-CRF模型进行实体抽取

基于BERT的自然语言处理垃圾邮件检测模型

在我们日常的网络通信中,垃圾邮件成为了我们必须要面对的问题之一。传统的垃圾邮件检测模型需要使用手动设计的规则和特征进行分类,但这种方法在复杂的邮件分类任务上表现并不理想。随着自然语言处理技术的不断发展,利用深度学习技术进行垃圾邮件检测的方法也变得越来越普遍。本文将介绍基于BERT的自然语言处理垃圾邮

【Python】Transformers加载BERT模型from_pretrained()问题解决

本文分享Transformers加载BERT模型的系列问题解决,错误围绕着from_pretrained()展开

bert 的输出格式详解

输出是一个元组类型的数据 ,包含四部分,last hidden stateshape是(batch_size, sequence_length, hidden_size),hidden_size=768,它是模型最后一层输出的隐藏状态pooler_output:shape是(batch_size,

bert-bilstm-crf提升NER模型效果的方法

在使用bert或者其它预训练模型进行微调,下接其它具体任务相关的模块时,会面临这样一个问题,bert由于已经进行了预训练,参数已经达到了一个较好的水平,如果要保持其不会降低,学习率就不能太大,而下接结构是从零开始训练,用小的学习率训练不仅学习慢,而且也很难与BERT本体训练同步。如果学习率过小,梯度

详细介绍BERT模型

BERT通过在所有层中联合调节左右语境,从未标记的文本中预训练深度双向表征。因此,预训练的BERT模型可以通过一个额外的输出层进行微调,以创建最先进的模型,用于更广泛的任务,而无需对特定任务的架构进行大量修改。

【实战篇】是时候彻底弄懂BERT模型了(收藏)

如何弄懂BERT模型,当然是理论+实战了。本文就告诉大家如何实战BERT模型。

NLP进阶,Bert+BiLSTM情感分析实战

Bert+BiLSTM做情感分析情感分析情感分析一类的任务比如商品评价正负面分析,敏感内容分析,用户感兴趣内容分析、甚至安全领域的异常访问日志分析等等实际上都可以用文本分类的方式去做,情感分析的问题本质是个二分类或者多分类的问题。什么是Bert?BERT的全称为Bidirectional Encod

基于 BERT 实现的情感分析(文本分类)----概念与应用

一文详解Bert的发展由来,及如何使用Bert模型实现情感分析(文本分类任务)

BERT详解:概念、原理与应用

对bert的原理,结构,预训练过程进行介绍

BERT详解:概念、原理与应用

对bert的原理,结构,预训练过程进行介绍

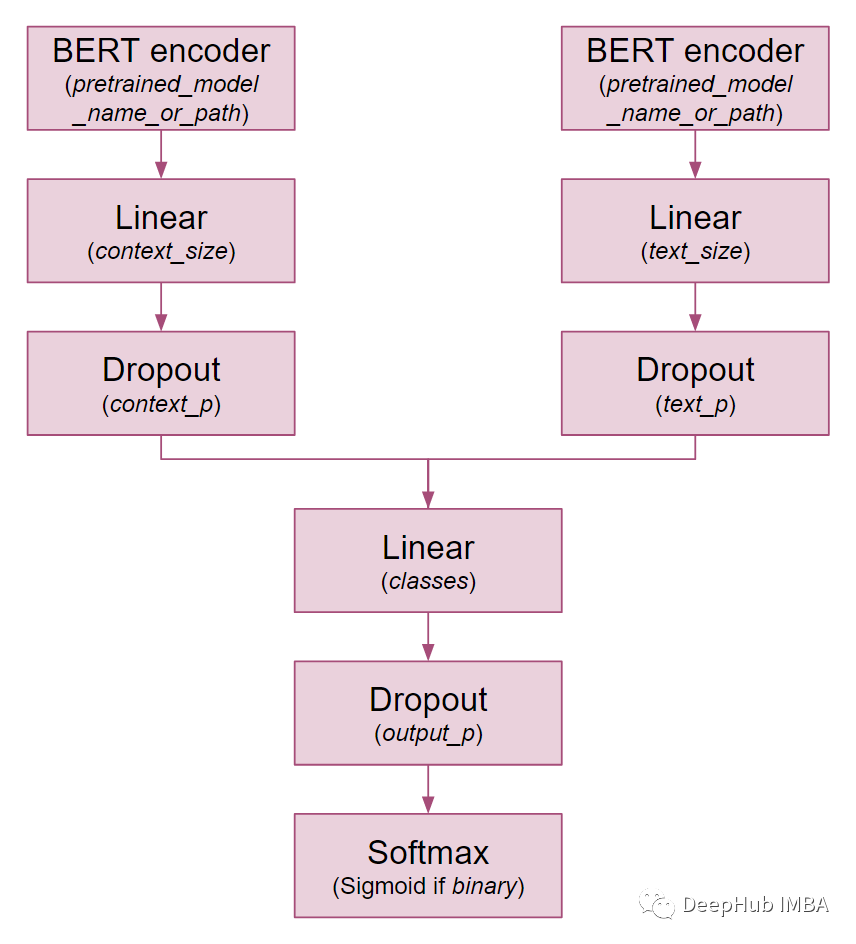

TwoModalBERT进行角色分类

魔改模型,不一定有用,但很好玩

BERT模型解析

BERT模型的提出对于NLP预训练的效果有了较大提升,在ELMo模型的基础上使用了Self-Attention作为文本特征的挖掘,同时避免了GPT模型中的单向语言模型,充分利用文本中的上下文特征。

图解BERT、ELMo(NLP中的迁移学习)| The Illustrated BERT, ELMo, and co.

2018年是NLP模型发展的转折点。我们不断探索单词和句子的表示方法,以求能最好地捕捉其中潜在的语义和关系。此外,NLP领域已经提出了一些功能强大的组件,你可以免费下载,并在自己的模型和pipeline中使用它们(这被称为NLP领域的ImageNet时刻,类似的发展在几年前也是这么加速计算机视觉领域