第十四课:理解自注意力机制和Transformer模型

第十四课:自注意力机制和Transformer

1. 自注意力机制简介

自注意力机制(Self-Attention)是一种允许输入序列中的每个位置都与其他所有位置交互以计算表示的机制。它是Transformer架构的核心,被广泛应用于自然语言处理(NLP)和计算机视觉(CV)等领域。

自注意力机制的计算

给定一个序列(X)(例如,一个句子中的单词序列),自注意力通过以下步骤计算序列中每个元素的新表示:

- 查询(Query)、键(Key)和值(Value):首先,对于序列中的每个元素,使用三个不同的权重矩阵将其映射到查询向量(Q)、键向量(K)和值向量(V)。

- 注意力分数(Attention Scores):然后,计算每对元素之间的注意力分数,这通常是通过计算查询向量与键向量的点积来实现的:[ \text{Attention}(Q, K, V) = \text{softmax}\left(\frac{QK^T}{\sqrt{d_k}}\right)V ]其中,(d_k)是键向量的维度,这个缩放因子有助于训练稳定性。

- 输出:最后,使用softmax函数对注意力分数进行归一化,然后用它们对值向量进行加权求和,得到每个位置的最终输出。

2. Transformer模型

Transformer模型由Vaswani等人在2017年提出,是第一个完全基于自注意力机制来处理序列数据的模型。它摒弃了之前常用的循环网络结构,通过自注意力机制有效地捕获序列内的长距离依赖。

- Transformer架构:主要包括编码器(Encoder)和解码器(Decoder)两部分,每部分由多个相同的层堆叠而成。每一层都包含一个自注意力子层和一个前馈神经网络子层。

3. Transformer在NLP中的应用

Transformer模型及其变体(如BERT、GPT等)已成为NLP领域的核心技术,用于文本分类、语言模型、机器翻译、问答系统等多种任务。

4. 动手实践:探索Transformer模型

由于Transformer模型较为复杂,这里我们将使用TensorFlow的高级API来探索一个预训练的Transformer模型(如BERT或GPT):

from transformers import TFAutoModelForSequenceClassification, AutoTokenizer

import tensorflow as tf

# 加载预训练模型和分词器

model_name ='bert-base-uncased'

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = TFAutoModelForSequenceClassification.from_pretrained(model_name)# 准备输入数据

inputs = tokenizer("Hello, my dog is cute", return_tensors="tf")# 进行预测

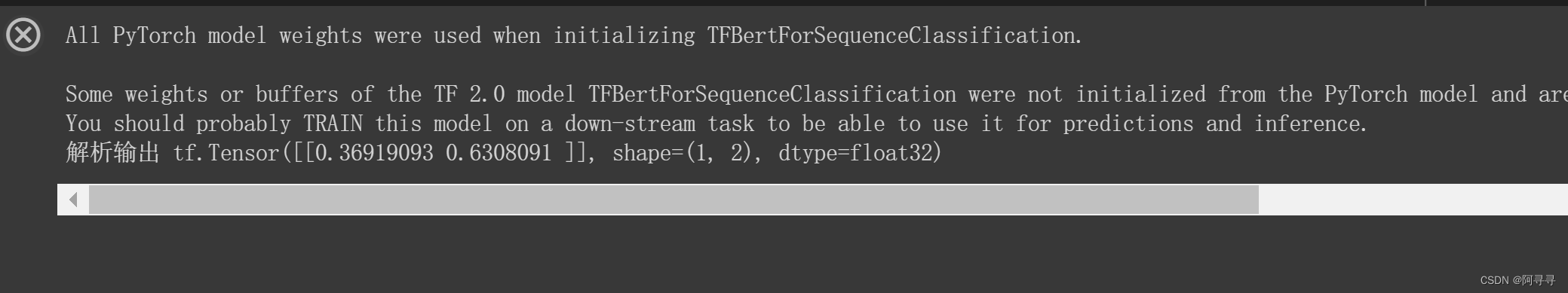

outputs = model(inputs)# 解析输出

predictions = tf.nn.softmax(outputs.logits, axis=-1)print(predictions)

请注意,使用

transformers

库需要先安装它,你可以通过

pip install transformers

来安装。

结语

自注意力机制和Transformer架构为处理复杂的序列数据问题开辟了新的可能性。通过深入学习这些概念和技术,你将能够利用最先进的模型来解决自然语言处理和计算机视觉等领域

的挑战性问题。

希望这第十四课能够帮助你理解自注意力机制和Transformer模型的基本原理,并激发你继续探索深度学习领域的兴趣。继续前行,探索更多知识,实践更多项目,你将在人工智能的旅程上取得更大的成就!

版权归原作者 阿寻寻 所有, 如有侵权,请联系我们删除。