目录

一、前言

我们在此前的名叫python+opencv实现人脸微整形博文里已经简单地实现了人脸图像的微形变,为人脸驱动一个虚拟人脸提供了一些基础,但是运行性能上面需要优化,因为要想用人脸特征点实时驱动,需要非常快速的响应时间。目前国内外高等院校利用深度学习、生成神经网络等技术取得了较大的进展,由于神经网络需要耗费大量的算力,动则需要1万元以上的显卡3块并训练3个星期,不是个人能玩得,本篇试图利用简单图像处理原理继续深入探究人脸驱动应用,作一下入门级研究,目标是基于人脸识别出的特征点(如眉毛、眼睛、嘴唇)并计算相机的相对于人脸的朝向,简单实现真人脸微表情驱动一张虚拟人脸,虚拟人脸可以是一个二次元人脸、一个卡通脸或者是另一个AI生成的真人脸。

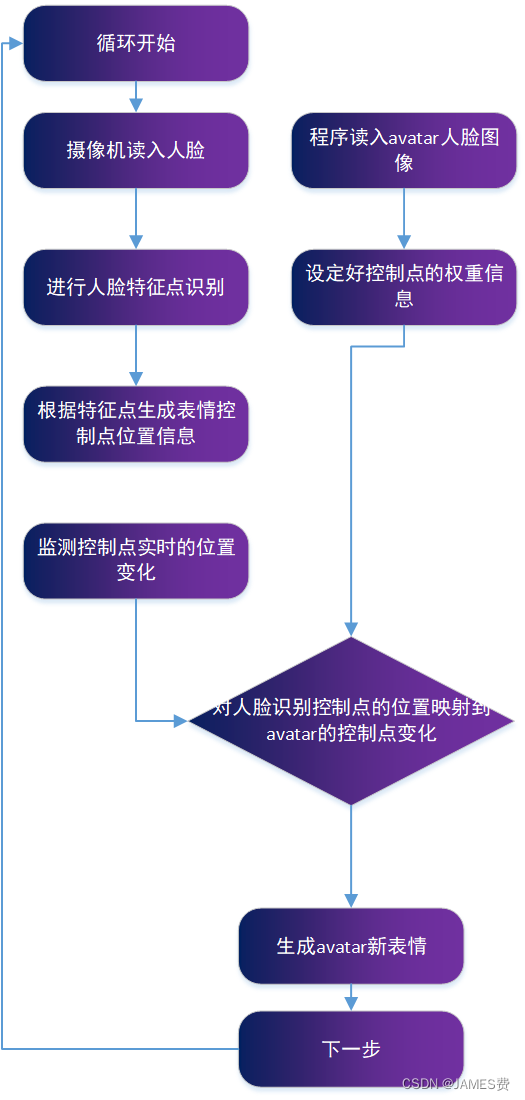

二、技术路线

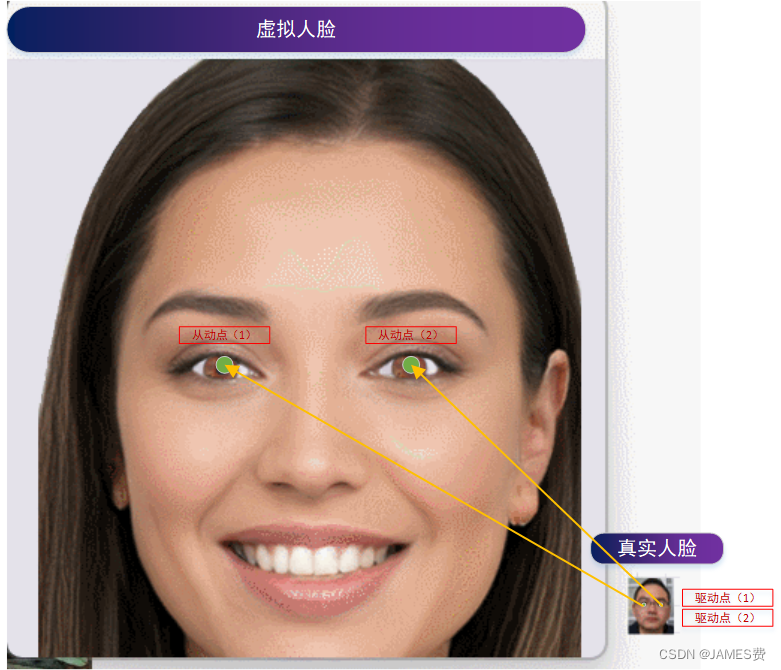

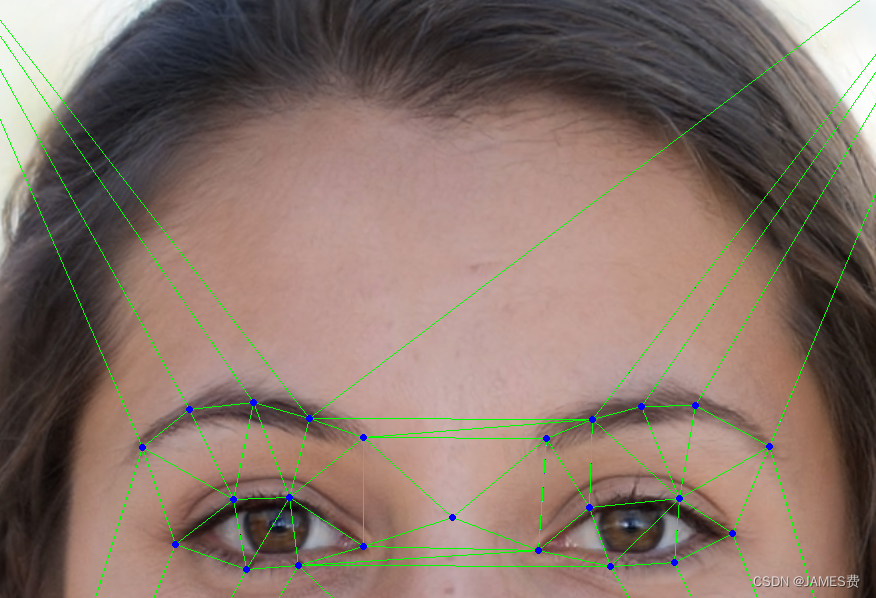

如上图所示,主要技术路线是:首先,通过摄像头实时捕捉人脸,并通过人脸识别软件模块获取真实人脸得特征点(如下图):

然后将特征点映射至数字人得对应特征点上,形成运动的主从运动映射(即,主动特征点产生偏移dx、dy,那么从动点也使得发生偏移),这样就实现了人脸驱动的功能,如下图的人眼球运动,通过人脸检测,获取眼球的位置点作为驱动点,当眼球发生偏移,数字人从动点眼睛也发生变化了。

三、主要技术点分析

虽然以上的技术路线看起来比较简单,但是我们通过前期的测试发现,要可靠的运行,还存在一些比较底层的问题需要优化或者解决,主要包括:

(1) 人脸识别模块特征点的漂移

人脸识别模块我们可以通过多种开源程序获得,这里我们使用的是python库——face_recognition,识别较为准确,但是识别出的特征点存在飘逸,如果直接将模块识别出的特征点映射到阿凡达从动点,会出现随机微小的抖动,显得非常的不自然。

我们主要采用设置时间窗口,并进行均值计算,在不牺牲实时性的前提下用平均值代替瞬时值,起到了一定的滤波效果。后续再碰到此来问题,还将尝试其它消除稳定性的算法,本次代码部分如下:

if firstloop and ticktak<6:#时间周期设为5个循环时间

rig_center_xs0.append(rig_center_x)

rig_center_ys0.append(rig_center_y)if firstloop and ticktak>=6:#大于5个周期,为下一个间隔数据

rig_center_xs.append(rig_center_x)

rig_center_ys.append(rig_center_y)if ticktak>10:

ticktak=0

screen.blit(bg_img,(0,0))

count=0whilelen(rig_center_xs0):#计算k-1间隔平均值

count+=1

rig_center_x0=rig_center_x0+rig_center_xs0.popleft()

rig_center_y0=rig_center_y0+rig_center_ys0.popleft()

rig_center_x0=int(rig_center_x0/count)

rig_center_y0=int(rig_center_y0/count)

count=0whilelen(rig_center_xs):#计算k间隔平均值

count+=1

rig_center_x1=rig_center_x1+rig_center_xs.popleft()

rig_center_y1=rig_center_y1+rig_center_ys.popleft()

rig_center_x1=int(rig_center_x1/count)

rig_center_y1=int(rig_center_y1/count)#计算两个窗口期的偏移量,用于驱动数字人对应从动点

deyesx=rig_center_x1-rig_center_x0

deyesy=rig_center_y1-rig_center_y0

(2) 柔性运动与刚性运动的处理

同一视角下,人脸的运动点可以认为是刚性运动+柔性运动的组合结果。所谓的刚性运动,是运动部位不产生自身的形变,人脸上眼球、牙齿、鼻子、耳朵等的运动可以认为是刚性的运动;所谓柔性运动,这里指的是运动的部位产生了形变、弯曲、拉扯等,如表情中眉毛的微微变形、嘴巴的张大缩小、眼睛的睁大等。

在此前的博文中我们采用“控制点位置变化来影响周边的像素点的变化”的原理来实现局部的变形,但是由于需要便利所有的像素点计算量比较大,实际生成应用存在一定的性能瓶颈。受到linve2d技术(一种应用于电子游戏的绘图渲染技术)的启发,可以应用可自定义的三角剖分,加上局部仿射变换进行所控图像的任意柔性变形!主要解决的思路如下:

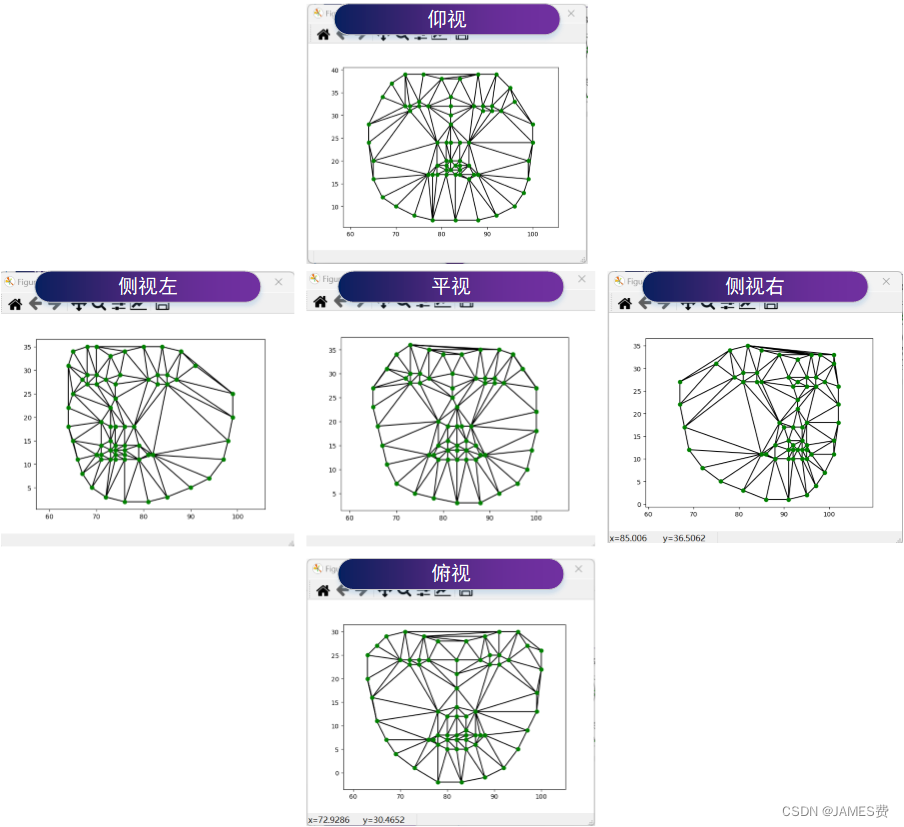

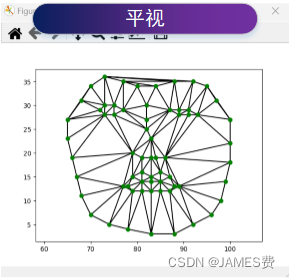

setp1 基于人脸特征点的三角剖分

首先我们根据人脸识别模块获得正面人脸的特征点,并利用三角剖分算法对人脸进行三角分割:

然后在数字人中自定义映射点,并根据所得到的剖分也进行三角形分割。

这样就实现了一一对应,当然这个工作需要做细致,并进行反复的调试。

setp2 基于三角映射的仿射变换

这一步是要根据所得到的三角,对每个三角部分进行前后帧的仿射变换,我们可以利用opencv自带的工具进行计算,先计算仿射变换矩阵,再利用cv2.warpAffine进行变换:

# 计算仿射阵

WMat = cv2.getAffineTransform( np.float32(tri1), np.float32(tri2))# 根据仿射阵计算目标图像

img2Cropped = cv2.warpAffine( img1, WMat,(r2[2], r2[3]),None, flags=cv2.INTER_LINEAR, borderMode=cv2.BORDER_REFLECT_101 )

这样将所有的三角块都遍历一遍,就完成了整个人脸的柔性变形!

(3) 正脸转侧脸的处理

由于我们入门级的数字人只是一个二维的正脸图像,没有三维的信息,如何让她动起来(左右微微摇头),从而产生更加仿真的结果。这块未经过测试,在本篇先不予以说明,待测试完后在后续博文中发出。

四、小结

上篇就到此浅尝则至了,以上所描述的技术我们一步一步敲代码,运行测试调试,用python已经写到了730行,这可能仅仅只是开始,过程非常耗时间,当完成一个初步应用后,我们打算把这个程序开源,希望得到更多人的助力。

版权归原作者 JAMES费 所有, 如有侵权,请联系我们删除。