Adam

adam优化器是经常使用到的模型训练时的优化器,但是在bert的训练中不起作用,具体表现是,模型的f1上不来。

AdamW

简单来说,AdamW就是Adam优化器加上L2正则,来限制参数值不可太大

以往的L2正则是直接加在损失函数上,比如这样子:

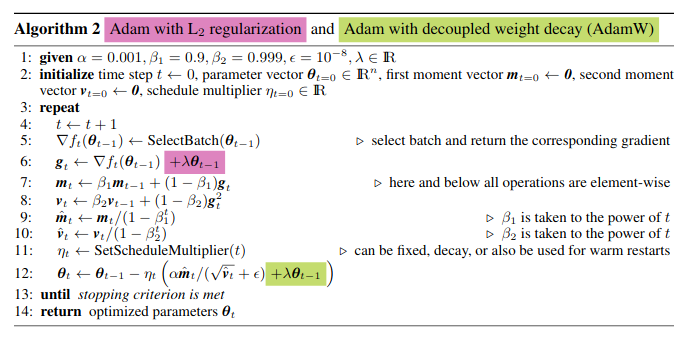

但AdamW稍有不同,如下图所示:

粉色部分,为传统L2正则施加的位置;而AdamW,则将正则加在了绿色位置。

结论

Adamw 即 Adam + weight decate ,效果与 Adam + L2正则化相同,但是计算效率更高,因为L2正则化需要在loss中加入正则项,之后再算梯度,最后在反向传播,而Adamw直接将正则项的梯度加入反向传播的公式中,省去了手动在loss中加正则项这一步

更多可参考:

https://blog.csdn.net/yinyu19950811/article/details/90476956

https://blog.csdn.net/real_ilin/article/details/108438089

https://blog.csdn.net/weixin_45743001/article/details/120472616

版权归原作者 hazel爱吃肉 所有, 如有侵权,请联系我们删除。