需要全部代码请点赞关注收藏后评论区留言私信~~~

下面列举通过余弦相似度公式和标准库分别计算不同文本信息相似度的实例,首先需要对中文进行分词,通过jieba导入分词库文件,使用Python标准库计算相似度,导入两种不同的相似度计算库difflib和fuzz,除此之外,还自定义了基于余弦相似度公式的相似度计算方法

接着定义余弦相似度计算函数,函数参数部分传入需要比较的两个文本信息,先对文本进行向量化处理,dot计算出两个向量之间的点积,即相同维度上的值的乘积和,如果A和B是同一个向量,则求出的是欧几里得距离平方,余弦相似度函数返回的是根据余弦相似度计得出的结果 代码如下

# 余弦相似度

def similarity(text1, text2):

cos_text1 = (Counter(text1))

cos_text2 = (Counter(text2))

similarity_text1 = []

similarity_text2 = []

for i in set(text1 + text2):

similarity_text1.append(cos_text1[i])

similarity_text2.append(cos_text2[i])

similarity_text1 = np.array(similarity_text1)

similarity_text2 = np.array(similarity_text2)

return similarity_text1.dot(similarity_text2) / (np.sqrt(similarity_text1.dot(similarity_text1)) * np.sqrt(similarity_text2.dot(similarity_text2)))

接下来定义停用词信息,停用词信息可以根据实际需要灵活调整,并定义需要比较的文本信息

停用词就是比较的时候不考虑他们

#停用词

stopwords = {}.fromkeys([',', '。', ';',':'])

text1 = "新冠疫情对世界产生了深刻影响,人们更注重保持社交距离。"

text2 = "新冠疫情对世界影响很大,但很多人仍然不注意保持社交距离。"

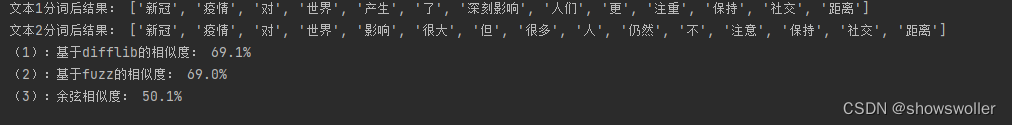

最后根据不同标准库以及余弦相似度计算得出结果 结果近似到小数点后面三位,并计算转换成百分数表达的余弦相似度值

最后 代码如下

#jieba分词

import jieba

#Python标准库计算相似度

import difflib

#Python标准库计算相似度

from fuzzywuzzy import fuzz

import numpy as np

from collections import Counter

# 余弦相似度

def similarity(text1, text2):

cos_text1 = (Counter(text1))

cos_text2 = (Counter(text2))

similarity_text1 = []

similarity_text2 = []

for i in set(text1 + text2):

similarity_text1.append(cos_text1[i])

similarity_text2.append(cos_text2[i])

similarity_text1 = np.array(similarity_text1)

similarity_text2 = np.array(similarity_text2)

return similarity_text1.dot(similarity_text2) / (np.sqrt(similarity_text1.dot(similarity_text1)) * np.sqrt(similarity_text2.dot(similarity_text2)))

#停用词

stopwords = {}.fromkeys([',', '。', ';',':'])

text1 = "新冠疫情对世界产生了深刻影响,人们更注重保持社交距离。"

text2 = "新冠疫情对世界影响很大,但很多人仍然不注意保持社交距离。"

text1_cut = [i for i in jieba.cut(text1, cut_all=False) if i != '' and i not in stopwords]

text2_cut = [j for j in jieba.cut(text2, cut_all=False) if j != '' and j not in stopwords]

# jieba分词并去除停用词

print('文本1分词后结果:', text1_cut)

print('文本2分词后结果:', text2_cut)

zz=str(round(fuzz.ratio(text1, text2)/100,3)*100)+"%"

sim_cos=str(round(similarity(text1_cut, text2_cut),3)*100)+"%"

print('(1):基于difflib的相似度:', sim_diff)

print('(2):基于fuzz的相似度:', sim_fuzz)

print('(3):余弦相似度:', sim_cos)

创作不易 觉得有帮助请点赞关注收藏~~~

版权归原作者 showswoller 所有, 如有侵权,请联系我们删除。