GLM-4-9B 是智谱 AI 推出的最新一代预训练模型 GLM-4 系列中的开源版本。 在语义、数学、推理、代码和知识等多方面的数据集测评中,GLM-4-9B 及其人类偏好对齐的版本 GLM-4-9B-Chat 均表现出较高的性能。 除了能进行多轮对话,GLM-4-9B-Chat 还具备网页浏览、代码执行、自定义工具调用(Function Call)和长文本推理(支持最大 128K 上下文)等高级功能。 本代模型增加了多语言支持,支持包括日语,韩语,德语在内的 26 种语言。我们还推出了支持 1M 上下文长度(约 200 万中文字符)的模型。

模型下载

首先在githup上下载GLM4的模型:GitHub - THUDM/GLM-4: GLM-4 series: Open Multilingual Multimodal Chat LMs | 开源多语言多模态对话模型

我是在云服务器上(算力云)推理的GLM4:

最好是单张4090(3090也可以)

在魔塔社区下载模型:首页 · 魔搭社区 (modelscope.cn)

根据需求而定下载哪一个模型,我这里下载的GLM-4-9b-chat

然后在你的笔记本里面下载模型

首先要下载modelscope:pip install modelscope -i(可以加一个源镜像)

from modelscope import snapshot_download

model_dir = snapshot_download('ZhipuAI/glm-4-9b-chat',cache_dir="autodl-tmp")

然后进入到GLM4文件夹下进入到basic_demo按需求运行

最低硬件要求

Python >= 3.10

内存不少于 32 GB

安装依赖

pip install -r requirements.txt

基础功能调用

除非特殊说明,本文件夹所有 demo 并不支持 Function Call 和 All Tools 等进阶用法

使用 transformers 后端代码

使用命令行与 GLM-4-9B 模型进行对话。

python trans_cli_demo.py # GLM-4-9B-Chat

python trans_cli_vision_demo.py # GLM-4V-9B

使用 Gradio 网页端与 GLM-4-9B-Chat 模型进行对话。

python trans_web_demo.py

使用 Batch 推理。

python cli_batch_request_demo.py

使用 vLLM 后端代码

使用命令行与 GLM-4-9B-Chat 模型进行对话。

python vllm_cli_demo.py

自行构建服务端,并使用 OpenAI API 的请求格式与 GLM-4-9B-Chat 模型进行对话。本 demo 支持 Function Call 和 All Tools功能。

启动服务端:

python openai_api_server.py

客户端请求:

python openai_api_request.py

压力测试

python trans_stress_test.py

运行

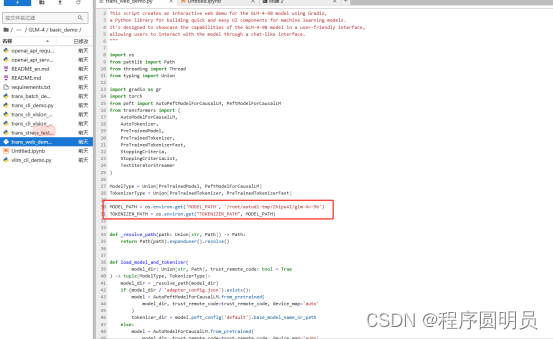

由于我只需要进入web页面,那我就只把trans_web_demo的路径换成权重,可以根据个人的需求来修改

由于我实在服务器上跑的,需要本地代理。

结语:除了glm4-9b-chat,我觉得比较有意义的智普的多模态模型的开源,这代表这AI时代又向前走了一步,希望我的文档可以对大家有所帮助,最后大家如果认可的话请点赞收藏,避免到时候需要的时候找不到,希望大家一起进步

版权归原作者 程序圆明员 所有, 如有侵权,请联系我们删除。