引

如果你也有如下问题,那么接下来的文字会一一为你解答

- 一套数据集,如何微调不同类型的开源大模型?—— Bedrock

- 如何只有产品说明书,如何构建一个智能问答机器人?—— Q

- 哪里还有免费的 GPU 算力——在线 Jupyter 平台?—— SageMaker

亚马逊云科技开发者社区为开发者们提供全球的开发技术资源。这里有技术文档、开发案例、技术专栏、培训视频、活动与竞赛等。帮助中国开发者对接世界最前沿技术,观点,和项目,并将中国优秀开发者或技术推荐给全球云社区。如果你还没有关注/收藏,看到这里请一定不要匆匆划过,点这里让它成为你的技术宝库!

发布会

亚马逊云科技 re:lnvent 发布会,在 2023 年11月底于拉斯维加圆满召开,介绍了一些云产品的升级,以及自研芯片的升级、性能提升。当然今年的重头戏就是 AI,此次升级了Bedrock服务提供了更多功能,并推出了企业级 AI 助手——Q),对于 ML 研究者,升级后的 SageMaker 提供了和 Jupyter 一致的机器学习(ML)环境。

AI 云服务

此次发布会,我最关注的亚马逊的 AI 服务,我发现它在这上面做了非常多的差异化功能,相较于 openAI,微软、Google 等 AI 云服务公司,亚马逊云的 AI,这些功能是独居特色的的:

- 保护用户隐私、不会用用户的数据来训练

- 支持定制化得模型数据

- 对 fine tunning 优化,不需要太多专业知识就能微调大模型

- 模型价格便宜,微调之后的模型成本有所提升,但依然比 GPT3 便宜。

在当前 AI 淘金潮中,亚马逊坚持做最好的——“铲子”

面向开发者

如何让普通 IT 人员也能上手 AI 产品

作者我作为后端研发,天天 CURD 做业务。对于 AI 大模型,只会用用聊天机器人,用文字描述生成图片。至于如何训练、调试大模型我是丈二和尚——摸不着头脑,大家都在聊,AI 赋能产品,作为一名普通 IT 人员,当前只能“玩玩”它,至于产品赋还把握不住。当前时间点,但凡一个降低 AI 使用门槛的工具开源,那都是 10k Star 级别的热度,例如: lang-chain, hinese-LLaMA-Alpaca, LLaMA-Factory

所以,作为普通人,是非常愿意接触 AI 的,但目前开源 AI 产品对于普通人来讲,还是有非常高的使用门槛。现在就有很多云服务商就开始做人与 AI 算法产品之间的衔接工作。

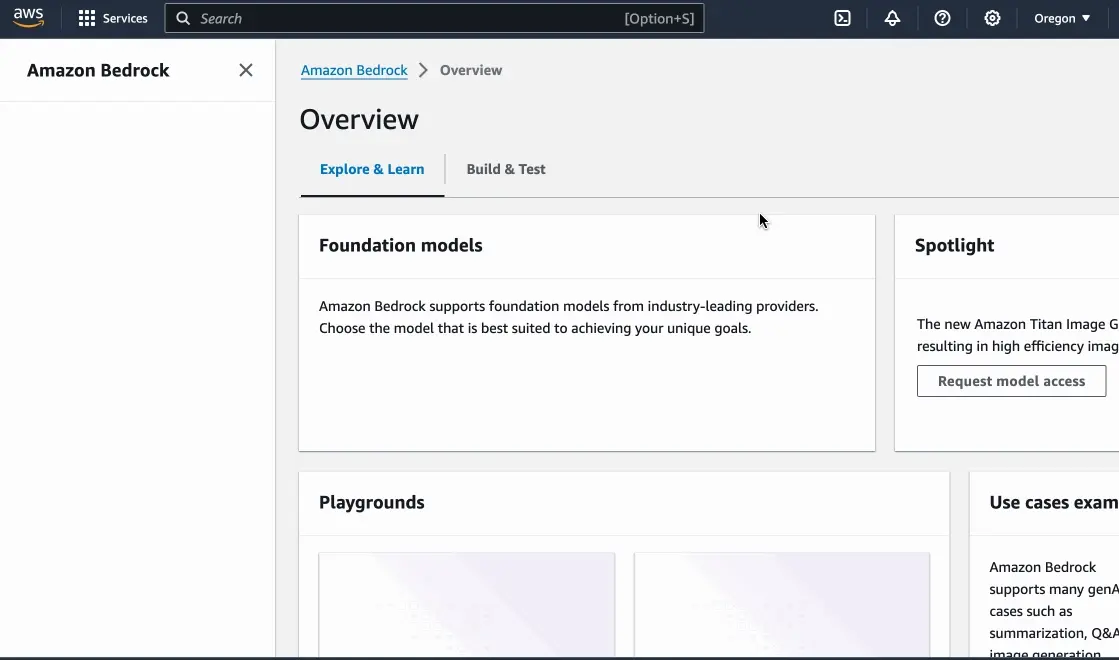

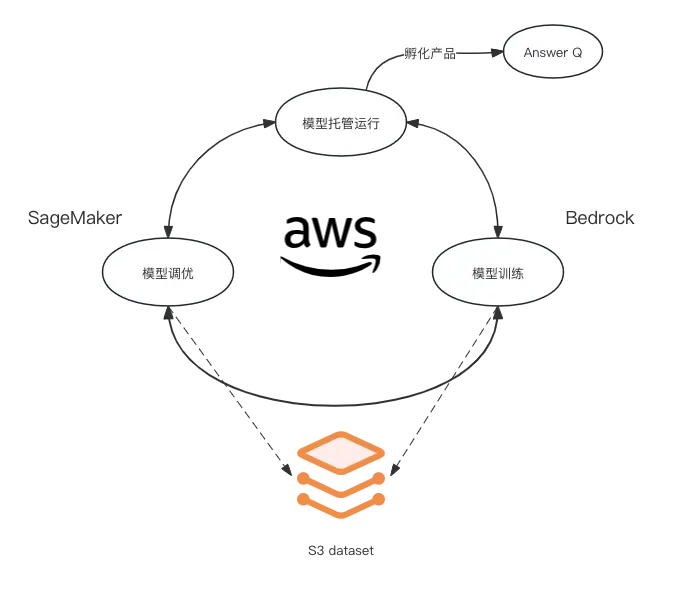

Bedrock

Bedrock – Amazon 提供一个简单的入口,让大家能够快速构建起生成式人工智能应用程序。它的能力有这几个方向:

- 文本生成

- 聊天机器人

- 向量搜索

- 文本摘要

- 图像生成

Bedrock 采用了市面上优秀开源的模型,来完成如上工作。模型有:

- Jurassic-2

- Claude

- Command

- Stable Diffusion

- Llama 2

当然亚马逊自己也研发了大模型——Titan

小试身手

我们要试用大模型,还需要申请模型权限,其实就是勾选一下。

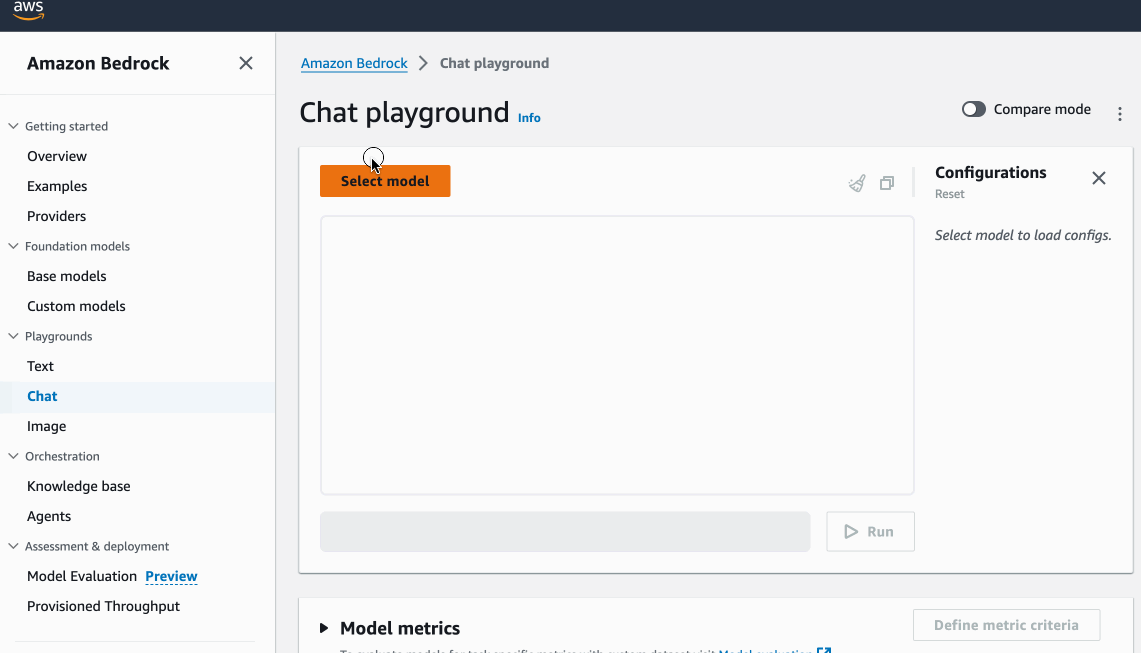

Chat 模型

这里体验了一下 LLama 2 13B, 具体使用情况如下:

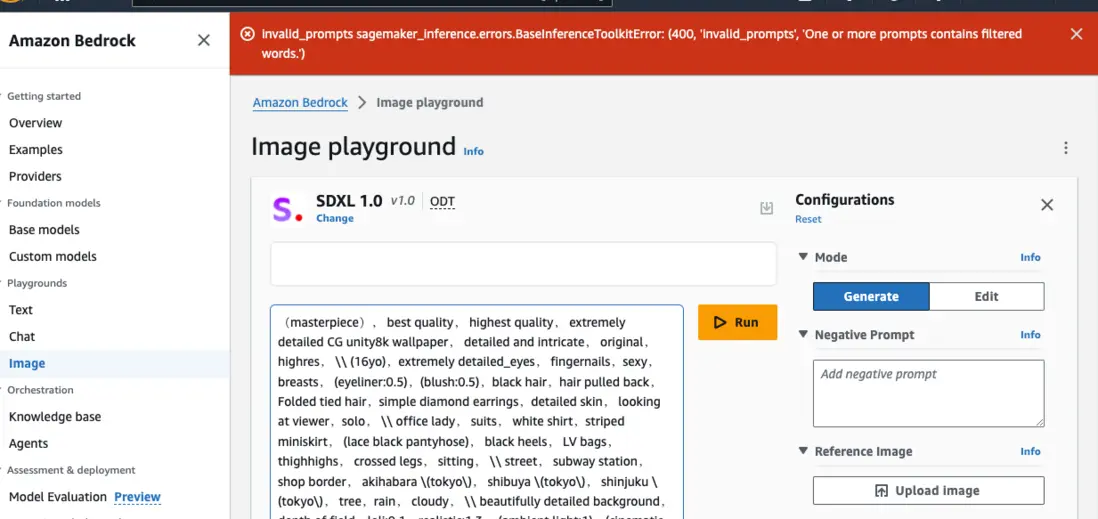

文生图

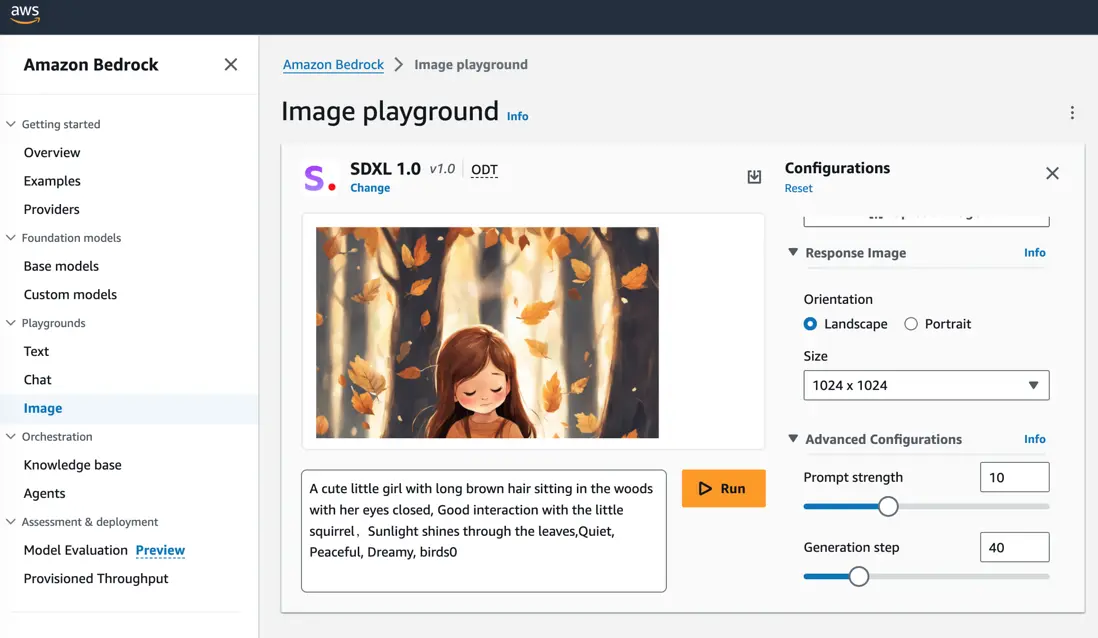

使用 SDXL 1.0 生成了一张

1024\*1024

图片,耗时 20s 左右。

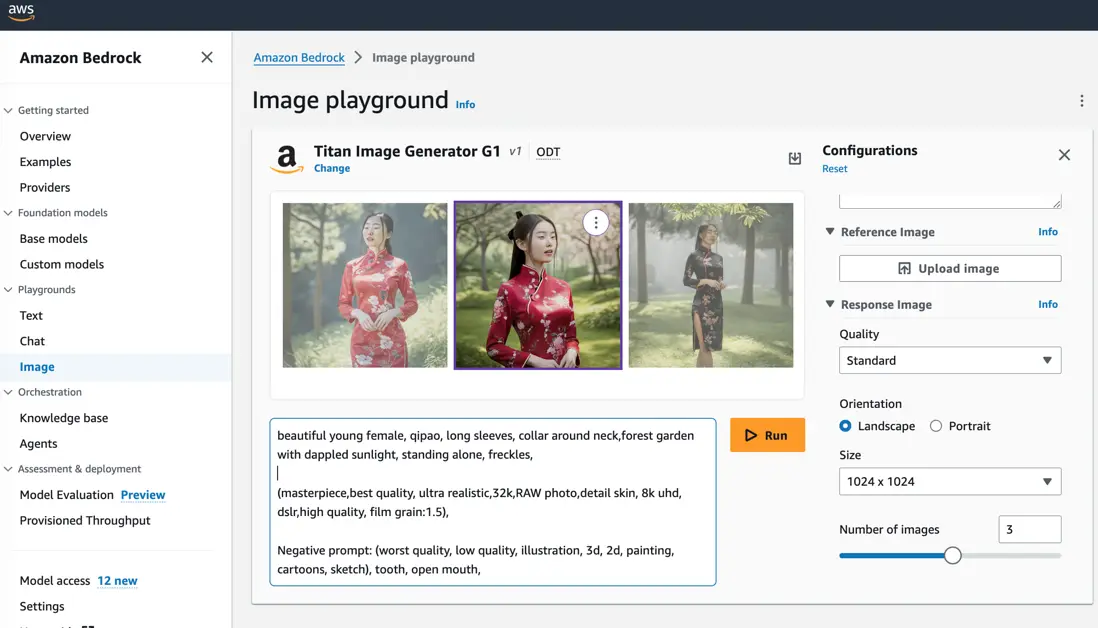

我又试用了一下 亚马逊的 Titan Image G1 模型, 同时生成了3张

1024\*1024

图,大概花了30+s

对了,如果一下生成多张图片,批量下载时会压缩成一个 zip 包再下载。但我用过后,发现这个 zip 包解不开,感觉这个压缩有问题,如果大家也遇到了,可以点开图片,一张张单独下载,就好了。关于: Amazon Bedrock Image playground,the zip of the generated image cannot be extracted

微调

相较于我们平常用的

ChatGPT3.5、4

两代通用模型, 亚马逊提供了可定制性、可微调,可以使用保存在云上语料库、知识库进行训练(fine tunning)。

也就是说你可以通过使用大量的数据微调大模型,让模型学习到新的东西,你再向模型提问时,就不需要提供冗长的上下文信息了,这样可以节约大量的 token,还能提高模型响应速度。

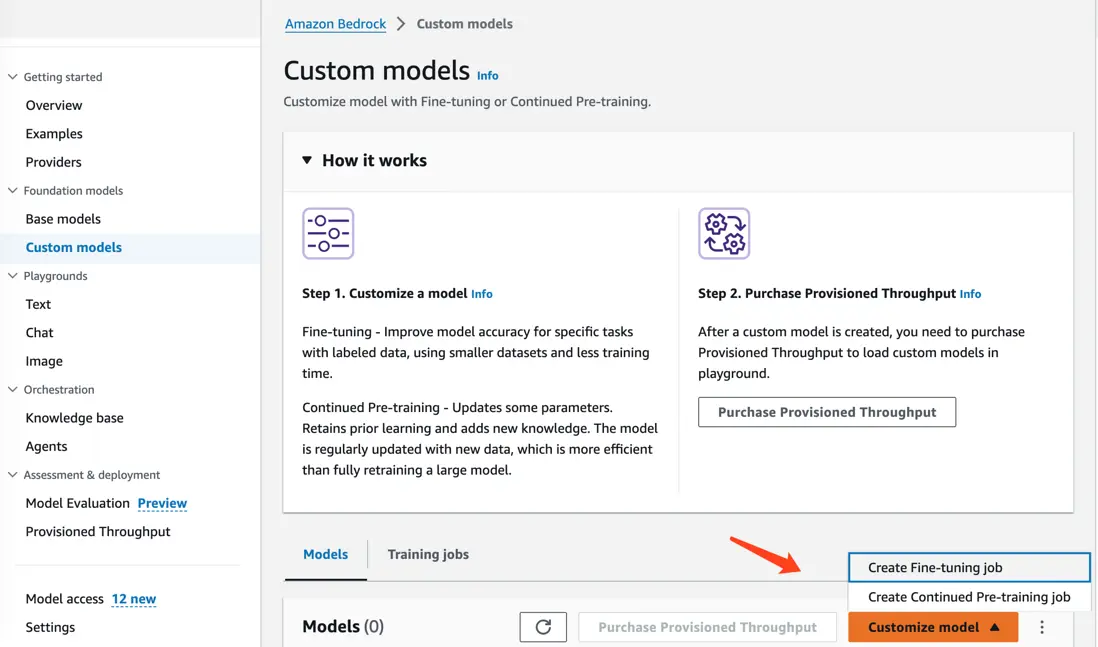

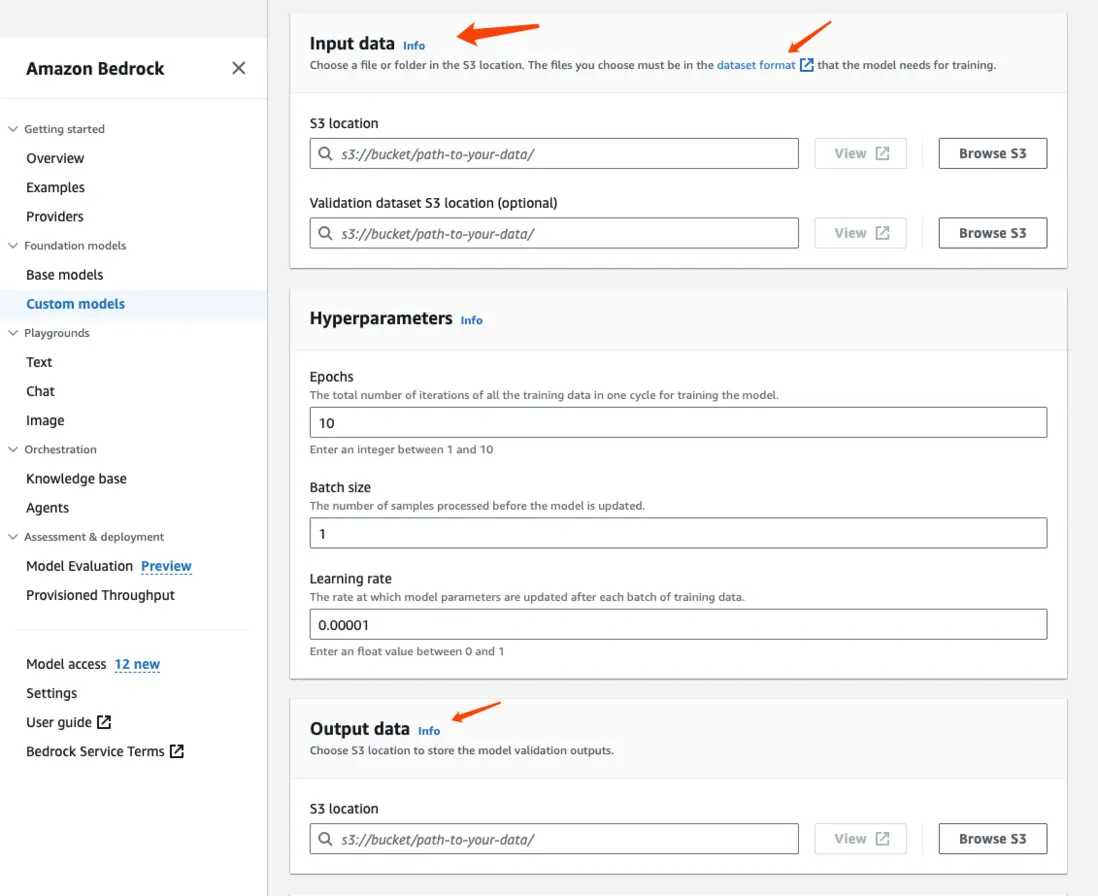

创建 Fine-tunning 任务

通过 Custom models 选择 Fine tuning job 就能

微调任务,你只需要提交数据集即可,数据集的格式,你可参看这个文档。datasetformat

这样就创建好 微调模型任务了,然后这个模型就是为你定制的,要是用这个 微调模型,还需要额外购买时间的,这个费用也不低,如果你的用量大,微调模型的性能是能抹平这部分成本的。

价格

Bedrock pricing

Meta Llama 2

按需和批量定价

模型定制(微调)的定价:

Stability AI

相较于 GPT 系列,价格要便宜很多,因为模型大小可选,通用型不如 GPT,但提供了定制、预训练、微调功能,提供更具性价比的模型服务。

优势

Bedrock

提供一站式的:多种开源大模型,以及配套的模型微调,dataset 预处理功能。在 Bedrock 你只需要熟悉一个模型的使用、调优、数据投喂功能,那么你就能使用其他所有同类型模型了,如果是自己调适多个模型,那么不同模型的 dataset 格式、调优参数都是巨大的时间成本。

在重度、商业化使用条件下,是占有成本、速度优势的。如果你有海量大模型使用请求,并且每次请求都要带上长长的上下文信息,那么不妨试试微调大模型。

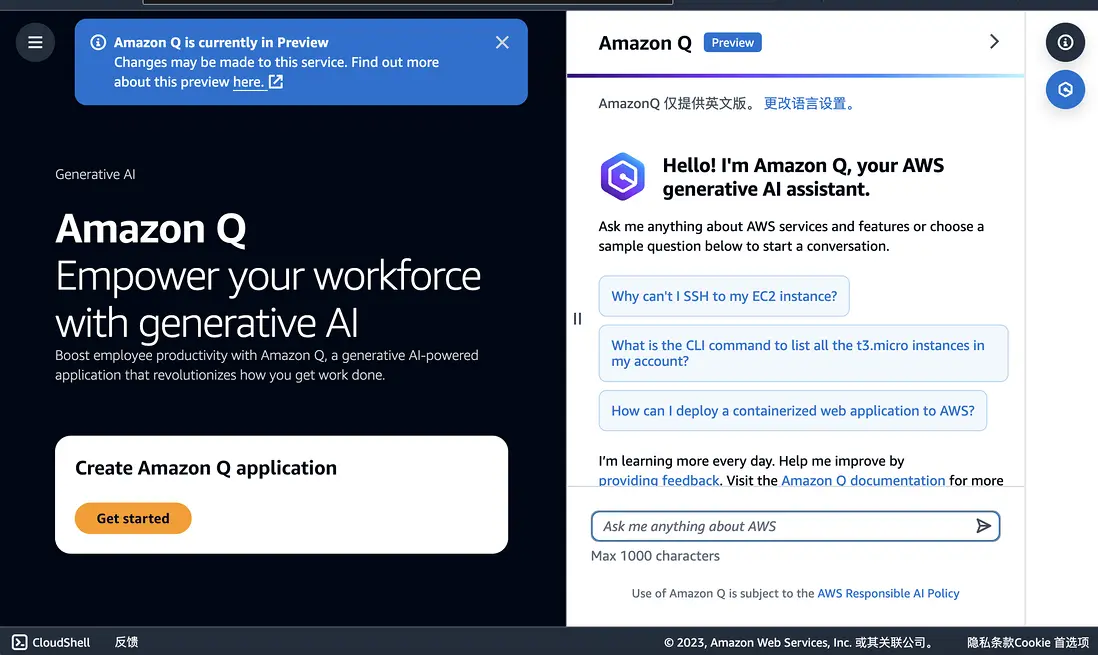

企业级 AI 助手——Q

Amazon Q 是基于 Amazon Bedrock 构建一款完全托管的生成式 AI 驱动的企业聊天助手

最近登录亚马逊后台时,我就发现 Q 已实装到亚马逊云的控制台了。是的,它的主要形态就是聊天助手。通过聊天的形式为你提供服务,就是 IM 客服。

借助 Q 的能力,能够帮助普通用户快速了解亚马逊云服务,如果可能它还会提供对应的链接地址,大家点击就能跳转到对应的页面。让一般用户在没有专业的亚马逊技术售前的协助下,也能完成一些工作,这就是为 console 平台“增效”了。

定制自己的 Q

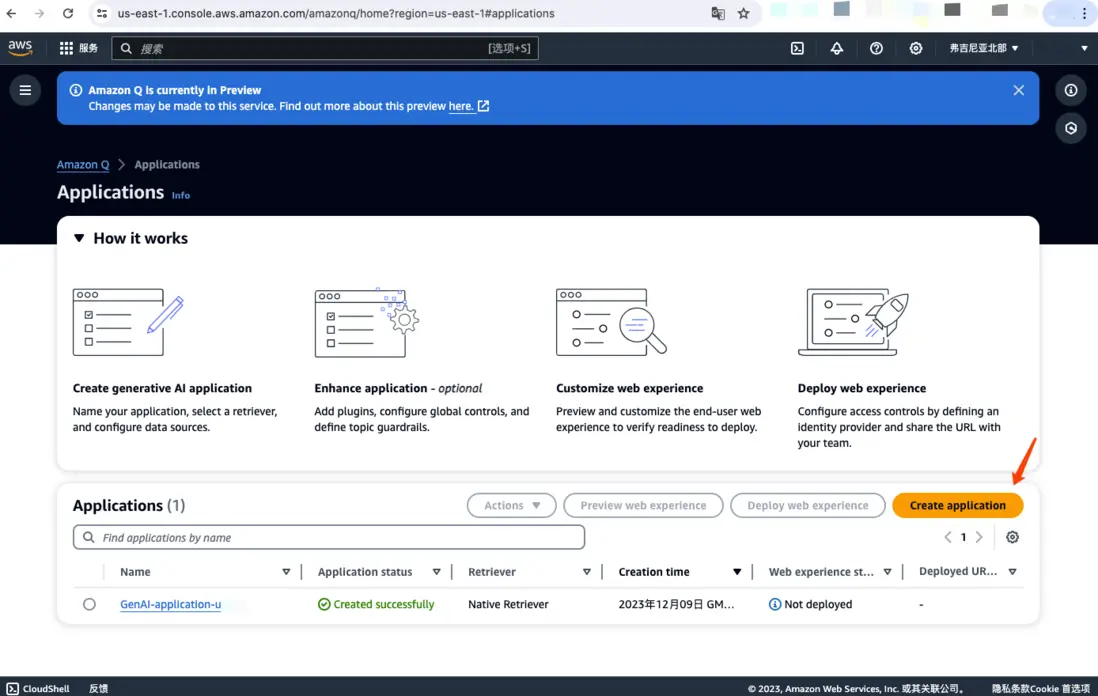

亚马逊云控制台里的 Q,可以说是 Q 的最佳实践。那么接下来,我就带大家来定制一个 IM 技术客服。

创建 应用

访问 Amazon Q 控制台, 创建一个应用

目前 Q 还是预览版,没有全球发布,所以制定地区可用,这里选的 弗吉尼亚。

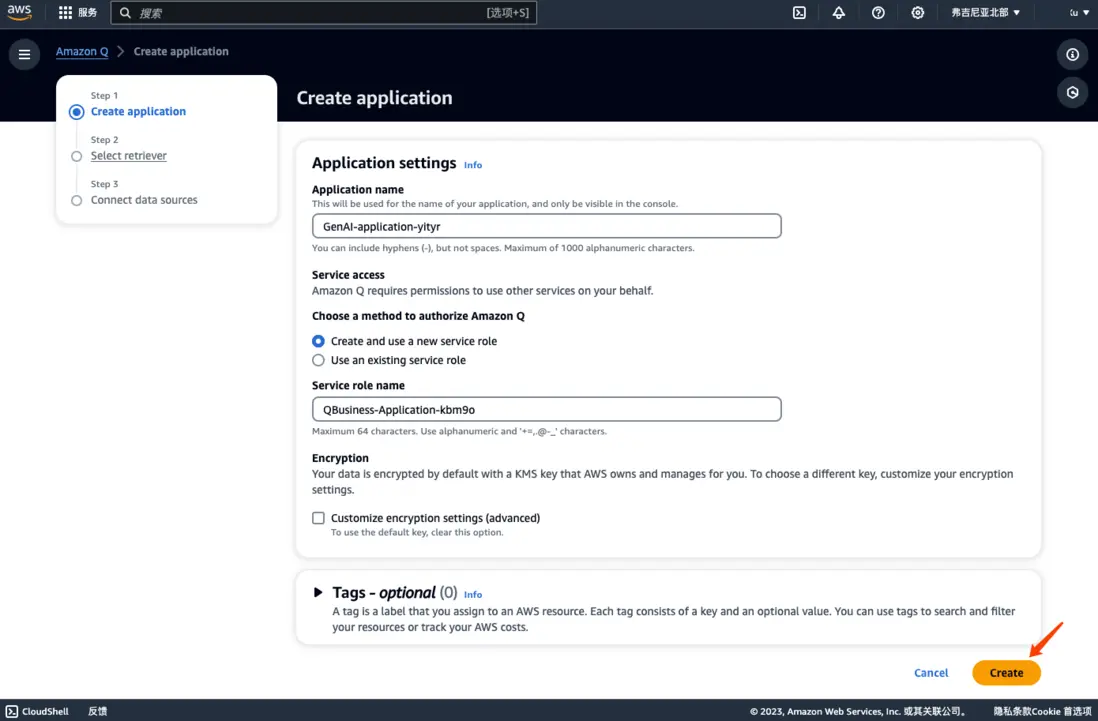

第一步:命名

这里使用默认值,不用改,点下一步。授权可能会耽搁点时间,等一会儿就好。

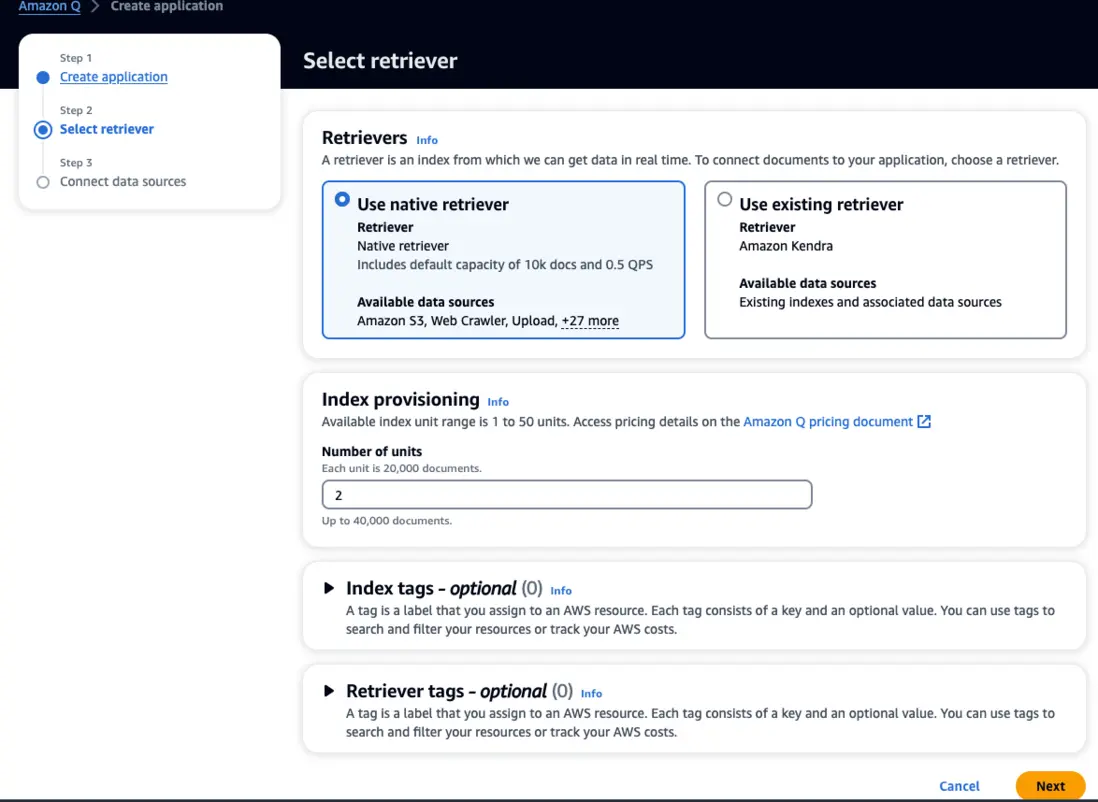

第二步:Retriever 选择

如果不清楚就直接选择 native retriever。

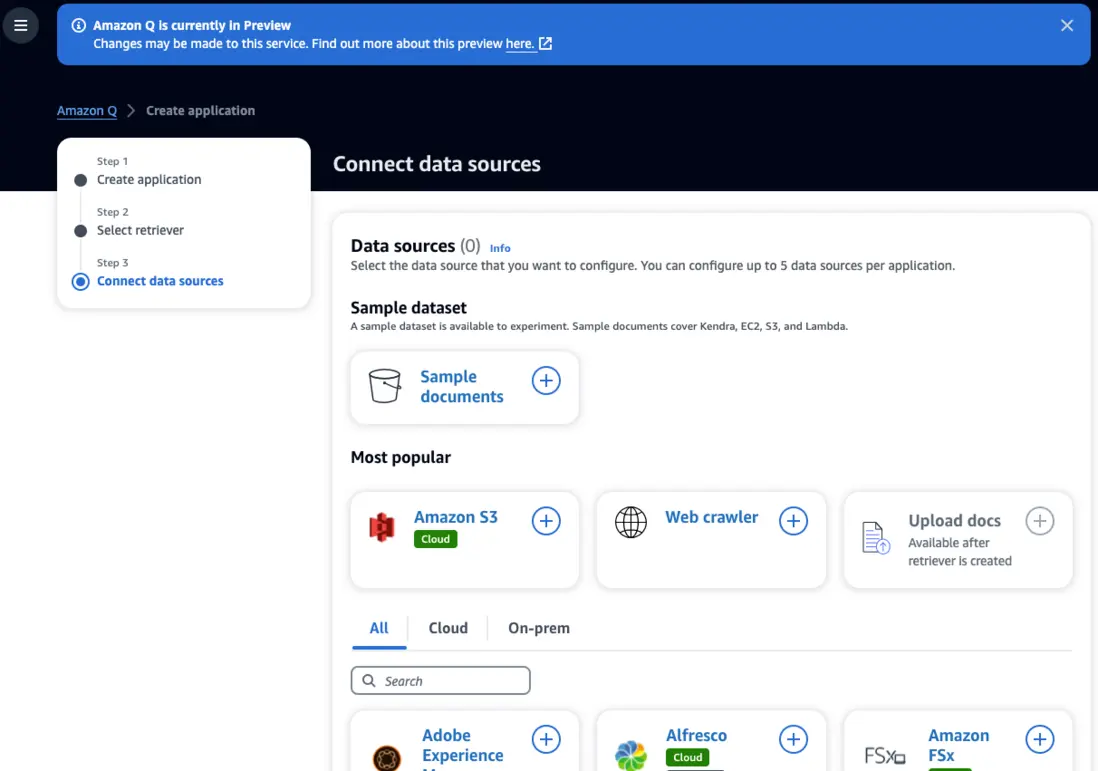

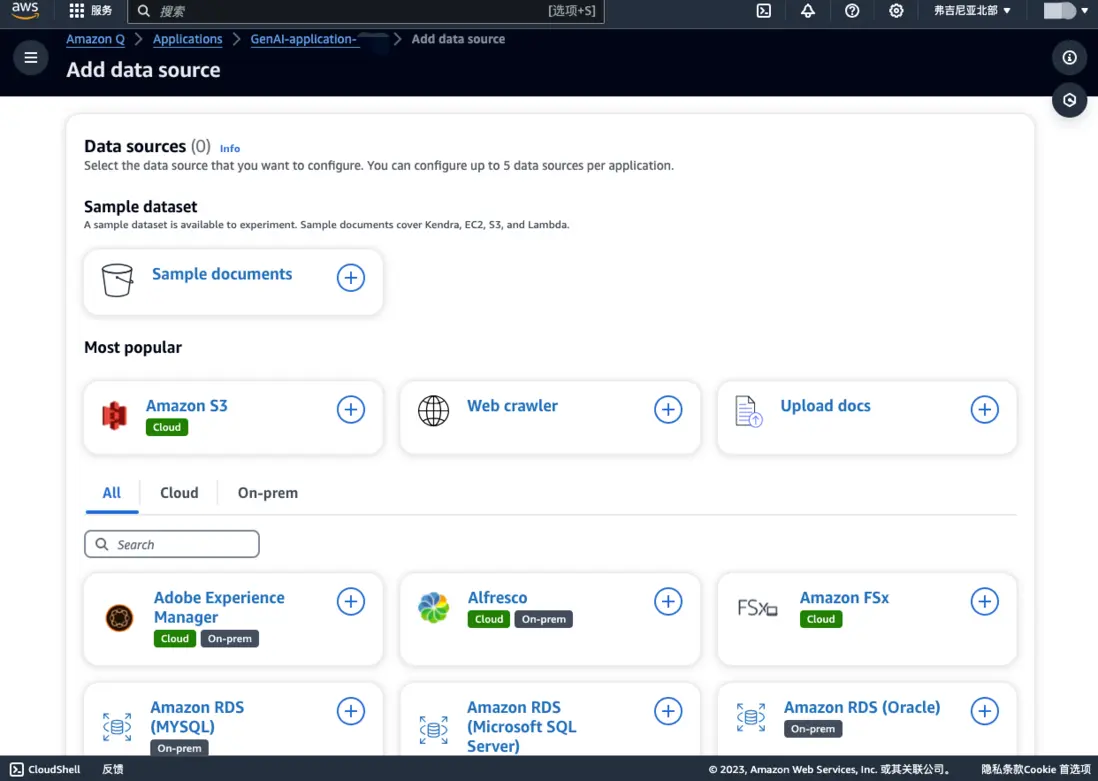

第三步:数据源

数据源空过,直接脱到底创建。

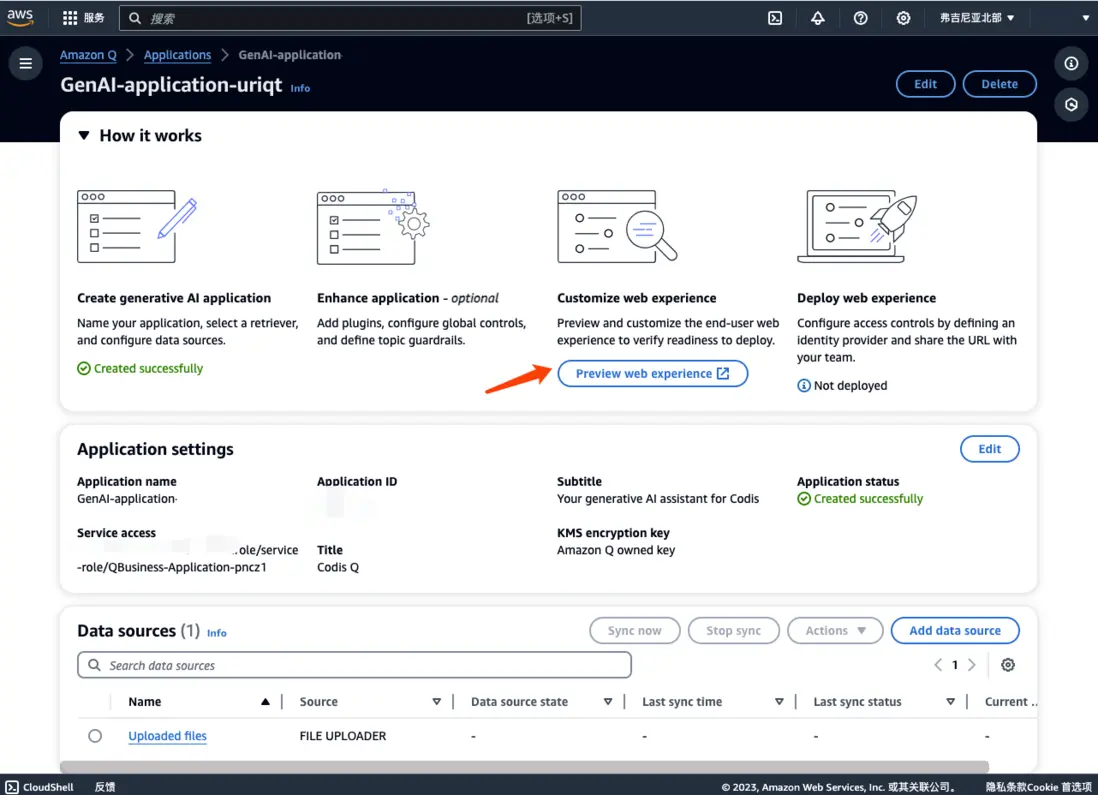

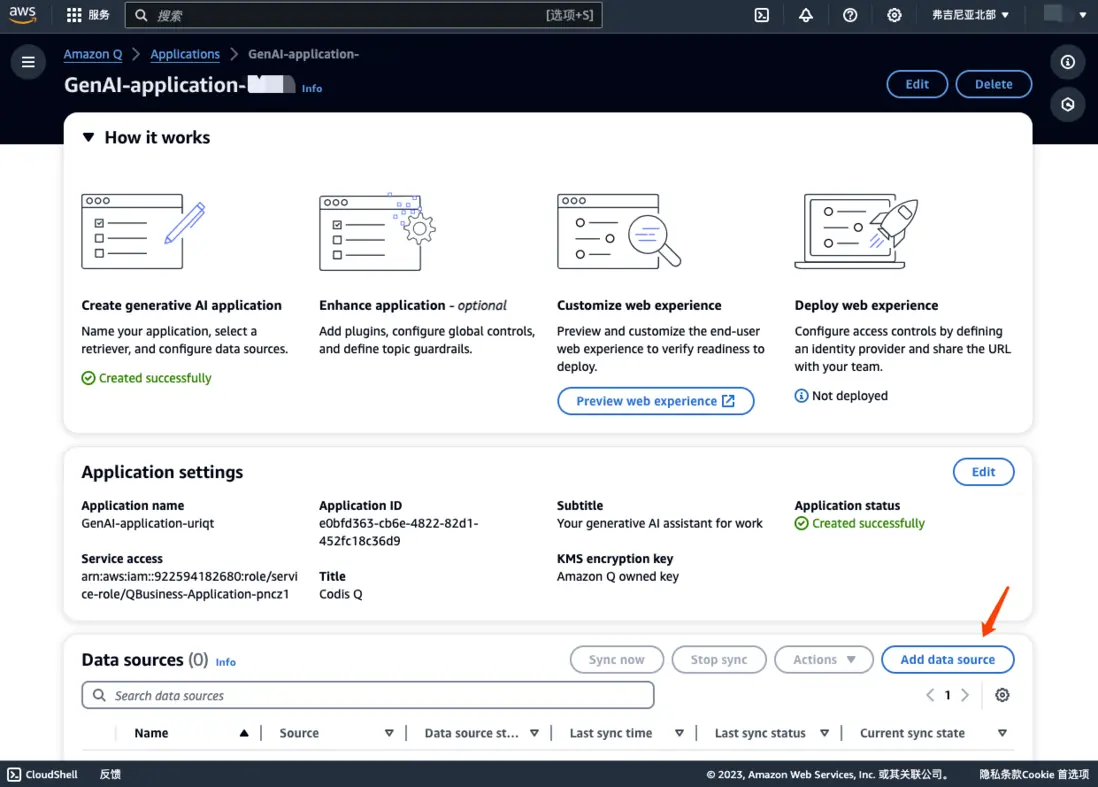

体验

点击刚刚创建 Q application,进入到这个应用

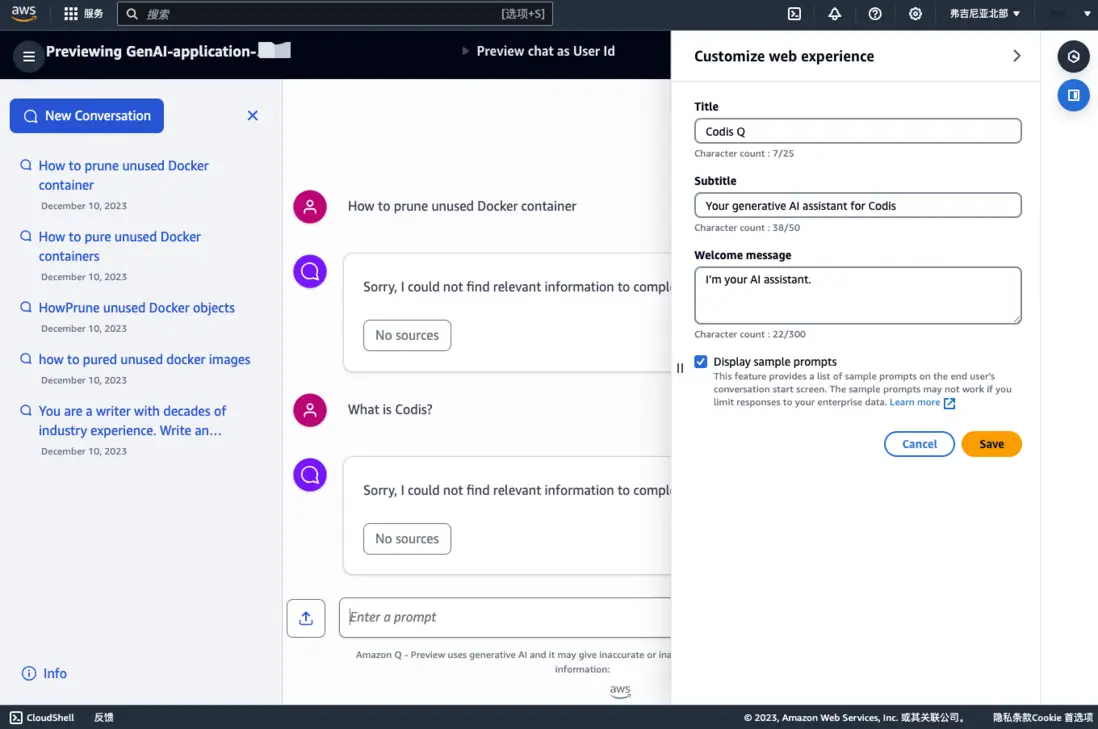

空白的体验

点击

review web experience

就进入了一个聊天室。

当前,我们还没有上传任何文档,也没有配置 retriever,我们问它几个问题试试。

它直接回复没有数据源,不知道。

数据源添加

回到我们的应用主页面,点击

Add data source

这里我们选择上传文档,点击

Upload docs

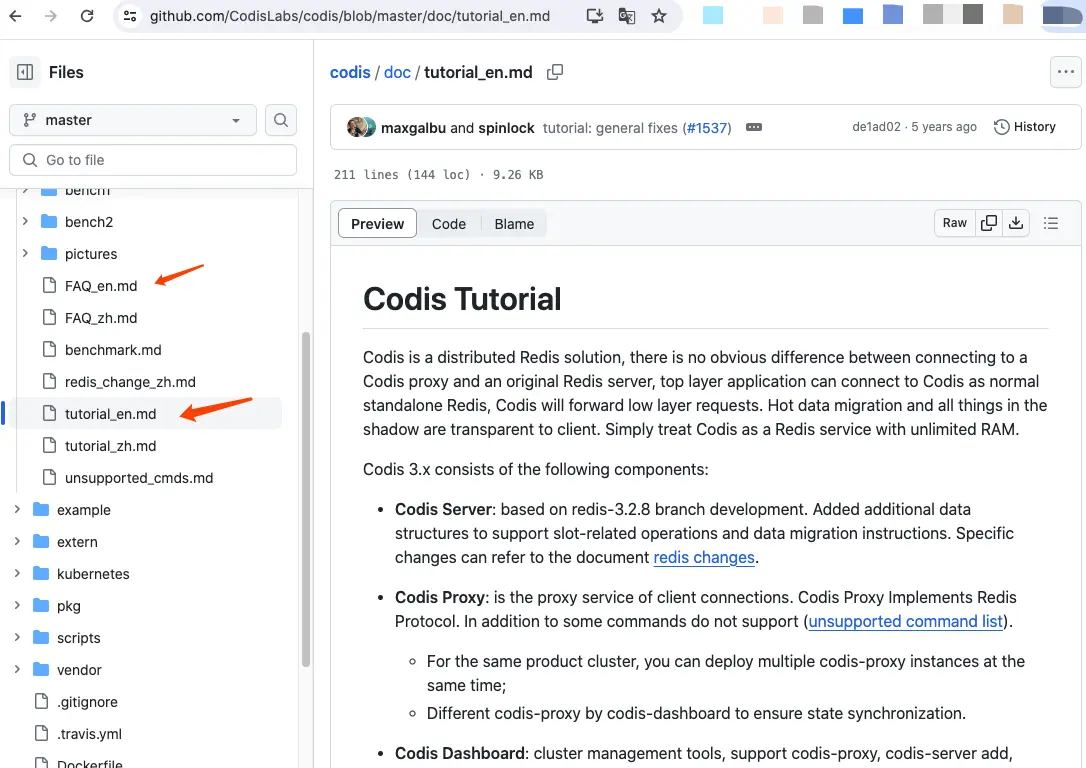

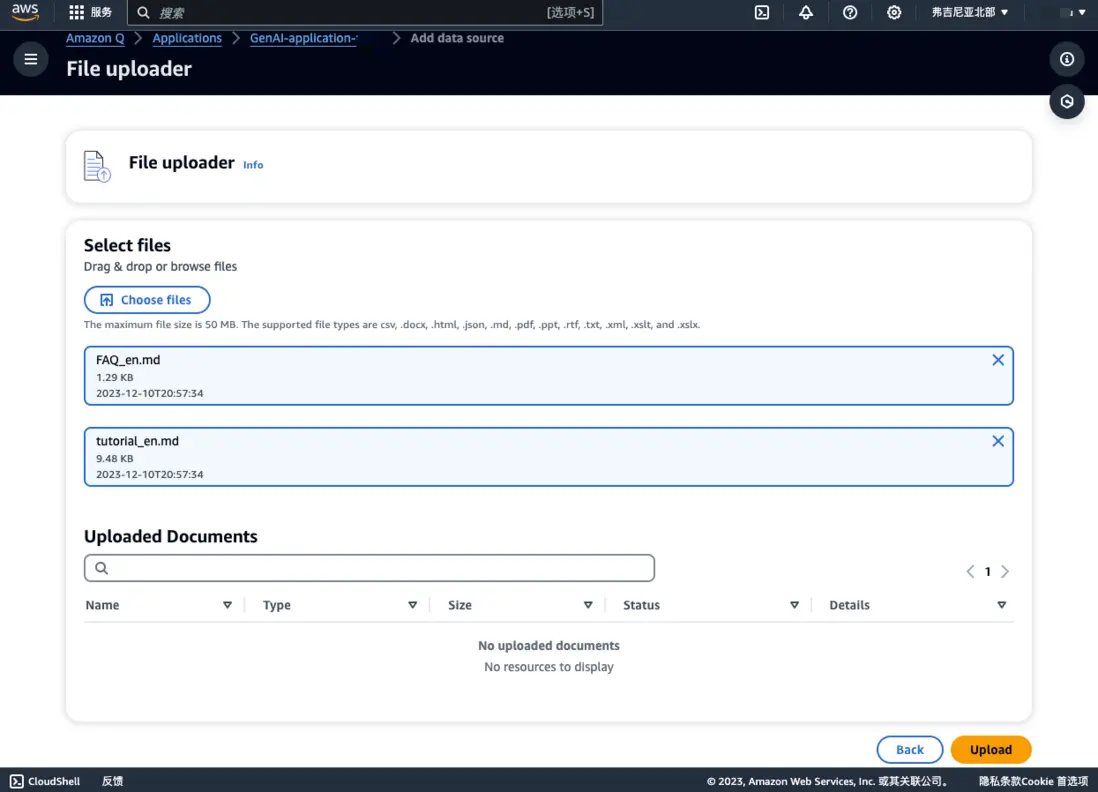

关于数据源,我选择了 Codis 的文档。

上传文件, 他是支持 markdown 文件的,我就上传了 tutorial_en.md, FAQ_en.md 两个文件。

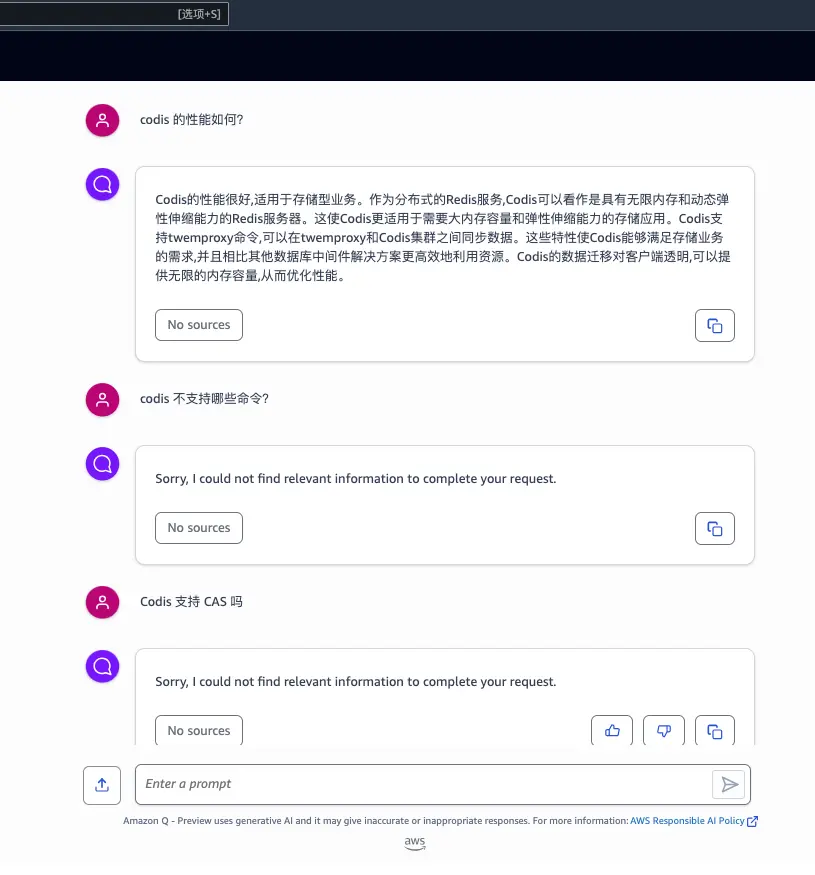

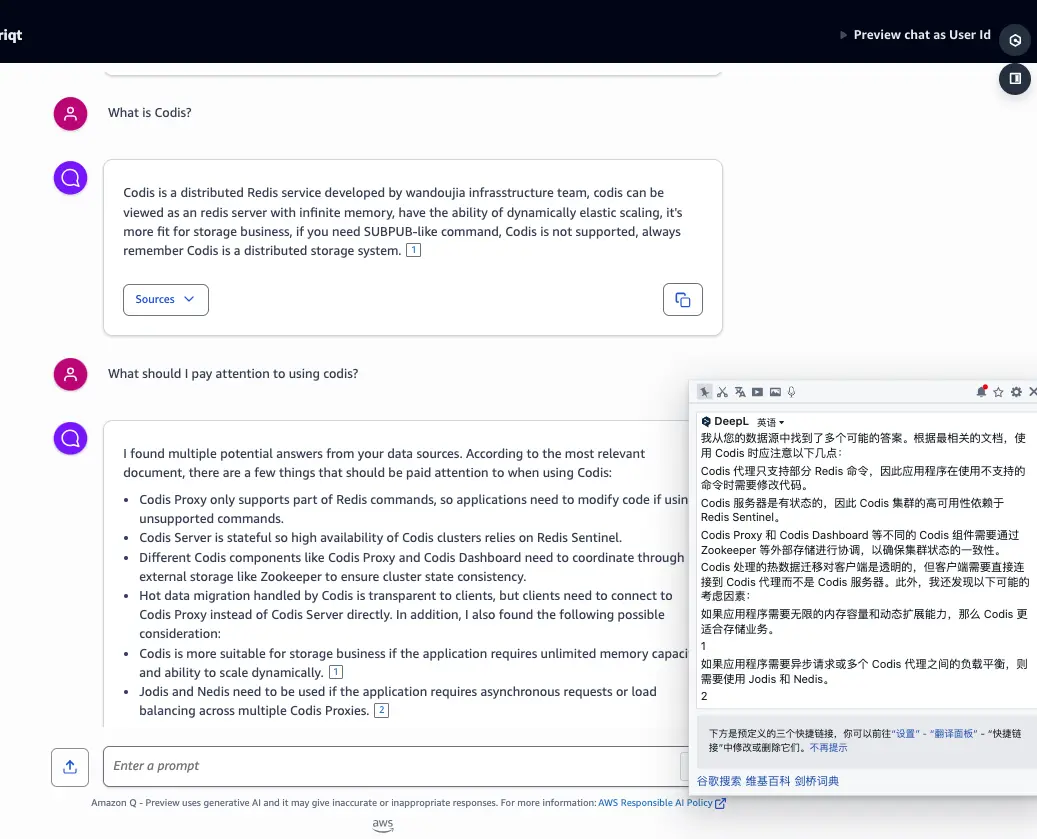

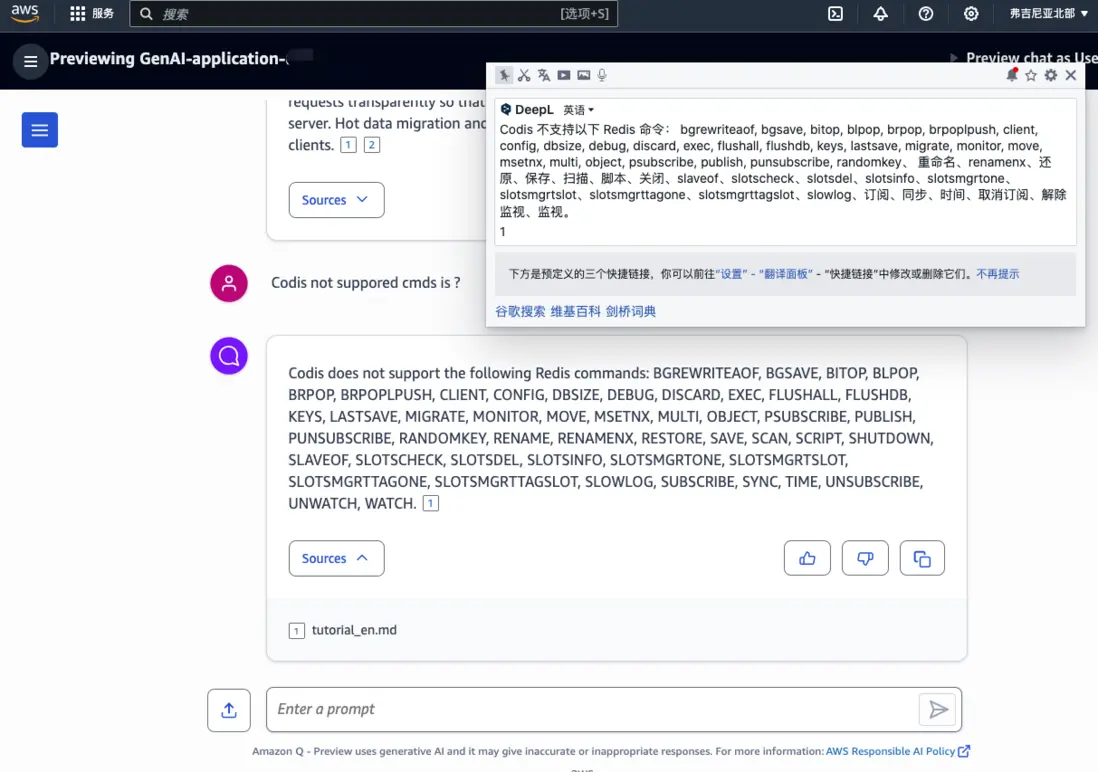

学习后的对话

上传文档后,我们再来问问 Q。可以看到它能根据我们提供的文档,进行回答了。

后面还跟上了数据源,也就是它的回答依据是哪些文档。

中文

大家都看到了我一直都在使用的英文和它交流,因为目前的预览版对中文的支持还不那么好,我这也上传了些中文文档,然后进行对话提问,结果如下。

还是比较期待它能完全支持中文,到时候就能赋能国内业务了。

感受

相比于其他 AI 产品,需要准备大量数据集,预训练,参数调优,以及服务部署。

你只要投喂文档、数据给 Amazon Q ,他就能成为某方面的专家,按照你的文档回答问题,你可以说它是一个更聪明的搜索引擎,或者智能客服。

整个体验下来,我觉得不懂 IT 的朋友也能上手,目前亚马逊对它的定义是——生成式 AI 驱动的企业聊天助手。从它的易上手程度、以及智能程度。我觉得它可以用作:

- 个人知识库助手

- 企业知识库搜索入口

- 智能客服

- 售后技术顾问

刚刚是在亚马逊的 Web 上体验了 Q,它当然提供了 API 供你介入自己应用内部。

响应速度

10词/秒 左右

我在 Web 端体验是这样的速度。不同于 ChatGPT 一个个字得吐,Q 是生成完所有文字后一次性返给前端,所以给人感觉是有点慢。但这个输出速度,其实和人打字速度差不多了。

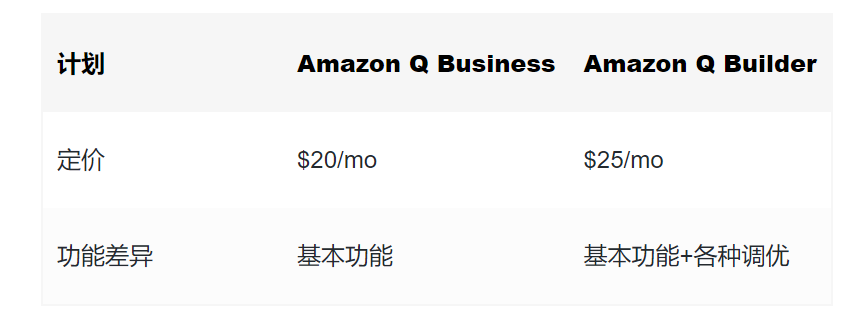

价格

Amazon Q pricing

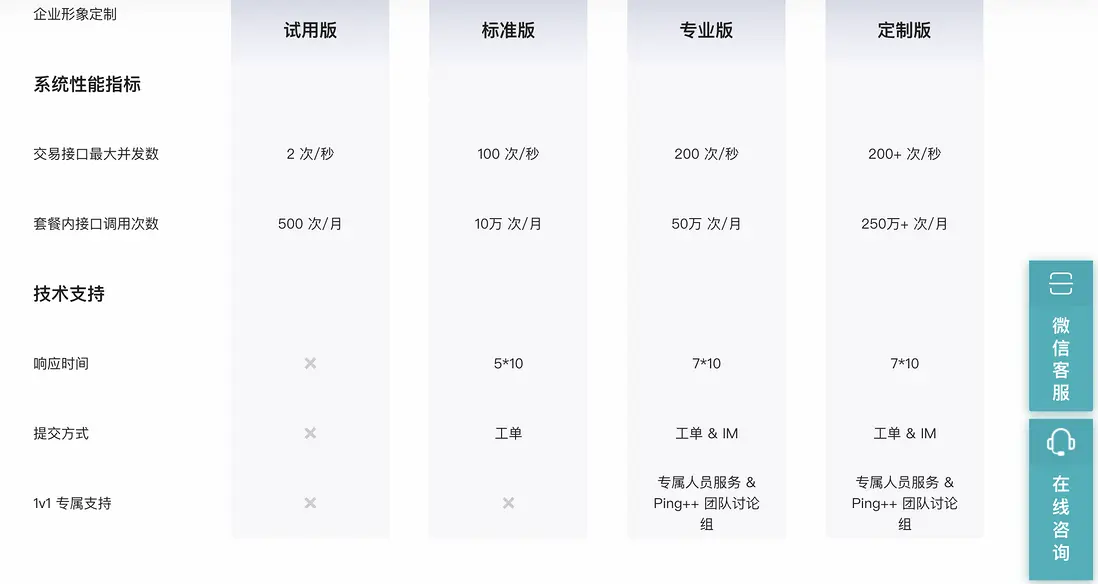

AI 技术顾问

就拿 AI 技术顾问为使用场景,我们把产品的使用文档,以及常见问题,以及解决方案投喂给 Q,Q 就可以按照用户的提问,帮文档去查找解决方案,并告诉客户。

是的,当你提供的云服务控制面板报错时,不需要让客户到处去百度,xx 云平台报错该怎么办了,这个时候,右下角弹出一个 Q ,咨询下客户遇到了什么问题,就能引导客户自行解决问题了。

相较于传统技术支持:

- 免费版没有技术支持

- 标准版工作日工单支持(工单还要排队

- 专业版 工作日通过IM技术支持。

借助 Q 可以做到7*24小时 秒级支持我们的客户!便宜的价格可以让 Q 下放到标准版,甚至 使用版。

对于一些专业、有一定使用门槛的产品,借助 Q 是能够降低产品的使用难度,特别是在试用阶段,在新用户遇到困难并立马解决,是能提高成单率的。

增效

想象一下你需要客服,来解决售后问题,客服在客户和技术人员之间沟通解决问题,并把这些问题记录下来,慢慢得你积累了很多问题集——F&Q。慢慢地,客服反馈有些问题看看产品说明就能解决,但客户就是要打电话咨询。

这个时候,你把这些售后问题投喂到 Q 的 dataset,Q 就立马成为一名经验丰富的客户,能够帮客户解决一些常见问题了,解决不了的再接入到人工客服了。

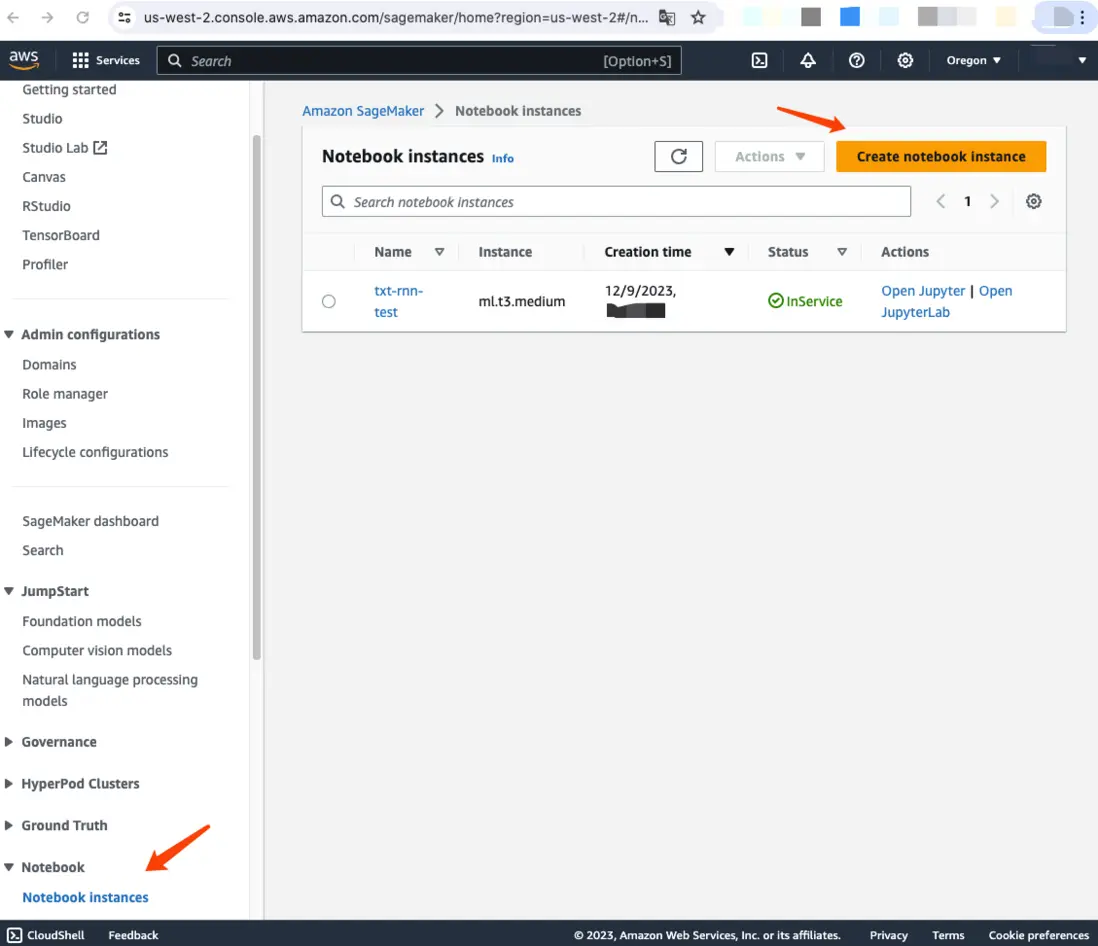

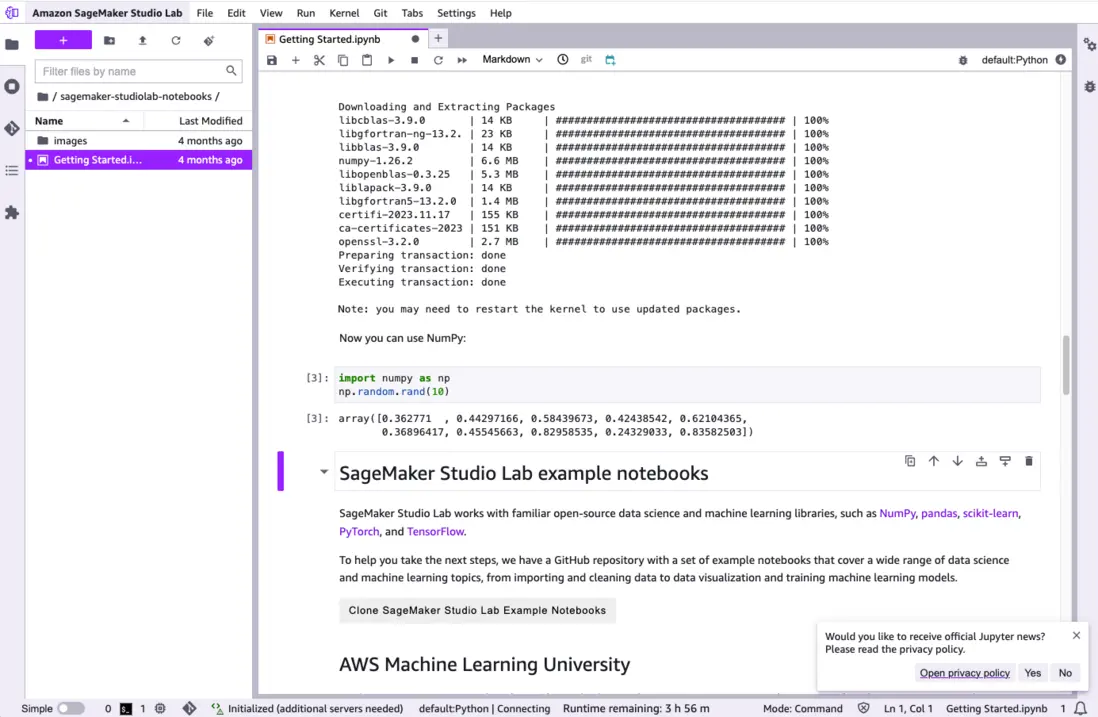

SageMaker

SageMaker 提供专为数据科学家和开发人员高效地准备、构建、训练和部署高质量 ML 模型而构建的机器学习 (ML) 功能。

当团队内的数据专家,想进一步对数据做分析时,无需把数据下载到本地,亚马逊提供了在线 Jupyter 平台,通过它你可以在任何终端访问 Notebook 进行数据分析工作,一切运算都在云端,数据通过 S3 访问,让你无需担心本地磁盘,以及算力。

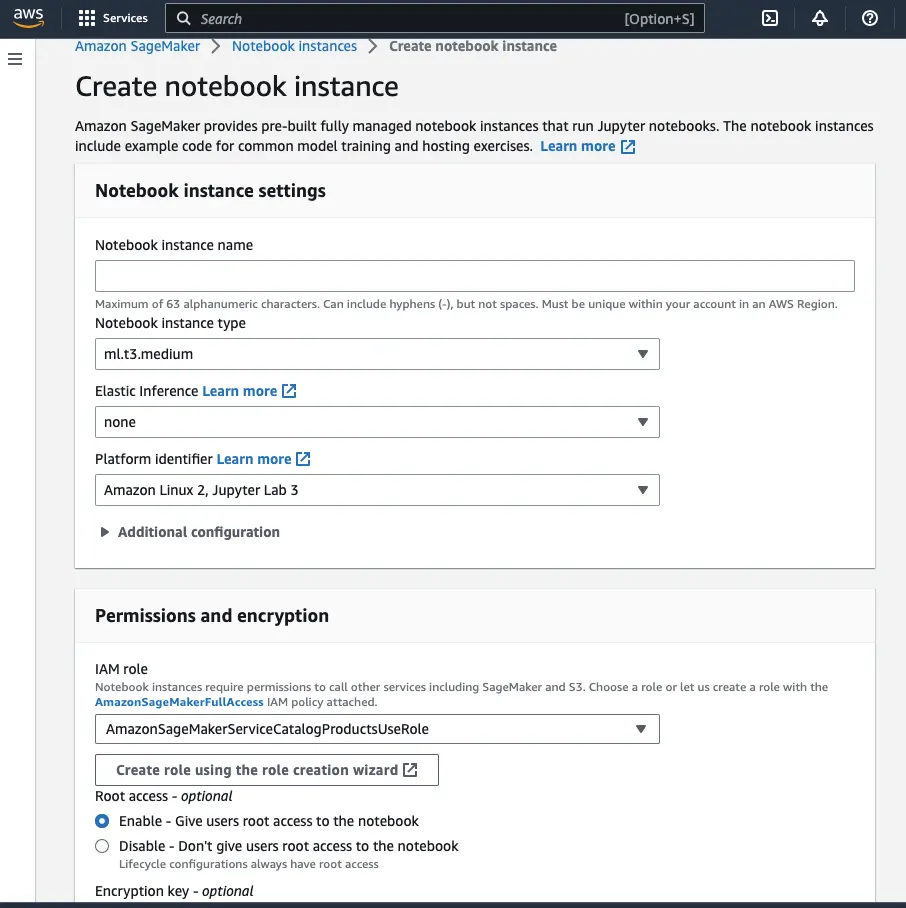

创建 Notebook

访问 SageMaker,翻到 Notebook, 点击

Create notbook instance

这里填了的不用改,只需要填一下名字就行了。

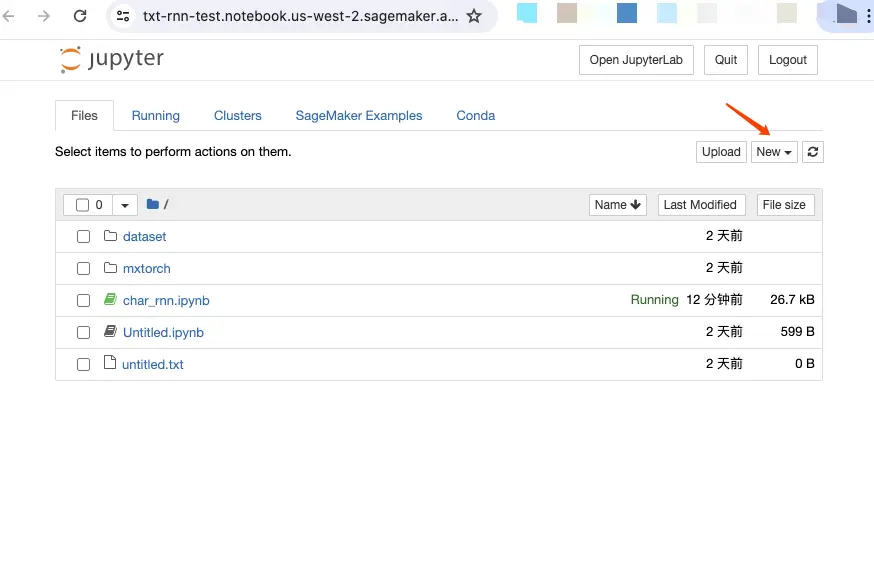

打开 Jupyter

创建好 notebook 实例后,点击

Open Jupyter

就能到一个你熟悉的界面了

是的,这就是 亚马逊云提供服务的 Jupyter。你看到的 Running 状态,就是我没有关闭那个实例,所以,你不用了的话记得手动关闭运行时,它不会自己关,程序会一直为你保存工作状态,随时衔接工作。哎,这样就不用写额外代码去保存中间状态了。(PS:说的就是你 Colab)

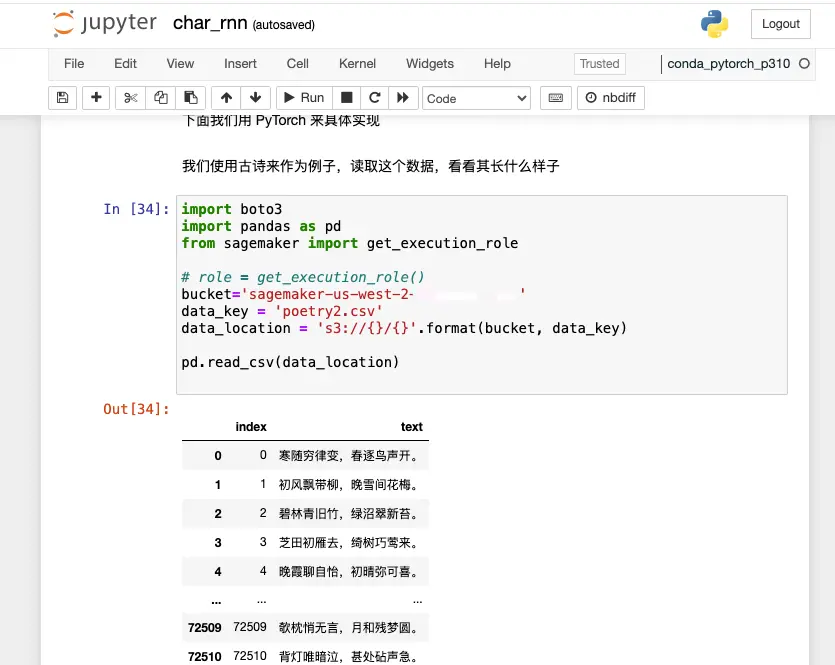

访问 S3 数据

那么如何访问 S3 数据呢

通过如上代码,说明 SageMaker 是和 S3 打通了的。只需要配置好数据权限,数据分析人员就能自己拿数据进行分析工作了。

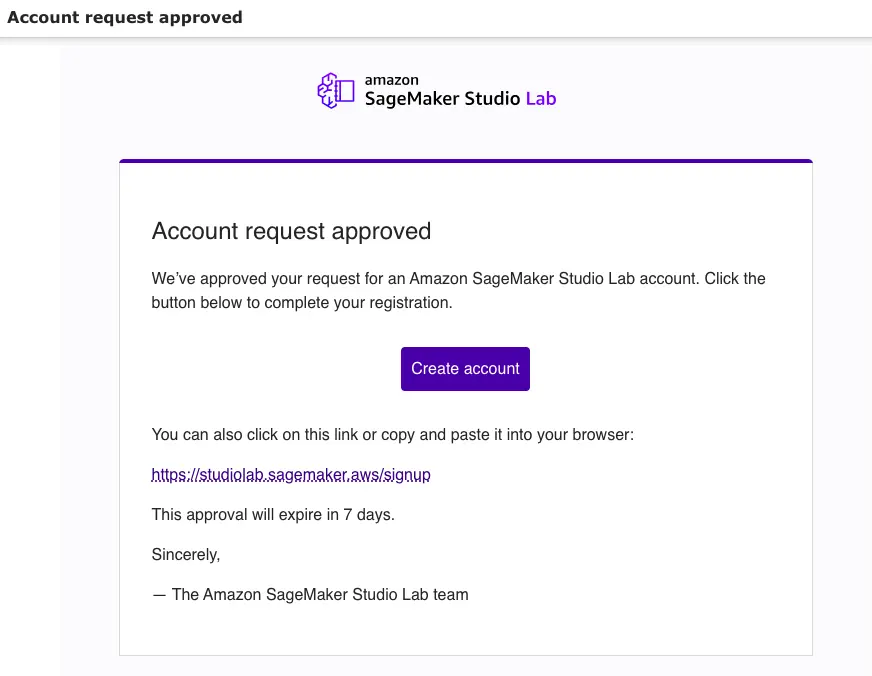

SageMaker Studio

对了, 亚马逊还推出了 SageMaker Studio 一个免费的机器学习(ML)开发环境。独立于亚马逊的账号体系,目前是需要申请的,我的申请一天就过了,还是挺快的。(想白嫖的早点申请,😄)

用过 Colab,Kaggle 的同学,可以试试这个平台。每天免费4个小时的 GPU 算力,如果你只用 CPU 的话,那么会有8个小时运行时可供你用。

这个免费算力发放策略和 Colab 比较像啊,访问不了Google 的同学可以试试这个。

启动运行时之前,会让你填手机号,我填的国内的+86手机号,是可以畅通使用的。

访问速度

目前,我访问 Studio 没有网络障碍,大家放心冲。

生态

这场 AI 热潮,亚马逊云不仅仅是提供了大模型给大家使用,还围绕达模型的训练、调优、运行提供了一整套服务。

安全

作为云服务商,亚马逊非常重视用户的数据安全,并且公开承诺不会用客户的数据去改进他们的模型,至于他们怎么改进模型,估计是基于自己的业务。

还有生成的内容安全,由于 AI 生成模型,参数众多,可能你都不知道训练出来的模型,可能学到了什么坏毛病,关于这一天,Bedrok 提供了跟踪,以及完善的日志功能,并切发现错误会帮你屏蔽内容输出,同时也会检查用户的输入,

例如:我在玩文生图时,有几个词汇过于涩涩就直接告警,不给我生成图片。

跑得快不一定赢,不跌跟头才是成功

在国内环境下,这些功能都是必须的,它已经先一步帮我们想到了。

最后

看过发布会,体验过 Q 之后,个人感觉距离 AI 产品更近一步了。在当前隐私泄露严重,滥用个人信息的环境下,生成式 AI 这个婴儿在一旁嗷嗷待哺(数据投喂),还有一个云服务商把客户的安全、隐私放在第一位,是难能可能可贵的。

本文参与了「构」向云端 | 亚马逊云科技 x 思否 2023 re:Invent 构建者征文大赛,欢迎正在阅读的你也加入。

授权声明:本篇文章授权活动官方亚马逊云科技文章转发、改写权,包括不限于在 Developer Centre,知乎,自媒体平台,第三方开发者媒体等亚马逊云科技官方渠道

文章来源:2023 re:Invent AI 生成产品体验,从 Bedrock 到 Amazon Q

版权归原作者 亚马逊云开发者 所有, 如有侵权,请联系我们删除。