题目: Spatial-Temporal-Decoupled Masked Pre-training for Spatiotemporal Forecasting

作者:Haotian Gao ; Renhe Jiang(姜仁和) ; Zheng Dong ; Jinliang Deng (邓锦亮); Yuxin Ma ; Xuan Song(宋轩)

机构:东京大学,南方科技大学,悉尼大学

arXiv网址:https://arxiv.org/abs/2312.00516

Cool Paper:https://papers.cool/arxiv/2312.00516

代码:https://github.com/Jimmy-7664/STD-MAE

关键词:自监督预训练,时空解耦,掩码自编码器,时空预测,异质性

TL; DR: 本研究提出了一种自监督预训练框架STD-MAE,利用时空解耦掩码自编码器(S-MAE和T-MAE)分别在空间和时间维度上重建时空序列,以学习丰富的上下文表示,这些表示可以无缝集成到下游预测器中,提升其性能。

🌟【紧跟前沿】“时空探索之旅”与你一起探索时空奥秘!🚀

欢迎大家关注时空探索之旅

摘要

时空预测技术对于交通、能源和天气等各个领域都具有重要意义。由于复杂的时空异质性,时空序列的准确预测仍然具有挑战性。特别是,当前的端到端模型受到输入长度的限制,因此经常陷入时空幻觉(spatiotemporal mirage),即相似的输入时间序列后面跟着不同的未来值,反之亦然。为了解决这些问题,本文提出了一种新颖的自监督预训练框架时空解耦掩码预训练(STD-MAE),它采用两个解耦屏蔽自动编码器沿空间和时间维度重建时空序列。通过这种重建学习的丰富上下文表示可以由下游预测器与任意架构无缝集成,以增强其性能。对六个广泛使用的基准(PEMS03、PEMS04、PEMS07、PEMS08、METR-LA 和 PEMS-BAY)进行了一系列定量和定性评估,以验证 STD-MAE 的最先进性能。

Q: 这篇论文试图解决什么问题?

A: 这篇论文提出了一种新颖的自监督预训练框架,名为Spatial-Temporal-Decoupled Masked Pre-training (STD-MAE),旨在解决时空预测中的一些关键挑战。具体来说,论文试图解决以下问题:

- 复杂的时空异质性:时空序列预测的准确性受到时空异质性的挑战,因为时空数据在不同位置(如城市中心与郊区)和不同时间段(如工作日与周末)表现出不同的模式。

- 端到端模型的输入长度限制:现有的端到端模型由于其高模型复杂性,通常将输入范围限制在较短的值(通常为12步),这限制了模型捕捉完整的时空依赖性的能力。

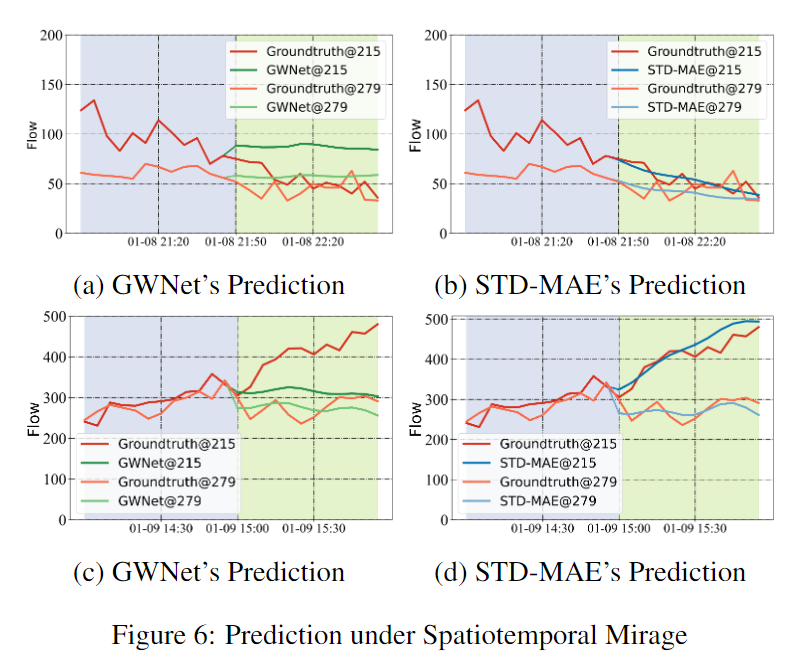

- 时空幻影(mirage)问题:由于现有模型只能捕捉到片段化的异质性而非完整的异质性,导致模型在面对时空幻影(即相似的输入时间序列可能跟随不同的未来值,反之亦然)时表现不佳。

- 学习清晰完整的时空异质性:为了提高模型在时空幻影问题上的鲁棒性,论文提出了通过预训练来学习清晰和完整的时空异质性。

STD-MAE框架通过两个解耦的掩码自编码器(masked autoencoders)分别在空间和时间维度上重建时空序列,从而学习到丰富的上下文表示,这些表示可以无缝地集成到下游预测器中,以增强其性能。论文通过在六个广泛使用的基准数据集上的定量和定性评估来验证STD-MAE的性能。

Q: 有哪些相关研究?

A: 论文中提到的相关研究主要涉及以下几个领域:

- 时空预测(Spatiotemporal Forecasting):旨在通过分析历史数据来预测未来的时空序列。早期的工作主要依赖于传统的时间序列模型,后来发展到使用循环神经网络(RNNs)和卷积神经网络(CNNs)来更好地建模时空数据。

- 图卷积网络(Graph Convolutional Networks, GCNs):一些研究通过将GCNs与时间模型结合,以更好地捕捉网络化道路系统中的时空特征。

- 注意力机制(Attention Mechanisms):在时空预测中,注意力机制,特别是变换器(Transformers),已被提出并展现出在捕捉时空关系方面的优越性能。

- 掩码预训练(Masked Pre-training):在自然语言处理(NLP)和计算机视觉(CV)中,掩码预训练已成为一种高效的自监督表示学习技术。这种方法通过预测输入中被遮蔽的部分来训练模型,使其能够学习到丰富的上下文表示。

- 时间序列数据的预训练技术:最近,研究人员尝试将预训练技术应用于时间序列数据,以获得更优越的隐藏表示。

这些研究为本文提出的STD-MAE框架提供了理论基础和技术背景。

Q: 论文如何解决这个问题?

A: 论文提出了一种新颖的自监督预训练框架,名为Spatial-Temporal-Decoupled Masked Pre-training (STD-MAE),来解决时空预测中的挑战。以下是解决这个问题的关键步骤和方法:

- 时空解耦掩码预训练(Spatial-Temporal-Decoupled Masking):提出了一种新的掩码策略,分别在空间和时间维度上执行掩码和重建任务。这种方法允许模型分别学习空间和时间上的异质性,从而能够更清晰地捕捉到时空数据的复杂性。

- 时空解耦掩码自编码器(Spatial-Temporal-Decoupled Masked AutoEncoder):构建了一个由时间自编码器(T-MAE)和空间自编码器(S-MAE)组成的框架,每个自编码器都具有相似的架构。S-MAE沿空间维度应用自注意力,而T-MAE沿时间维度应用自注意力。

- 长输入处理:为了处理长输入序列,论文采用了分块嵌入技术,将长输入序列划分为非重叠的小块,并使用全连接层和二维位置编码来获得嵌入表示。

- 轻量级解码器:为了重建被掩码的输入,S-MAE和T-MAE使用了轻量级解码器,该解码器由填充层、标准变换层和回归层组成。

- 下游时空预测集成:STD-MAE生成的空间和时间表示可以无缝集成到现有的预测器结构中,通过将这些表示添加到预测器的隐藏表示中,可以显著提高下游时空预测器的性能。

- 定量和定性评估:通过在六个广泛使用的基准数据集上的实验,展示了STD-MAE在定量和定性上的性能,验证了其在捕捉时空异质性和提高预测准确性方面的有效性。

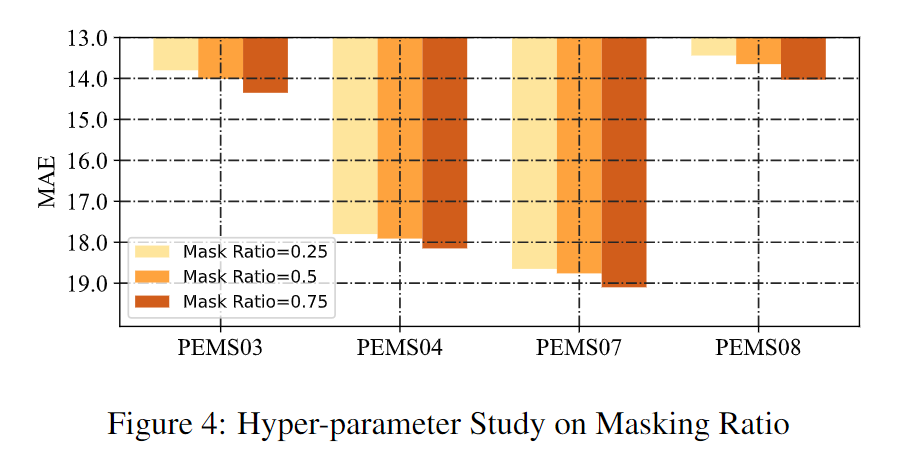

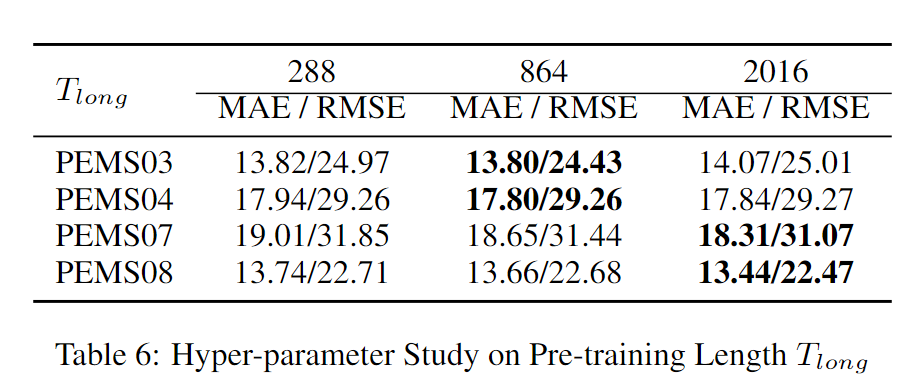

- 超参数研究:论文还进行了超参数研究,包括掩码比例和预训练长度,以找到最佳的模型性能。

通过这些方法,STD-MAE能够有效地学习时空数据的清晰和完整的异质性,并且能够提高下游预测器在复杂时空预测任务中的性能。

Q: 论文做了哪些实验?

在预训练阶段,长输入时间序列的长度(

T l o n g T_{long} Tlong)对于不同的数据集分别设置为864、864、864、2016、864和864时间步长。

A: 论文中进行了一系列的实验来验证所提出的Spatial-Temporal-Decoupled Masked Pre-training (STD-MAE)框架的有效性。以下是实验的主要部分:

- 实验设置: - 使用了六个真实世界的时空基准数据集,包括PEMS03、PEMS04、PEMS07、PEMS08、METR-LA和PEMS-BAY。- 对数据进行了Zscore标准化处理。- 设定了不同的数据集的训练、验证和测试集的比例。- 选择了嵌入维度、变换层数量、多头注意力的头数、填充大小等超参数。

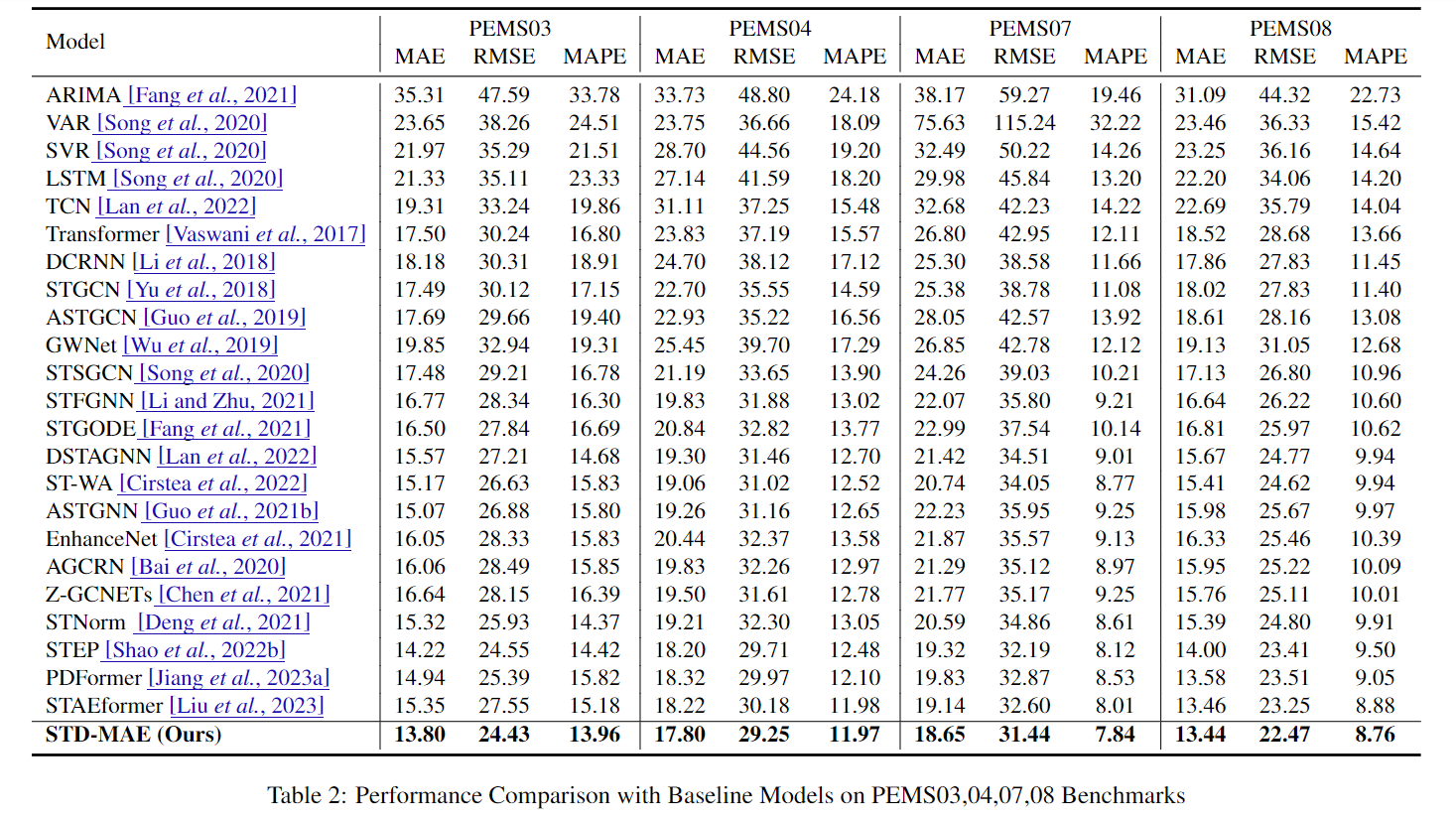

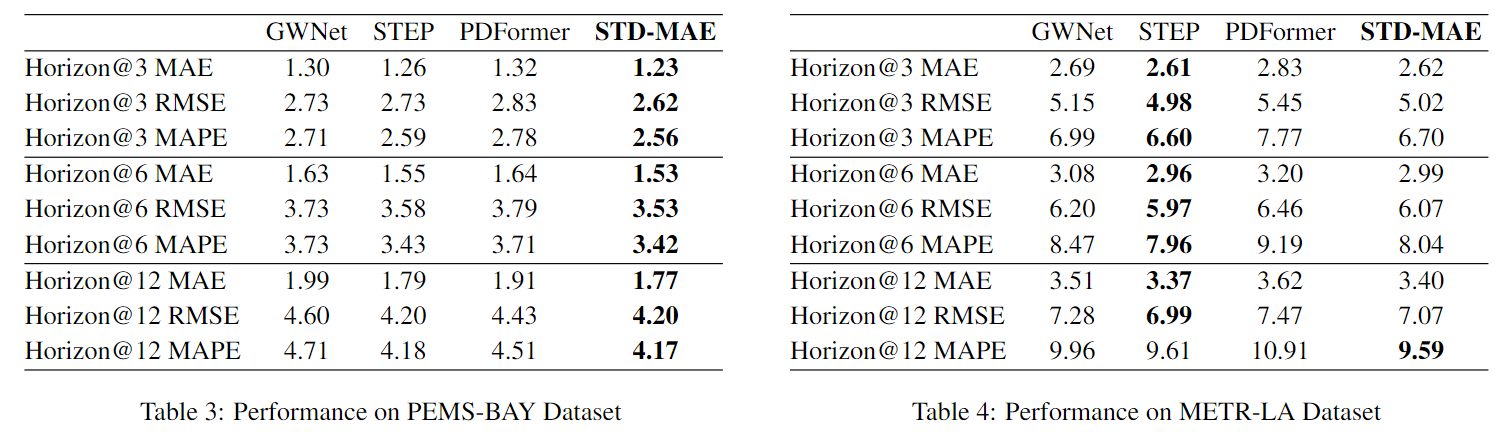

- 整体性能评估: - 将STD-MAE与多个基线方法进行了比较,包括ARIMA、VAR、SVR、LSTM、TCN、Transformer以及多种时空模型,如DCRNN、STGCN、ASTGCN、GWNet等。- 使用平均绝对误差(MAE)、均方根误差(RMSE)和平均绝对百分比误差(MAPE)作为评估指标。

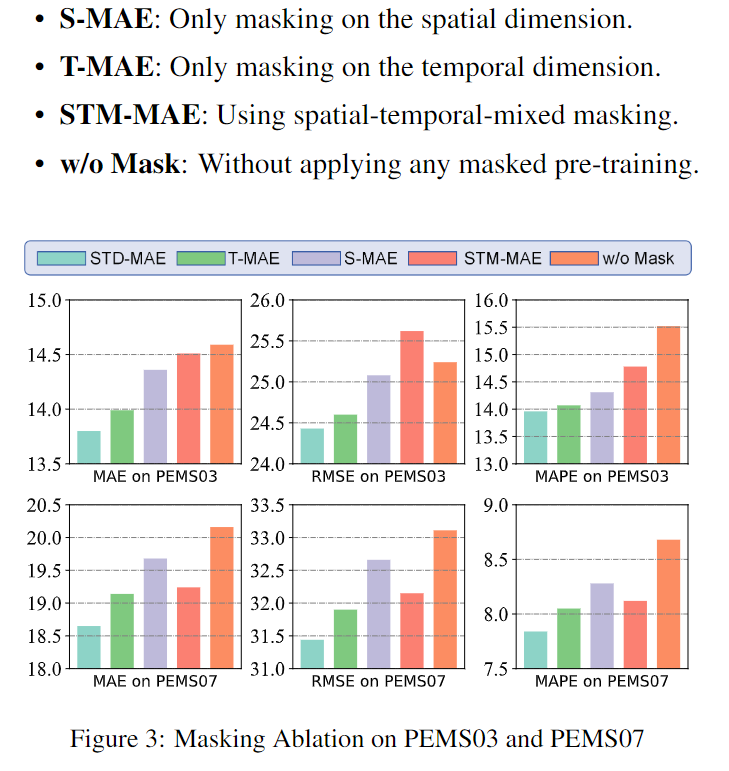

- 消融实验: - 设计了四种变体来验证时空掩码机制的有效性,包括仅在空间维度掩码的S-MAE、仅在时间维度掩码的T-MAE、使用时空混合掩码的STM-MAE以及不使用掩码预训练的w/o Mask。

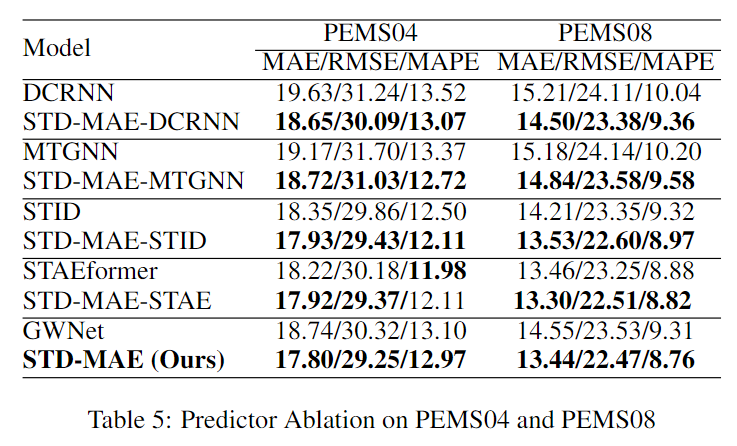

- 预测器消融: - 为了评估STD-MAE的通用性,将其与五种不同的下游预测器进行了集成,包括DCRNN、MTGNN、STID、STAEformer和GWNet。

- 超参数研究: - 研究了掩码比例对模型性能的影响,发现0.25的掩码比例在所有数据集上都能获得最低的误差。- 研究了预训练长度对模型性能的影响,测试了一天、三天和一周的预训练长度。

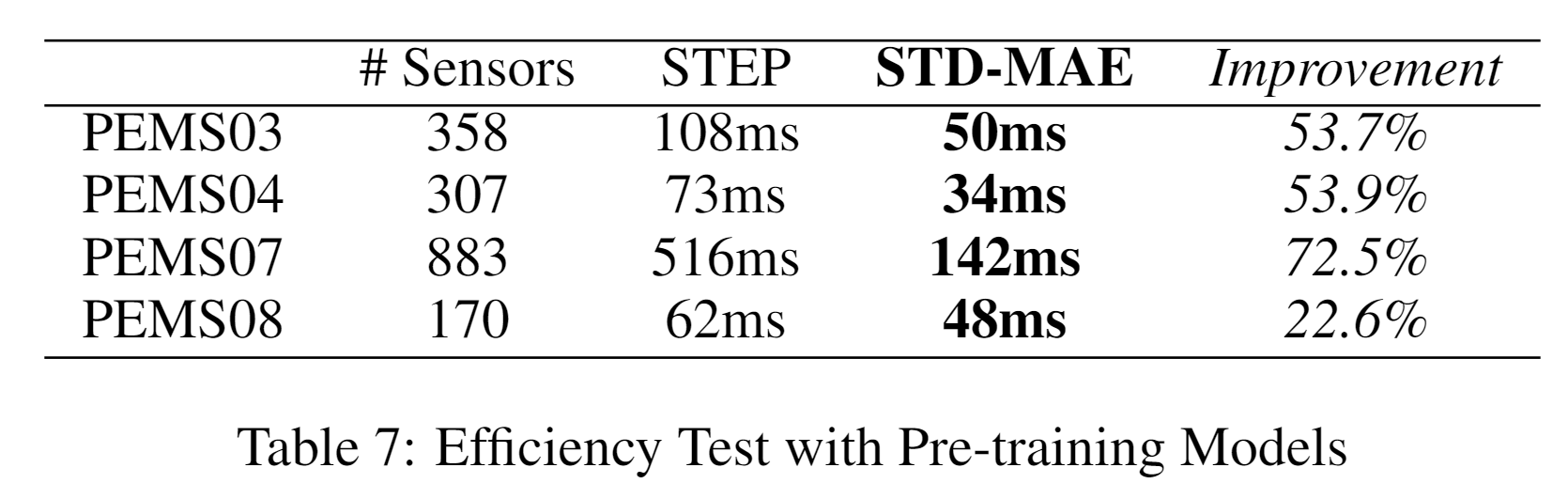

- 效率测试: - 对比了STD-MAE与其他预训练模型的效率,特别是在处理具有大量传感器数据集时的效率。

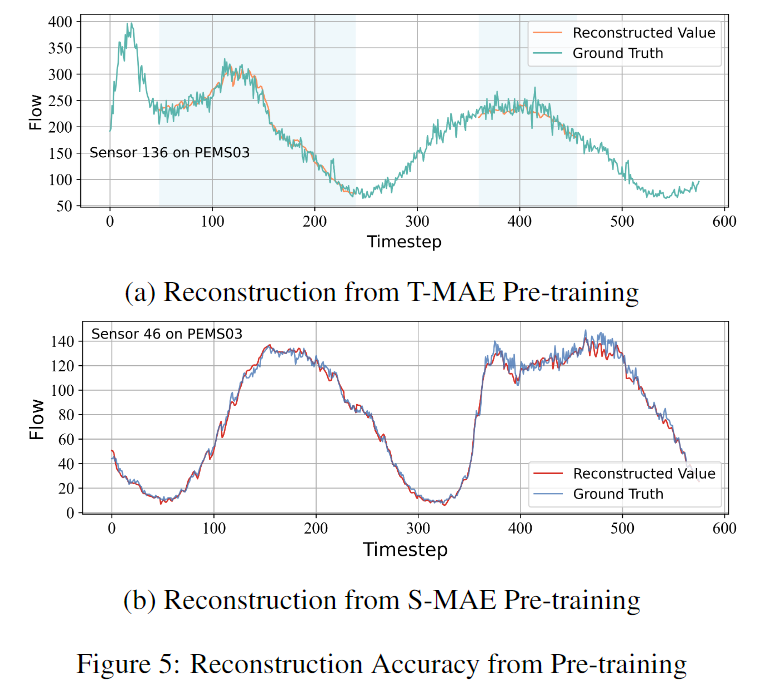

- 案例研究: - 展示了STD-MAE在预训练阶段的重建准确性,以及在面对时空幻影问题时的预测鲁棒性。

这些实验全面地评估了STD-MAE框架的性能,包括其在不同数据集上的表现、与现有方法的比较、不同变体和超参数对性能的影响,以及其在实际预测任务中的有效性。

Q: 总结一下论文的主要内容

A: 这篇论文提出了一种新颖的自监督预训练框架,名为Spatial-Temporal-Decoupled Masked Pre-training (STD-MAE),用于改进时空预测任务。以下是论文的主要内容总结:

- 问题背景:时空预测对于交通、能源和气象等领域至关重要。由于时空数据的复杂异质性,准确预测时空序列面临挑战。

- 现有模型局限:当前的端到端模型受限于输入长度,难以捕捉完整的时空依赖性,容易受到“时空幻影”问题的影响。

- STD-MAE框架:提出了一种新的预训练框架,通过两个解耦的掩码自编码器(S-MAE和T-MAE)分别在空间和时间维度上重建时空序列,以学习丰富的上下文表示。

- 方法细节:- 时空解耦掩码:分别在空间和时间维度上执行掩码操作,以捕捉长距离的时空异质性。- 自编码器架构:使用自注意力机制分别在空间和时间维度上进行信息编码。- 长输入处理:采用分块嵌入技术和二维位置编码来处理长输入序列。

- 下游集成:STD-MAE生成的表示可以无缝集成到各种下游预测器中,以增强其性能。

- 实验验证:在六个广泛使用的基准数据集上进行了定量和定性评估,验证了STD-MAE在捕捉时空异质性和提高预测准确性方面的有效性。

- 消融实验:通过一系列消融实验,展示了时空解耦掩码策略的有效性,并证明了STD-MAE对不同下游预测器的通用性。

- 超参数研究:探讨了掩码比例和预训练长度对模型性能的影响,以找到最优的模型配置。

- 效率测试:尽管引入了两个解耦的自编码器,STD-MAE在效率上仍然优于其他预训练模型,特别是在处理大量传感器数据集时。

- 案例研究:通过案例研究展示了STD-MAE在预训练阶段的重建准确性和在面对时空幻影问题时的预测鲁棒性。

- 结论:STD-MAE通过学习清晰和完整的时空异质性,显著提高了时空预测的性能,并为下游预测器提供了一种有效的增强方法。

- 案例研究:通过案例研究展示了STD-MAE在预训练阶段的重建准确性和在面对时空幻影问题时的预测鲁棒性。

- 结论:STD-MAE通过学习清晰和完整的时空异质性,显著提高了时空预测的性能,并为下游预测器提供了一种有效的增强方法。

论文的贡献在于提出了一种新的预训练方法,可以显著提高时空预测的准确性,并且具有很好的通用性和效率。

🌟【紧跟前沿】“时空探索之旅”与你一起探索时空奥秘!🚀

欢迎大家关注时空探索之旅

版权归原作者 STLearner 所有, 如有侵权,请联系我们删除。