文章目录

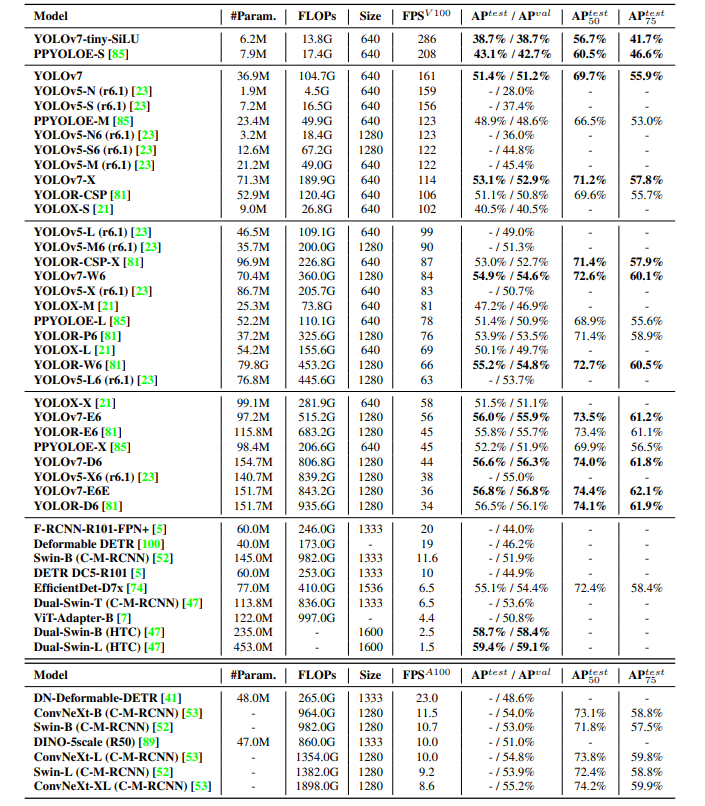

YOLOv7相同体量下比YOLOv5精度更高,速度快120%(FPS),比 YOLOX 快180%(FPS),比 Dual-Swin-T 快1200%(FPS),比 ConvNext 快550%(FPS),比 SWIN-L快500%(FPS)。在5FPS到160FPS的范围内,无论是速度或是精度,YOLOv7都超过了目前已知的检测器,并且在GPU V100上进行测试, 精度为56.8% AP的模型可达到30 FPS(batch=1)以上的检测速率,这是目前唯一一款在如此高精度下仍能超过30FPS的检测器。论文中(

论文下载)各个模型的性能对比如下图所示:

1. 依赖类库

- matplotlib>=3.2.2

- numpy>=1.18.5

- opencv-python>=4.1.1

- Pillow>=7.1.2

- PyYAML>=5.3.1

- requests>=2.23.0

- scipy>=1.4.1

- torch>=1.7.0,!=1.12.0

- torchvision>=0.8.1,!=0.13.0

- tqdm>=4.41.0

- protobuf<4.21.3

2. 相关下载(可跳过本步,依据后面步骤按需下载)

- 论文下载:YOLOv7: Trainable bag-of-freebies sets new state-of-the-art for real-time object detectors

- 源码地址:https://github.com/WongKinYiu/yolov7

- 基准数据集:https://cocodataset.org/

train2017

train2017:http://images.cocodataset.org/zips/train2017.zip

train2017 annotations:http://images.cocodataset.org/annotations/annotations_trainval2017.zip

val2017

val2017:http://images.cocodataset.org/zips/val2017.zip

val2017 annotations:http://images.cocodataset.org/annotations/stuff_annotations_trainval2017.zip

test2017

test2017:http://images.cocodataset.org/zips/test2017.zip

test2017 info:http://images.cocodataset.org/annotations/image_info_test2017.zip

3. 源码调试

3.1 下载源码

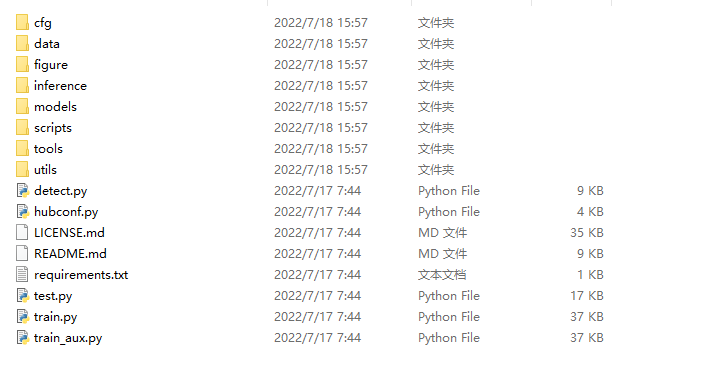

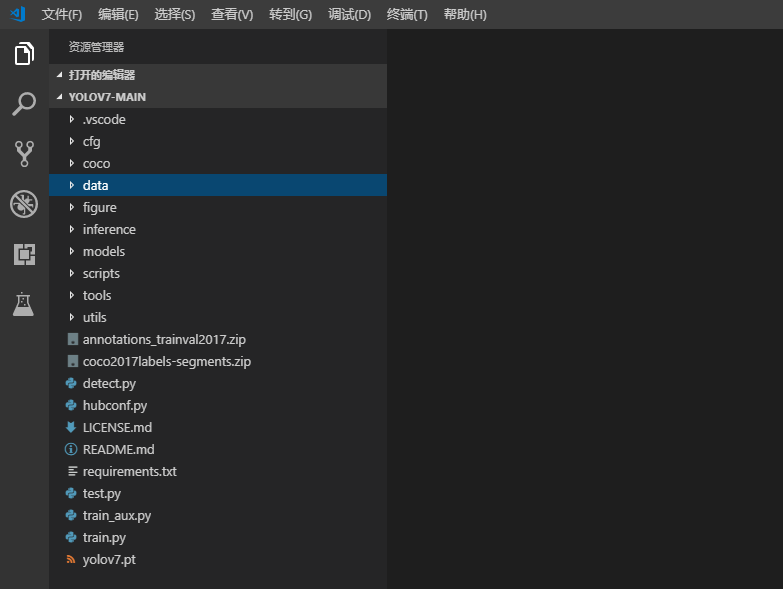

下载YOLO7源码(点击下载),并进行解压。

3.2 下载预训练模型

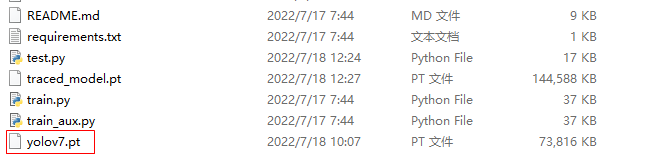

3.1 下载YOLO7预训练模型(点击下载),并放置在项目的根目录下。

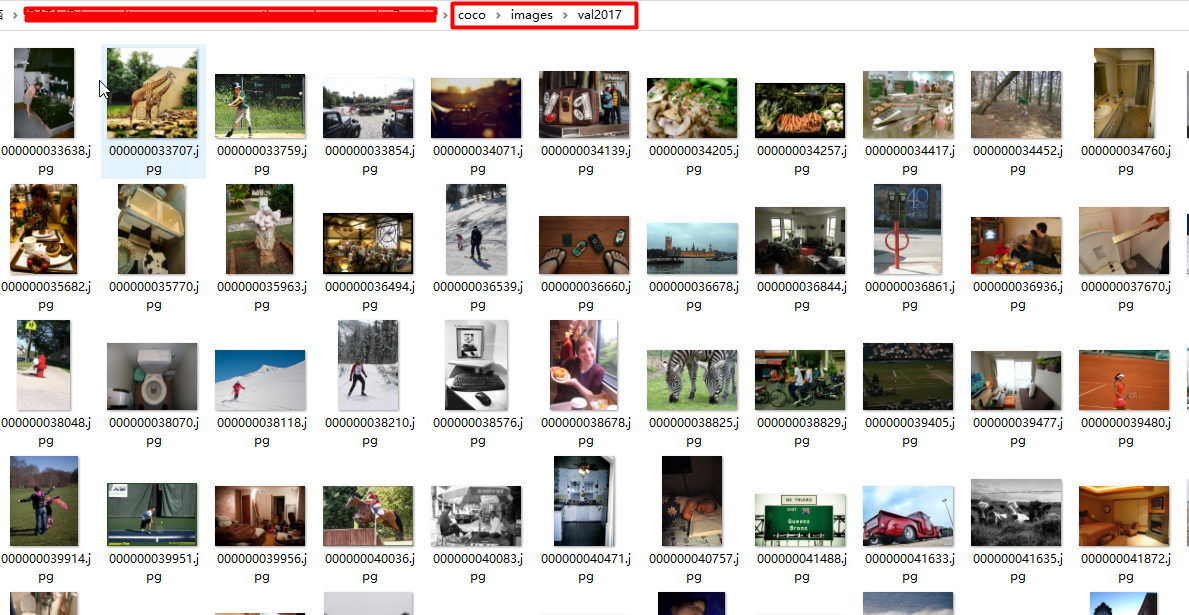

3.3 下载数据集

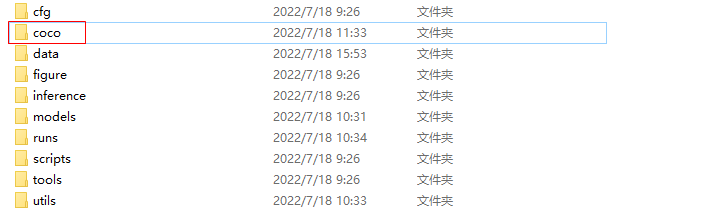

下载COCO数据集标签数据数据(点击下载),并加压到项目跟目录下。

下载COCO验证数据集(点击下载)并加压到coco/images/val2017目录下,

4. 运行代码

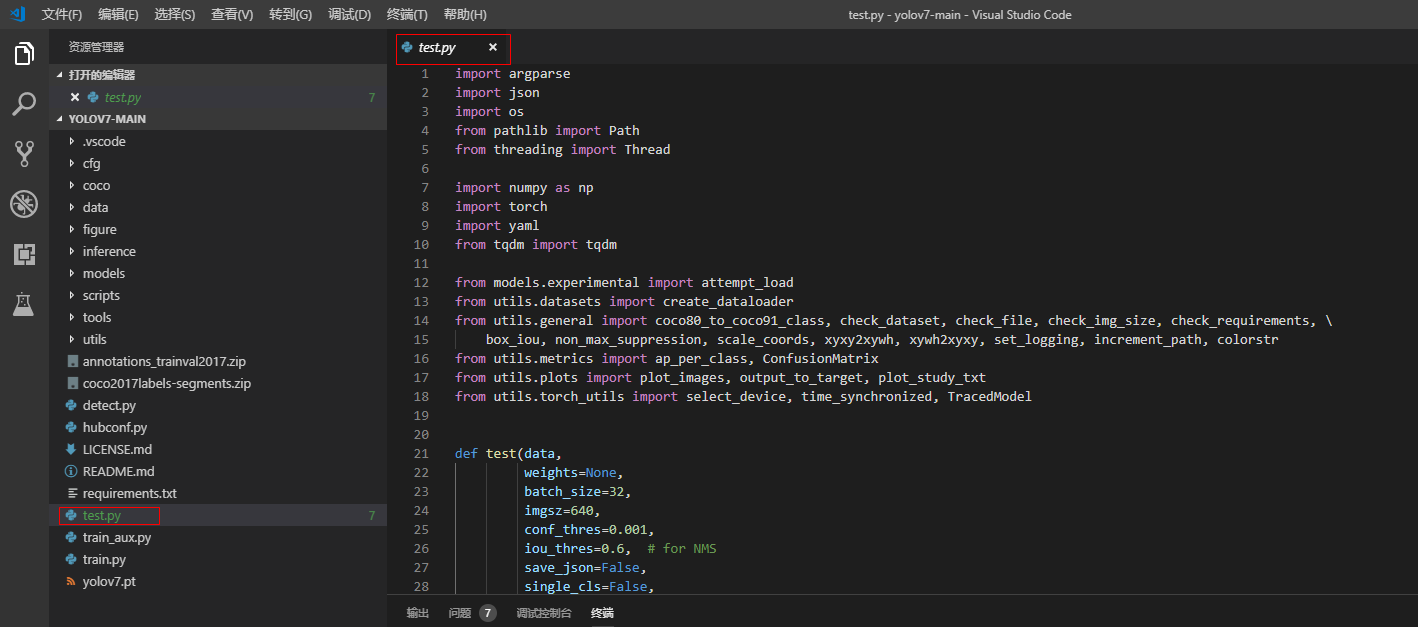

4.1 用VSCode打卡项目文件夹

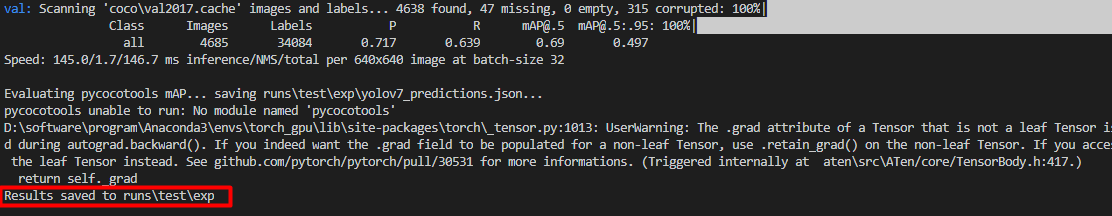

4.2 运行测试代码

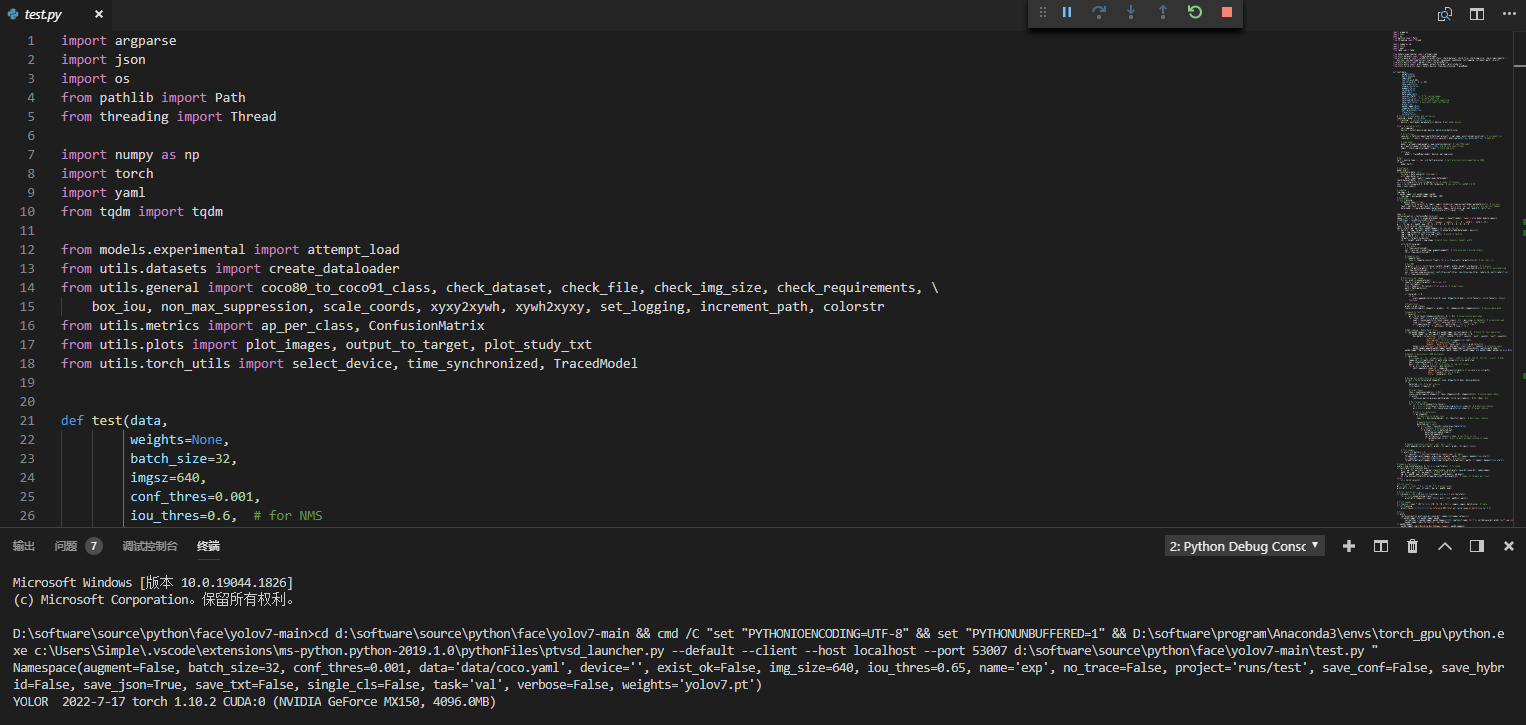

打开测试代码 test.py,并按F5运行代码(请确保Python中已经安装第一节要求的类库)

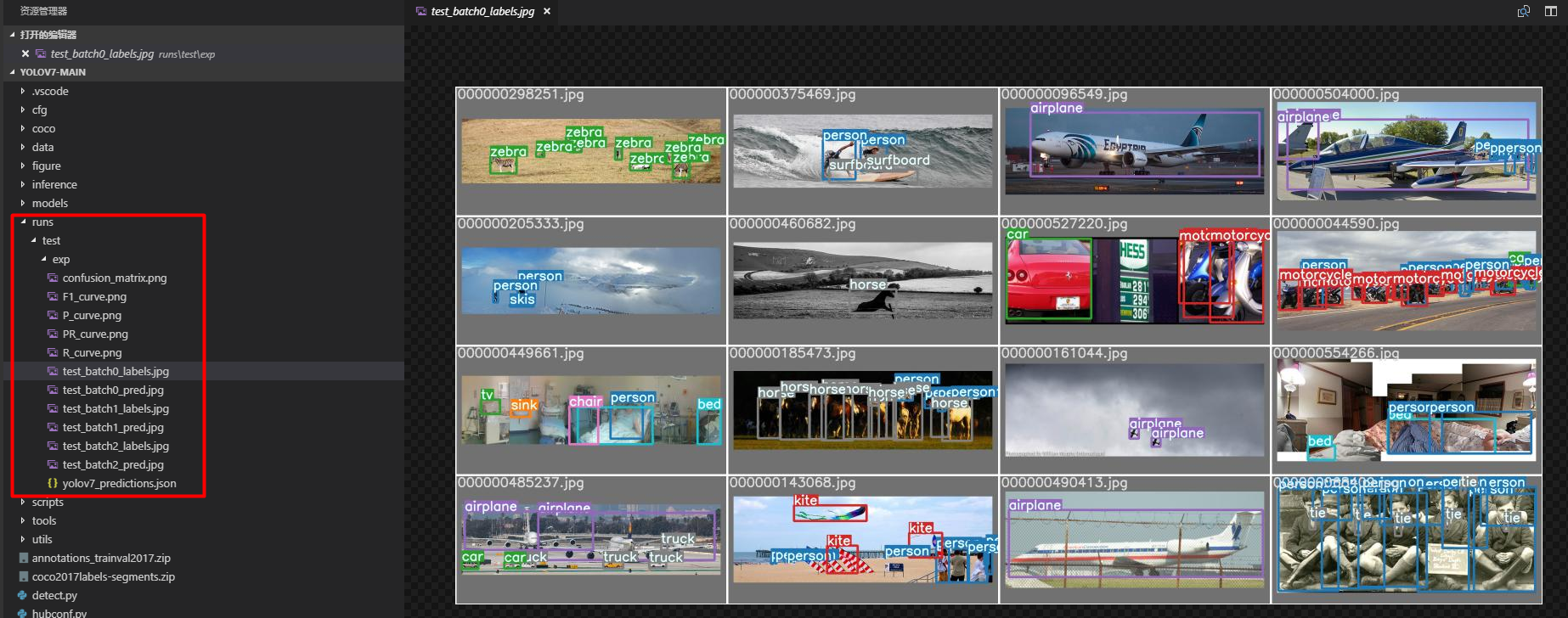

运行结果如下,测试结果会保存到runs\test\exp目录下

5. 问题

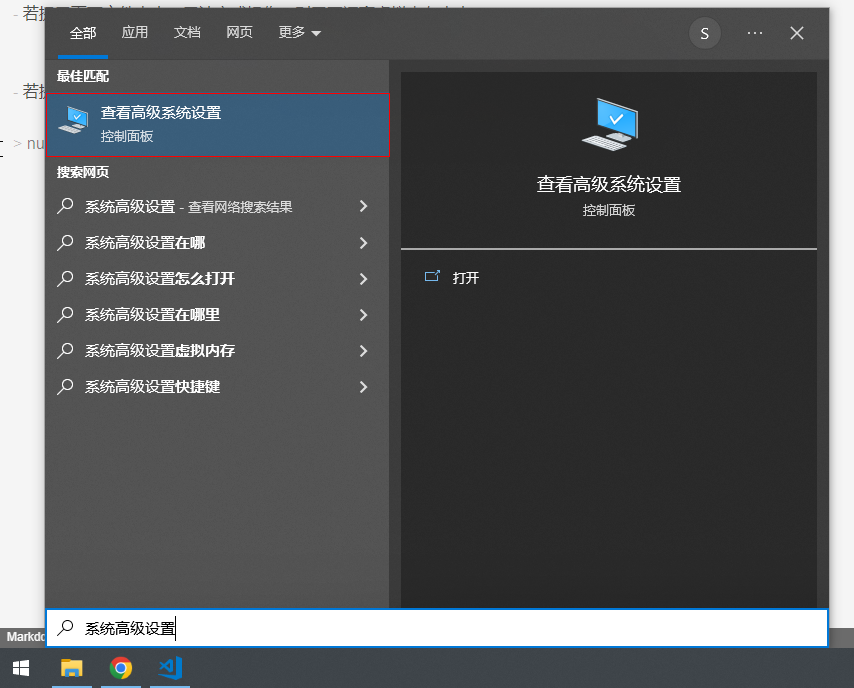

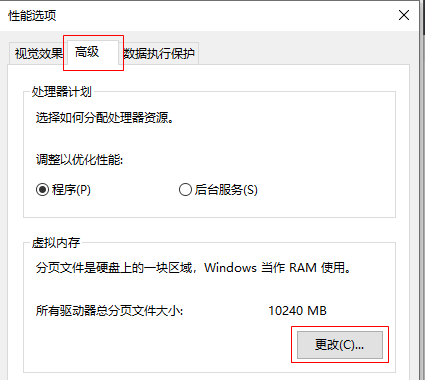

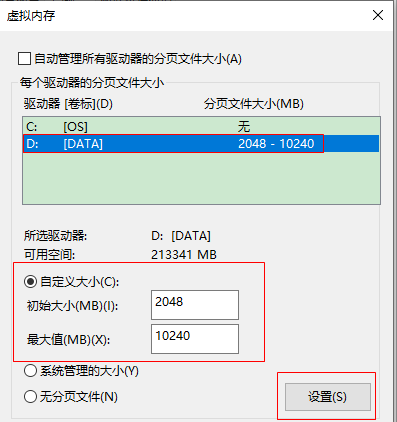

5.1 若提示页面文件太小,无法完成操作,则需要调高虚拟内存大小。

- 打开系统高级设置

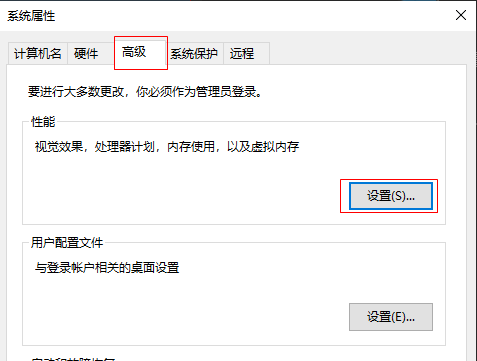

- 选择高级选项卡,点击性能框中的设置按钮

- 在打开的选项卡中,选择高级选项卡,然后点击虚拟内存框中的更改按钮

- 设置虚拟内存大小(如果C盘剩余空间较少,建议虚拟内存设置到其他盘)

- 设置完成后,点击设置按钮,并重启计算机,完成虚拟内存设置。

5.2 若提示错误:BrokenPipeError,将utils/datasets.py的87行的num_workers设置为0即可

dataloader = loader(dataset,

batch_size=batch_size,

num_workers=0,

sampler=sampler,

pin_memory=True,

collate_fn=LoadImagesAndLabels.collate_fn4 if quad else LoadImagesAndLabels.collate_fn)

版权归原作者 maerdym 所有, 如有侵权,请联系我们删除。