Ollama是一个开源的大型语言模型服务,提供了类似OpenAI的API接口和聊天界面,可以非常方便地部署最新版本的GPT模型并通过接口使用。支持热加载模型文件,无需重新启动即可切换不同的模型。

Ollama的优势

提供类似OpenAI的简单内容生成接口,极易上手使用类似ChatGPT的的聊天界面,无需开发直接与模型聊天支持热切换模型,灵活多变

搭建步骤

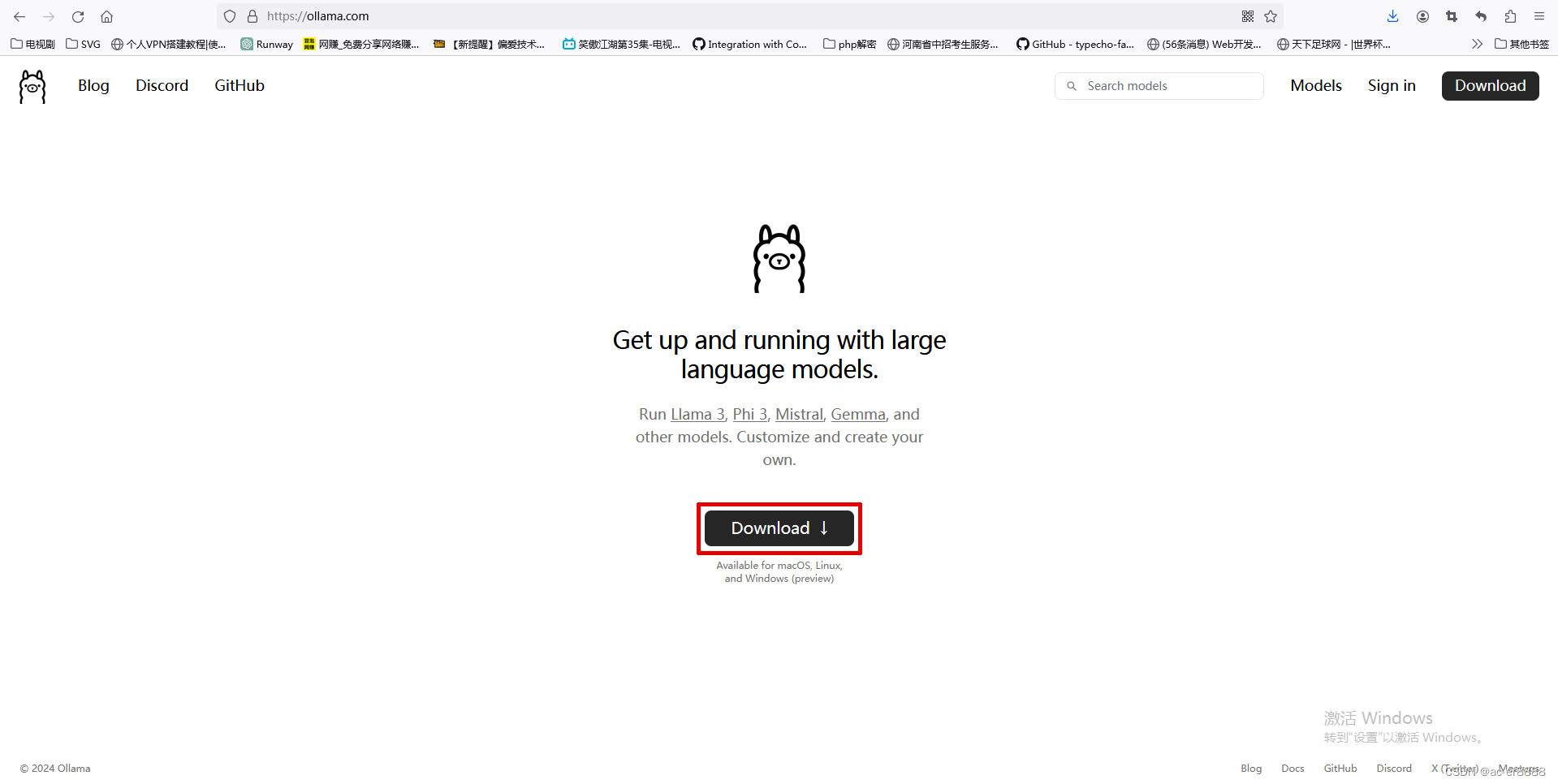

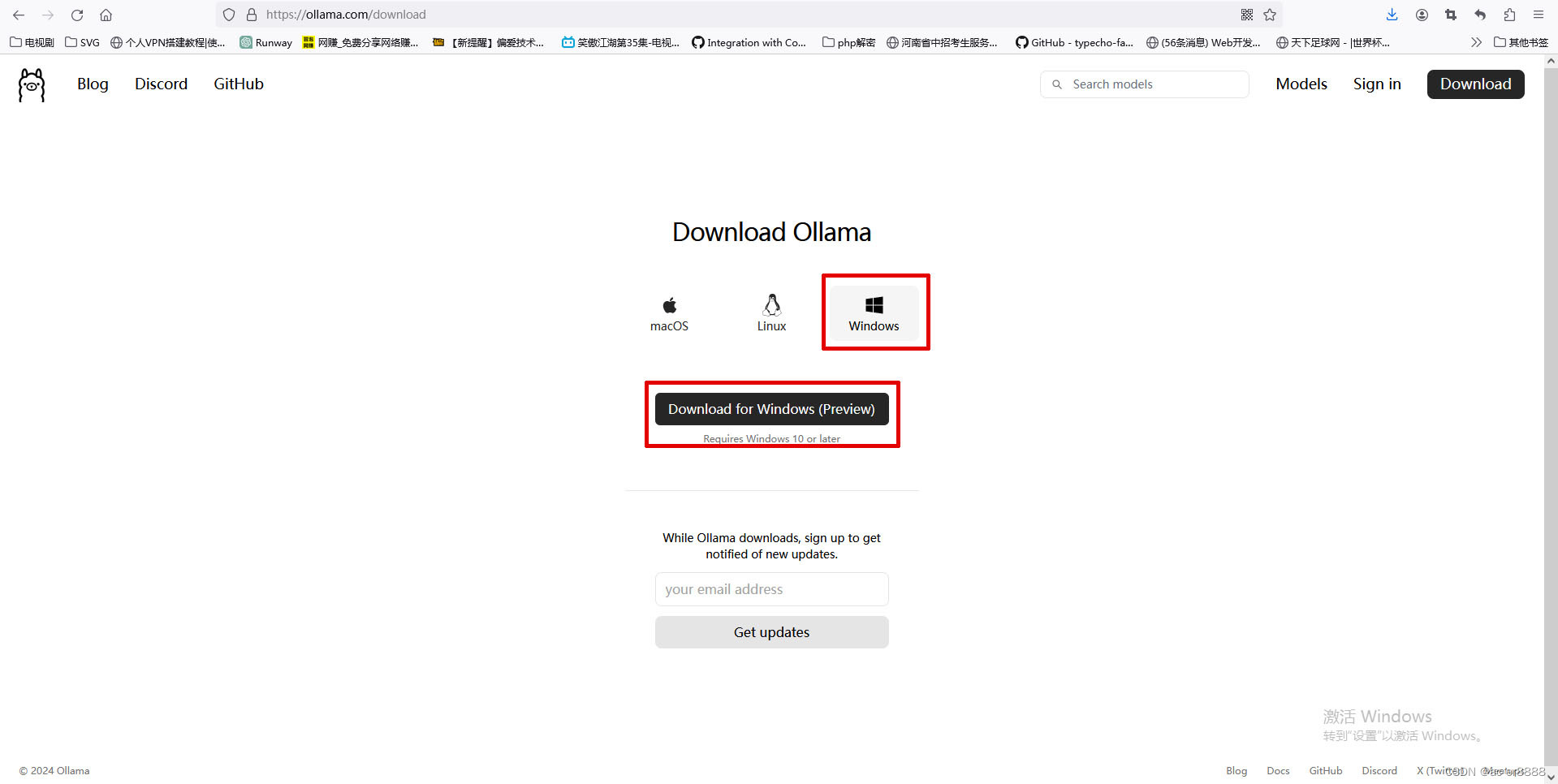

1.打开https://ollama.com/官网,点击“Download”按钮打开下载页面,选择适合自己系统的版本下载。

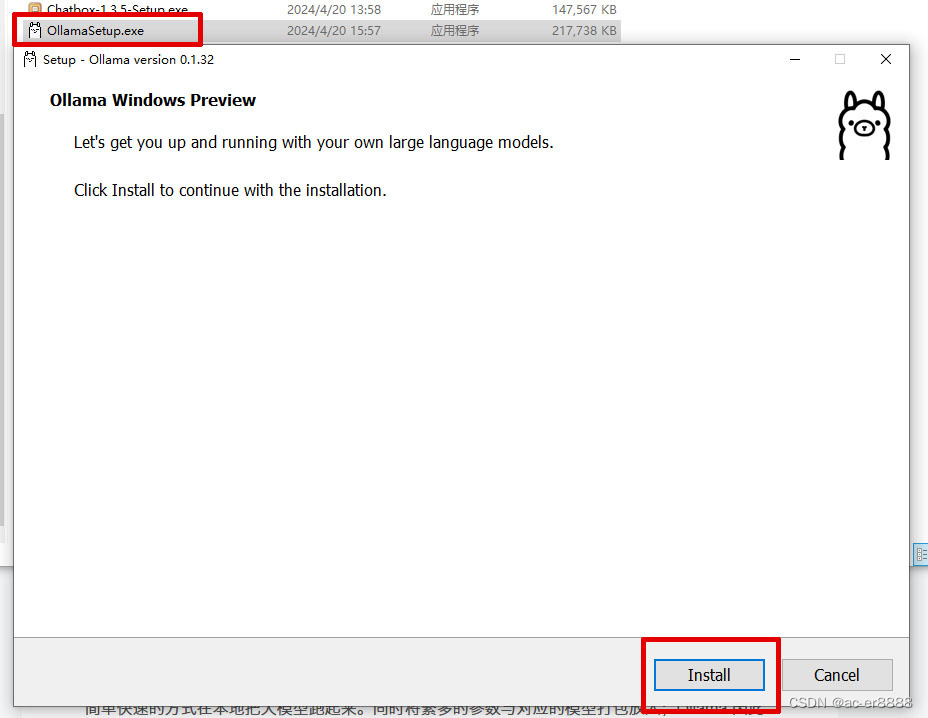

2.找到下载的Ollama安装包,一键安装。

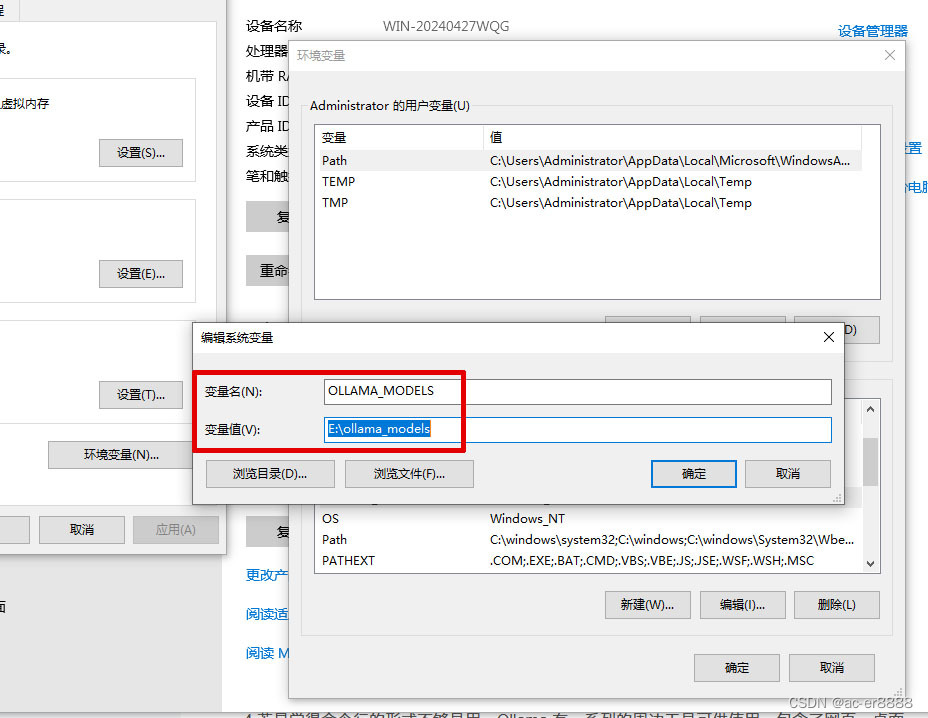

如果你想把Ollama下载的模型放到其它磁盘(默认是在C盘),打开系统环境变量设置,

添加**变量名:OLLAMA_MODELS,变量值:“你存放Ollama模型的路径”。**

设置保持后需要重启电脑,下载的模型就会存放到你设置的目录里了。

Linux可以使用提供的安装脚本一键安装Ollama,

curl -fsSL https://ollama.com/install.sh | sh

3.下载模型

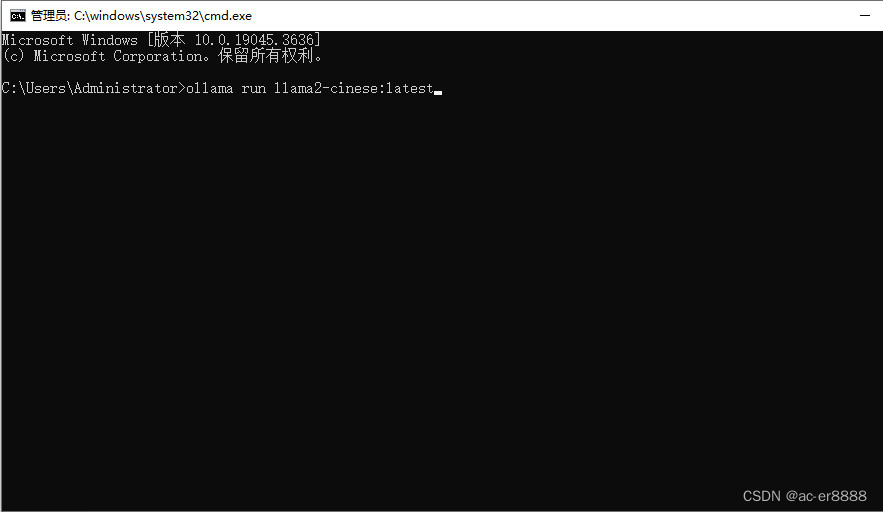

打开cmd窗口,输入指令

ollama run llama2-cinese:latest

下载一个支持中文的模型,模型下载完成后,就可以在CMD窗口进行聊天了。

4.若是觉得命令行的形式不够易用,Ollama 有一系列的周边工具可供使用,包含了网页、桌面、终端等交互界面及诸多插件和拓展。

之所以 Ollama 能快速形成如此丰富的生态,是因为它自立项之初就有清晰的定位:让更多人以最简单快速的方式在本地把大模型跑起来。同时将繁多的参数与对应的模型打包放入;Ollama 因此约等于一个简洁的命令行工具和一个稳定的服务端 API。这为下游应用和拓展提供了极大便利。

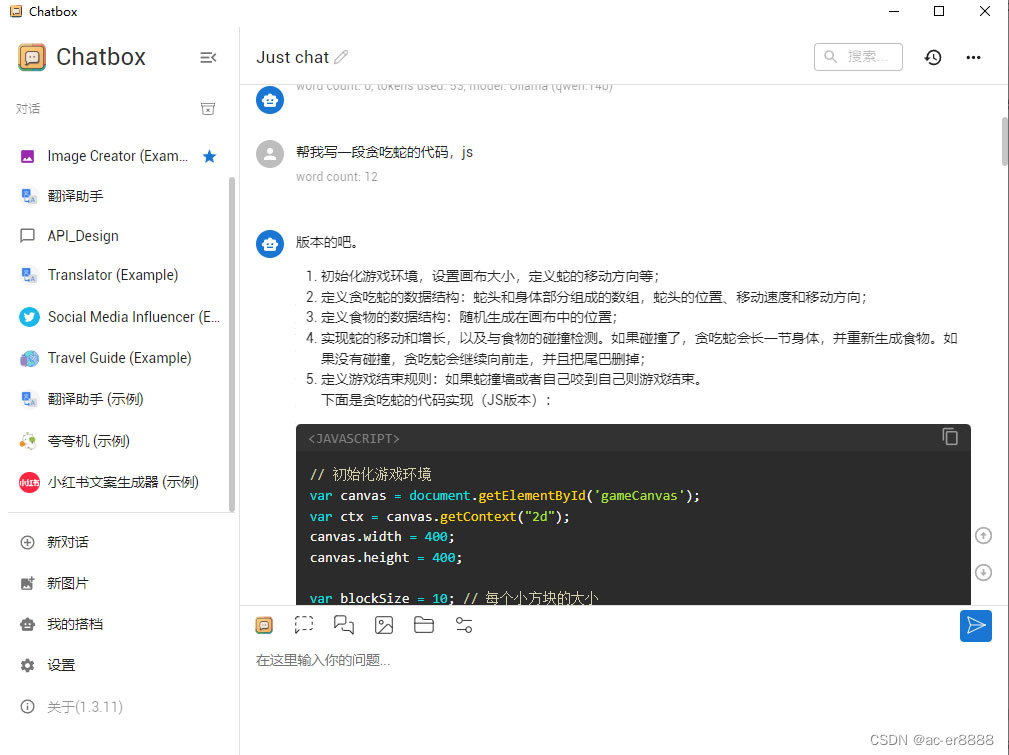

我选择一个最简单的方式:Chatbox

Chatbox是开源的 ChatGPT API (OpenAI API) 桌面客户端,Prompt 的调试与管理工具,支持 Windows、Mac 和 Linux。

github地址:https://github.com/Bin-Huang/chatbox

官网地址:Chatbox官网 - 办公学习的AI好助手,官方免费下载

下载Chatbox,一路下一步安装完成。

先启动Ollama服务器模式,

ollama sreve

如果启动失败,关闭ollama,退出ollama进程,重新启动即可。

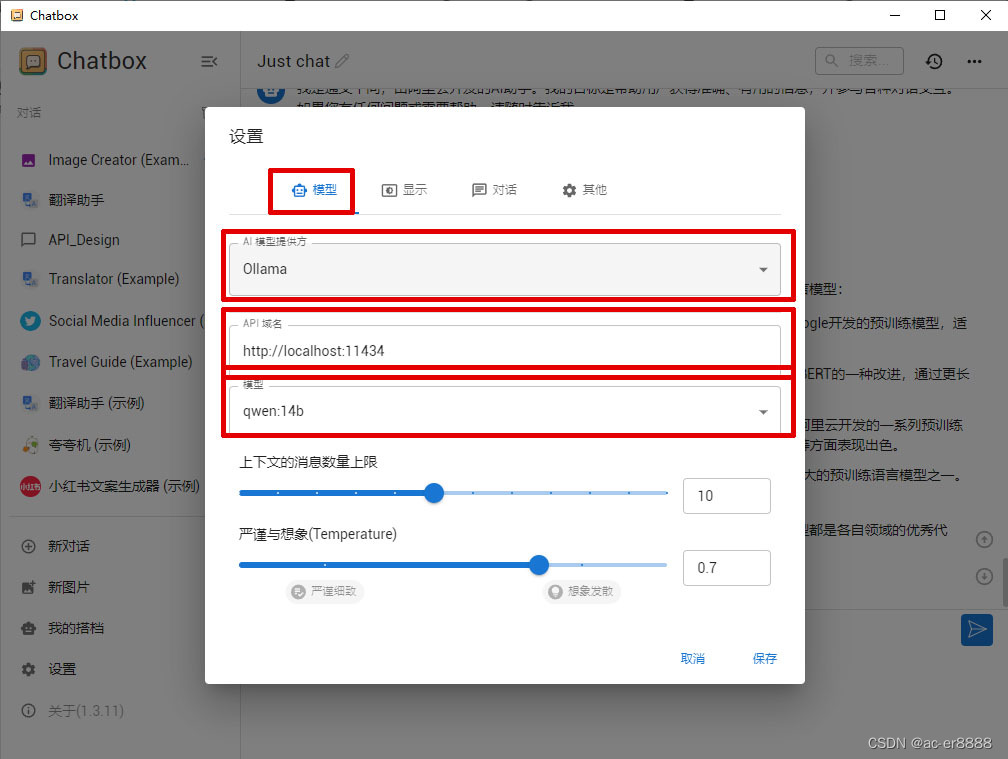

然后打开Chatbox,点击左侧的设置,在模型选项卡,选择AI模型提供方:Ollama,API域名:http://localhost:11434,模型:选择你喜欢的模型,其它默认,确定保存即可开始使用

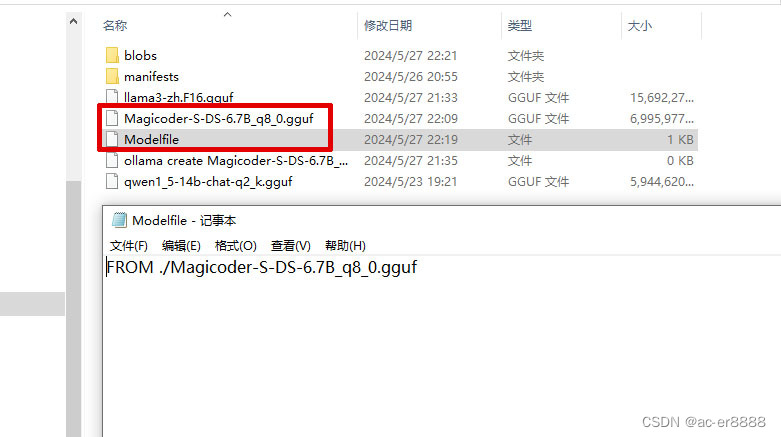

4.如果Ollama提供的模型没有你需要的,你可以从huggingface.co或modelscope.cn下载GGUF格式的模型,导入到Ollama。

** 导入方法:**在你下载好的GGUF模型目录,新建一个Modelfile文件,写入:FROM ./vicuna-33b.Q4_0.gguf(FROM后面为GGUF模型的路径)

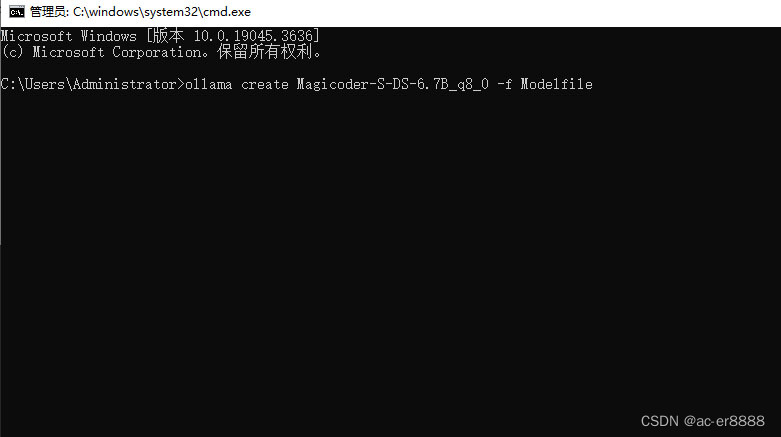

在当前目录进入cmd窗口,输入:ollama create example -f Modelfile(example为你重新命名的模型名称)

导入完成后,就可以使用了,

ollama run 你刚才导入的模型名称

版权归原作者 ac-er8888 所有, 如有侵权,请联系我们删除。