群智能优化算法改进-学习策略总结与分析

一、随机反向学习(Random opposition-based Learning, ROBL)

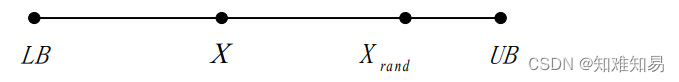

反 向 学 习 策 略 ( Opposition-based Learning, OBL) 是 Tizhoosh H R 等人提出的一种群智能优化算法改进策略,其思想是:在种群寻优的过程中,根据当前解产生一个反向解,比较当前解与反向解的目标函数值,择优进入下一次迭代。 由于反向学习策略生成的反向解与当前解距离为一定值,缺乏随机性,无法有效增强搜索空间内种群多样性。因此,Long W 等人提出了改进的随机反向学习策略(Random Opposition-based Learning, ROBL),计算公式如下:

X

r

a

n

d

=

L

B

+

U

B

−

r

∗

X

.

Xrand= LB+UB-r*X.

Xrand=LB+UB−r∗X.

r为0到1之间的随机数。

二、准反向学习(Quasi-opposition-based learning)

Rahnamayan提出了OBL的一种变体,称为准反向学习(QOBL),定义为:

x

i

o

=

l

b

i

+

u

b

i

−

x

i

.

x_i^o = l{b_i} + u{b_i} - {x_i}.

xio=lbi+ubi−xi.

x

i

q

o

=

r

a

n

d

(

l

b

i

+

u

b

i

2

,

x

i

o

)

.

{\rm{x}}_i^{qo} = rand(\frac{{l{b_i} + u{b_i}}}{2},x_i^o).

xiqo=rand(2lbi+ubi,xio).

即得到的新位置位于中间值与反向位置之间。

三、准反射学习(Quasi-reflection-based learning)

基于OBL和QOBL,Qian Fan提出了准反射学习(QRBL),定义为:

x

i

q

r

=

r

a

n

d

(

l

b

i

+

u

b

i

2

,

x

i

)

.

{\rm{x}}_i^{qr} = rand(\frac{{l{b_i} + u{b_i}}}{2},{x_i}).

xiqr=rand(2lbi+ubi,xi).

即得到的新位置位于中间值与当前位置之间。

四、动态反向学习

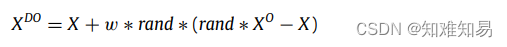

还有动态反向学习(DOL):

可参考:Dynamic opposite learning enhanced teaching–learning-based optimization

五、总结

学习策略非常灵活,可以用于初始化阶段,也可用于种群迭代阶段。其形式也多种多样,变体很多,与其它策略有很好的相容性,是多策略改进算法中非常常见的一种。

版权归原作者 知难知易 所有, 如有侵权,请联系我们删除。