目录

1 ChatGPT中的强化学习

2015年,

OpenAI

由马斯克、美国创业孵化器Y Combinator总裁阿尔特曼、全球在线支付平台PayPal联合创始人彼得·蒂尔等硅谷科技大亨创立,公司核心宗旨在于**实现安全的通用人工智能(AGI)**,使其有益于人类。

ChatGPT

是

OpenAI

推出的一个基于对话的原型 AI 聊天机器人,2022年12 月 1 日,

OpenAI

的联合创始人山姆·奥特曼在推特上公布

ChatGPT

并邀请人们免费试用

ChatGPT

可以与人类进行谈话般的交互,可以回答追问,连续性的问题,承认其回答中的错误,指出人类提问时的不正确前提,拒绝回答不适当的问题,其性能大大超乎人们对弱人工智能的想象。

ChatGPT

魔力的关键因素之一可以追溯到2017年的概念人类反馈强化学习(RLHF)

RLHF的关键在于在难以明确规定任务的强化学习环境中操作,在这些情景下,人类反馈可能产生巨大的影响。RLHF利用人类评估者的少量反馈来引导智能体对目标及其相应奖励函数的理解。

RLHF的训练过程大致阐述为

智能体从环境中随机采取行动,智能体每隔一段时间向人类评估者展示学习效果。根据效果,评估者会施加引导信息,智能体然后利用这个反馈逐渐建立起一个最能解释人类判断的目标和奖励函数的模型。一旦智能体对目标及其相应奖励函数有了清晰的理解,它就使用传统强化学习方法来学习如何实现该目标。随着行为的改善,智能体会继续请求关于它最不确定哪个更好的轨迹对的人类反馈,进一步完善对目标的理解

ChatGPT

是大型语言模型的缩影,而这个领域已成为应用现代强化学习技术最有趣的领域之一。接下来,我们将介绍深度强化学习的基本概念,以及有效的学习路线

2 环境与智能体的交互

**环境(Environment)**是机器学习任务所依赖的物理规则与载体,例如

- 在下棋对弈任务中,环境是棋盘、对手与游戏规则

- 在机器人控制任务中,环境是机器人硬件、任务场景与物理定律

- …

**智能体(Agent)是存在于环境中的实例,智能体必须依赖环境,并与环境产生交互。智能体不能改变环境的物理规则,但可以通过传感器(Sensor)观察来感知环境(感知的结果称为状态),通过决策器(decision maker)来根据状态决定将要采取的行动,最后通过执行器(Actuator)**动作来影响环境。

举例而言

- 人类Agent有眼睛、耳朵和其他器官等传感器,也有手、腿、声道等作为执行器

- 硬件Agent可能用摄像头、红外测距仪作为传感器,各种马达作为执行器

- 软件Agent接受键盘敲击、文件内容和网络数据包作为传感器输入,并以屏幕显示、写文件和发送网络数据包为执行器

- …

Agent的核心是决策器,其内部存在一个从感知到行为的映射,称为Agent函数(或称之为策略)。Agent函数的具体实现过程称为Agent程序,机器学习等人工智能学科就是一系列Agent程序设计的方法论。Agent根据外部环境感知做出相应行为,很自然地需要判断Agent函数的好坏。若这个行为符合期望,则认为智能体是**理性的(Rational)**。

3 强化学习特征四元组

接下来,我们正式给出经典强化学习的定义

**强化学习(Reinforcement Learning, RL)是在潜在的不确定复杂环境中,训练一个最优决策

π

\pi

π指导一系列行动实现目标最优化的机器学习方法**。

强化学习与监督学习的不同之处在于不需要进行样本标注,核心是通过奖励期望行动和惩罚非期望行动的方式在探索(未知领域)和利用(现有知识)之间找到平衡。

在初始情况下,没有训练数据告诉强化学习智能体并不知道在环境中应该针对何种状态采取什么行动,而是通过不断试错得到最终结果,再反馈修正之前采取的策略,因此强化学习某种意义上可以视为具有“延迟标记信息”的监督学习问题。

强化学习的基本过程是:智能体对环境采取某种行动

a

a

a,观察到环境状态发生转移

s

0

→

s

s_0\rightarrow s

s0→s,反馈给智能体转移后的状态

s

s

s和对这种转移的奖赏

r

r

r。综上所述,一个强化学习任务可以用四元组

E

=

<

S

,

A

,

P

,

R

>

E=\left< S,A,P,R \right>

E=⟨S,A,P,R⟩表征

- 状态空间 S S S:每个状态 s ∈ S s \in S s∈S是智能体对感知环境的描述;

- 动作空间 A A A:每个动作 a ∈ A a \in A a∈A是智能体能够采取的行动;

- 状态转移概率 P P P:某个动作 a ∈ A a \in A a∈A作用于处在某个状态 s ∈ S s \in S s∈S的环境中,使环境按某种概率分布 P P P转换到另一个状态;

- 奖赏函数 R R R:表示智能体对状态 s ∈ S s \in S s∈S下采取动作 a ∈ A a \in A a∈A导致状态转移的期望度,通常 r > 0 r>0 r>0为期望行动, r < 0 r<0 r<0为非期望行动。

状态空间有限的基本强化学习可以用马尔科夫决策过程进行抽象建模,可见机器学习强基计划6-1:图文详细总结马尔科夫链及其性质(附例题分析)

4 深度强化学习的引入

传统强化学习大多基于数值离散状态空间的任务,即根据所有数值组合的状态是有限的,但现实中往往面临数值连续的无限状态空间。例如围棋任务的状态空间规模高达

1

0

17

10^{17}

1017;自动驾驶任务中状态可能由激光雷达、陀螺仪、里程计的连续数值共同组成。庞大的状态空间导致无法维护内部用以决策的数据结构——例如Q-Learning算法的Q-Table,因此引入**深度强化学习(Deep Reinforcement Learning, DRL)**。

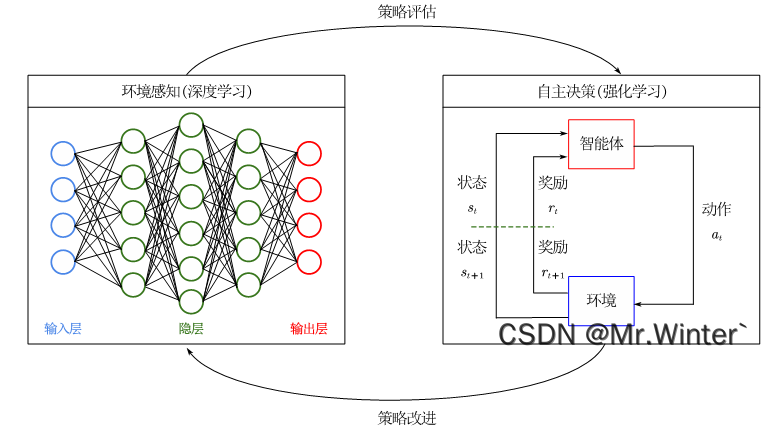

深度强化学习融合了深度学习和强化学习框架,其中

- 深度学习负责感知和拟合非结构化的环境输入信息,而不依赖于对状态空间的人工建模,克服了无限状态空间问题;

- 强化学习负责通过奖励期望行动和惩罚非期望行动的方式在探索(未知领域)和利用(现有知识)之间找到平衡;

深度强化学习使智能体具有在未知环境中做出复杂决策的能力,在机器人、游戏、自然语言处理等诸多领域得到广泛应用。如图所示,深度学习为强化学习提供了策略评估,而强化学习根据评估值进行策略改进,与环境交互产生训练样本反馈给神经网络,增强其感知能力

5 教程大纲

本专栏将重点介绍强化学习技术,并且采用Pytorch框架对常见的强化学习算法、案例进行实现,帮助读者理解原理。同时,辅以各种机器学习、数据处理技术,弥补一些人工智能的底层知识

🔥 专栏地址:Pytorch深度强化学习,具体大纲如下

🚀 第一章——经典强化学习理论

- 通用人工智能之路:什么是强化学习?如何结合深度学习?

- Pytorch深度强化学习1-1:Gym安装与环境搭建教程(附基本指令表)

- Pytorch深度强化学习1-2:详解K摇臂赌博机模型和 ϵ \epsilon ϵ-贪心算法

- Pytorch深度强化学习1-3:策略评估与贝尔曼期望方程详细推导

- Pytorch深度强化学习1-4:策略改进定理与贝尔曼最优方程

- Pytorch深度强化学习1-5:详解蒙特卡洛强化学习原理

- Pytorch深度强化学习1-6:详解时序差分强化学习(SARSA、Q-Learning算法)

🚀 第二章——深度强化学习理论

- Pytorch深度强化学习2-1:基于价值的强化学习——DQN算法

- Pytorch深度强化学习2-2:基于价值的强化学习——Prioritized Replay DQN

- Pytorch深度强化学习2-3:基于价值的强化学习——Dueling DQN

- Pytorch深度强化学习2-4:基于策略的强化学习——策略梯度定理

- Pytorch深度强化学习2-5:基于策略的强化学习——基线优化(Baseline)

- Pytorch深度强化学习2-6:演员-评论家框架——A2C与A3C算法

- Pytorch深度强化学习2-7:演员-评论家框架——DDPG与TD3算法

🚀 第三章——深度强化学习案例

- Pytorch深度强化学习案例:基于DQN实现Flappy Bird游戏与分析

加入我们

目前博主正在组建深度学习技术交流群,群中成员是有明确共同目标,共同愿景的,这样才能共同成长,所以只要你想学好机器学习、深度学习就请加入我们(下方名片),让我们一起从理论到实践攻克深度学习,为从事相关工作或科研打下基础!

当然群里也配套长期更新的网盘资源福利等你领取!

上面给出的是教程的大致大纲,后面可能会有顺序和内容的调整,但可以保证内容量只增不减,更新频率为一周1~2更。所有应用类内容都配有代码,可以放心使用

🔥 更多精彩专栏:

《ROS从入门到精通》

《Pytorch深度学习实战》

《机器学习强基计划》

《运动规划实战精讲》

…

👇源码获取 · 技术交流 · 抱团学习 · 咨询分享 请联系👇

版权归原作者 Mr.Winter` 所有, 如有侵权,请联系我们删除。