完全离线linux 版open webui 的搭建

1.在具有网络连接的环境中下载whl

在有网络的环境,使用pip download可以保存所有的依赖包,可以使用-i 指定清华的镜像源加速下载速度。

# 命令:

pip download <package_name> --only-binary=:all: --wheel --platform <platform_tag> --python-version <python_version># 示例

pip download -d e:\temp\openweuiwhi_linux open-webui --only-binary=:all: --platform linux_x86_64 --python-version 311 -i https://pypi.tuna.tsinghua.edu.cn/simple

注意:如果windows要下载linux的还要指定系统 --platform

下图是我依赖截图其中几个,我下载后依赖了200多个其他包:

下载的时候要注意,两个环境python版本最好一致,因为很多包是要求python版本的

比如这里面的311就要求是Python3.11版本

2.拷贝whl 包到无网络环境安装

进入到上述依赖包的文件夹,执行安装,如下:

pip.exe install --no-index --find-links . .\open_webui-0.3.28-py3-none-any.whl

该命令会自动的寻找openwebui 在当前路径下的依赖安装

2.1安装中的小问题

安装的时候报错版本不符合要求,升级setuptools和pip(pip版本比较低的时候,无法安装其中的tar.gz的文件)

pip install setuptools-75.1.0-py3-none-any.whl

python.exe -m pip install pip-24.2-py3-none-any.whl

如果中间遇到某一个tar.gz的包无法安装成功,可以解压缩,进入到解压缩后的目录,用包中的setup单独安装下:

python.exe setup.py install

然后重新安装,出现如下就是安装成功了

pip list也可以看到安装的open webui了

如果open-webui 在powershell找不到,可以加到环境变量中:

3.启动

open-webui.exe serve

3.1 启动中的问题

启动的时候肯定会报错,如下:

openwebui默认需要联网下载模型,联网环境连不上hugging face,而我们完全离线的环境连网络都上不去,解决方法如下:

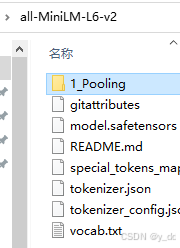

- 提前下载好模型 官网:https://hf-mirror.com/sentence-transformers/all-MiniLM-L6-v2/tree/main

- 修改openwebui的代码,启动时从本地环境加载模型 具体修改的位置可以参考报错,比如加载模型的时候在下面报错了:

在上面提示的路径找到utils.py,打开这个文件,大致看一下,修改这行为固定地址:

model_repo_path ="D:\\install\\sentence-transformers\\all-MiniLM-L6-v2"

然后再次启动,出现如下,就是安装成功了

默认的运行端口是 8080,所以启动后,浏览器输入127.0.0.1:8080,就可以使用openwebui了

点注册,输入账号和密码,第一个账号默认为管理员,open web ui就可以使用了

版权归原作者 y_dd 所有, 如有侵权,请联系我们删除。