提示学习prompt

为什么要用提示学习? 下游任务的目标与预训练的目标差距过大导致提升效果不明显,微调过程中依赖大量的监督语料

下游任务的目标与预训练的目标差距过大导致提升效果不明显,微调过程中依赖大量的监督语料

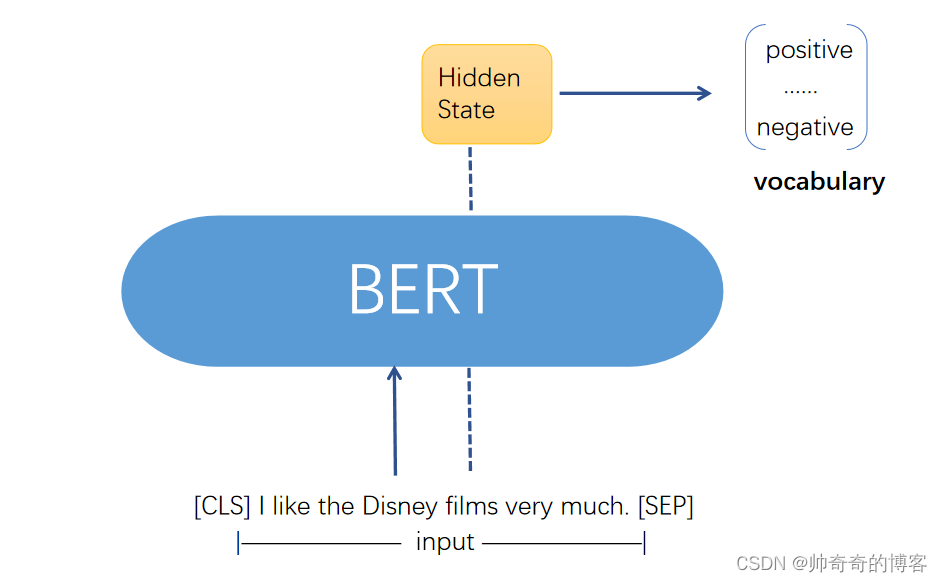

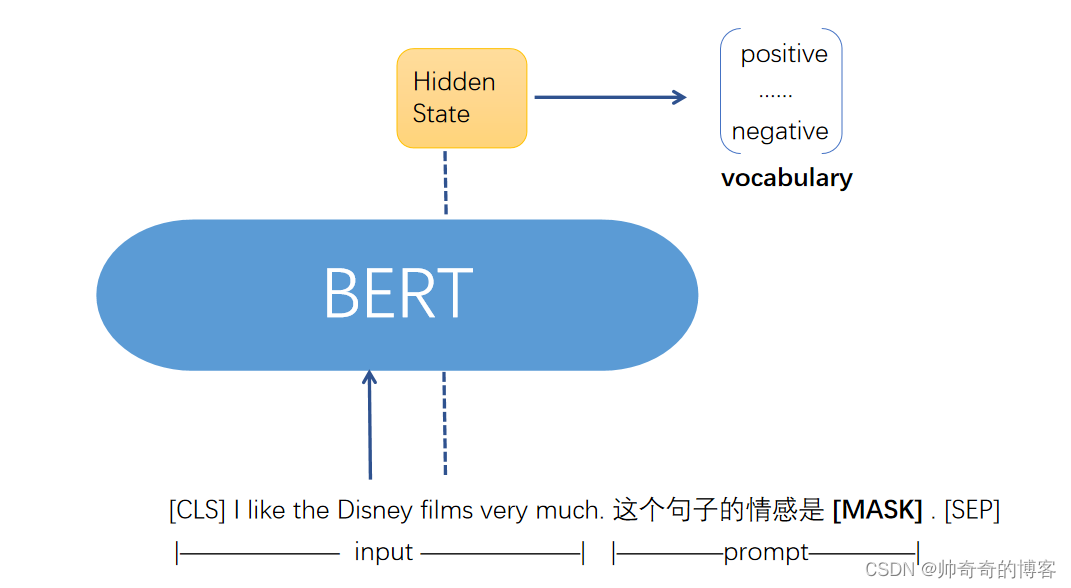

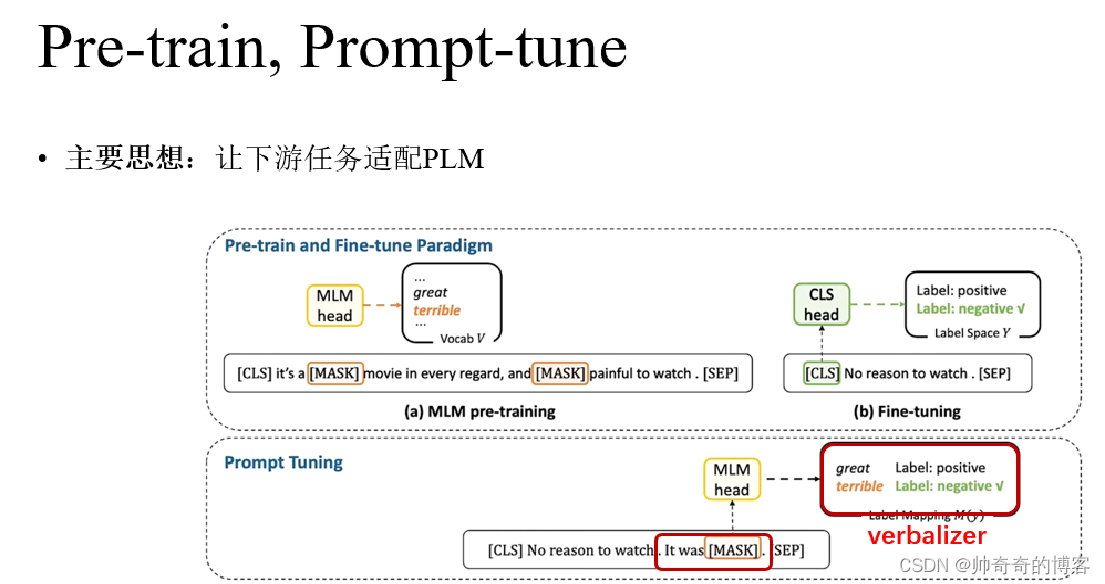

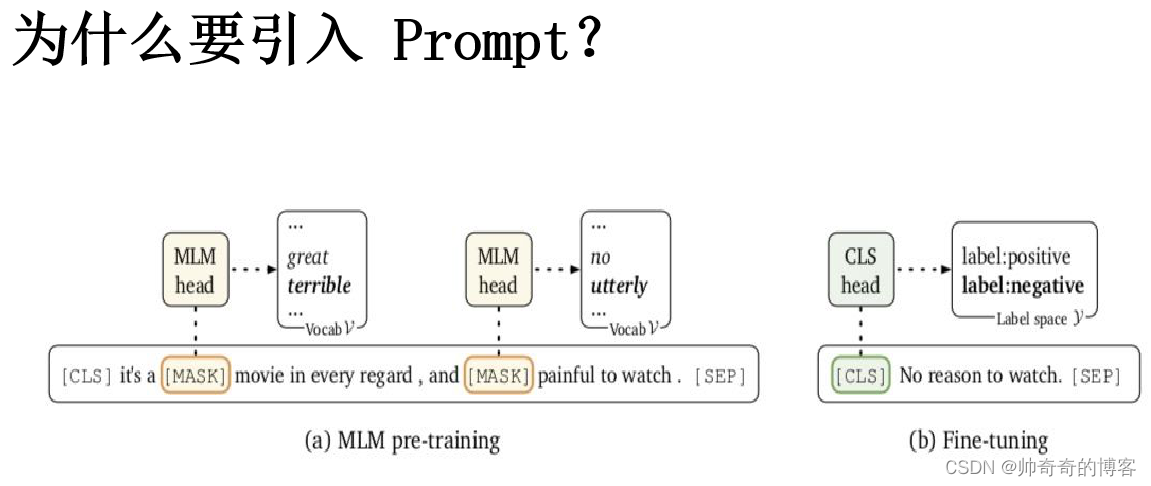

降低语义差异:预训练任务主要以(MLM)为主,而下游任务则重新引入新的训练参数,因此两个阶段的目标通常有较大差异;

避免过拟合:由于再Fine-tuning阶段需要新引入额外的参数以适配相应的任务需要,因此在样本数量有限的情况容易发生过拟合,降低了模型的泛化能力。

提示:写完文章后,目录可以自动生成,如何生成可参考右边的帮助文档

文章目录

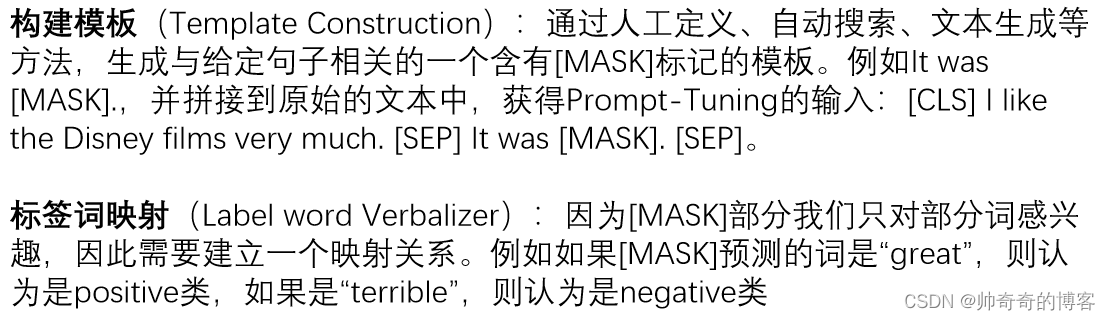

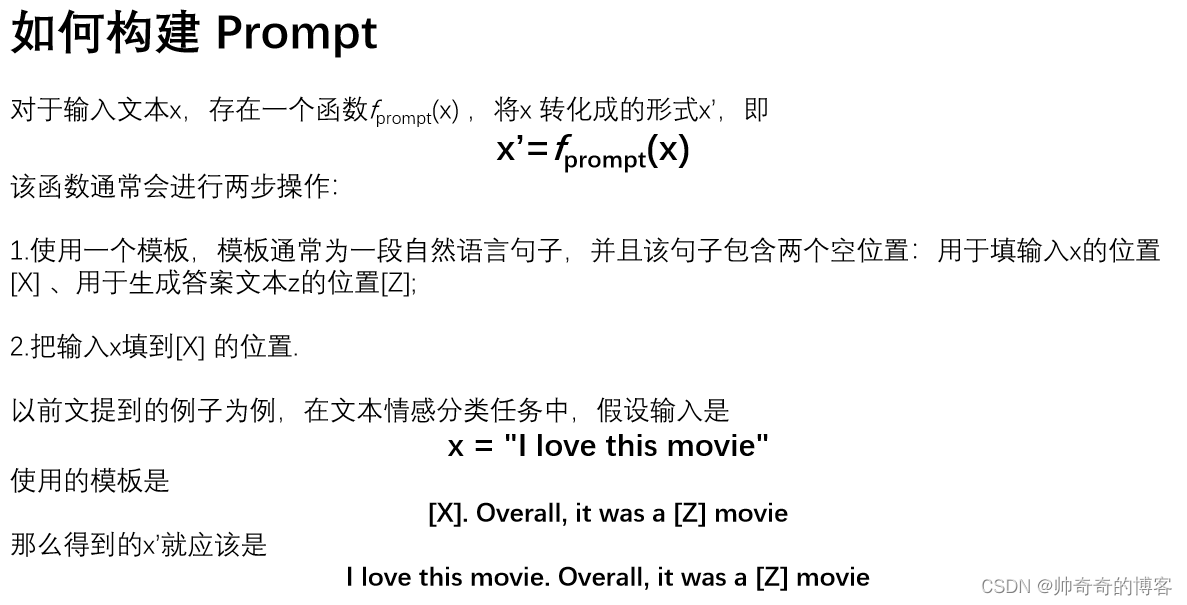

一、Prompt工作原理

提示:这里可以添加本文要记录的大概内容:

例如:随着人工智能的不断发展,机器学习这门技术也越来越重要,很多人都开启了学习机器学习,本文就介绍了机器学习的基础内容。

提示:以下是本篇文章正文内容,下面案例可供参考

二、提示学习的组成部分

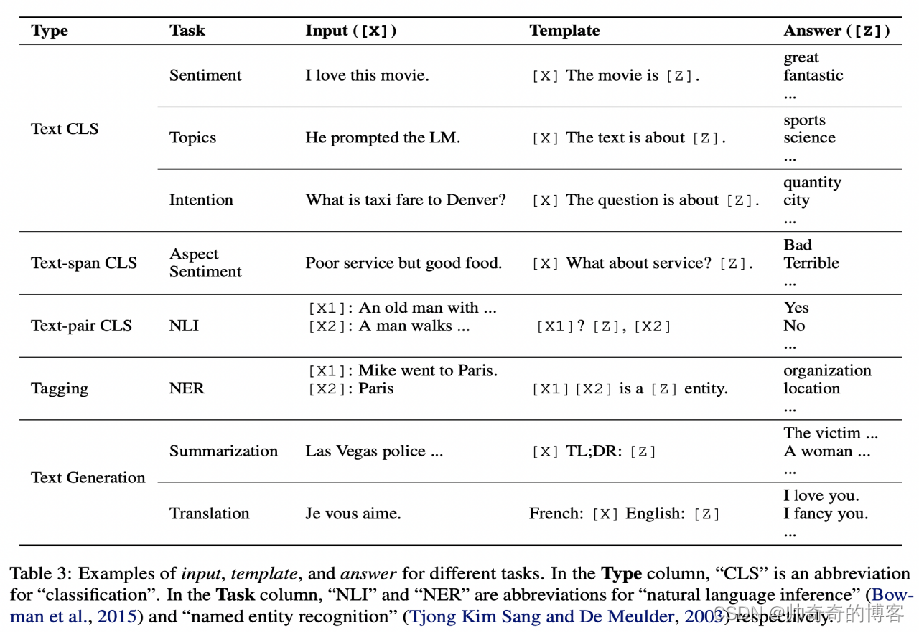

其他 NLP 任务的 Prompt 如何设计呢?实际上刘鹏飞大神在他的论文中给我们提供了一些参考

三、提示学习的设计

1.人工设计模板

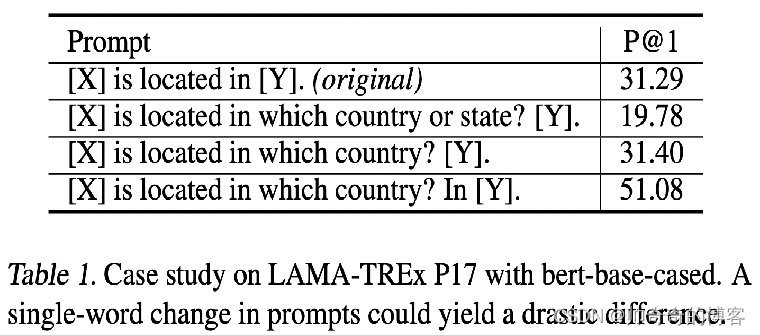

Prompt 的模板最开始是人工设计的,人工设计一般基于人类的自然语言知识,力求得到语义流畅且高效的「模板」。人工设计模板的优点是直观,但缺点是需要很多实验、经验以及语言专业知识。下图是 GPT Understands, Too 论文中的一个实验结果

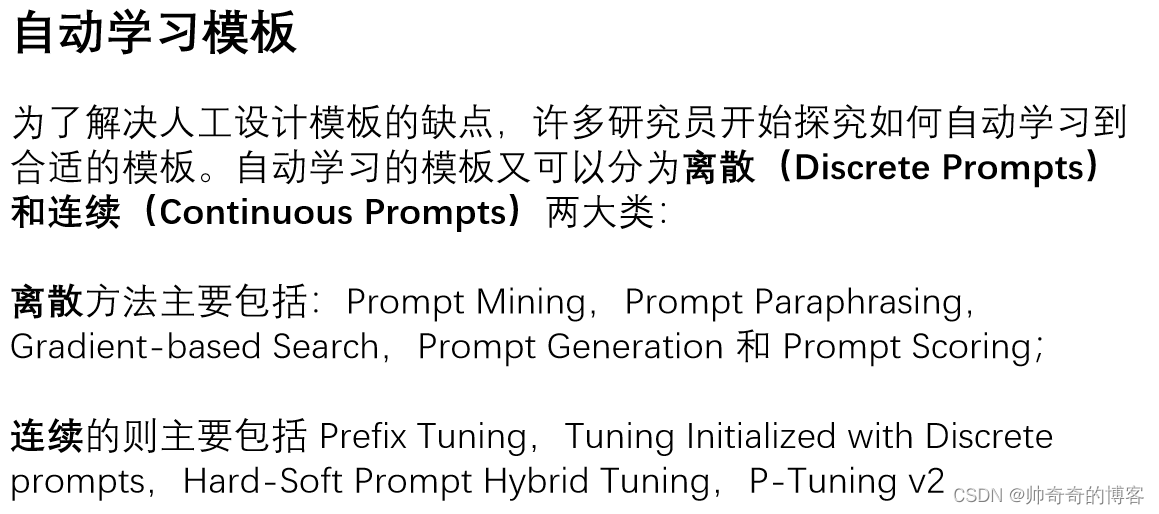

2.自动学习模板

四、为什么引入prompt

Prompt的挑战与展望

Prompt的设计问题。目前使用Prompt的工作大多集中于分类任务和生成任务,其它任务则较少,因为如何有效地将预训练任务和prompt联系起来还是一个值得探讨的问题。另外,模板和答案的联系也函待解决。如何同时搜索或者学习出两者联合的最好效果仍然很具挑战性。

Prompt的理论分析和可解释性。尽管Prompt方法在很多情况下都取得了成功,但是目前prompt-based learning的理论分析和保证还很少,使得人们很难了解Prompt为什么能达到好的效果,又为什么在自然语言中意义相近的Prompt有时效果却相差很大。

Prompt在PLM debias方面的应用。由于PLM在预训练过程中见过了大量的人类世界的自然语言,所以很自然地受到了影响。比如说训练语料中有很多的"The capital of China is “Beijing.”,导致模型认为下次看到"capital" 的时候都会预测出"Beijing",而不是着重看到底是哪个国家的首都。在应用的过程中,Prompt还暴露了PLM学习到的很多其它bias,比如种族歧视、恐怖主义、性别对立等等。

五、参考文献

版权归原作者 帅奇奇的博客 所有, 如有侵权,请联系我们删除。