大模型通过赋能安全,如代码补丁自动生成、安全功能代码生成、恶意代码分析、代码相似性分析、事件关联分析等,来驱动安全。大模型可以基于计算机程序代码作为语料进行预训练或优化训练,从而实现自动化修复安全漏洞、生成安全功能代码等功能。此外,大模型还可以通过自然语言文本自然语言标签、安全功能代码理解、恶意代码分析等手段,实现对安全漏洞的检测和修复。

1. 大模型如何赋能安全

- 文本分类:LLM 可以用于训练文本分类器,对文档进行分类或标记。这对于网络安全领域非常重要,因为网络威胁往往以各种形式出现,如恶意软件、钓鱼邮件、网络钓鱼等。

- 威胁检测和识别:LLM 可以对大量的网络流量数据进行处理和分析,检测和识别潜在的威胁。这种方法被称为实时威胁检测或实时入侵检测。

- 漏洞挖掘:LLM 可以利用其强大的文本处理和自然语言理解能力,自动识别和挖掘潜在的软件漏洞。这对于安全研究人员和漏洞报告者来说是非常有用的。

- 自动化安全分析:LLM 可以用于自动化安全分析,帮助安全团队快速发现潜在的安全问题。这种方法被称为自动化安全审计或自动化风险评估。

- 风险评估和合规性检查:LLM 可以用于自动化风险评估和合规性检查,帮助企业或组织了解其面临的安全风险和遵守相关法规。

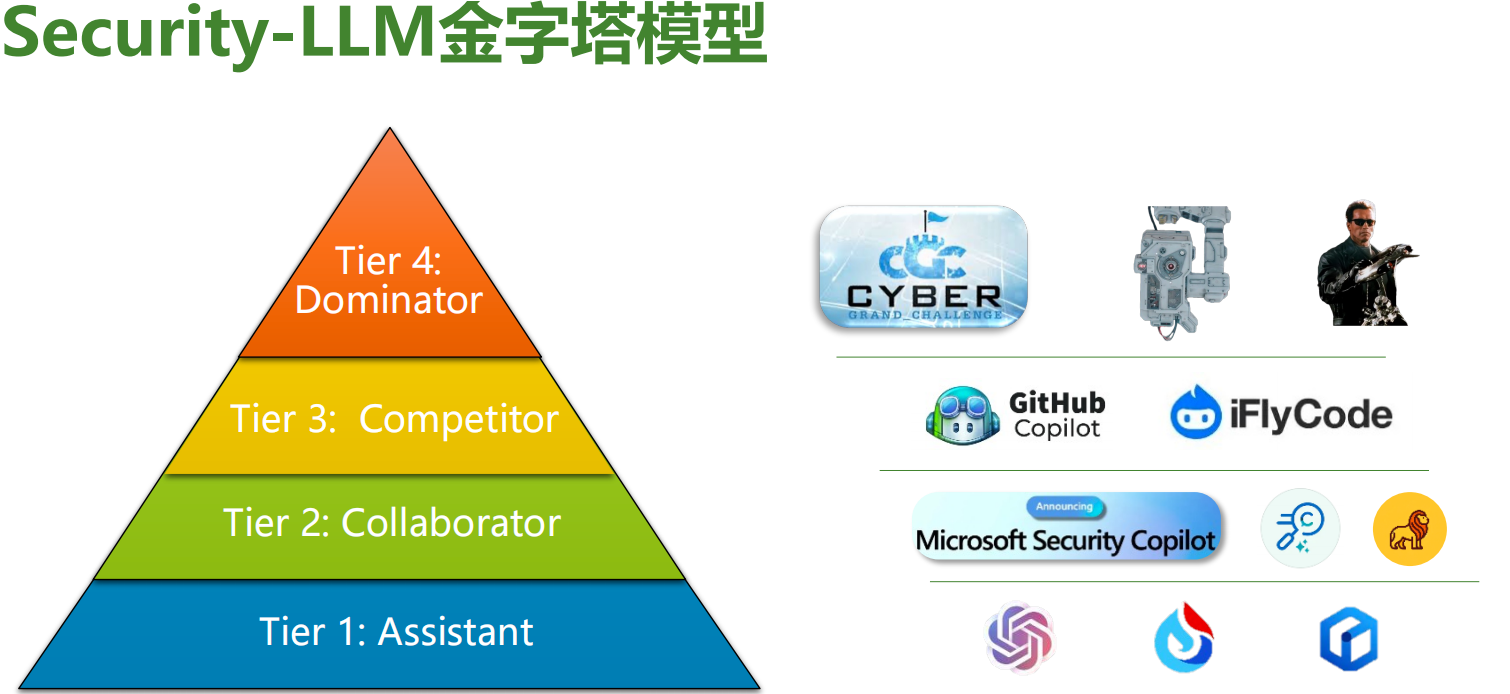

2. 大模型在安全领域的实践与探索

当前已经有了一些探索,例如:

- 网络安全日志分析:研究者利用LLM分析网络安全日志,识别异常行为和潜在攻击,提高安全团队的响应速度。

- 利用 LLM 进行垃圾邮件过滤:一些研究团队已经尝试将 LLM 应用于垃圾邮件过滤,取得了很好的效果。

- 利用 LLM 进行软件漏洞挖掘:一些研究团队已经开发出基于 LLM 的漏洞挖掘工具,能够自动识别和挖掘软件中的漏洞。(如悬镜灵脉PTE AI多引擎驱动的新一代自动化渗透测试平台)

- 社会工程和钓鱼攻击检测:LLM可以帮助检测社会工程和钓鱼攻击中使用的欺骗性语言和手段。通过学习欺骗性文本的模式,LLM可以帮助用户识别潜在的欺骗性信息,提高网络安全意识。

总的来说,LLM 在安全领域有着广泛的应用前景,随着技术的不断发展和完善,未来将会出现更多的探索和应用。

3. 大模型在安全领域的局限性

大模型(如深度学习模型)应用于网络安全领域时,可能会遇到以下一些局限性:

- 数据稀缺性: 在网络安全领域,获取高质量的标记数据集可能会很困难。由于网络攻击的复杂性和多样性,构建具有代表性的数据集可能需要大量的时间和资源。

- 对抗性攻击: 大模型往往容易受到对抗性攻击的影响,攻击者可以通过微小的扰动来欺骗模型,使其产生错误的预测。在网络安全领域,对抗性攻击可能导致模型无法准确识别恶意行为。

- 解释性: 大模型通常是黑盒模型,难以解释其预测结果的原因。在网络安全领域,对模型的决策过程和预测结果进行解释是至关重要的,以便安全专家理解模型的行为并采取适当的措施。

- 泛化能力: 大模型可能在面对未知的攻击或新型威胁时泛化能力不足。模型在训练时所接触到的数据可能无法涵盖所有可能的攻击场景,导致模型在实际应用中表现不佳。

- 计算资源需求: 大模型通常需要大量的计算资源进行训练和推理,这可能会限制其在资源受限的环境中的应用。在网络安全领域,实时性和效率非常重要,因此计算资源需求可能成为一个限制因素。

- 隐私和安全性: 大模型可能涉及大量敏感数据的处理,这可能会引发隐私和安全性方面的顾虑。确保模型在处理数据时符合隐私法规和安全标准是至关重要的。

综上所述,尽管大模型在网络安全领域有很多潜在应用,但仍然存在一些局限性需要认真考虑和解决。在实际应用中,需要综合考虑这些局限性,并结合具体情况选择合适的解决方案。

版权归原作者 筑梦之月 所有, 如有侵权,请联系我们删除。