目录标题

NLP是自然语言处理,而GPT是自然语言生成模型。

它们的联合碰撞结果是大模型与小模型联合发力,是因为大模型可以提供更好的语言理解和生成能力,而小模型则可以更快地进行推理和预测。

因此,将它们结合起来,可以充分发挥它们各自的优势,提高模型的性能和效率。

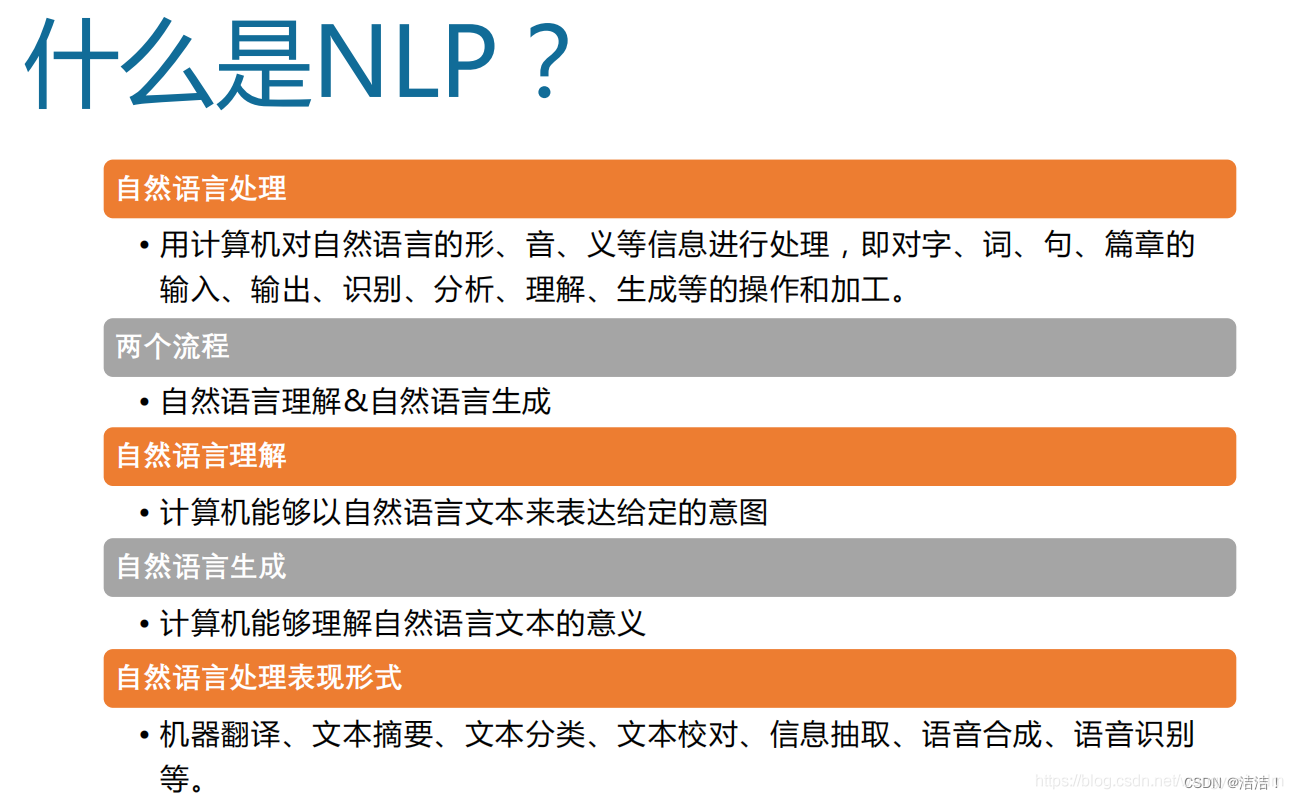

NLP是什么东西?

NLP ( Natural Language Processing ),也就是人们常说的 自然语言处理,就是研究如何让计算机读懂人类语言,即将人的自然语言转换为计算机可以阅读的指令。

自然语言处理(NLP)的两个核心任务分别是自然语言理解(NLU)和自然语言生成(NLG)。

它主要关注如何让计算机能够理解、处理和生成人类语言。NLP的目标是使计算机能够像人类一样理解自然语言,包括语法、语义、语用等方面的知识,并能够进行自然语言的生成、理解、翻译、摘要、问答等任务。

在内容理解方面,NLP可以通过分析文本中的语言结构、词汇、句法和语义信息,从而提取出文本的主题、情感、意图、关键词等内容。通过NLP技术,可以实现文本分类、情感分析、关键词提取、实体识别、命名实体识别、语义角色标注、依存句法分析等任务,从而帮助人们更好地理解和利用文本信息。

自然语言的理解就是希望机器可以和人一样,有理解他人语言的能力;

自然语言的生成就是将非语言格式的数据转换成人类的语言格式,以达到人机交流的目的。

总之,NLP技术在内容理解方面有着广泛的应用,可以帮助人们更好地理解和处理自然语言,从而实现更加智能化、高效化的信息处理和应用。

Al大小模型联合发力

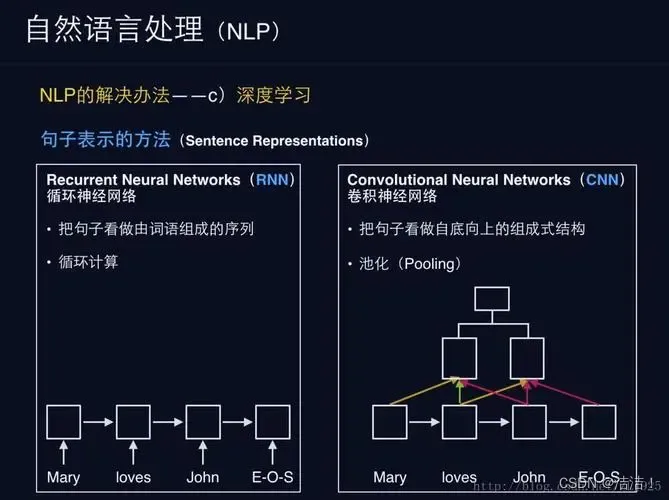

Al大模型是一个基于深度学习技术的自然语言处理(nlp)模型,由dutuai开发。AI大模型是Foundation Model(基础模型),指通过在大规模宽泛的数据上进行训练后能适应一系列下游任务的模型。

它被认为是目前最先进、最强大的nlp模型之一,包含超过1.75万亿个参数,可以进行类似人类思考的任务,如对话、文本生成、机器翻译等。

所谓AI大模型,就是经过大规模数据训练后,能够适应一系列任务的模型。深度学习作为人工智能的重要技术,完全依赖模型自动从数据中学习知识,在显著提升性能的同时,也面临着通用数据激增与专用数据匮乏的矛盾。AI大模型是由多个子模型组成的层次结构,其中每个子模型都专门处理特定的nlp任务。这些子模型的训练使用了谷歌(google)机器学习平台tensor processing unit(tpu),并利用dutuai自有的计算集群提高效率。

由于其巨大的规模和具有变形记忆能力的结构,al大模型在各种nlp任务上表现出色,并已广泛应用于产业界、学术界和非营利组织,为语言处理领域带来了显著的突破。

大模型和小模型各有优势,互相补充,进行分工协作。大模型通常具有更强的语言建模能力和更丰富的语言知识,可以更好地处理复杂的自然语言任务;而小模型则具有更快的推理速度和更低的资源消耗,可以更好地适应实时的应用场景。

大模型可以提供更准确的预测结果和更全面的语言知识,而小模型则可以在实际应用中提供更快的响应速度和更低的资源消耗。两者可以相互协作,发挥各自的优势,提高整个系统的性能。

大模型可以承担更复杂的自然语言任务,如机器翻译、文本生成等;而小模型则可以处理更简单的自然语言任务,如文本分类、情感分析等。

两者可以根据任务的难度和复杂度进行分工协作,提高整个系统的效率和性能。

因此,大模型与小模型联合发力在NLP与GPT碰撞结果中是十分重要的。

这是一本讲述如何用NLP技术进行文本内容理解的著作,也是一本系统讲解NLP算法的著作,是李明琦在NLP和内容理解领域多年经验的总结。

本书结合内容理解的实际业务场景,系统全面、循序渐进地讲解了各种NLP算法以及如何用这些算法高效地解决内容理解方面的难题,主要包括如下几个方面的内容:

(1)文本特征表示文本特征表示是NLP的基石,也是内容理解的基础环节,本书详细讲解了离散型表示方法和分布型表示方法等特征表示方法及其应用场景,还讲解了词向量的评判标准。

(2)内容重复理解详细讲解了标题重复、段落重复、文章重复的识别方法和去重算法。

(3)内容通顺度识别及纠正详细讲解了内容通顺度的识别方法以及纠正不通顺内容的方法。

(4)内容质量详细讲解了多种内容质量相关的算法,以及如何搭建高质量的知识问答体系的流程。

(5)标签体系构建详细讲解了针对内容理解的标签体系的建设流程和方法,以及多种相关算法。

(6)文本摘要生成详细讲解了抽取式文本摘要和生成式文本摘要两种流行的文本摘要生成方法,以及文本摘要的常用数据集和文本摘要评价方法。

(7)文本纠错详细讲解了文本纠错的传统方法、深度学习方法、工业界解决方案,以及常用的文本纠错工具的安装和使用。

所以重点来啦,从即日起,到5月29号晚8点整准时开奖。我准备了2本图书送给幸运观众。

对此文章进行3连,点赞+收藏+评论即可以参与抽奖。评论写什么都可以。

希望大家多多支持!

版权归原作者 洁洁! 所有, 如有侵权,请联系我们删除。