官网信息

评估学生写作:分析 6-12 年级学生的议论文写作要素

https://www.kaggle.com/c/feedback-prize-2021/

官方说明

识别学生写作中的元素。将自动分割文本并对 6 至 12 年级学生撰写的作文中的议论和修辞元素进行分类。

kaggle说这是目前最大的学生写作数据集。

评估方式

具体可以看官方的evaluation例子:

最终分数是通过计算类别中 macro F1 score

单词索引是通过使用 Python 的 .split() 函数并在结果列表中获取索引来计算的。 这两个重叠的计算方法是获取一个真实/预测对中每个索引列表的 set() 并计算两个集合之间的交集除以每个集合的长度。

以上两点是需要特殊注意的

时间点

2022.3.8:组队结束

2022.3.15:最后提交(北京时间 16.早8点)

分析说明

训练目标

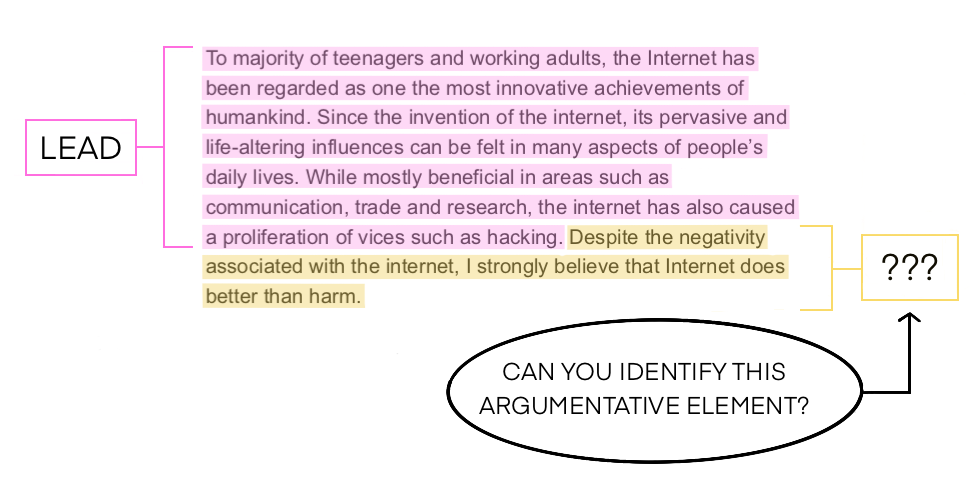

1、Position - an opinion or conclusion on the main question

立场 - 对主要问题的意见或结论

2、Claim - a claim that supports the position

声明 - 支持该职位的声明

3、Counterclaim - a claim that refutes another claim or gives an opposing reason to the position

反诉 - 驳斥另一主张或对该立场提出反对理由的主张

4、Rebuttal - a claim that refutes a counterclaim

反驳 - 驳回反诉的主张,就是反驳Counterclaim的

5、Evidence - ideas or examples that support claims, counterclaims, or rebuttals.

证据 - 支持主张、反主张或反驳的想法或例子。

6、Concluding Statement - a concluding statement that restates the claims

结论声明 - 重申声明的结论声明

还有一个要注意的是,文章的某些部分将没有注释(即,它们不属于上述分类之一)。 也就是说,是不是可以再多一个分类,将这些部分也加入到训练数据中。

模型选择

这是一个阅读理解的问题,所以模型选择肯定是BERT类比GPT的要好一些:

GPT

Generative Pre-Training,可以理解为Transformer的Decoder

GPT1和2是自回归模型,也就是预测接下来会出现的token是什么,所以它在训练时不会获得完整的文本内容,这对于阅读理解来说不太好,它主要擅长的任务是写作或者语言生成,比如说文本生成。

由于GPT的参数是Bert的4倍有余,使得去fine-turing一个模型需要更长,更大的训练时间,所以GPT给出了 'In-context learning' 可以不训练(Zero-shot Learning)直接就可以进行阅读理解、文档摘要和机器翻译。只需要输入一定的范式,然后GPT就会自动地补全内容,比如说我们输入 “把 ‘你好’翻译成英文 ”,GPT会直接返回 ‘hello’,这显然不是我们需要的,但是这种该方式是更接近于人类使用的方式。

Bert

Bidirectional Encoder Representations from Transformers 顾名思义,双向Encoder,或者可以直接把它看作Transformer中的Encoder,BERT模型的输入是一些词的序列,输出每个词的一个embedding。

在Bert的预训练任务中,Bert主要使用“填空题"的方式来完成预训练(Masked LM),也就是说词序列中每个词汇有15%(官方)几率被一个特殊的token[MASK]遮盖掉,然后将被遮盖掉的词对应输出的embedding使用一个线性多分类器来预测被遮盖掉的词是哪一个,由于线性多分类器的能力很弱,所以训练得到的embedding会是一个非常好的表示

当然还有一种是Next Sentence Prediction,这个和GPT就类似了,这个比赛应该用不到。

BERT的浅层会学习语言中一些简单的东西比如语法,而深层会比学习比较复杂的东西比如语义,这个是可以被证明的。

Bert的使用就是将CLS对应的Output作为Embedding的结果,然后根据不同的任务进行对应的操作来fine-turing,从某方面而言,更像是利用深度学习对文本进行特征表示的过程,也就是上面说的Encoder学习了文本表征。

内部会员

“Kaggle用户组”可以使用以下链接查看所有文章: