用提示工程让大模型自己检查自己:CoVe方法有效减少幻觉

Chain-of-Verification(CoVe)的思路是既然模型会在生成时犯错,那就让它生成完之后再检查一遍自己的输出,把能发现的错误纠正掉,然后再给用户看。

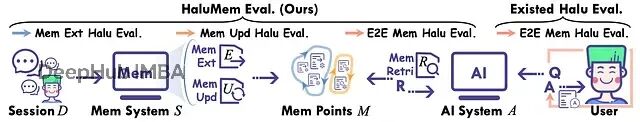

HaluMem:揭示当前AI记忆系统的系统性缺陷,系统失效率超50%

ArXiv最近一篇名为"HaluMem: Evaluating Hallucinations in Memory Systems of Agents"的论文提供了一个非常最新可靠的诊断工具。

人工智能产生的幻觉问题真的能被看作是创造力的另一种表现形式吗?

一.幻觉问题的概念OpenAI的首席执行官山姆·奥特曼(Sam Altman)曾声称,人工智能产生的“幻觉”其实未尝不是一件好事,因为实际上。一.幻觉问题的概念人工智能的幻觉问题是指其在没有充分训练数据支持的情况下自信地做出的响应。这种响应可能是由于数据不完备、存在偏见或过于专业化等因素导致的。以下