【循环神经网络】:教AI写周杰伦风格的歌词

只会python基础,也能让AI写歌词

LSTM模型计算详解

本文记录笔者在学习LSTM时的记录,相信读者已经在网上看过许多的LSTM博客与视频,与其他博客不同的是,本文会从数学公式的角度,剖析LSTM模型中各个部分的模型输入输出等维度信息,帮助初学者在公式层面理解LSTM模型,并且给出了相关计算的例子代入股票预测场景,并给出参考代码。

【人工智能】掌握深度学习中的时间序列预测:深入解析RNN与LSTM的工作原理与应用

深度学习中的循环神经网络(RNN)和长短时记忆网络(LSTM)在处理时间序列数据方面具有重要作用。它们能够通过记忆前序信息,捕捉序列数据中的长期依赖性,广泛应用于金融市场预测、自然语言处理、语音识别等领域。本文将深入探讨RNN和LSTM的架构及其对序列数据进行预测的原理与优势,使用数学公式描述其内部

万字长文解读深度学习——循环神经网络RNN、LSTM、GRU、Bi-RNN

面试资料收集者之万字长文解读深度学习——循环神经网络RNN、LSTM、GRU、Bi-RNN

LSTM网络实现洪水预报原理附完整Matlab代码

详细介绍了LSTM神经网络的原理以及如何将其运用于水文预报之中,文章附有完整且详细注释的MATLAB代码。

LSTM预测股票走势

LSTM预测股票数据

Transformer、RNN和SSM的相似性探究:揭示看似不相关的LLM架构之间的联系

通过探索看似不相关的大语言模型(LLM)架构之间的潜在联系,我们可能为促进不同模型间的思想交流和提高整体效率开辟新的途径。

【人工智能】项目案例分析:使用LSTM生成图书脚本

本项目旨在利用LSTM(长短期记忆网络)生成图书脚本。LSTM是RNN(递归神经网络)的一种变体,特别适用于处理和预测时间序列数据中的长期依赖关系。在本案例中,我们将利用LSTM网络来学习和生成类似文学作品的文本序列,例如莎士比亚的戏剧或现代小说片段。

torch.nn.RNN()相关的参数设置

torch.nn.RNN()相关的参数设置

LSTM模型

🏷️在介绍LSTM模型之前,我们再次见一下CNN是什么?many-to-one: MNIST(glimpse输入)字符分类many-to-many: 机器翻译🏷️接下来我们先简单介绍传统的RNN模型,了解其优缺点根据反向传播算法和链式法则, 梯度的计算可以简化为以下公式。

算法金 | 秒懂 AI - 深度学习五大模型:RNN、CNN、Transformer、BERT、GPT 简介

每个节点不仅接收当前输入,还接收前一个节点的输出,从而形成记忆能力。Transformer 摒弃了传统 RNN 的循环结构,通过自注意力机制和并行处理,实现了更快的训练速度和更好的效果。BERT 的创新在于其双向性和预训练方法,使得模型在各种 NLP 任务中都表现优异,尤其是在需要上下文理解的任务中

与传统RNN相比,AI模型当红大神Transformer有什么新魔法呢?

在处理“我决定明年再回去”这一小部分时,自注意力机制允许模型直接关联到“去年我去了西湖”中的“西湖”,从而建立了一个直接的联系。这是因为在计算注意力分数时,每个单词的表示(查询)会与所有其他单词的表示(键)进行比较,从而直接捕捉到它们之间的相关性,无论它们在文本中的距离如何。然而,由于RNN在处理序

人工智能--循环神经网络

循环神经网络是一类具有反馈连接的神经网络,能够处理任意长度的序列数据,通过在隐藏层中引入循环连接,使得网络能够记住过去的信息,并将其用于当前的计算。

使用seq2seq架构实现英译法

将它们拼接成一个中间语义张量c, 接着解码器将使用这个中间语义张量c以及每一个时间步的隐层张量, 逐个生成对应的翻译语言。

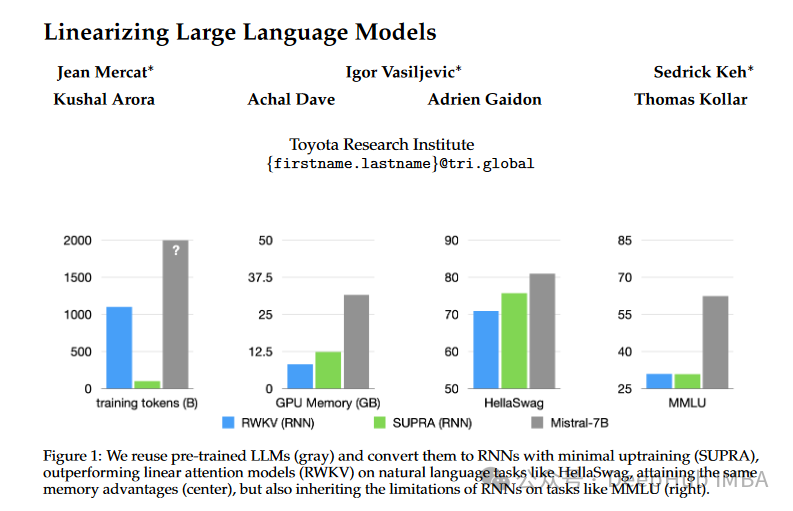

SUPRA:无须额外训练,将Transformer变为高效RNN,推理速度倍增

SUPRA方法旨在将预训练的大型语言模型(LLMs)转化为RNNs,具体步骤包括替换softmax归一化为GroupNorm,使用一个小型MLP投影queries和keys。

秒懂AI-深度学习五大模型:RNN、CNN、Transformer、BERT、GPT简介

BERT是一种基于Transformer的预训练语言模型,它的最大创新之处在于引入了双向Transformer编码器,这使得模型可以同时考虑输入序列的前后上下文信息。GPT也是一种基于Transformer的预训练语言模型,它的最大创新之处在于使用了单向Transformer编码器,这使得模型可以更

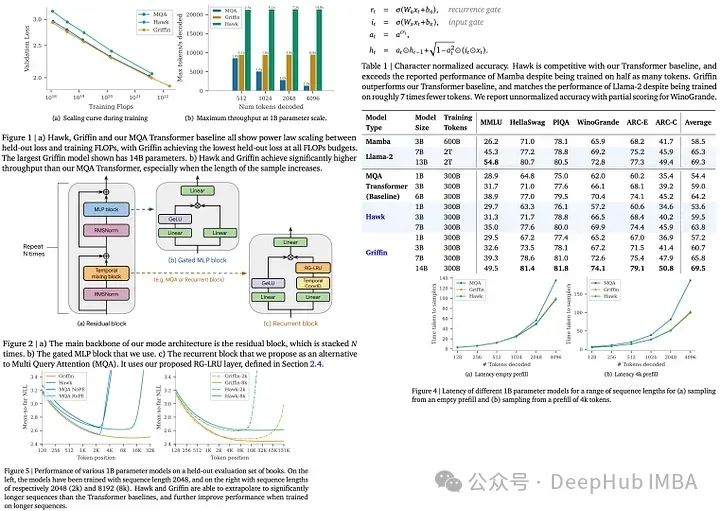

RNN又行了!DeepMind新发布的Griffin可以与同级别的LLM性能相当

Hawk和Griffin是DeepMind推出的新型循环神经网络(RNNs),2月刚刚发布在arxiv上。

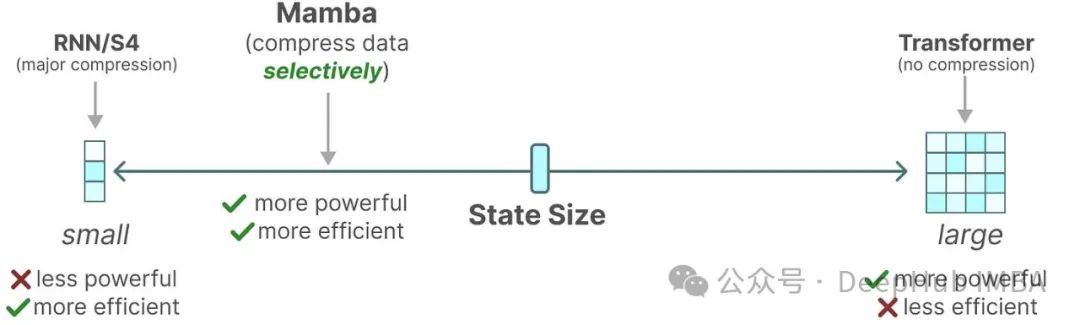

Mamba详细介绍和RNN、Transformer的架构可视化对比

看完这篇文章,我希望你能对Mamba 和状态空间模型有一定的了解,最后我们以作者的发现为结尾:作者发现模型与相同尺寸的Transformer模型的性能相当,有时甚至超过了它们!作者:Maarten Grootendorst。

基于pytorch 的RNN实现字符级姓氏文本分类

当使用基于PyTorch的RNN实现字符级姓氏文本分类时,我们可以使用一个非常简单的RNN模型来处理输入的字符序列,并将其应用于姓氏分类任务。请注意,以上代码只提供了一个基本的示例,您可能需要根据具体任务和数据的特点进行适当的修改和调整。在上面的训练过程中,我们遍历训练数据集中的每个样本,将姓氏的字

验证集精度来回震荡是什么原因,怎么解决

验证集精度来回震荡是什么原因,怎么解决

- 1

- 2