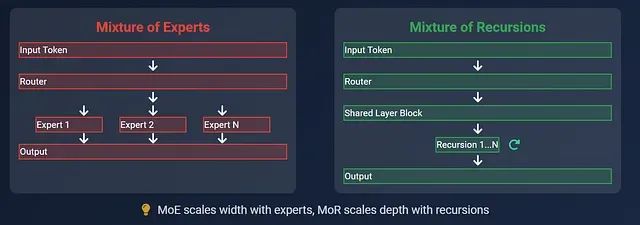

MoR vs MoE架构对比:更少参数、更快推理的大模型新选择

本文将深入分析递归混合(MoR)与专家混合(MoE)两种架构在大语言模型中的技术特性差异,探讨各自的适用场景和实现机制,并从架构设计、参数效率、推理性能等多个维度进行全面对比。

人工智能|集成学习——混合专家模型 (MoE)

与稠密模型相比,预训练速度更快与具有相同参数数量的模型相比,具有更快的推理速度需要大量显存,因为所有专家系统都需要加载到内存中在微调方面存在诸多挑战,但 近期的研究 表明,对混合专家模型进行指令调优具有很大的潜力。为了实现大模型的高效训练和推理,有的是从模型底层下手,比如直接改变底层模型架构,将原来

使用MergeKit创建自己的专家混合模型:将多个模型组合成单个MoE

在本文中,我们将详细介绍MoE架构是如何工作的,以及如何创建frankenmoe。最后将用MergeKit制作自己的frankenMoE,并在几个基准上对其进行评估。