新研究旨在借助 AI 驱动的系统,为失明或低视 (BLV) 观众带来视频访问变革,使用户能够以交互方式探索内容。该创新系统在最近的一篇论文中进行了详细介绍,解决了传统音频描述 (AD) 中的重大差距,提供了丰富的沉浸式视频观看体验,使用户能够更好地理解和参与视频内容。

尽管视频已成为访问信息和娱乐的重要媒介,但视力受限者通常发现这些媒介不太容易获取,”巴黎圣母院大学计算机科学与工程博士的首席作者 Zheng Ning 说,“借助 AI,我们可以构建一个交互式系统,从视频中提取分层信息,并使用户能够通过有限的视觉、听觉感知和触觉,在消费视频内容方面发挥积极作用。

AD 可为视频中的视觉元素提供口语叙事,对于可访问性至关重要。但是,传统的静态描述通常会省略细节,主要集中在为用户提供内容理解的信息,而不是让用户沉浸在内容中。此外,同时消费和处理原始声音以及 AD 中的音频可能会带来心理负担,从而降低用户参与度。

研究人员来自诺特丹大学、加州大学圣迭戈分校、德克萨斯大学达拉斯分校和威斯康星大学麦迪逊分校,开发了一种新的AI驱动系统,以解决这些挑战。

该工具名为 System for Providing Interactive Content for Accessibility (SPICA),使用户能够通过分层广告和空间音效以交互方式探索视频内容。

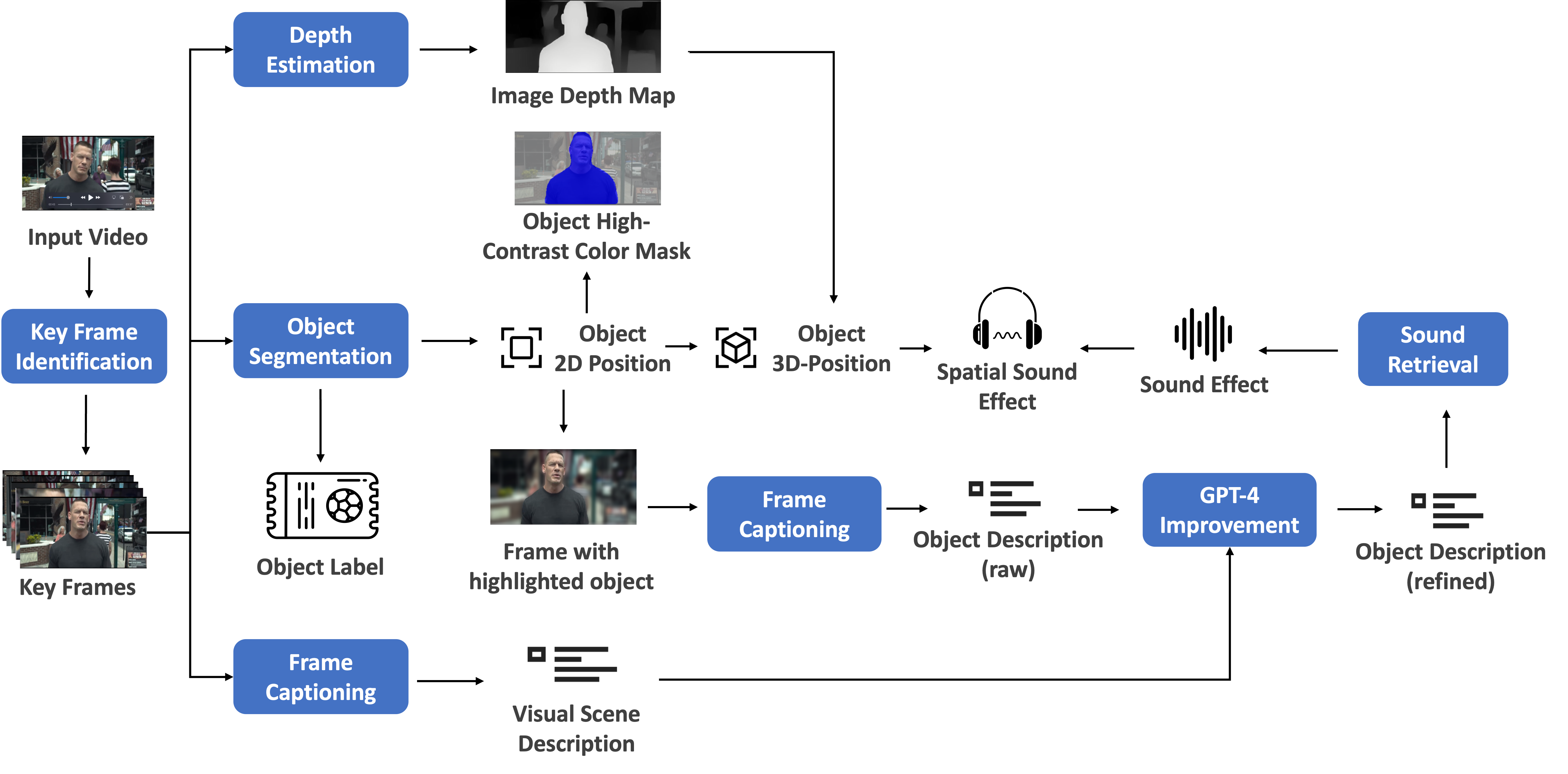

机器学习流程首先进行场景分析,以识别关键帧,然后进行物体检测和分割,以确定每帧中的重要对象。接着,使用经过优化的图像字幕模型和 GPT-4 对这些对象进行详细描述,以实现一致性和全面性。

该流程还可检索每个物体的空间音效,利用其 3D 位置来增强空间感知。深度估计进一步优化了物体的 3D 定位,而前端界面使用户能够使用触摸或键盘输入以交互方式探索这些帧和物体,并借助高对比度叠加技术为视觉残差者提供帮助。

图 1. 机器学习流程由多个模块组成,用于生成分层帧级描述、目标级描述、高对比度颜色蒙版和空间音效

SPICA 在 NVIDIA RTX A6000 GPU 上运行,该团队作为 NVIDIA 学术硬件资助计划的受助者获得了该设备。

宁表示:“NVIDIA 技术是该系统的重要组成部分,为运行这些计算模型提供了稳定高效的平台,从而大幅减少系统的实施时间和工作量。”

这种计算机视觉和自然语言处理技术的高级集成使BLV用户能够以更详细、更灵活和更身临其境的方式与视频内容进行交互。用户不会按帧获得预定义的广告,而是通过触摸界面或屏幕阅读器主动探索帧内的单个对象。

SPICA 还通过交互式元素、空间音效和详细的物体描述来增强现有的 AD,这些所有都通过音视频机器学习流程生成。

在 SPICA 的开发期间,研究人员使用 BLV 视频消费研究来根据用户需求和偏好调整系统。该团队对 14 名 BLV 参与者进行了用户研究,以评估可用性和有用性。参与者发现该系统易于使用,并且能够有效地提供额外信息,从而提高他们对视频内容的理解和沉浸感。

研究人员表示,从用户研究中获得的见解凸显了进一步研究的潜力,包括改进 AI 模型以生成准确且上下文丰富的描述。此外,还可以探索使用触觉反馈和其他感知通道来增加 BLV 用户的视频消耗量。

该团队计划利用 AI 进行未来研究,帮助 BLV 个人在日常生活中完成物理任务,并通过近期在大型生成模型上的突破发现潜力。

版权归原作者 人工智能时代 准备好了吗 所有, 如有侵权,请联系我们删除。