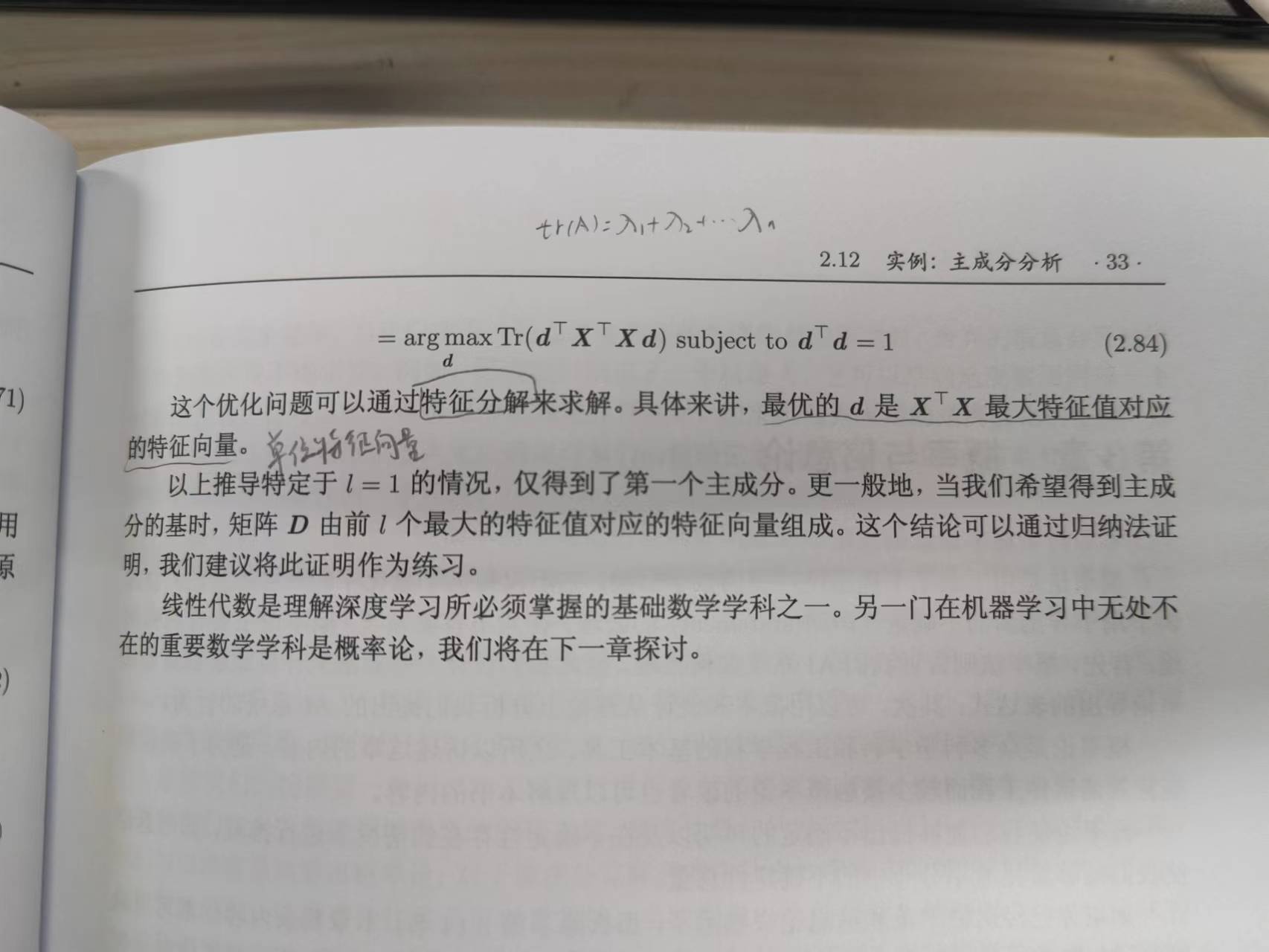

在Ian Goodfellow / Yoshua Bengios所著的《深度学习》第33页中:

该公式中最优的d是最大特征值对应的特征向量

** **

证明:d是最大特征值对应的特征向量

(我们在这里证明中的矩阵、向量的元素都是为实数,其中为n维方阵,

为n维列向量)

证

是实对称矩阵

那么存在一个正交矩阵Q,使得:

令,

其中

为

的单位特征向量(

)

由于线性无关,则

可线性表示任何n维向量

公式为: .............................................(1)

向量表示为:

令

则公式(1)可以表示为:

将二次型展开:

又由约束条件:

可得,

则,

即取 时,

则 (

为

最大特征值对应的单位特征向量)

最后得

证毕

版权归原作者 Goldroc_ 所有, 如有侵权,请联系我们删除。