ChainForge是一个用于构建评估逻辑来衡量模型选择,提示模板和执行生成过程的GUI工具包。ChainForge可以安装在本地,也可以从chrome浏览器运行。

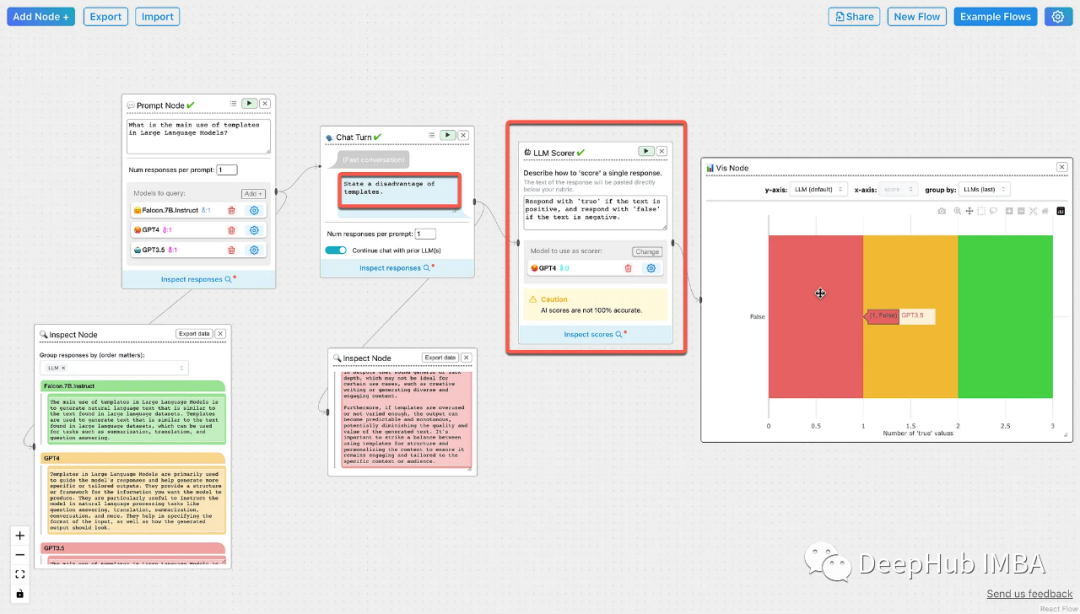

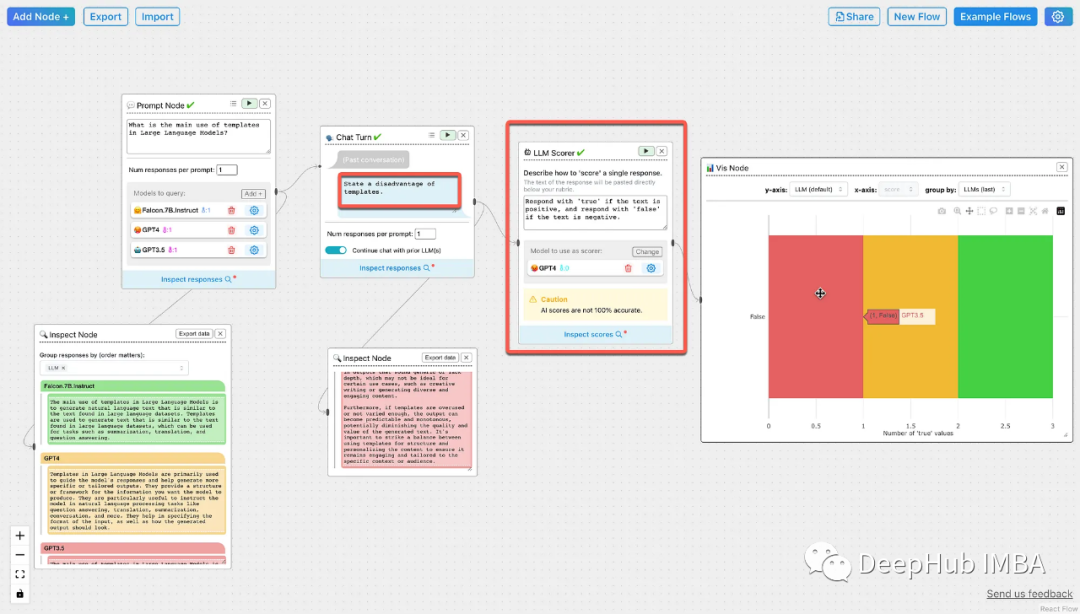

ChainForge可以通过聊天节点对多个对话可以使用不同的llm并行运行。可以对聊天消息进行模板化,并且可以在此过程中为每个节点更新和更改底层LLM。

聊天节点对于会话接口的生成审计非常重要。可以检查每个节点以检测提示漂移,LLM漂移等。

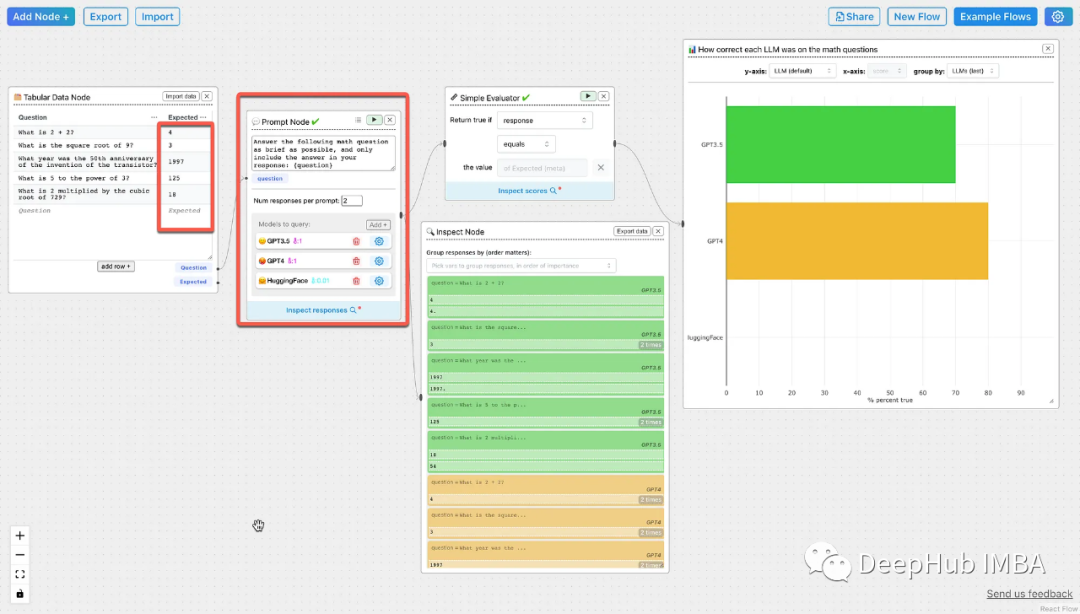

下图显示了如何通过表格数据输入来定义预期响应或真值响应。

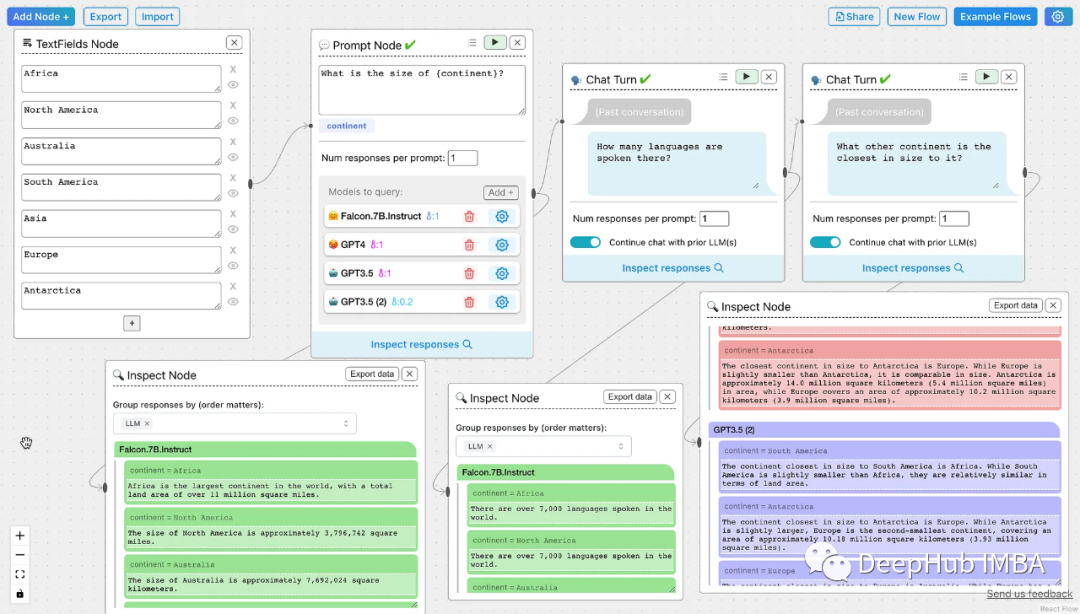

下面的文本字段节点用七个容器。提示符以文本字段为前提;其次是聊天节点。在聊天节点中,可以使用以前使用的LLM,也可以定义新的LLM。

对于每个聊天节点,可以定义一个检查节点来查看LLM响应。

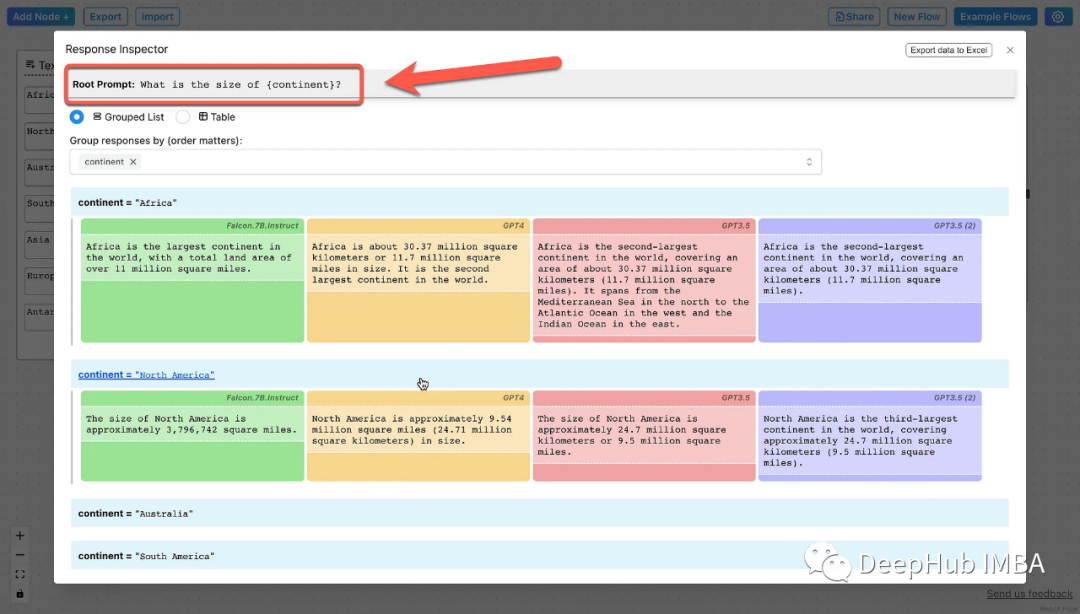

响应选择器有一个分组列表或表的选项,可以在下面看到所引用的每个模型的输出。

下面的LLM Scorer,通过使用评分提示来使用单个模型对其他LLM回答进行评分,

Respond with ‘true’ if the text is positive, and respond with ‘false’ if the text is negative.

总之,ChainForge是一个用于对大型语言模型(LLM)提示进行测试的开源可视化编程环境,用于分析和评估LLM响应,功能包括:快速有效地同时查询多个LLM,测试提示的想法和变化;比较不同提示排列和模型的响应质量,选择最适合你的用例的提示和模型。

官网的DEMO在这里: