ai安全概要

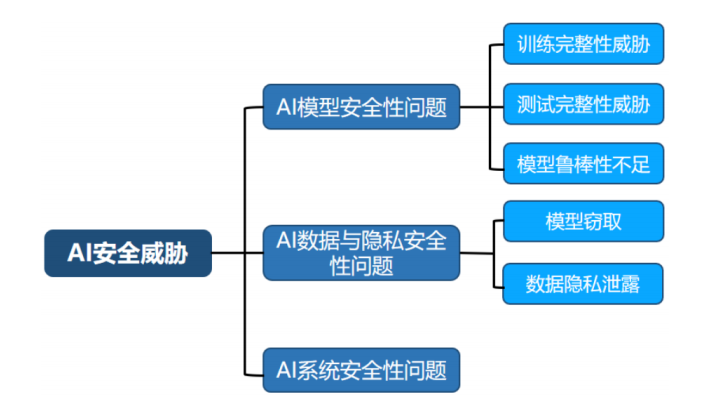

人工智能推动社会经济各个领域从数字化、信息化向智能化发展的同时,也面临着严重的安全性威胁。

ai安全面临的三个主要问题

一、ai模型安全

AI 模型安全是指 AI 模型面临的所有安全威胁,包括 AI 模型在训练与运行阶段遭受到来自攻击者的功能破坏威胁,以及由于 AI 模型自身鲁棒性欠缺所引起的安全威胁。

1)训练完整性威胁,攻击者通过对训练数据进行修改,对模型注入隐藏的恶意行为。训练完整性威胁破坏了 AI 模型的完整性,该威胁主要包括传统投毒攻击和后门攻击;

2)测试完整性威胁,攻击者通过对输入的测试样本进行恶意修改,从而达到欺骗 AI 模型的目的,测试完整性威胁主要为对抗样本攻击

3)鲁棒性欠缺威胁,该问题并非来自于恶意攻击,而是来源于 AI 模型结构复杂、缺乏可解释性,在面对复杂的现实场景时可能会产生不可预计的输出。

二、ai数据安全

数据安全问题是指 AI 技术所使用的训练、测试数据和模型参数数据被攻击者窃取。针对 AI 技术使用的数据,攻击者可以通过 AI 模型构建和使用过程中产生的信息在一定程度上窃取 AI 模型的数据,主要通过两种方式来进行攻击:

1)基于模型的输出结果,模型的输出结果隐含着训练/测试数据的相关属性。

2)基于模型训练产生的梯度(参数),该问题主要存在于模型的分布式训练中,多个模型训练方之间交换的模型参数的梯度也可被用于窃取训练数据。

三、ai系统安全

承载 AI 技术的应用系统主要包括 AI 技术使用的基础物理设备和软件架构(pytorch等),是 AI 模型中数据收集存储、执行算法、上线运行等所有功能的基础。

对抗样本攻击

研究者还发现在输入数据上添加少量精心构造的人类无法识别的“扰动”,可以使 AI 模型输出错误的预测结果。这种添加扰动的输入数据通常被称为对抗样本(Adversarial Example)。在许多安全相关的应用场景中,对抗样本攻击会引起严重的安全隐患。属于ai模型安全。

以自动驾驶为例,攻击者可以在路牌上粘贴对抗样本扰动图案,使得自动驾驶系统错误地将“停止”路牌识别为“限速”路牌 。这类攻击可以成功地欺骗特斯拉等自动驾驶车辆中的路标识别系统,使其作出错误的驾驶决策判断,导致严重的交通事故。

隐私泄露

研究者发现 AI 技术在使用过程中产生的计算信息可能会造成隐私数据泄露,例如攻击者可以在不接触隐私数据的情况下利用模型输出结果、模型梯度更新等信息来间接获取用户隐私数据。在实际应用中,这类信息窃取威胁会导致严重的隐私泄露。属于ai数据安全。

例如:生物核身识别模型****(如人脸识别)返回的结果向量可以被用于训练生成模型,从而恢复如用户头像等训练数据中的敏感信息(原始输入数据)。攻击者甚至还可以通过输出结果窃取 AI 模型的参数,对模型拥有者造成严重的经济损害。在这种情况下,攻击者可能利用模型的输出来训练另一个生成模型,这个生成模型旨在从结果向量中重建或近似原始的输入数据(如用户的头像)。这种攻击通常被称为模型逆向攻击(Model Inversion Attack)。

对抗样本与对抗训练

这里详细介绍一下对抗样本相关的知识

- 对抗样本: 对抗样本是指经过微小、精心设计的修改(通常是不可察觉的)的输入数据,旨在欺骗机器学习模型,使其做出错误的预测。这些修改通常是通过在原始输入上添加人类难以察觉的噪声来实现的。对抗样本的存在揭示了深度学习模型在某些方面的脆弱性,尤其是在图像识别等领域。

- 对抗攻击: 对抗攻击是指利用对抗样本来攻击机器学习模型的过程。攻击者可能通过这种方法来规避或误导模型的行为,例如,在自动驾驶系统中,通过在路标上贴上对抗性贴纸,可能导致系统错误地识别路标。研究对抗攻击有助于开发更安全的机器学习系统。

- 对抗防御: 对抗防御是指采取措施来保护机器学习模型免受对抗攻击的技术和方法。其中包括对抗训练技术。

- 对抗训练: 对抗训练是一种提高机器学习模型鲁棒性的技术。它利用对抗攻击算法生成对抗样本对数据集进行补充,弥补模型薄弱的部分,从而增强模型面对恶意攻击时的****鲁棒性。对抗训练可以使模型在面对潜在的对抗攻击时更加稳定和可靠。

生成对抗网络(GAN)

生成器(Generator):

- 生成器的任务是生成看起来像真实数据的新数据。

- 它通常是一个深度神经网络,输入是一个随机噪声向量(通常是从高斯分布中抽取的),输出是一个数据点(例如图像)。

- 生成器的目标是欺骗判别器,使其认为生成器产生的数据是真实的。

判别器(Discriminator):

- 判别器的任务是区分输入数据是来自真实数据集还是生成器生成的假数据。

- 它也是一个神经网络,接收真实数据或生成数据作为输入,并输出一个概率值,表示输入数据为真实数据的可能性。

- 判别器通过最大化其能够正确分类真实数据和生成数据的能力来提高性能。

对抗过程:

- 生成器和判别器之间的对抗过程可以被看作是一个最小化最大化问题(minimax game)。

- 生成器试图最小化判别器正确分类的准确性,而判别器试图最大化其准确性。

- 通过这种对抗训练,生成器学习如何生成越来越真实的数据,而判别器学习如何更好地区分真假数据。

GAN的训练:

- 训练GAN通常涉及交替训练生成器和判别器。

- 首先,固定生成器的参数,训练判别器来区分真实数据和生成(假)数据。

- 然后,固定判别器的参数,训练生成器来生成能够欺骗判别器的数据。

- 这个过程重复进行,直到生成器生成的数据足够真实,或者达到预定的训练轮数。

- 判别器训练:- 首先,从真实数据集中抽取一批真实样本。- 使用生成器从随机噪声中生成一批假样本。- 将真实样本和假样本混合在一起,并使用判别器进行分类。- 根据判别器的分类结果,使用反向传播算法更新判别器的参数,以提高其区分真实和假样本的能力。

- 生成器训练:- 从随机噪声中生成一批假样本。- 使用判别器对这些假样本进行分类。- 根据判别器的分类结果,使用反向传播算法更新生成器的参数,以提高其生成看起来像真实数据的样本的能力。

GAN与对抗样本结合

对抗训练,本身也是一种数据增强技术(例如视觉领域模拟环境因素的数据增强:对图片进行仿射变换、光照调节、翻转、裁剪、注入噪声、随机擦除或滤波等 ),是为了增加ai模型面对恶意攻击的鲁棒性。

而在生成对抗网络(GAN)中,通过对抗的训练方式,生成器可以很好地模拟训练集的数据分布生成逼真的样本,将对抗样本加入原始数据集,这样通过对抗生成网络就可以对缺少的数据集进行补充,即数据增强。

GAN的训练,具体步骤如下:

- 初始化GAN:- 首先,初始化GAN,包括一个生成器(Generator)和一个判别器(Discriminator)。生成器的任务是生成数据,而判别器的任务是区分真实数据和生成器生成的数据。

- 训练判别器:- 在训练的第一阶段,固定生成器的参数,使用真实的数据集和生成器生成的假数据来训练判别器。判别器学习如何区分真实数据和假数据。

- 训练生成器:- 在训练的第二阶段,固定判别器的参数,更新生成器的参数。生成器接收随机噪声作为输入,并尝试生成尽可能接近真实数据分布的数据,以便欺骗判别器。这一步可以通过反向传播算法来完成,目标是最大化判别器将生成数据误判为真实数据的概率。

- 交替训练:- 重复步骤2和步骤3,生成器和判别器交替进行训练。这个过程可以被视为一个对抗过程,生成器试图生成更好的假数据,而判别器试图变得更擅长识别假数据。

- 生成对抗样本:- 经过足够的训练轮次后,生成器应该能够生成高质量的对抗样本。这些样本在视觉上与真实数据相似,但实际上是经过精心设计的,以欺骗原始分类模型。

- 增强原始模型:- 最后,将这些对抗样本加入到原始分类模型的训练集中。这样,原始模型在训练过程中不仅学习如何处理正常数据,还学习如何处理对抗样本,从而提高其对潜在对抗攻击的鲁棒性。

通过这种方式,GAN可以用来生成对抗样本,这些样本随后用于对抗训练,以增强原始分类模型的鲁棒性。需要注意的是,生成的对抗样本通常是为了特定类型的攻击而设计的,例如针对图像分类模型的FGSM(Fast Gradient Sign Method)攻击或PGD(Projected Gradient Descent)攻击。因此,生成器的设计和训练过程需要针对特定的攻击类型和目标模型进行调整。

版权归原作者 池池池` 所有, 如有侵权,请联系我们删除。