自举元学习到深度学习的时间序列预测,外推与泛化之间的关系与 Ridge Rider 探索多样化最优

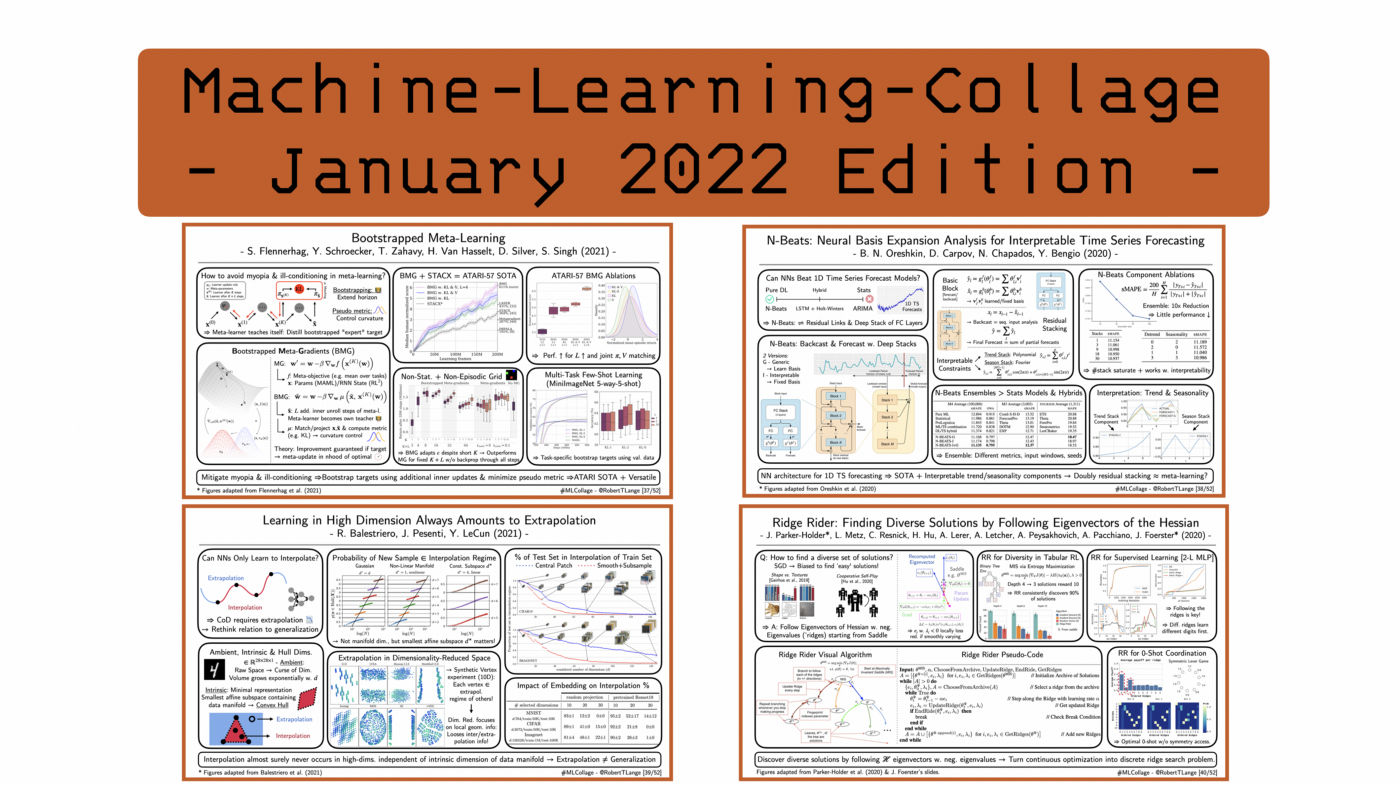

‘Bootstrapped Meta-Learning’

Flennerhag et al. (2021) | 📝 https://arxiv.org/pdf/2109.04504.pdf

元学习算法旨在自动发现归纳偏差,这允许在许多任务中快速适应。经典示例包括 MAML 或 RL^2。一般情况下这些系统是针对双层优化问题进行训练的,快速的内部循环中只考虑单个任务实例化,在第二个慢的外部循环,系统通过对许多内循环的单个任务进行批处理来更新权重,系统会自动发现和利用任务的底层结构。但是大多数情况下外部更新必须通过内部循环更新过程来传播梯度,所以会出现两个问题:应该如何选择内循环的长度?使用短长度会更容易优化,但是会导致视野过短;如果长度过长可能会出现梯度消失和爆炸的问题导致元目标可能表现不稳定。那么我们如何才能克服这种短视和优化困难呢?自举(Bootstrapped)元学习建议通过运行内部循环稍长一点来构建所谓的自举目标,然后将由此产生的网络作为教师为视野较短的学生提供训练服务。与 DQN 类似,自举目标与计算图分离,只是在损失计算中充当固定量。论文中说到,该方法基本上将元学习方法向前进行了推进,通过比较专家和学生的度量可以进一步控制元目标的曲率。在一组测试的RL 实验中,作者表明,尽管视野很短,但自举可以实现快速的探索适应,并且它优于具有较长视野的普通元梯度。与 STACX 元梯度代理一起,自举元梯度提供了一种新的 ATARI SOTA,也可以应用于多任务少样本学习。总而言之,这项工作为如何积极地进行元学习问题公式开辟了许多新视角。

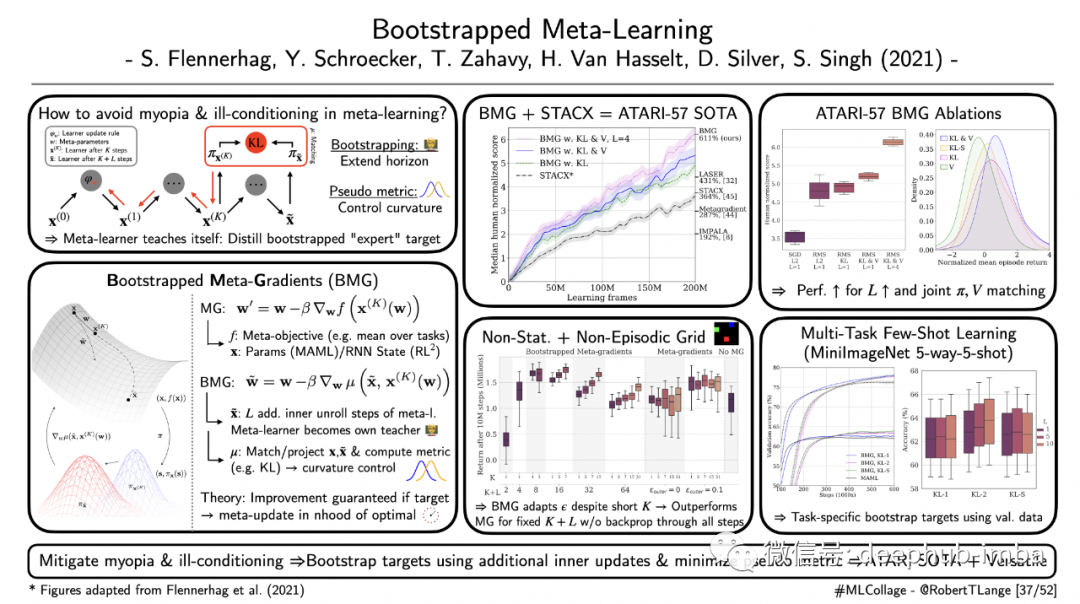

‘N-Beats: Neural Basis Expansion Analysis for Interpretable Time Series Forecasting’

Oreshkin et al. (2020)| 📝 https://arxiv.org/abs/1905.10437 | 🤖https://github.com/ElementAI/N-BEATS

传统的时间序列预测模型,例如 ARIMA是来自金融计量经济学领域,它依赖于趋势和季节性成分的拟合移动平均线。这样的模型往往只有很少的参数,同时保持清晰的可解释性。但是最近一段时间将循环神经网络与可微预测相结合的混合模型变得越来越流行。这种方式允许灵活的函数拟合,同时保持更经典方法的归纳偏差,是否可以训练基于纯深度学习方法的预测者呢?在 N-Beats 中,作者介绍了一种用于单变量时间序列预测的新网络架构,它在 M3、M4 和tourism 基准上建立了新的 SOTA。该架构由多个残差块堆栈组成,它们同时执行预测和逆推。各个堆栈的部分预测被合并到时间范围的最终预测中。单个预测块可以通过学习或固定为合适并且可解释的函数形式,例如可以是低维多项式或用于捕捉季节性成分的趋势或周期函数。作者将他们的方法与集成技术相结合,合并在不同指标、输入窗口和随机初始化上训练的模型。作者还表明,随着添加更多堆栈,性能增益会饱和,并通过视觉分析固定基础堆栈预测确实是可解释的。

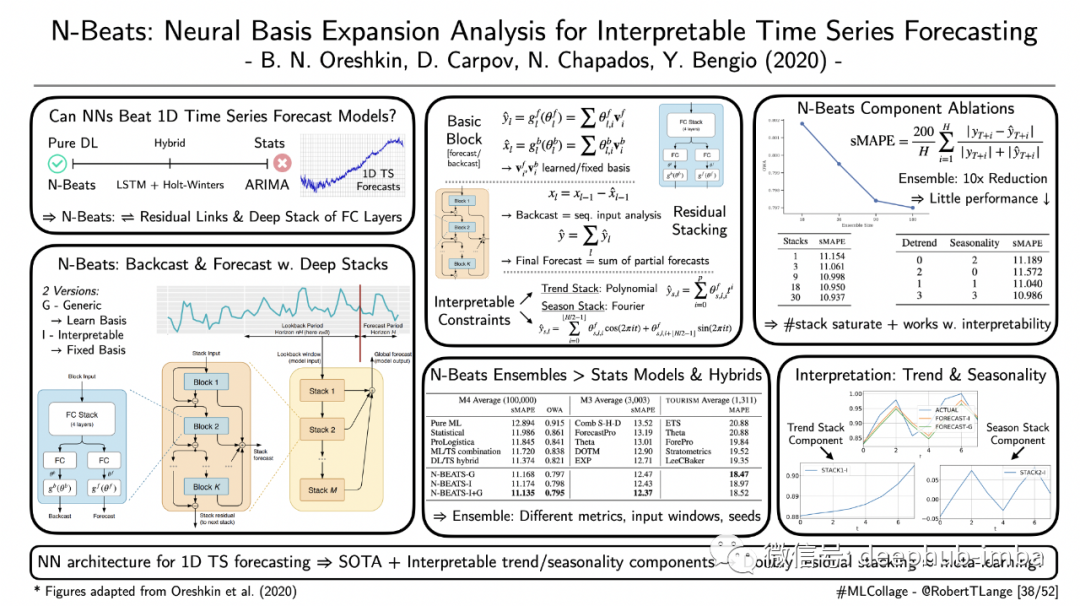

‘Learning in High Dimension Always Amounts to Extrapolation’

Balestriero et al. (2021) | 📝http://arxiv.org/abs/2110.09485

神经网络(NN)只能学习插值吗?Balestriero 等人认为:为了解决高维任务,神经网络必须进行外推。他们的推理依赖于插值的简单定义,也就是说只要数据点落入观察到的训练数据的凸包内就会发生插值。随着原始输入空间的维数线性增长该空间的体积以指数速度增长,这种现象通常被称为维度灾难(我们人类在 3D 空间之外的几何直觉的可视化中苦苦挣扎)。如果数据位于低维流形上怎么办?那么是否有可能规避维数灾难并仅用几个样本获得插值的方法呢?在一组综合实验中,作者表明:真正重要的不是流形的原始维度,而是所谓的本征维度(intrinsic dimension)——即包含数据流形的最小仿射子空间。他们表明对于常见的计算机视觉数据集,随着输入维数的增加,测试集样本包含在训练集的凸包中的概率迅速降低。作者还强调这种现象存在于神经网络嵌入或不同的降维技术中,在所有情况下当考虑更多输入维度时,插值百分比都会降低。那么这能告诉我们什么呢?为了让神经网络成功解决任务,它们必须在“外推”机制下运行!但并非所有人都像其他人一样概括。因此,这开启了关于这种特定的外推概念与更普遍的概括之间关系的新问题。例如,数据增强和正则化扮演什么角色?

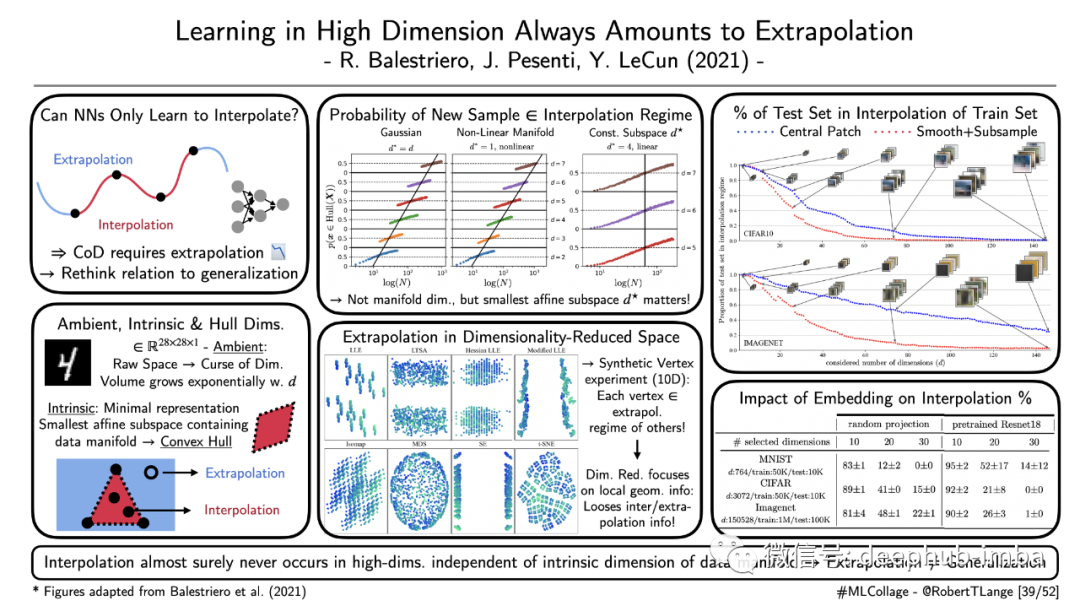

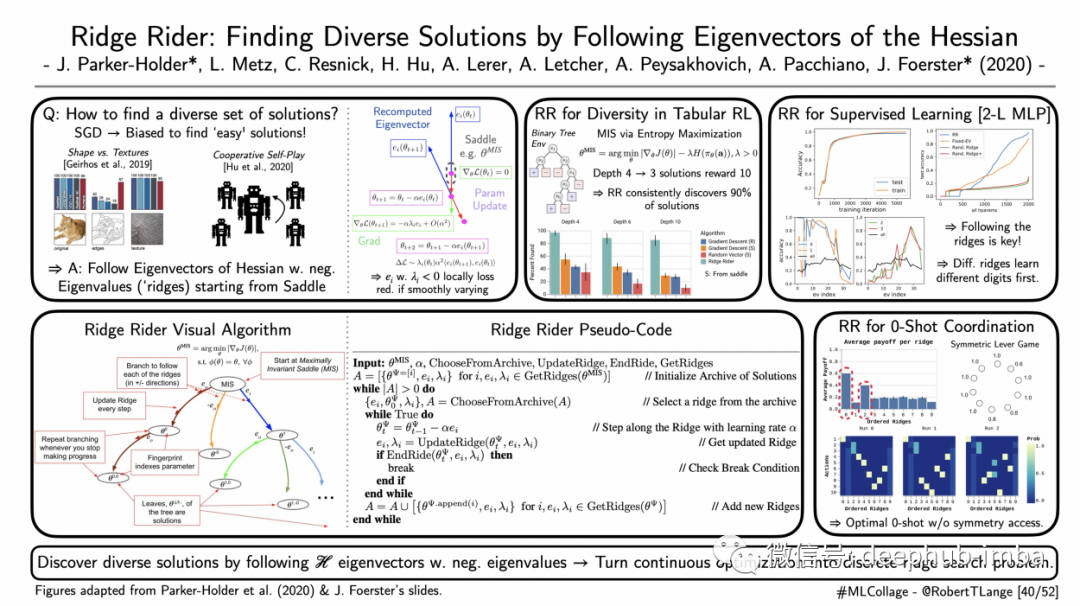

‘Ridge Rider: Finding Diverse Solutions by Following Eigenvectors of the Hessian’

Parker-Holder et al. (2020) | 📝 https://arxiv.org/abs/2011.06505| 🤖 https://colab.research.google.com/drive/1RTwd7IOgOC7Meky1jCekbyQNG8fu_Stg?usp=sharing

现代深度学习问题通常需要处理许多局部最优解,而梯度下降已被证明偏向于简单的高曲率解决方案。这个问题的经典例子包括计算机视觉中的形状与纹理最优和已经训练好的自我对战策略不能推广到新的玩家中。优化过程在哪个局部最优中结束取决于许多任意因素,例如初始化、数据排序或正则化等细节。如果我们不是试图获得单一的最优值,而是同时探索一组不同的最优值呢?Ridge Rider 算法目的是通过迭代地跟踪具有负特征值的 Hessian 特征向量(即所谓的脊)来做到这一点。作者表明只要特征向量沿着轨迹平滑变化,这个过程就可以减少局部损失,通过遵循这些不同的山脊,Ridge Rider能够在表格 RL 和 MNIST 分类的上下文中覆盖许多不同的局部最优值。作者还表明Ridge Rider 还可以在无需访问潜在的问题对称性的情况下帮助发现最佳的零样本协调策略。Ridge Rider 将连续优化问题转化为对不同山脊的离散搜索。它为稳健优化开辟了一个有前途的未来方向。但是关于该方法的可扩展性,包括有效的特征分解和多个特征向量的同时探索,仍然存在许多悬而未决的问题。

本月推荐的4篇论文专业术语太多了,所以只翻译的并不好,如果你对以上论文感兴趣,请阅读英文原文。

作者:Robert Lange