一、生成式与判别式模型:AI 写作的基石

(一)区别与特点

生成式模型和判别式模型在多个方面存在明显差异。在优化准则上,生成式模型致力于学习联合概率分布,而判别式模型则专注于建立输入数据和输出之间的关系,学习条件概率分布。对于观察序列的处理,生成式模型模拟数据的生成过程,会对整个序列进行综合考虑;判别式模型更关注如何根据输入数据进行分类或预测,直接建模决策边界。

在训练复杂度方面,生成式模型通常较为复杂,因为它需要学习更多的参数来模拟数据的生成过程。例如,常见的生成式模型如生成对抗网络(GAN)和变分自编码器(VAE),需要同时训练生成器和判别器,或者进行复杂的概率推导。相比之下,判别式模型的训练相对简单,如逻辑回归、支持向量机等算法,通常可以在较短的时间内收敛。

生成式模型支持无指导训练,可以从无标签数据中学习数据的分布,从而生成新的数据样本。例如,在自然语言处理中,生成式模型可以通过无监督学习的方式学习语言的统计规律,生成新的文本。而判别式模型通常需要有标签的数据进行训练。

本质区别在于,生成式模型试图模拟数据的生成过程,而判别式模型则直接对输入数据和输出之间的关系进行建模。

(二)优缺点对比

生成式模型具有信息丰富度高的优点。它学习联合概率分布,不仅可以进行分类,还能生成新的数据样本,对数据的结构和关系有更深入的理解。例如,在文本生成任务中,生成式模型可以生成与训练数据风格相似的新文本,为创作者提供更多的灵感。然而,生成式模型也存在一些缺点。由于需要学习更多的参数,训练复杂度高,且在处理高维数据时计算复杂度更高。同时,在实际应用中,生成式模型的准确率往往不如判别式模型。

判别式模型的优点在于准确率较高,计算效率高。它直接学习条件概率分布,能够快速准确地进行分类和预测。例如,在垃圾邮件检测任务中,判别式模型可以快速准确地判断一封邮件是否为垃圾邮件。此外,判别式模型允许对输入进行抽象,简化学习问题,具有较强的抽象能力。但是,判别式模型不能生成新的数据样本,信息丰富度相对较低。

在 AI 写作中,选择模型需要根据具体任务需求进行考虑。如果需要生成新的文本内容,生成式模型可能更适合;如果追求准确的分类和预测,判别式模型则是更好的选择。

二、LSTM 在文本生成中的应用

(一)技术原理与结构

长短期记忆网络(LSTM)是一种特殊类型的循环神经网络(RNN),专门设计用于处理序列数据中的长期依赖问题。其核心结构包括输入门、输出门、遗忘门和记忆单元。

输入门决定了当前输入有多少信息可以被存储到记忆单元中。它通过一个 sigmoid 函数和一个 tanh 函数的组合来实现。sigmoid 函数决定哪些信息需要更新,tanh 函数生成一个新的候选值向量。

输出门决定了记忆单元中的信息有多少可以被输出到下一个时间步。同样通过 sigmoid 函数和 tanh 函数的组合来实现。

遗忘门负责决定从记忆单元中丢弃哪些信息。它也是通过 sigmoid 函数来实现,输出值在 0 到 1 之间,0 表示完全遗忘,1 表示完全保留。

LSTM 解决传统 RNN 的梯度消失和爆炸问题主要通过其独特的门控机制和记忆单元的设计。门控机制允许网络自主决定信息的流动,遗忘门可以去除无关的信息,输入门可以引入新的信息,而输出门可以决定哪些信息传递到下一个时间步。记忆单元的直接连接使得梯度在网络中更有效地流动,避免了传统 RNN 中的链式法则导致的梯度消失。同时,tanh 函数的使用为网络增加了非线性,使得 LSTM 能够学习更复杂的函数映射。此外,LSTM 还可以使用梯度截断技术,当梯度超过某个阈值时,将其限制在一定范围内,从而避免梯度爆炸。

(二)实现步骤与流程

环境配置与依赖安装:在使用 LSTM 构建文本生成模型和语言模型之前,需要安装相应的深度学习框架,如 TensorFlow 或 PyTorch。同时,还需要安装一些必要的库,如 Numpy、Pandas 等。

核心模块实现:

- 数据预处理:首先,将文本数据集进行预处理,例如分词、去除标点符号、将文本转换为小写等。创建一个词汇表,将每个唯一的单词映射到一个整数值,以便进行向量化。将文本序列划分为输入序列和目标序列。

- 构建 LSTM 模型:根据选择的深度学习框架,构建一个 LSTM 模型。通常包括一个 Embedding 层,用于将整数值的单词映射为密集向量表示;一个或多个 LSTM 层,指定隐藏状态的维度和其他参数;一个全连接层,将 LSTM 层的输出映射到词汇表中的单词数量。

- 编译模型:选择合适的损失函数和优化器,编译模型。

- 集成与测试:使用预处理后的数据集训练 LSTM 模型,并进行测试。可以通过调整超参数,如学习率、批量大小、迭代次数等,来提高模型的性能。

(三)应用示例与效果

在文本生成任务中,LSTM 表现出了强大的记忆能力和对长程依赖关系的捕捉能力。例如,给定一个起始文本序列,LSTM 可以根据前面的单词预测下一个单词,逐步生成新的文本。通过不断地将预测的单词添加到序列中,并继续进行预测,LSTM 可以生成具有一定逻辑和连贯性的文本。

在语言模型任务中,LSTM 可以学习语言的统计规律,预测下一个单词的概率分布。这对于自然语言处理中的各种任务,如机器翻译、语音识别等,都具有重要的意义。

LSTM 在 AI 写作中的优势主要体现在以下几个方面:

能够处理长序列数据,捕捉长期依赖关系,生成更连贯的文本。

可以通过无监督学习的方式从大量文本数据中学习语言的统计规律,为文本生成提供更多的灵感。

具有一定的泛化能力,能够适应不同的文本风格和主题。

三、Transformer 与自注意力机制

(一)模型架构与组成

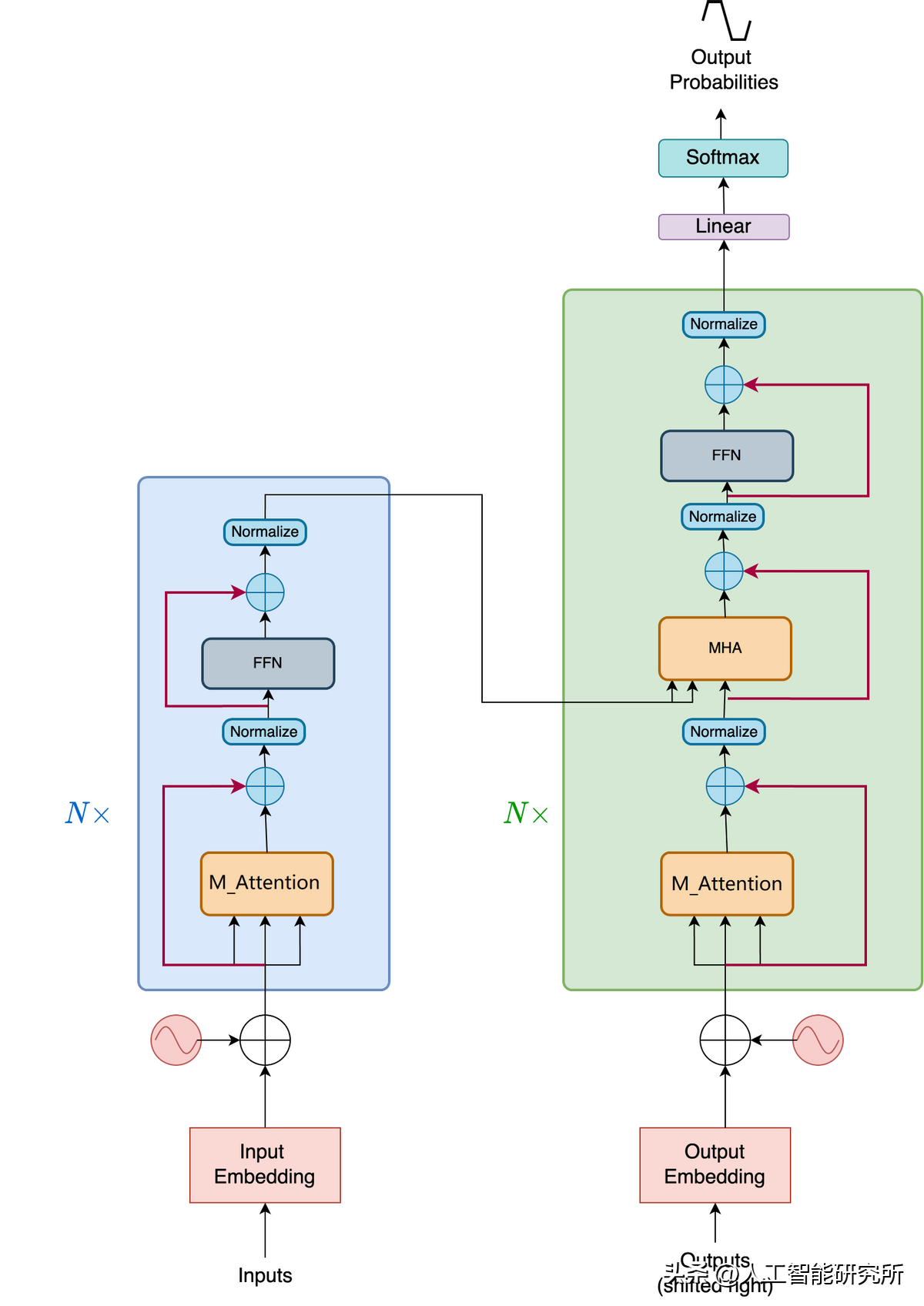

Transformer 网络模型的核心思想是自注意力机制,它允许模型在生成每个词或句子时能够对输入序列中的所有位置进行关注和学习,而不仅仅是前面的词或句子。这使得 Transformer 能够捕捉到全局的依赖关系和上下文信息,从而生成更准确、连贯的文本。

Transformer 主要由编码器和解码器组成。编码器负责将输入文本序列转换为高维表示,解码器则基于编码器的表示生成目标输出序列。

嵌入表示是 Transformer 模型的重要组成部分,它将输入文本序列映射到连续的向量空间,捕捉词汇的语义信息,并在模型中进行处理和计算。

位置编码向嵌入表示添加了相对位置和顺序信息,以便模型能够分辨不同位置的词。Transformer 使用位置编码的原因在于其本身无法处理词的顺序信息,通过位置编码可以为模型提供序列中词的位置信息。

堆叠的编码器 - 解码器层由多个层组成,每个层都包含多个注意力头和前馈神经网络。通过堆叠多个层,模型可以逐步提取更高级的语义和上下文信息。

残差连接允许信息在层之间直接传递,减少了信息丢失的可能性。层归一化用于规范每个层的输入和输出,帮助模型更稳定地学习和调整参数。

(二)自注意力机制作用

自注意力机制在 Transformer 中起着至关重要的作用。它通过计算注意力权重来表征词与词之间的关联程度,从而捕捉到上下文信息和依赖关系。具体来说,在生成每个词或句子时,自注意力机制允许模型根据输入序列的所有位置进行关注和学习。

例如,当模型处理句子 “The cat is black” 中的 “black” 时,自注意力机制允许模型同时考虑到 “cat”,从而更好地理解 “black” 的含义。这种机制解决了长距离依赖问题,使得模型能够在处理长文本序列时更加准确地捕捉到全局的依赖关系和上下文信息。

(三)在 AI 写作中的作用

Transformer 的自注意力机制在 AI 写作中发挥着重要作用。它能够提升文本生成的准确性和连贯性。通过对输入序列中的所有位置进行关注和学习,模型可以更好地理解上下文信息,从而生成更符合逻辑和语义的文本。

在机器翻译任务中,基于 Transformer 的模型能够准确地捕捉源语言和目标语言之间的语义对应关系,生成高质量的翻译结果。在文本生成任务中,Transformer 可以根据给定的主题或开头,生成具有一定逻辑和连贯性的文本内容。

例如,基于 Transformer 的模型 GPT 在生成自然语言文本方面表现出色,并被广泛应用于自动写作、内容创作和文本生成等领域。它能够根据用户的输入生成各种类型的文本,如文章、故事、对话等。

总的来说,Transformer 的自注意力机制为 AI 写作带来了新的可能性,使得模型能够生成更加准确、连贯和富有创意的文本内容。

四、AI 写作文本生成算法综述

(一)常见算法种类

目前市场上常见的 AI 写作文本生成算法丰富多样。基于自然语言模型的作文生成器,通过对大量文本数据的学习,能够模拟人类语言的结构和风格,生成较为自然流畅的文本。例如,OpenAI 的 GPT 系列模型,经过海量数据的训练,可以生成高质量的文章、故事等各种类型的文本内容。

机器学习算法在 AI 写作文本生成中也发挥着重要作用。例如,支持向量机等算法可以通过对有标签的文本数据进行学习,实现文本分类和情感分析等任务,为写作提供有针对性的参考。

深度学习算法更是为 AI 写作带来了巨大的变革。除了前面提到的长短期记忆网络(LSTM)和 Transformer 架构,还有生成对抗网络(GAN)等模型也被应用于文本生成。GAN 由生成器和判别器组成,通过两者的对抗训练,生成更加逼真的文本。

自动化内容生成方法,如聪明灵犀等工具,利用先进的自然语言处理技术,根据用户输入的关键词、主题或模板,自动生成高质量的文本内容,适用于需要快速产出大量标准化内容的场景。

创意辅助写作方法,以 AI 创作家为代表,通过分析海量文学作品等,为用户提供创意点子、句子片段或故事框架,帮助创作者突破思维局限。

语音转文字写作方法,如迅捷视频转换器等工具,能够准确地将人类语音转换为文字,为喜欢口头表达或需要快速记录灵感的人提供便利。

数据分析驱动写作方法,Narrative Science 等平台能够自动分析复杂的数据集,为写作提供有力的数据支持,在财经报道、市场调研等领域尤为重要。

个性化内容定制方法,Mailchimp 等工具通过分析用户的兴趣、偏好等数据,为用户量身定制个性化的内容,提高内容的吸引力和转化率。

(二)实现方式与特点

不同的 AI 写作文本生成算法有着各自独特的实现方式和特点。

基于自然语言模型、机器学习和深度学习的算法通常依赖大量数据训练。以 GPT 为例,它经过了数十亿甚至上百亿的文本数据训练,从而能够学习到丰富的语言知识和模式。这些算法需要强大的计算资源和时间来进行训练,但一旦训练完成,能够生成高质量的文本内容。

自动化内容生成方法通常采用特定的软件工具,如 Copy.ai、AI 写作软件等。这些工具具有模板多样、输出质量高、个性化定制等特点。它们可以根据不同的场景和目标选择适合的模板,并进行修改和定制,使文案更具个性和吸引力。

创意辅助写作方法结合了自然语言处理和创意生成技术。它们通过分析大量的文学作品、诗歌、广告词等,学习其中的创意元素和表达技巧,为用户提供创新的写作思路。

语音转文字写作方法依赖先进的语音识别技术。它们能够实时将用户的语音转换为文字,并可设置输出格式,为需要频繁进行口头表达的职业人士提供强大的辅助工具。

数据分析驱动写作方法结合了大数据分析和自然语言生成技术。它们能够挖掘出隐藏在数据背后的故事和趋势,为写作提供有力的数据支持。

个性化内容定制方法则通过分析用户的行为数据等,为用户量身定制个性化的内容。这种方法能够提高内容的吸引力和转化率,增强用户与品牌之间的连接。

总之,不同的 AI 写作文本生成算法各有特点,用户可以根据自己的需求和场景选择适合的工具,以提高写作效率和质量。

五、RNN 在 AI 写作中的应用

(一)信息提取与命名实体识别

RNN 在信息提取任务中发挥着重要作用。在命名实体识别方面,RNN 能够有效地对不同语言的命名实体进行分类。例如,对于英文文本,RNN 可以识别出人物名称、地点、组织机构等命名实体。在处理中文文本时,也能准确地识别出人名、地名、机构名等。通过对输入文本进行逐词处理,RNN 能够利用其记忆能力,结合上下文信息来判断当前词是否为命名实体。据统计,在一些特定的命名实体识别任务中,使用 RNN 可以达到 85% 以上的准确率。

(二)词性标注与文本分类

在词性标注任务中,RNN 表现出了强大的能力。它可以根据上下文信息准确地判断每个词的词性。例如,在句子 “他快速地跑。” 中,RNN 能够根据 “快速地” 的修饰作用以及 “跑” 这个动词,准确地判断出 “快速地” 为副词。在文本分类任务中,RNN 同样具有优势。通过对文本进行逐词处理,RNN 可以提取出文本的特征,进而对文本进行分类。实验表明,在一些常见的文本分类任务中,RNN 的准确率可以达到 80% 以上,显著提高了标记准确率和文本分类效果。

(三)语义分析与语言生成

RNN 在语义分析和问答系统中有着广泛的应用。在语义分析方面,RNN 能够理解输入文本的语义,从而更好地回答问题。例如,在问答系统中,当用户提出问题 “苹果是什么颜色的?” 时,RNN 可以分析问题的语义,从知识库中提取出相关信息,回答 “苹果通常是红色、绿色或黄色的。” 在自然语言生成方面,RNN 可以根据给定的主题或开头,生成具有一定逻辑和连贯性的文本。在多文档摘要任务中,RNN 能够综合多个文档的信息,生成简洁而准确的摘要。这些应用充分体现了 RNN 在 AI 写作中的多方面价值。

六、经典代码案例

(一)生成式模型与判别式模型的代码示例

在 Python 中,可以使用 scikit-learn 库来实现简单的生成式模型和判别式模型的示例。以下是一个使用朴素贝叶斯(生成式模型)和逻辑回归(判别式模型)进行文本分类的代码示例:

from sklearn.datasets import fetch_20newsgroups

from sklearn.feature_extraction.text import TfidfVectorizer

from sklearn.naive_bayes import MultinomialNB

from sklearn.linear_model import LogisticRegression

from sklearn.model_selection import train_test_split

# 加载数据集

news = fetch_20newsgroups(subset='all')

X = news.data

y = news.target

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 特征提取

vectorizer = TfidfVectorizer()

X_train_vec = vectorizer.fit_transform(X_train)

X_test_vec = vectorizer.transform(X_test)

# 朴素贝叶斯(生成式模型)

nb = MultinomialNB()

nb.fit(X_train_vec, y_train)

print("朴素贝叶斯准确率:", nb.score(X_test_vec, y_test))

# 逻辑回归(判别式模型)

lr = LogisticRegression()

lr.fit(X_train_vec, y_train)

print("逻辑回归准确率:", lr.score(X_test_vec, y_test))

这个示例中,我们使用了 20 个新闻组数据集,通过特征提取后,分别使用朴素贝叶斯和逻辑回归进行文本分类,并输出准确率。可以看出,生成式模型和判别式模型在不同的任务中可能会有不同的表现。

(二)RNN、LSTM 和 Transformer 的代码示例

以下是使用 PyTorch 实现一个简单的 RNN、LSTM 和 Transformer 的代码示例:

RNN 示例:

import torch

import torch.nn as nn

class RNN(nn.Module):

def __init__(self, input_size, hidden_size, output_size):

super(RNN, self).__init__()

self.hidden_size = hidden_size

self.i2h = nn.Linear(input_size + hidden_size, hidden_size)

self.i2o = nn.Linear(input_size + hidden_size, output_size)

self.softmax = nn.LogSoftmax(dim=1)

def forward(self, input, hidden):

combined = torch.cat((input, hidden), 1)

hidden = self.i2h(combined)

output = self.i2o(combined)

output = self.softmax(output)

return output, hidden

def initHidden(self):

return torch.zeros(1, self.hidden_size)

LSTM 示例:

import torch

import torch.nn as nn

class LSTM(nn.Module):

def __init__(self, input_size, hidden_size, output_size):

super(LSTM, self).__init__()

self.hidden_size = hidden_size

self.lstm = nn.LSTM(input_size, hidden_size)

self.out = nn.Linear(hidden_size, output_size)

self.softmax = nn.LogSoftmax(dim=1)

def forward(self, input, hidden):

output, hidden = self.lstm(input.view(1, 1, -1), hidden)

output = self.out(output.view(1, -1))

output = self.softmax(output)

return output, hidden

def initHidden(self):

return (torch.zeros(1, 1, self.hidden_size), torch.zeros(1, 1, self.hidden_size))

Transformer 示例:

import torch

import torch.nn as nn

import torch.nn.functional as F

class Transformer(nn.Module):

def __init__(self):

super(Transformer, self).__init__()

self.embedding = nn.Embedding(1000, 128)

self.encoder_layer = nn.TransformerEncoderLayer(d_model=128, nhead=8)

self.transformer_encoder = nn.TransformerEncoder(self.encoder_layer, num_layers=6)

self.out = nn.Linear(128, 10)

def forward(self, x):

x = self.embedding(x)

x = self.transformer_encoder(x)

x = self.out(x.mean(dim=1))

return x

这些代码示例展示了如何使用 PyTorch 构建简单的 RNN、LSTM 和 Transformer 模型。在实际应用中,需要根据具体任务进行调整和优化。

(三)AI 写作中的代码应用案例

在 AI 写作中,可以使用预训练的语言模型来生成文本。以下是使用 Hugging Face 的 Transformers 库生成文本的示例:

from transformers import GPT2LMHeadModel, GPT2Tokenizer

tokenizer = GPT2Tokenizer.from_pretrained('gpt2')

model = GPT2LMHeadModel.from_pretrained('gpt2')

input_text = "The future of AI writing is"

input_ids = tokenizer.encode(input_text, return_tensors='pt')

output = model.generate(input_ids, max_length=50, num_return_sequences=1)

generated_text = tokenizer.decode(output[0], skip_special_tokens=True)

print(generated_text)

这个示例中,我们使用了预训练的 GPT-2 模型,给定一个开头的文本,生成了一段后续的文本。在实际应用中,可以根据具体需求调整输入文本和生成的长度等参数。

七、文章总结

(一)AI 写作文本生成算法的主要内容

本文深入探讨了 AI 写作中的多种文本生成算法。首先介绍了生成式与判别式模型的区别与特点,包括优化准则、对观察序列的处理、训练复杂度以及支持的训练方式等方面的差异,并对比了它们在 AI 写作中的优缺点。接着详细阐述了长短期记忆网络(LSTM)在文本生成中的应用,包括技术原理与结构、实现步骤与流程以及应用示例与效果。还深入分析了 Transformer 与自注意力机制,介绍了其模型架构与组成、自注意力机制的作用以及在 AI 写作中的重要作用。此外,文章还综述了常见的 AI 写作文本生成算法种类,如基于自然语言模型、机器学习、深度学习、自动化内容生成、创意辅助写作、语音转文字写作、数据分析驱动写作和个性化内容定制等方法,并阐述了它们的实现方式与特点。最后,探讨了递归神经网络(RNN)在 AI 写作中的应用,包括信息提取与命名实体识别、词性标注与文本分类、语义分析与语言生成等方面的价值。

(二)AI 写作文本生成算法的重要性

AI 写作文本生成算法在当今数字化时代具有重要意义。这些算法能够极大地提高写作效率,为创作者提供灵感和辅助,帮助他们快速生成高质量的文本内容。无论是在新闻报道、文学创作、商业文案还是学术写作等领域,AI 写作工具都能发挥重要作用。例如,在新闻领域,自动化内容生成方法可以快速产出大量标准化的新闻稿件,提高新闻报道的及时性;在文学创作中,创意辅助写作方法可以为作家提供新的创意和思路,突破创作瓶颈;在商业领域,个性化内容定制方法可以根据用户的偏好和行为数据,为企业提供更具吸引力的营销文案,提高转化率。

(三)未来发展趋势

随着技术的不断进步,AI 写作文本生成算法的未来发展前景广阔。一方面,算法的性能将不断提升,生成的文本质量将更加接近人类写作水平。例如,通过不断增加训练数据量和优化模型结构,Transformer 等先进模型将能够更好地捕捉上下文信息和语义关系,生成更加准确、连贯和富有创意的文本。另一方面,AI 写作工具将更加智能化和个性化。通过结合用户的反馈和行为数据,工具可以不断学习和适应用户的写作风格和需求,为用户提供更加贴心的服务。此外,多模态融合也将成为未来的发展趋势之一。将文本与图像、音频等其他模态的数据相结合,AI 写作工具可以生成更加丰富多样的内容,满足不同用户的需求。

总之,AI 写作文本生成算法为我们带来了新的写作方式和可能性,随着技术的不断发展,它们将在更多领域发挥重要作用,为我们的生活和工作带来更多便利。

八、本文相关学习

(一)学习资源推荐

对于想要深入了解 AI 写作文本生成算法的读者,以下是一些学习资源推荐。

在线课程平台:Coursera 和 edX 上有许多关于自然语言处理和深度学习的课程,其中不乏涉及 AI 写作算法的内容。例如,Coursera 上的 “自然语言处理专项课程”,由斯坦福大学教授授课,全面介绍了自然语言处理的各个方面,包括文本生成算法。

学术论文:可以通过查阅相关的学术论文来了解最新的研究进展。例如,在 arXiv 等预印本平台上,可以找到许多关于 Transformer、LSTM 等模型在文本生成中的应用的论文。此外,学术期刊如《自然语言处理学报》等也是获取高质量研究成果的重要渠道。

开源项目:GitHub 上有许多优秀的开源项目,可以帮助读者更好地理解和实践 AI 写作文本生成算法。例如,Hugging Face 的 Transformers 库,提供了丰富的预训练语言模型和工具,方便用户进行文本生成等任务。

(二)学习方法建议

学习 AI 写作文本生成算法需要掌握一定的方法。

理论与实践相结合:在学习算法的理论知识的同时,要通过实际的编程实践来加深理解。可以参考本文中的代码示例,自己动手实现一些简单的文本生成模型,如 RNN、LSTM 和 Transformer。

关注最新研究进展:AI 领域发展迅速,新的算法和技术不断涌现。要保持关注最新的研究成果,阅读学术论文、参加学术会议等,及时了解行业动态。

参与社区交流:加入相关的技术社区,如 Reddit 的 r/MachineLearning 等,与其他学习者和从业者交流经验、分享心得,共同进步。

(三)应用场景拓展

除了本文中提到的应用场景,AI 写作文本生成算法还有许多其他的潜在应用场景。

智能客服:可以利用文本生成算法构建智能客服系统,自动回答用户的问题,提高客户服务效率。

游戏剧情生成:在游戏开发中,可以使用文本生成算法为游戏生成剧情和对话,增加游戏的趣味性和可玩性。

社交媒体内容创作:帮助社交媒体用户快速生成有吸引力的内容,如微博、朋友圈文案等。

代码自动生成:虽然目前主要是针对自然语言的文本生成,但未来也有可能将算法应用于代码自动生成,提高软件开发效率。

本文相关文章推荐:

AI 写作(一):开启创作新纪元(1/10)

AI写作(二)NLP:开启自然语言处理的奇妙之旅(2/10)

AI写作(三)文本生成算法:创新与突破(3/10)

版权归原作者 正在走向自律 所有, 如有侵权,请联系我们删除。