Ollama本地部署

- 自动安装 通过运行命令来安装Ollama:

curl-fsSL https://ollama.com/install.sh |sh

- 手动安装 (1). 下载ollama二进制文件 Ollama被分发为一个独立的二进制文件。将其下载到您的PATH目录中:

sudocurl-L https://ollama.com/download/ollama-linux-amd64 -o /usr/bin/ollama

sudochmod +x /usr/bin/ollama

(2). 配置ollama用户将Ollama添加为启动服务

为Ollama创建一个用户:

sudouseradd-r-s /bin/false -m-d /usr/share/ollama ollama

手写服务文件:

[Unit]Description=Ollama Service

After=network-online.target

[Service]ExecStart=/usr/bin/ollama serve

User=ollama

Group=ollama

Restart=always

RestartSec=3[Install]WantedBy=default.target

转入服务更改并启动:

sudo systemctl daemon-reload

sudo systemctl enable ollama

- 启动与删除ollama服务: 启动服务:

sudo systemctl start ollama

删除服务:

sudo systemctl stop ollama

sudo systemctl disable ollama

sudorm /etc/systemd/system/ollama.service

删除执行文件:

sudorm$(which ollama)

删除用户与用户组:

sudorm-r /usr/share/ollama

sudouserdel ollama

sudogroupdel ollama

安装nvidia驱动及CUDA

一、nviidia驱动

1.查看系统版本

cat /etc/os-release

2.查看显卡型号

sudo lshw -numeric-C display

3.安装编译工具

sudoapt-getinstall g++ make build-essential

4.卸载旧驱动(如果有)

sudoapt-get remove --purge nvidia*

5.nvidia官网下载驱动

https://www.nvidia.com/Download/index.aspx?lang=en-us

选择显卡对应的版本驱动

6.安装下载的本地运行文件驱动

sudochmod +x NVIDIA-Linux-x86_64-510.68.02.run

sh NVIDIA-Linux-x86_64-510.68.02.run

7.检查驱动安装是否成功

终端中执行:

nvidia-smi

二、CUDA安装

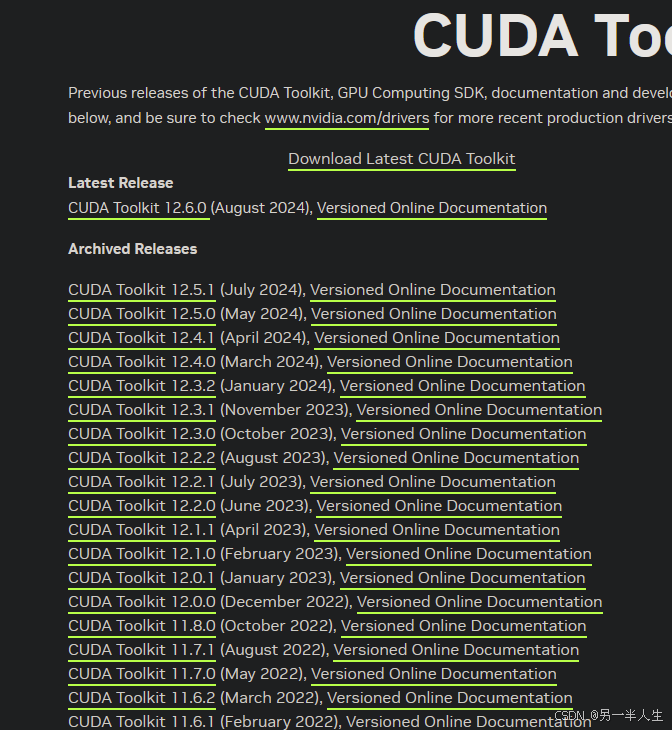

- 根据nvidia-smi显示的CUDA版本号去官网下载 https://docs.nvidia.com/cuda/cuda-toolkit-release-notes/ 下载https://developer.nvidia.com/cuda-toolkit-archive 我这里使用wsl运行ollama,下载对应的wsl2驱动

- 安装下载的本地运行文件 sudo sh cuda_11.6.2_510.47.03_linux.run

- 安装并配置环境变量 根据界面提示选择安装 安装完成配置环境变量 vim .bashrc export LD_LIBRARY_PATH= L D L I B R A R Y P A T H : / u s r / l o c a l / c u d a − 11.6 / l i b 64 e x p o r t P A T H = / u s r / l o c a l / c u d a − 11.6 / b i n : LD_LIBRARY_PATH:/usr/local/cuda-11.6/lib64 export PATH=/usr/local/cuda-11.6/bin: LDLIBRARYPATH:/usr/local/cuda−11.6/lib64exportPATH=/usr/local/cuda−11.6/bin:PATH 地址根据你的实际安装路径填写,保存 source ~/.bashrc

- 查看cuda安装是否正常 nvcc -V 有正常显示版本号即可

dify 部署

- 下载Dify git clone https://gitee.com/dify_ai/dify

- Docker部署Dify CMD 在该路径下运行 cd docker docker-compose up -d

- 检查dify运行情况 docker ps

初次运行时会有拉取镜像过程,镜像拉取完成后会自动运行。

初次运行时会有拉取镜像过程,镜像拉取完成后会自动运行。 - Dify连接Ollama

点开设置

点开设置 模型供应商中选择ollama 在ollama中添加模型

模型供应商中选择ollama 在ollama中添加模型 输入模型名称 基础url中,因为是本地运行的ollama而dify是docker运行的,需要更改ollama启动服务配置,不修改ollama默认只监听在127.0.0.1上。

输入模型名称 基础url中,因为是本地运行的ollama而dify是docker运行的,需要更改ollama启动服务配置,不修改ollama默认只监听在127.0.0.1上。 上图为已修改过ollama服务文件配置后,添加模型的基础url 修改ollama服务配置文件 查看ollama服务的服务文件位置

上图为已修改过ollama服务文件配置后,添加模型的基础url 修改ollama服务配置文件 查看ollama服务的服务文件位置 修改服务配置文件

修改服务配置文件 修改后重启ollama服务: systemctl restart ollama

修改后重启ollama服务: systemctl restart ollama - 发布应用

点击创建空白应用

点击创建空白应用 填写应用名称、描述。

填写应用名称、描述。 根据自己需求填写,再点击发布

根据自己需求填写,再点击发布 点击运行,运行自己发布的ai应用

点击运行,运行自己发布的ai应用

版权归原作者 另一半人生 所有, 如有侵权,请联系我们删除。