简介

controlnet是基于只能绘画AI-stable diffusion推出的一款功能强大的插件,它为文生图功能引入了新的控制方式,可以额外控制人物的具体姿势,景深,线稿上色等等,可以更稳定的控制画面。

安装

插件安装

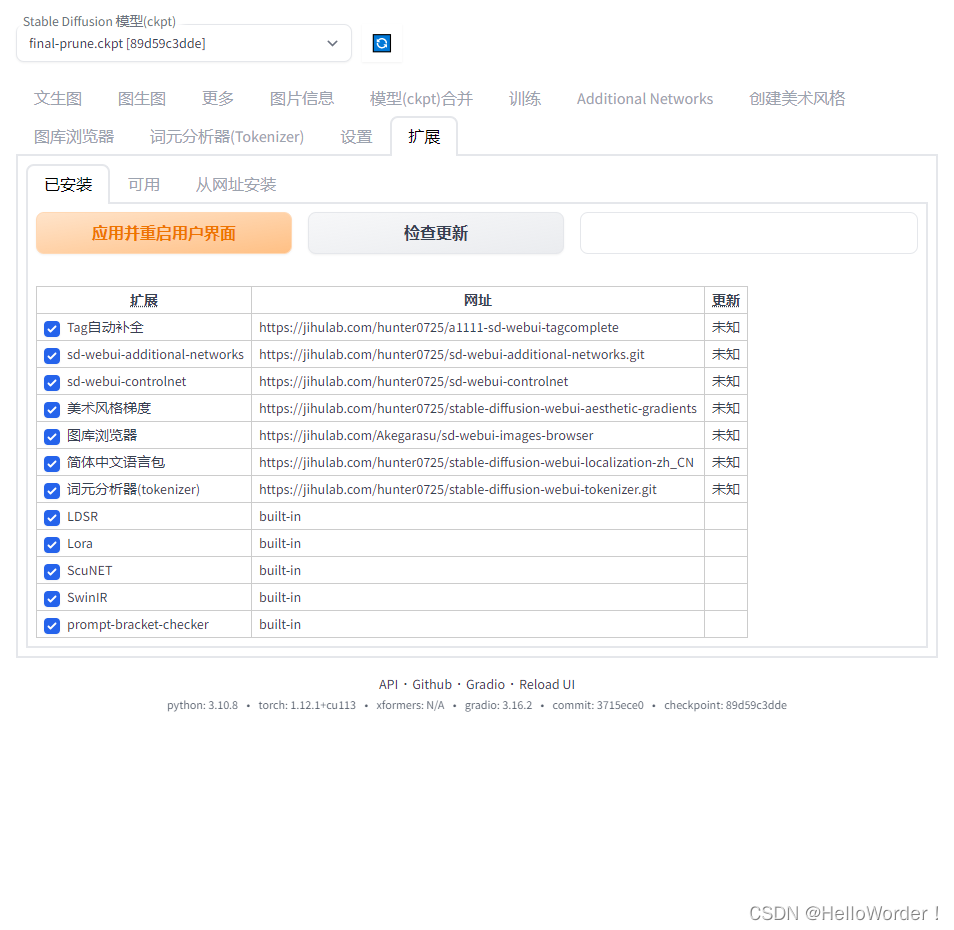

- 在stable diffusionUI界面中找到扩展

- 在扩展中找到<从网址安装>

- 当出现如下提示,则表示插件安装完成

模型安装

模型安装分为预处理模型和controlnet所需要的模型。

先安装预处理模型,打开AI所在的根目录输入这个地址

novelai-webui\extensions\sd-webui-controlnet\annotator

,将对应的预处理模型放进对应的文件夹中即可,而controlnet所需模型则是

novelai-webui\extensions\sd-webui-controlnet\models

,放在该文件夹下即可。

上述操作完成后打开我们的本地部署,在扩展中点击应用并重启即可。

本地部署重启之后就可以看到新的controlnet的选项了。

controlnet模型功能及参数分析

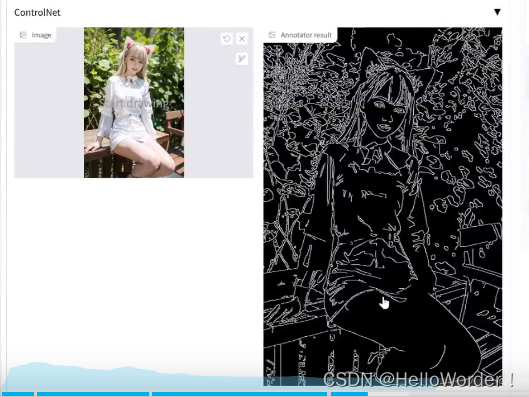

canny(边缘检测算法):一般用于参考图的线稿提取,-

Low VRAM该选项可以在你显存低于4G时开启,能够发挥最好的效果,高于4G可以不选-weight该选项表示使用controlnet的权重,权重越高越倾向于权重高的描述,一般使用默认值即可-Annotator resolution注释器分辨率,参数的大小影响模型的精度,当然越大,越消耗显存 512分辨率

512分辨率 1024分辨率 -

1024分辨率 - Preview annotator result预览注释器的结果,点击该按钮可以查看模型质量

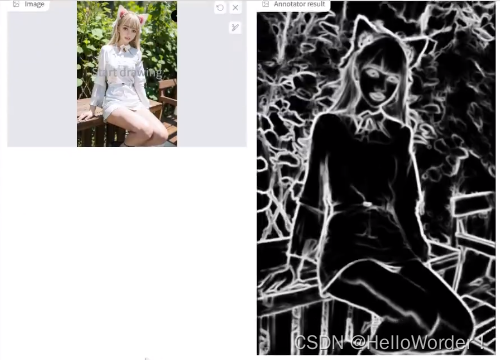

depth(深度图检测算法):一般用于提取物体边缘轮廓,没有物体内部的细节

hed(边缘检测算法):canny提取线稿更硬朗,hed提取的线条更圆润

mlsd(线段检测算法):一般用于建筑、物体的检测,常用于室内装潢,建筑设计

normal_map(法线图检测算法):会一定程度上保留物体内部的细节

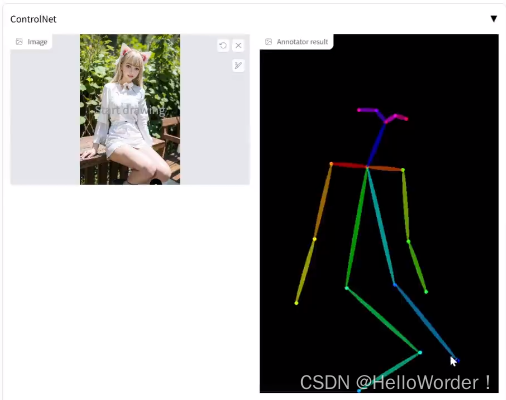

openpose(人物骨骼检测算法):提取人物的骨骼

好了,以上就是本期文章的全部内容了,如果本期内容对你使用stable diffusion有一定帮助,不妨点个赞吧,后续有什么问题也可以小窗私信我,看到留言后我会回复的。

版权归原作者 躺平阿宅の奇思妙想 所有, 如有侵权,请联系我们删除。