使用模型属性、本地逻辑表示和全局逻辑表示从黑盒模型生成解释

快速回顾:XAI 和 NSC

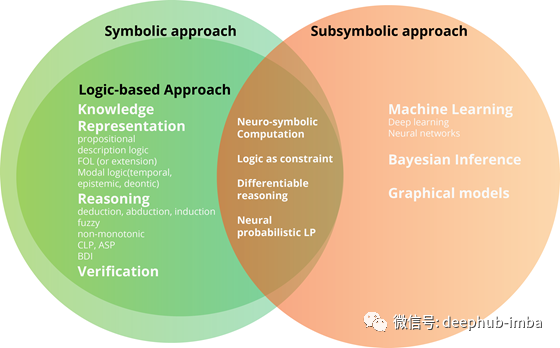

可解释人工智能 (XAI) 致力于开发对人类(包括用户、开发人员、政策制定者和审计人员)来说本质上更容易理解的人工智能模型。神经符号计算 (NSC) 处理将子符号学习算法与符号推理方法相结合。因此,我们可以断言神经符号计算是可解释人工智能下的一个子领域。NSC 也是最适用的方法之一,因为它依赖于结合现有的方法和模型。

如果可解释性是指用人类语言有意义地描述事物的能力。那么它可以认为,它是将原始信息(数据)映射到人类有意义的符号表示(例如,英语文本)的可能性。

通过从子符号中提取符号,我们可以使这些子符号具有可解释性。XAI和NSC都在努力使次符号系统更易于解释。NSC更多的是关于子符号到符号的映射,通过逻辑设计的可解释性:对子符号学习表示的符号推理。XAI没有那么具体,更多的是关于所有细微差别的可解释性,即使可解释性被包裹在无法解释的模型中。如果从子符号中提取符号意味着可解释性,那么XAI包含了NSC。

Neuro-Symbolic Concept Learner

Mao等人提出了一个新的NSC模型,Neuro-Symbolic Concept Learner,它遵循以下步骤:

- 图像分类器学习从图像或文本片段中提取亚符号(数字)表示。

- 然后,每个次符号表征都与一个人类可以理解的符号相关联。

- 然后,符号推理器检查符号表示的嵌入相似性

- 训练继续进行,直到通过更新表示使推理机输出的准确性达到最大为止。

白盒和黑盒模型

AI模型可以是(i)白盒或(ii)黑盒。

白盒模型可以通过设计来解释。因此,它不需要额外的功能来解释。

黑盒模型本身是无法解释的。因此,为了使黑盒模型具有可解释性,我们必须采用几种技术从模型的内部逻辑或输出中提取解释。

黑盒模型可以使用以下内容解释

模型属性:展示模型或其预测的特定属性,如(a)属性变化的敏感性,或(b)负责给定决策的模型组件(如神经元或节点)的识别。

局部逻辑:单个决策或预测背后的内部逻辑的表示。

全局逻辑:整个内部逻辑的表示。

因此,下图显示了AI模型的可解释性的子类别:

基于规则的可解释性与基于案例的可解释性

除了可解释模型的逻辑区分之外,我们还确定了两种常见的解释类型,所有上述模型都可以采用它们来提供解释:

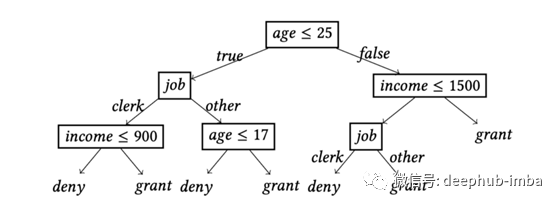

基于规则的解释:基于规则的可解释性依赖于生成“一组形式化的逻辑规则,这些规则构成了给定模型的内部逻辑。”

基于案例的解释:基于规则的可解释性依赖于提供有价值的输入-输出对(包括积极的和消极的),以提供对模型内部逻辑的直观理解。基于案例的解释依赖于人类从这些配对中推断逻辑的能力。

基于规则和基于案例的学习算法比较

假设我们的模型需要学习如何做苹果派的食谱。我们有蓝莓派、奶酪蛋糕、牧羊人派和普通蛋糕的食谱。基于规则的学习方法试图想出一套通用的规则来制作所有类型的甜点(即急切方法),而基于案例的学习方法则根据需要概括特定任务所需的信息。因此,它会在可用数据中寻找与苹果派最相似的甜点。然后,它会尝试在类似的食谱上进行小的变化来定制。

XAI: 设计白盒模型

包括基于规则和基于案例的学习系统,我们有四种主要的白盒设计:

手工制作的专家系统;

基于规则的学习系统:从归纳逻辑规划、决策树等数据中学习逻辑规则的算法;

案例学习系统:基于案例推理的算法。他们利用例子、案例、先例和/或反例子来解释系统输出;和

嵌入式符号和提取系统:更多的生物启发算法,如神经符号计算。

最后总结

在本文中,我们:

- 简要介绍XAI与NSC的异同;

- 定义并比较黑盒和白盒模型;

- 使黑盒模型可解释的方法(模型属性,局部逻辑,全局逻辑);

- 比较基于规则的解释和基于案例的解释,并举例说明。

作者:Orhan G. Yalçı

原文地址:https://towardsdatascience.com/black-box-and-white-box-models-towards-explainable-ai-172d45bfc512