1.LLaMA-2模型简介

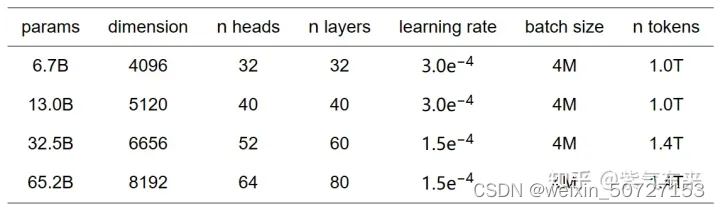

LLaMA-2(Language Learning and Modeling Architecture)是一种语言学习和建模框架,用于自然语言处理任务。它是在LLaMA的基础上进一步发展而来的。LLaMA-2模型通过结合多种语言学习和建模方法,提供了更强大和灵活的框架来处理自然语言的复杂性。目前共有7B、13B、33B、65B 四种版本,其模型参数如下表所示:

LLaMA-2模型的主要特点包括:

多任务学习:LLaMA-2模型可以同时处理多个相关任务,从而实现知识的共享和迁移,提高模型在各种任务上的性能。

细粒度语言建模:LLaMA-2模型通过使用更细粒度的语言建模技术,如基于字符的建模和多层次建模,提高了模型对语言的理解和表达能力。

知识图谱融合:LLaMA-2模型可以将外部知识图谱与文本数据相结合,从而增强模型的语义理解和推理能力。

迁移学习:LLaMA-2模型可以将从一个任务中学到的知识迁移到其他任务中,从而减少对大量标注数据的依赖,提高模型的泛化能力。

总之,LLaMA-2模型是一个强大的语言学习和建模框架,能够处理各种自然语言处理任务,并具有灵活性和扩展性。

2.LLaMA-2软件下载&环境搭建

- 样机环境 1.1 基于Windows 11搭建 1.2 Python:3.11 (Python版本需要高一些,否则会存在兼容性问题,导致无法执行) 1.3 网络环境请使用外网,国内网络会无法下载资源

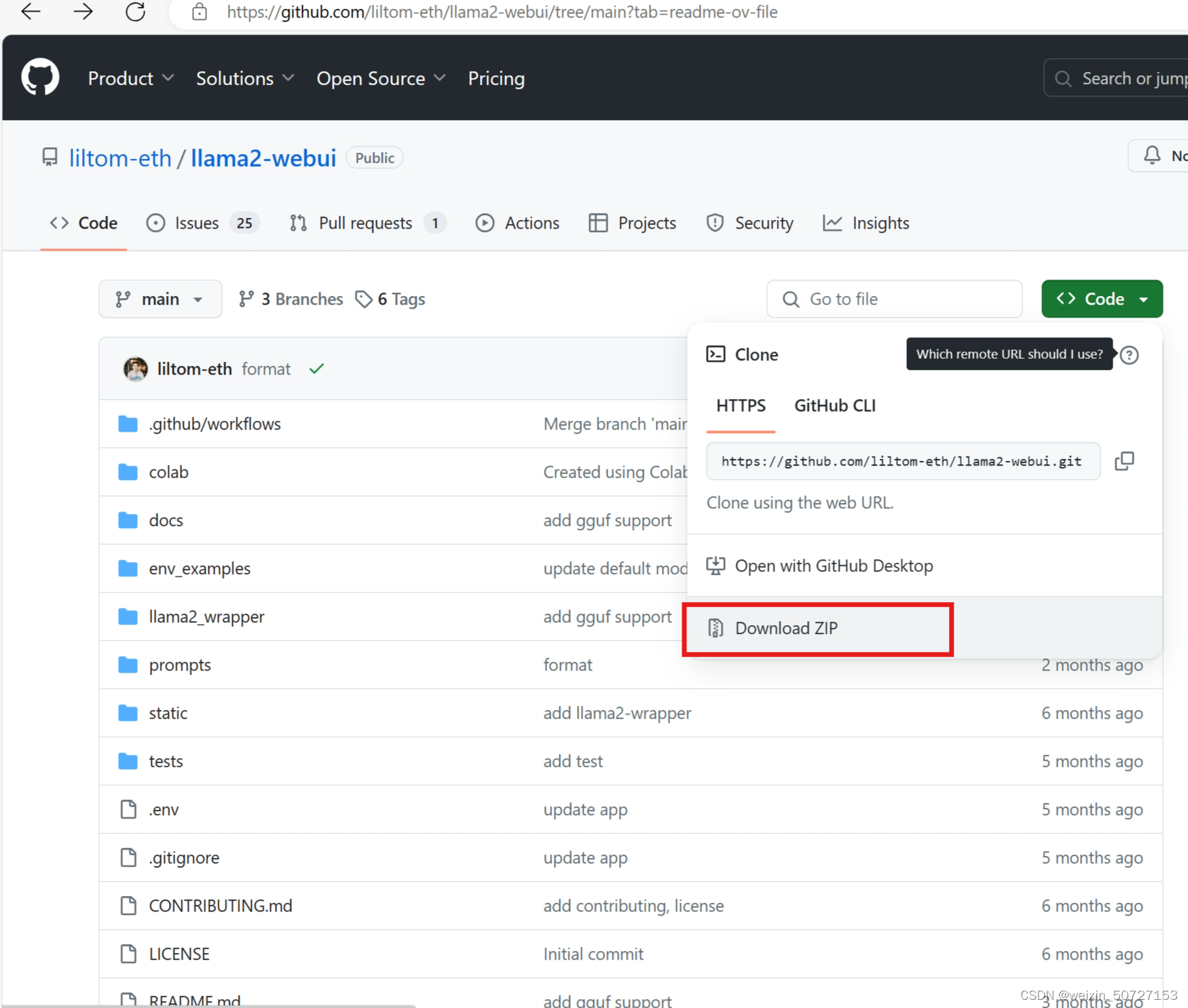

- 软件下载 2.1 下载llama2-webui软件包 2.11 下载地址 :Github链接

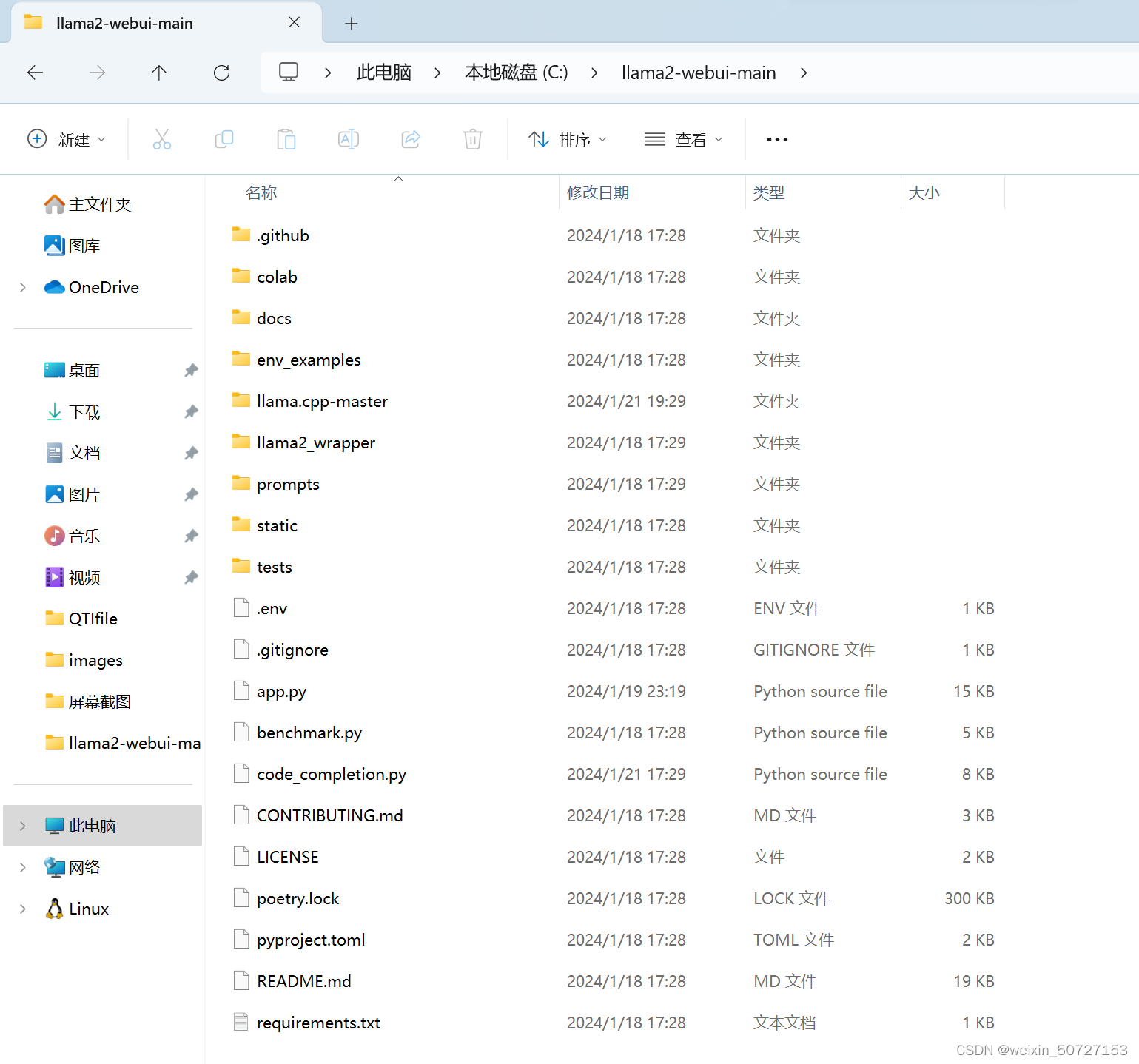

2.12 将下载好的软件包,解压到本地磁盘(我解压在了C盘)

2.13 安装llama2-wrapper

从PYPI下载

pip install llama2-wrapper

3.LLaMA-2模型Demo测试

1.Web Chat UI Demo

1.1 使用 Web UI 运行聊天机器人:

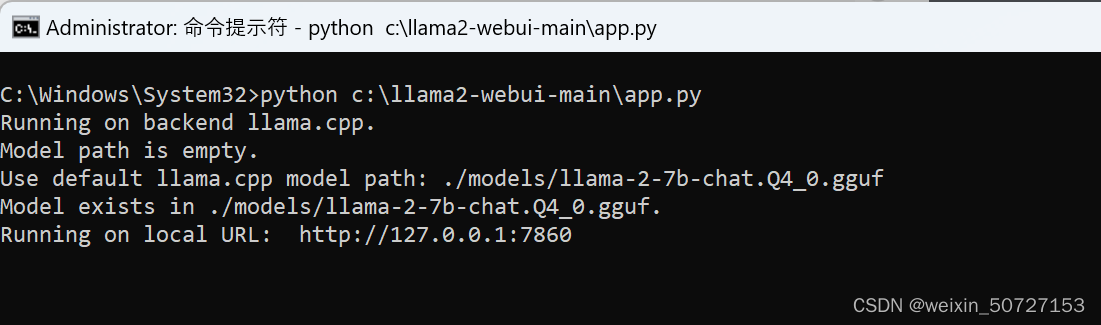

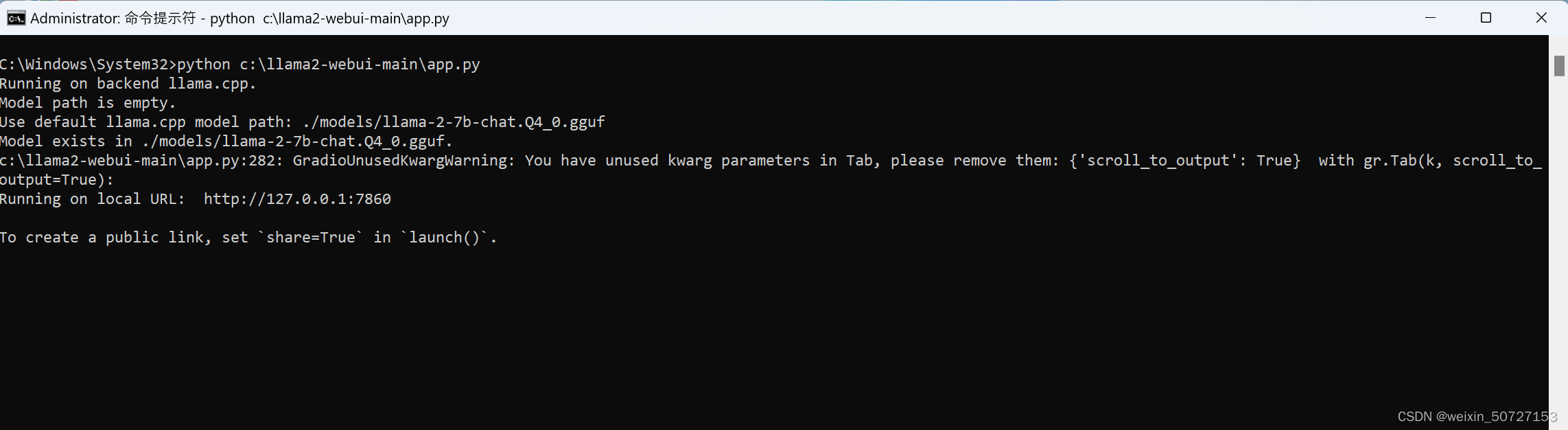

Python C:\llama2-webui-main\app.py (使用自己部署的路径)

1.2 模型自动下载

app.py将加载默认配置,该配置用作后端来运行模型进行推理。模型将自动下载,默认下载llama-2-7b-chat.Q4_0.gguf,执行结果如下:

Running on backend llama.cpp.

Use default model path:./models/llama-2-7b-chat.Q4_0.gguf

Start downloading model to:./models/llama-2-7b-chat.Q4_0.gguf

1.3 执行结果

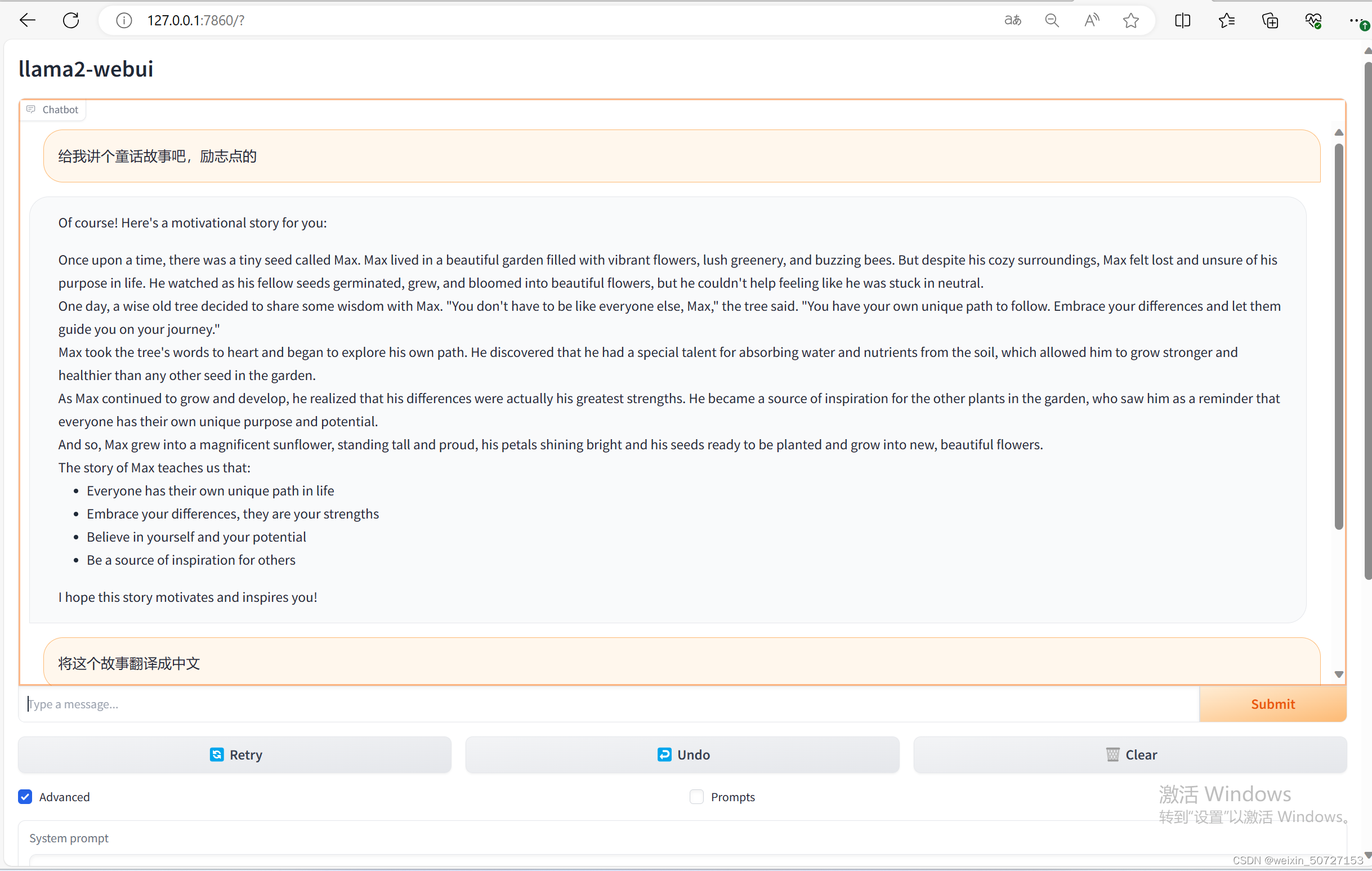

1.4 Web UI打开聊天窗口

将URL:http://127.0.0.1:7860复制到浏览器,运行后会出现Gradio窗口

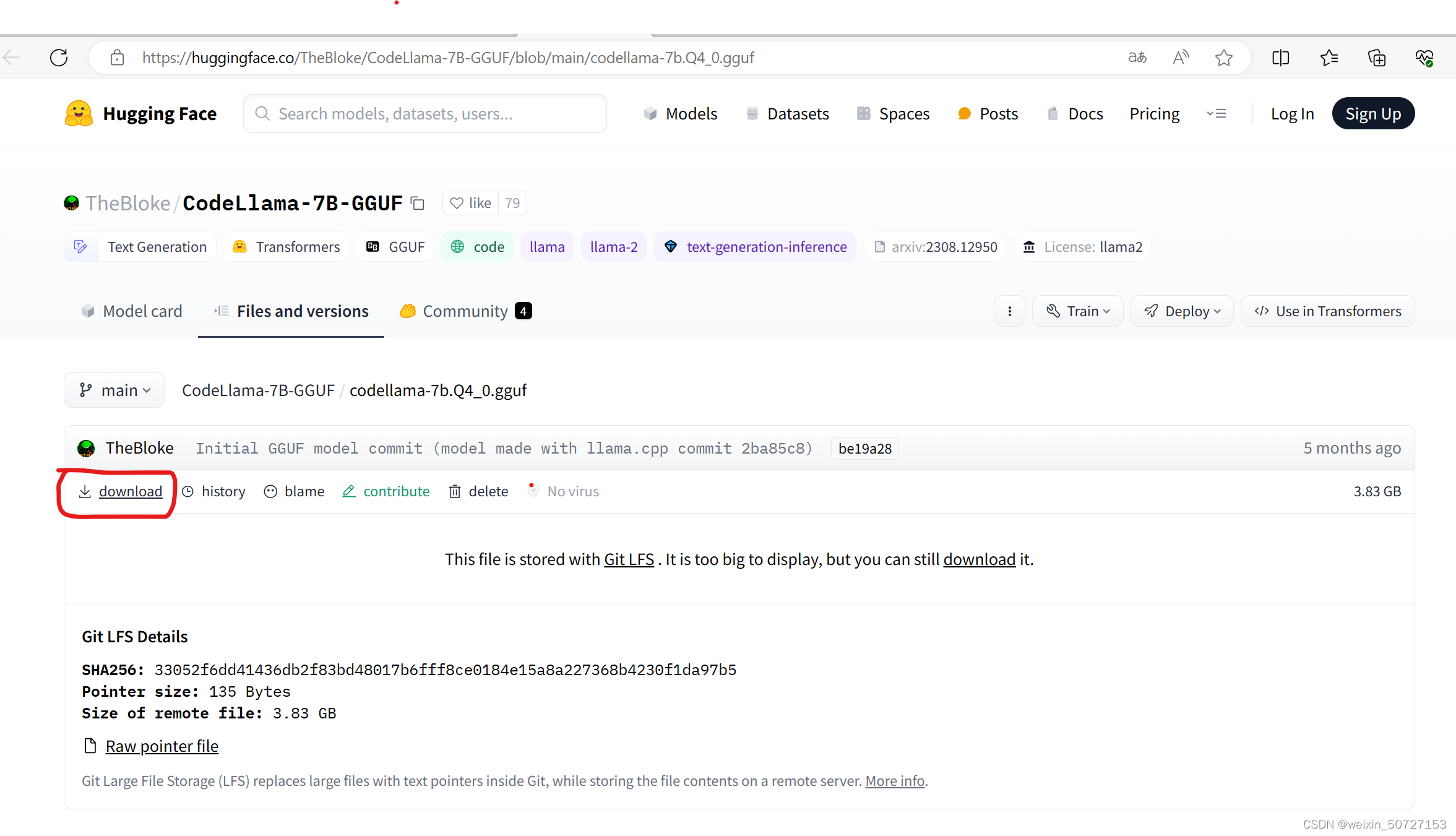

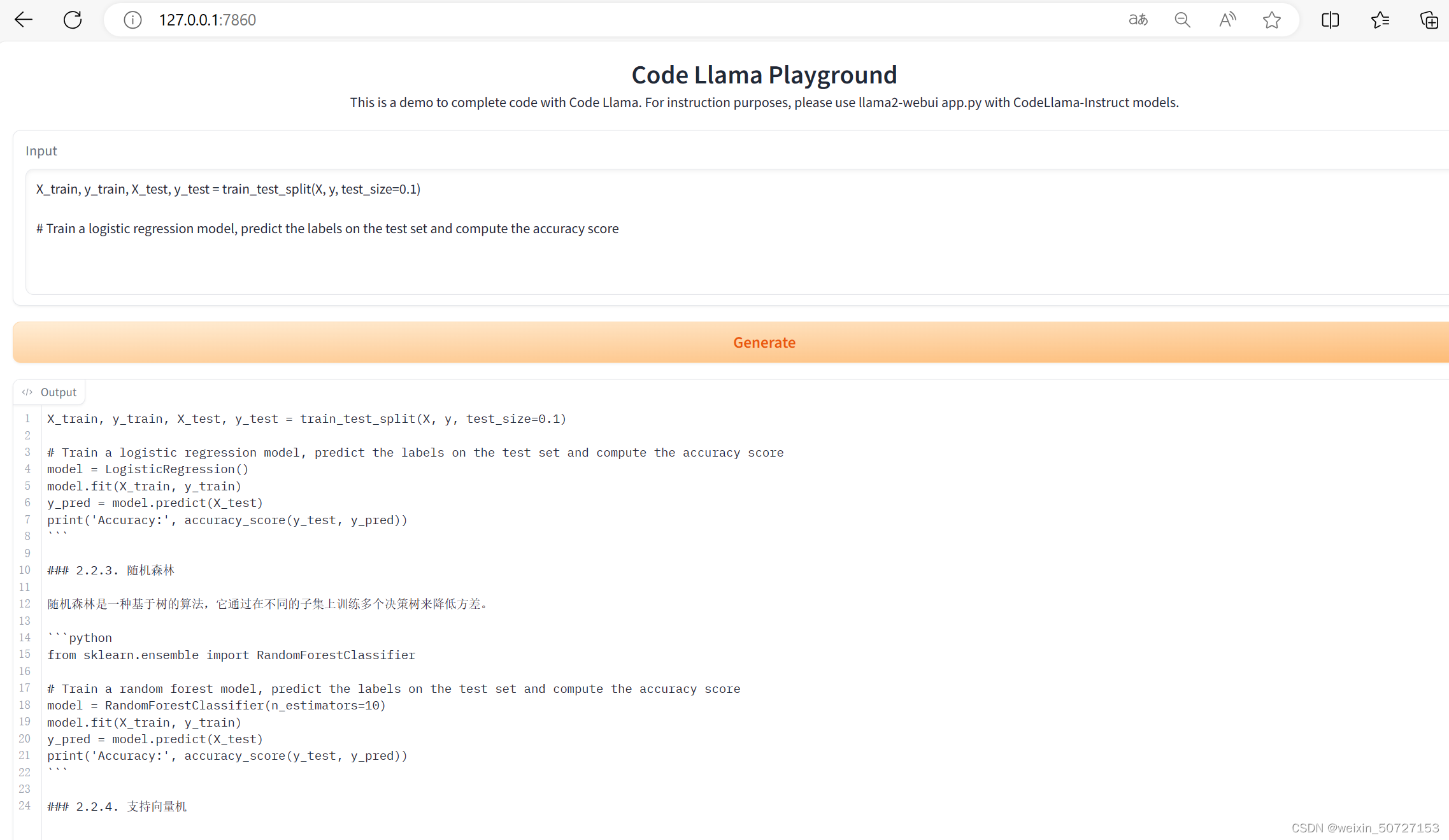

2.Code Llama UI Demo

2.1 代码完成/填充 UI模型下载

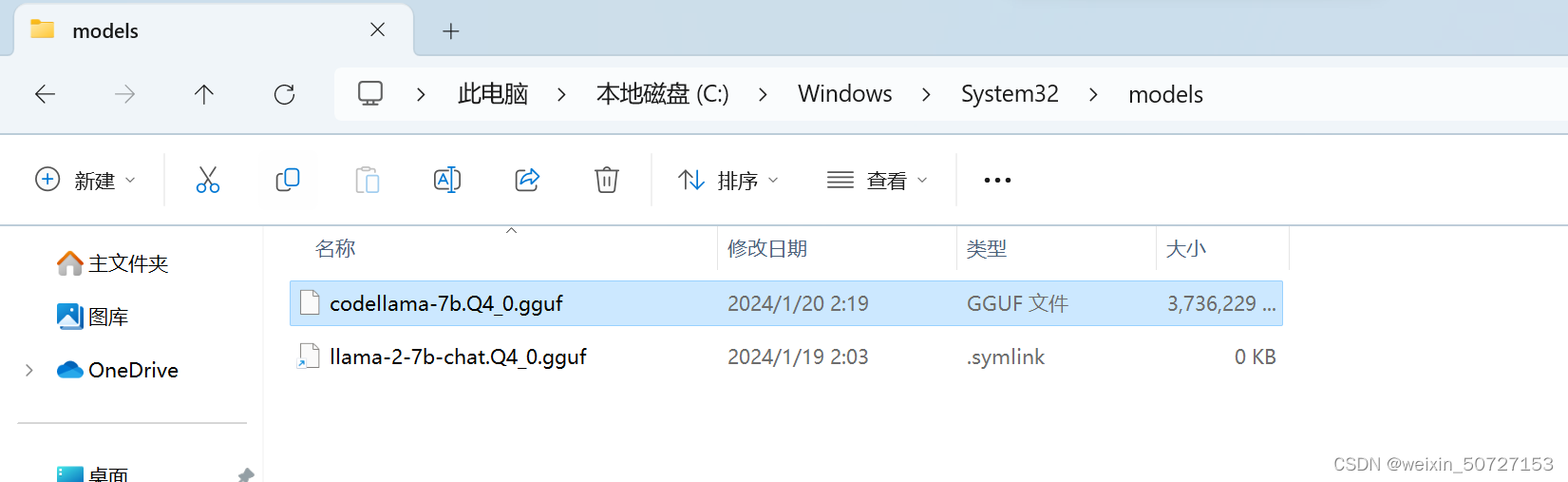

2.2 将模型文件 codellama-7b.Q4_0.gguf 放入Models文件夹中

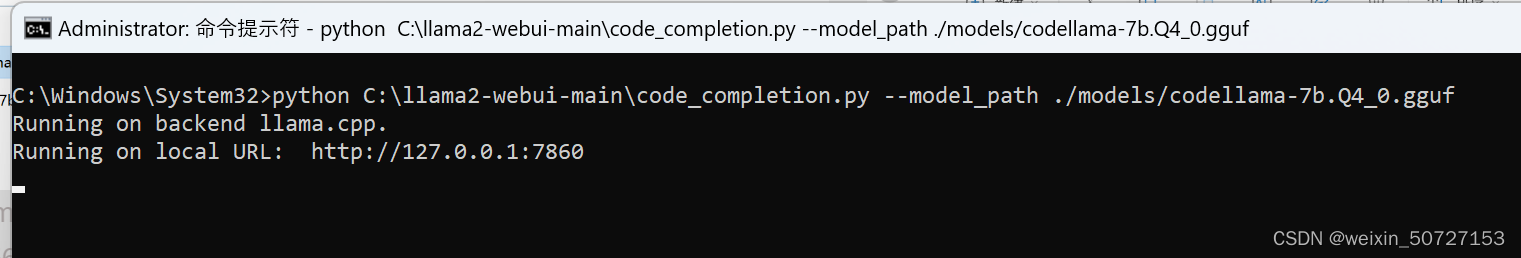

2.3 CodeLlama 代码执行

python C:\llama2-webui-main\code_completion.py --model_path ./models/codellama-7b.Q4_0.gguf

2.4 执行结果

2.5 CodeLlama 效果

将URL:http://127.0.0.1:7860复制到浏览器,运行后会出现Gradio窗口

4.问题Q&A

1.执行Web UI代码时报错如下,按照报错提示将代码中相应位置修改即可。

2.在运行app.py自动下载模型时,文件较大,请使用网络状况良好的外网。

3.在打开Web窗口,请注意不要将 代码运行窗口关掉,否则会无法使用。

版权归原作者 weixin_50727153 所有, 如有侵权,请联系我们删除。